在机器学习和数据分析任务中,特征选择(Feature Selection)是一项至关重要的任务。一个数据集可能包含大量的特征,但并非所有特征对模型的性能都有积极贡献。某些特征可能是冗余的、噪声较大的,甚至是高度相关的,这不仅可能影响模型的准确性,还可能增加计算成本。因此,合理的特征选择策略可以提高模型的泛化能力、减少计算资源消耗,并改善模型的可解释性。

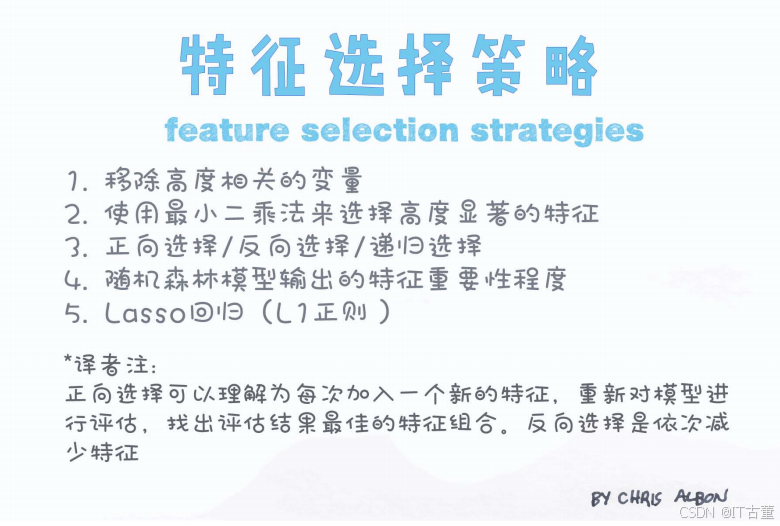

本文将基于上图介绍几种常见的特征选择策略,并详细讲解每种策略的原理、应用场景及优缺点。

1. 移除高度相关的变量

原理:

- 当两个特征之间的相关性过高时,它们可能会对模型产生类似的影响,因此可以移除其中一个,以减少冗余。

- 相关性可以通过皮尔逊相关系数(Pearson Correlation)等方法进行计算。

计算方法(Pearson 相关系数):

其中:

- r 接近 1 或 -1 表示两个变量高度相关。

- r 接近 0 表示无相关性。

应用场景:

- 数据集中包含多个相似的特征,如 "总销售额" 和 "平均每月销售额",其中一个可能是冗余的。

- 线性回归、逻辑回归等模型对多重共线性敏感,移除高度相关的特征可以提高模型稳定性。

优缺点:

✅ 优点:

- 降低特征冗余,减少计算成本。

- 提高模型的可解释性。

❌ 缺点:

- 可能会误删一些有价值的信息,影响模型表现。

2. 使用最小二乘法(Least Squares)选择高度显著的特征

原理:

- 最小二乘法用于线性回归模型中,通过计算回归系数的显著性来判断哪些特征对目标变量影响较大。

- 可以使用 p 值(P-value) 或 t 检验(T-test) 来选择显著的特征。

计算方法(线性回归系数):

其中:

代表每个特征的回归系数,较大的

表示该特征更重要。

应用场景:

- 线性回归模型,判断哪些特征对目标变量有显著影响。

- 经济学、医学等领域的数据分析。

优缺点:

✅ 优点:

- 直接使用回归系数进行特征筛选,计算简单。

❌ 缺点:

- 仅适用于线性关系的数据,对于复杂非线性关系可能无效。

3. 正向选择 / 反向选择 / 递归选择

正向选择(Forward Selection):

- 从空特征集开始,每次加入一个最能提升模型性能的特征,直到加入新特征不再带来显著提升。

反向选择(Backward Selection):

- 从所有特征开始,每次移除一个对模型影响最小的特征,直到去除某些特征后性能下降。

递归特征消除(Recursive Feature Elimination, RFE):

- 训练模型后,递归地去掉权重最低的特征,并重复该过程,直到达到最优特征子集。

应用场景:

- 处理高维数据,逐步筛选最重要的特征。

优缺点:

✅ 优点:

- 适用于所有机器学习模型,能够有效找到最优特征子集。

❌ 缺点:

- 计算复杂度较高,尤其是特征维度很大时。

4. 随机森林输出的特征重要性

原理:

- 随机森林(Random Forest)是一种集成学习方法,它的特征重要性可以用来评估每个特征对目标变量的贡献。

- 计算方式:

- 基尼指数(Gini Importance):衡量特征对分类决策的影响程度。

- 基于 OOB 误差的特征重要性。

应用场景:

- 适用于高维数据特征筛选,如文本分析、医学诊断等。

- 适用于非线性数据,因为随机森林可以自动捕捉复杂关系。

优缺点:

✅ 优点:

- 适用于大规模数据,适应性强。

- 可用于回归和分类任务。

❌ 缺点:

- 特征重要性可能受到数据分布的影响,导致偏差。

5. Lasso 回归(L1 正则化)

原理:

- Lasso(Least Absolute Shrinkage and Selection Operator)是一种 L1 正则化回归方法,它可以自动将某些回归系数收缩到 0,从而实现特征选择。

数学表达:

其中:

是 L1 范数,λ 控制正则化程度。

应用场景:

- 适用于高维稀疏数据,如基因数据分析、文本特征选择。

优缺点:

✅ 优点:

- 可以自动去除无关特征。

- 适用于高维数据。

❌ 缺点:

- 可能会舍弃一些有价值的特征,导致信息损失。

6. 总结

| 策略 | 方法 | 适用场景 | 优点 | 缺点 |

|---|---|---|---|---|

| 移除高度相关变量 | 计算相关系数,删除高度相关特征 | 线性回归、数据预处理 | 减少冗余,提高模型稳定性 | 可能丢失有价值的信息 |

| 最小二乘法 | 线性回归系数显著性 | 线性数据分析 | 计算简单,直观 | 仅适用于线性关系 |

| 正向/反向/递归选择 | 逐步增加/减少特征 | 处理高维数据 | 能找到最优特征子集 | 计算量大 |

| 随机森林特征重要性 | 计算基尼指数/OOB误差 | 高维非线性数据 | 适用于大规模数据 | 可能受数据分布影响 |

| Lasso 回归(L1 正则化) | 自动缩减特征权重 | 高维稀疏数据 | 自动选择重要特征 | 可能丢失部分信息 |

7. 结论

不同的特征选择策略适用于不同的数据集和任务,选择合适的方法能够有效提升模型的表现。在实践中,可以结合多种方法进行特征筛选,以获得最优特征子集,提高模型的精度、稳定性和计算效率。

755

755

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?