0 前言

本文主要讲述使用基尼指数构建二叉决策树的算法,并给出例题一步步解析,帮助读者理解。

本文所使用的数据集:贷款.CSV。

id,年龄,有工作,有房子,信贷情况,类别

1,青年,否,否,一般,否

2,青年,否,否,好,否

3,青年,是,否,好,是

4,青年,是,是,一般,是

5,青年,否,否,一般,否

6,中年,否,否,一般,否

7,中年,否,否,好,否

8,中年,是,是,好,是

9,中年,否,是,非常好,是

10,中年,否,是,非常好,是

11,老年,否,是,非常好,是

12,老年,否,是,好,是

13,老年,是,否,好,是

14,老年,是,否,非常好,是

15,老年,否,否,一般,否

读者需要具备的知识:基尼指数计算。

1 基于基尼指数的分类树构建算法

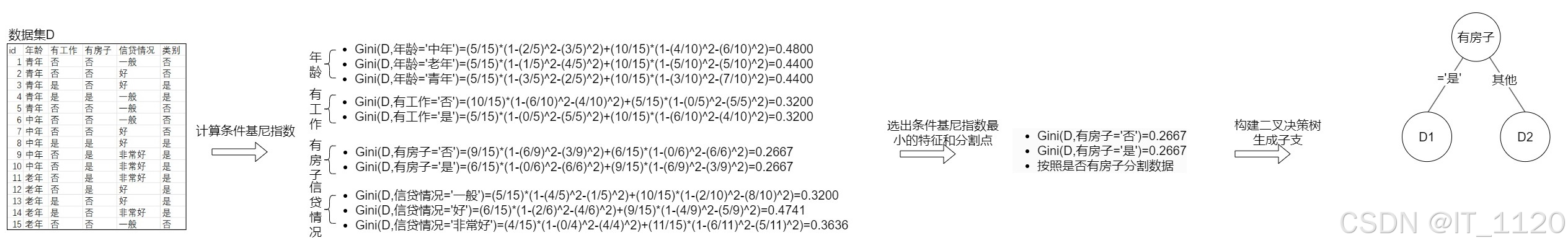

- 选择最优特征进行分裂:

对于决策树的每个节点,遍历数据集中的所有特征。对于每个特征,考虑其所有可能的分割点(对于离散特征,每个不同的值都是一个分割点;对于连续特征,则可能需要将特征值排序后,选择相邻值的中点作为候选分割点)。计算分割后的数据集的基尼指数,选择基尼指数最小的特征和对应的分割点作为最优特征和最优分割点。

- 生成子节点:

使用最优特征和最优分割点将当前节点的数据集分割成两个子集,并为每个子集创建一个新的子节点。

- 递归构建子树:

对每个子节点,重复步骤1和步骤2,直到满足停止条件(如,子节点中的样本都属于同一类别,或者子节点中的样本数少于预设的阈值)。

- 构建决策树:

将上述过程递归执行的结果组织成树形结构,即得到基于基尼指数的分类决策树。

2 示例

- 该示例采用贷款数据集,

- 选择最优特征构建根节点:

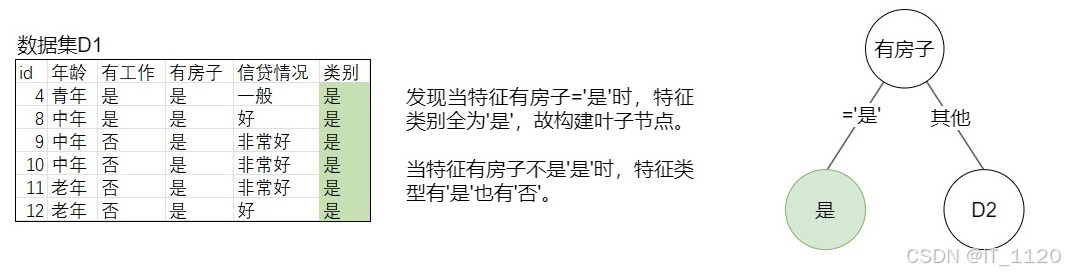

- 构建子节点:

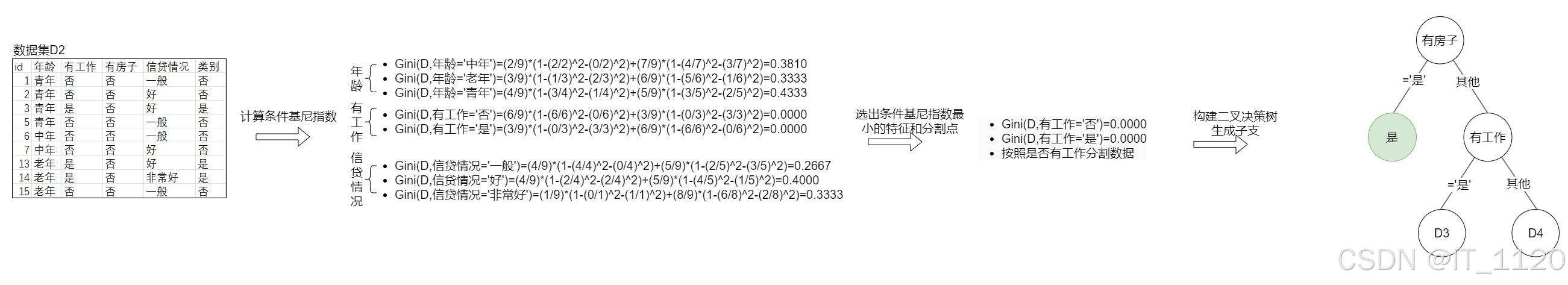

- 递归构建D2节点:

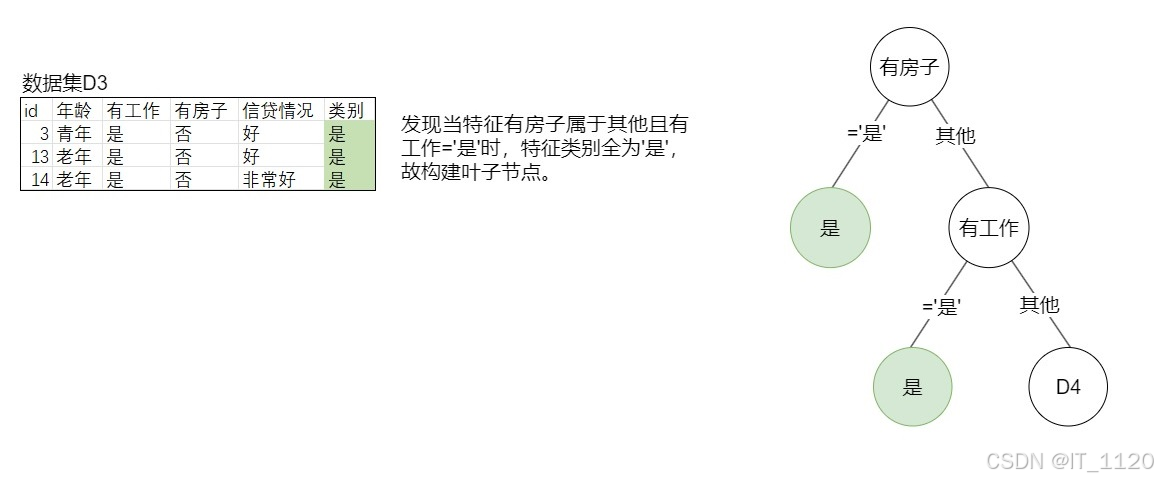

构建子节点:

**

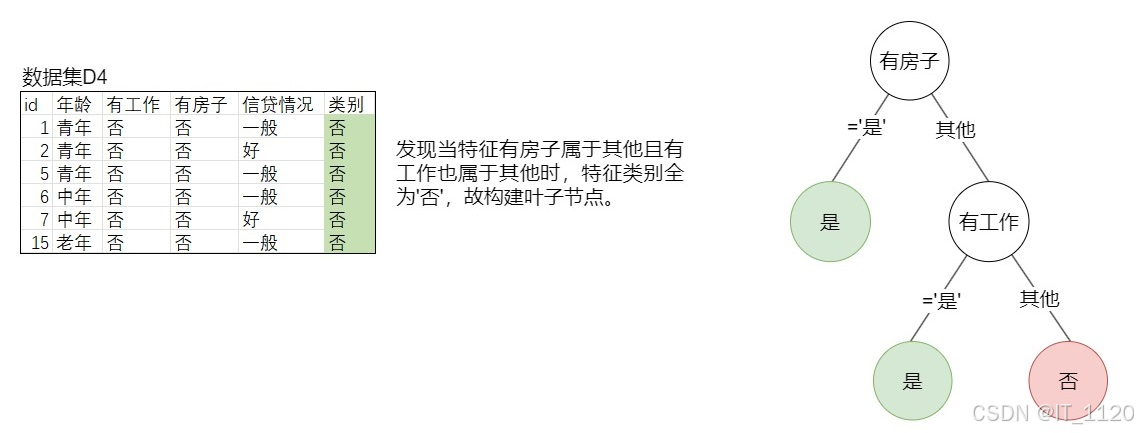

- 递归构建D4节点:

**

构建二叉分类决策树完成。

2276

2276

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?