Rethinking Multi-Contrast MRI Super-Resolution: Rectangle-Window Cross-Attention Transformer and Arbitrary-Scale Upsampling

代码:https: //github.com/GuangYuanKK/McASSR

摘要---最近,几种方法探索了多对比度磁共振成像(MRI)超分辨率(SR)的潜力,并获得了优于单对比度SR方法的结果。然而,现有的方法仍然有两个缺点:(1)它们只能解决固定的整数上采样尺度,如2×、3×和4×,这需要在临床上为每个上采样尺度分别训练和存储相应的模型。(2) 由于它们采用方形窗口(例如8×8)变压器网络架构,因此不同窗口之间缺乏直接交互,这导致对长期依赖关系的建模不足。此外,参考图像和目标图像之间的关系没有得到充分挖掘。为了解决这些问题,我们开发了一种用于多对比度MRI任意尺度SR的新型网络,称为McASSR。具体来说,我们设计了一个矩形窗口交叉注意力变换器,在不增加计算复杂度的情况下建立MR图像中的长距离依赖关系,并充分利用参考信息。此外,我们提出了参考感知隐式注意作为上采样模块,通过隐式神经表示实现任意尺度的超分辨率,进一步融合参考图像的补充信息。在公共和临床数据集上进行的广泛而全面的实验表明,我们的McASSR比SOTA方法具有更优的性能,表明其在临床实践中具有巨大的应用潜力。代码将在https://github/GuangYuanKK/McASSR上提供。

研究背景:

多对比磁共振成像MRI超分辨率任务,现有方法存在一些问题:

(1)它们只能解决固定的整数上采样尺度,例如2×、3×和4×,这需要在临床中为每个上采样尺度单独训练和存储相应的模型。

(2)由于它们采用方形窗口(例如8×8)变压器网络架构,因此它们缺乏不同窗口之间的直接交互,这导致对较长距离依赖关系的建模不充分。

(3)参考图像和目标图像之间的关系没有得到充分挖掘。

图1:与SOTA任意尺度SR方法LTE[13]的视觉比较,我们的网络重建的SR图像包含更清晰的边缘、更多的视觉细节和更少的模糊伪影。*意味着我们的实现使用SwinIR[17]作为骨干,并将参考图像和目标图像连接起来作为输入。

研究方法:

1 Feature Extraction & Cross-Fusion Network特征提取与交叉融合网络

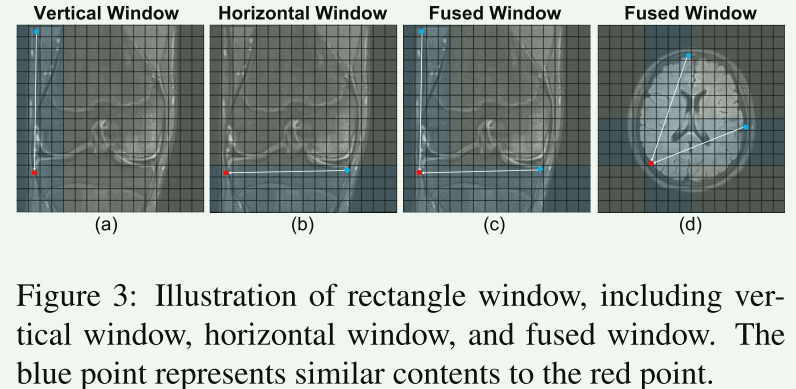

在图3(a)(b)中,蓝色斑块表示大小为4×16或16×4的矩形窗口。可以看出,在较长范围区域(红色和蓝色)中存在很高的相似性。然而,对于8×8这样的方形窗口,如果不扩大窗口大小,就不可能建立红色和蓝色区域的长距离依赖关系。因此,我们考虑在多对比度MRI SR(MCSR)任务中使用具有矩形窗口的变压器,以进一步增强网络建立长距离依赖关系的能力。

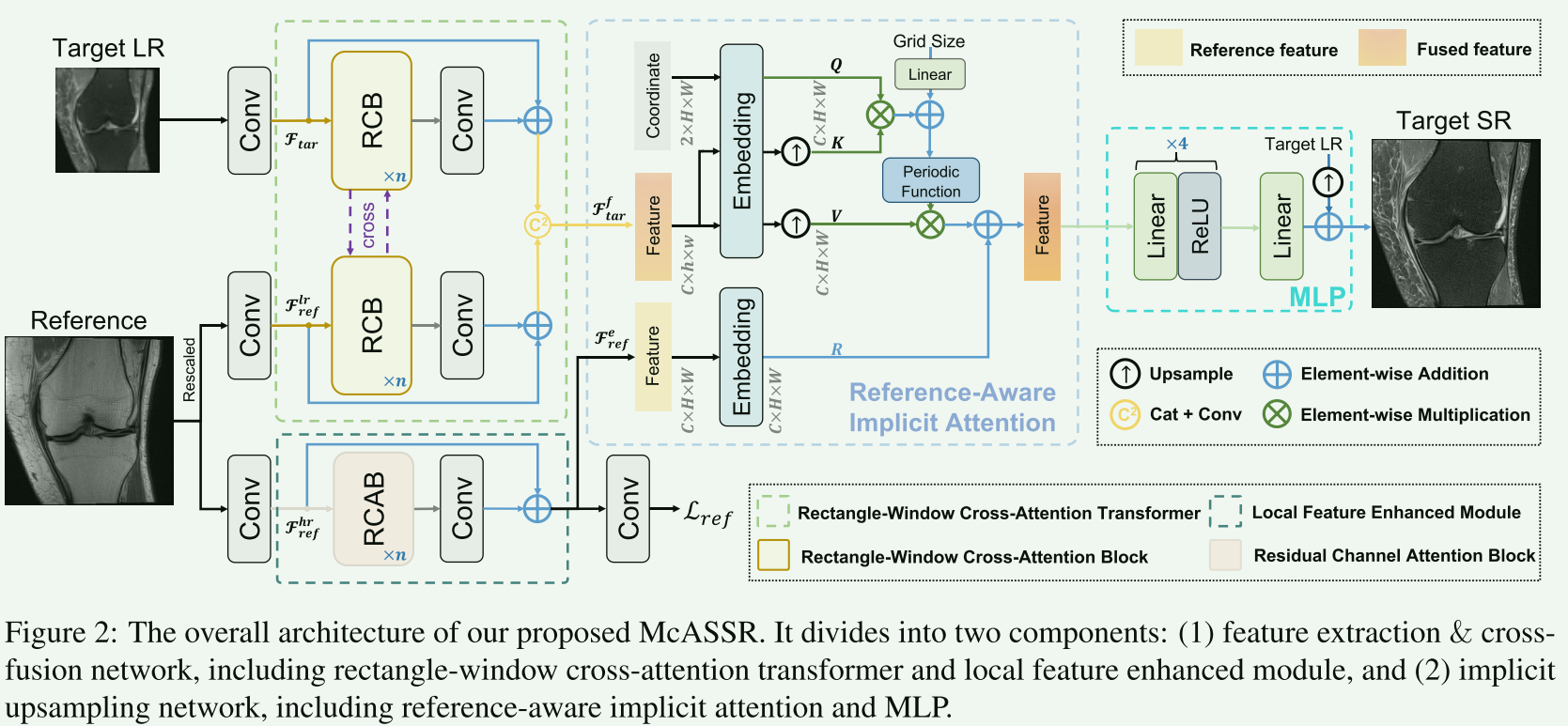

- 矩形窗口交叉注意力转换器。受最近研究[43,3,16]的启发,我们设计了一种新的矩形窗口交叉注意力变换器,有效地建立了MR图像中的长距离依赖关系,同时融合了参考图像中的互补信息。如图2所示,RCT由n个矩形窗口交叉注意块(RCB)和一个卷积层(我们设置n=6)组成。将浅层特征Ftar和Flr-ref分别馈入RCB,并进行特征提取和交叉融合,以获得融合的深层特征Ff-tar。此外,RCT中还涉及残余连接,以稳定训练。

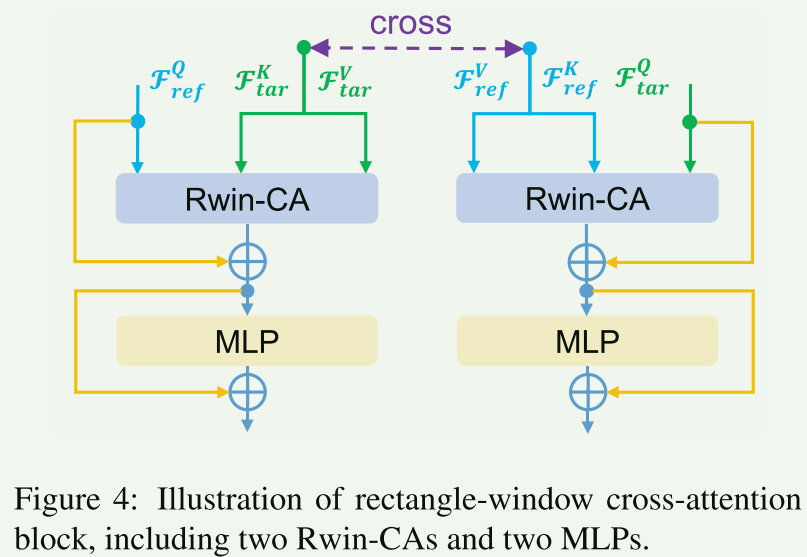

- 矩形窗口交叉注意块。如图4所示,RCB由两个矩形窗口交叉注意(Rwin CA)和两个MLP组成。与[43]类似,Rwin CA分为两种类型,垂直窗口(Sh>Sw,如图3(a)所示,称为Vwin CA)和水平窗口(Sh<Sw,见图3(b),称为Hwin CA),并将它们并行用于不同的注意头。我们将关注头的数量H设置为偶数,其中H/2个头执行Vwin-CA,其余头执行Hwin-CA。然后,它们的输出沿着通道维度连接。如图3(c)(d)所示,通过聚合Vwin-CA和Hwin-CA,可以扩展注意力区域,以建立更长的范围依赖关系,并在不扩大窗口大小的情况下捕获更多相似的特征。

设计矩形窗口交叉注意力变换器作为特征提取主干。具体来说,它并行地在不同的头部采用水平和垂直矩形窗口交叉注意力来扩展注意力区域,聚合不同窗口之间的特征,并交叉融合参考图像和目标图像的互补信息。

RCB 由两个矩形窗口交叉注意力(Rwin-CA)和两个 MLP 组成。

- 本地功能增强模块。目前的MCSR方法只考虑MR图像的局部特征提取[21,4]或全局特征提取[14,16],无法同时对MR图像进行局部和全局特征提取。因此,我们引入了一个局部特征增强模块来全面解决这个问题。具体来说,如图2所示,我们使用n个RCAB[42]作为局部特征提取器来获得高级局部特征Fe-ref,该特征用于补充隐式上采样中F F tar的高频分量信息。

2 隐式上采样网络

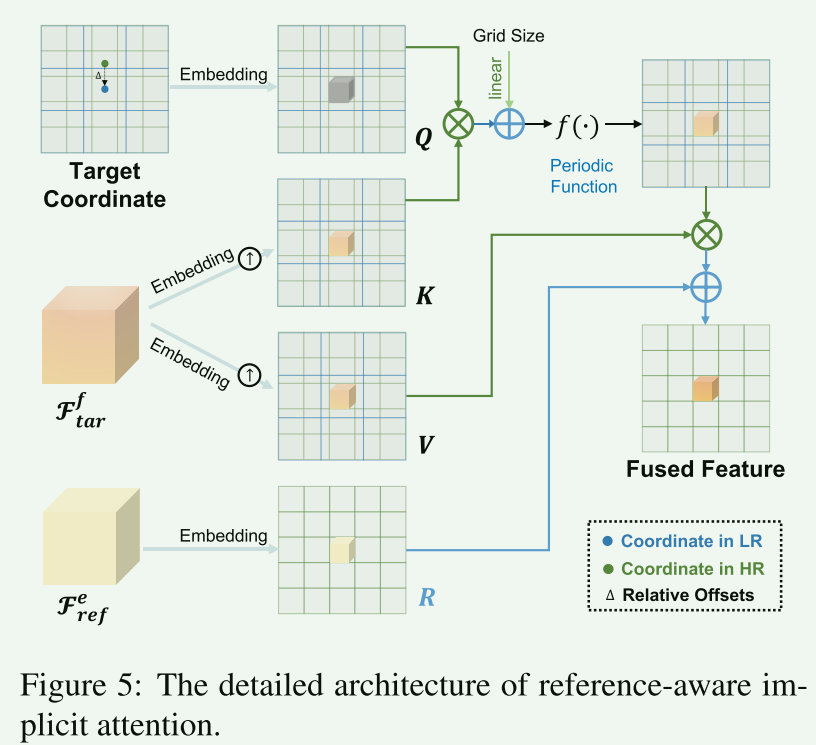

方法[14,16]只能进行固定比例的上采样,这不适合临床应用,因为它们需要为每个上采样因子训练和存储单独的模型。因此,我们提出隐式上采样来全面解决这个问题,它由参考感知隐式注意(RIA)和MLP组成。参考感知内隐注意。一些方法[1,36,13]目前通过隐式神经表示(INR)实现了自然图像的任意尺度SR。INR是指利用像素坐标生成像素值的连续可微函数,如NeRF[25]。受最近研究[1,36,13]的启发,我们设计RIA来实现任意比例的上采样,同时融合参考图像中的高频分量特征,如图5所示。与将像素值作为查询的显式注意不同,RIA将像素的坐标作为查询。换句话说,RIA不是学习像素2像素映射,而是学习坐标2像素映射。

受隐式神经表示(INR)[1]的启发,提出参考感知隐式注意力作为上采样模块,它实现了任意尺度的超分辨率,并进一步融合了参考图像和目标图像的互补信息。

与显示注意力不同,参考感知隐注意力RIA 不是学习像素到像素映射,而是学习坐标到像素映射。

引入HR空间上点与重建目标空间上点之间的相对偏移量。

在RIA中添加网格大小,以解决当比例因子发生变化时,边缘位置在其HR空间的小区域内发生变化的问题。

在INR中使用周期性激活函数,例如sin和cos,可以驱动网络学习高频分量。

def gen_feat(self, inp, ref, ref_hr):

"""

生成特征的方法,接受输入、参考和参考高分辨率图像,计算并返回相应的特征。

生成输入特征的坐标信息。

对输入特征和参考高分辨率特征进行处理,得到相应的特征表示。

返回输入特征、参考高分辨率特征的结果和损失。

"""

self.inp = inp

self.ref = ref

self.ref_hr = ref_hr

# 生成输入特征的坐标信息

"""

make_coord生成一个与输入形状相匹配的坐标网格,取倒数两个维度大小(宽、高)

"""

self.inp_feat_coord = make_coord(inp.shape[-2:], flatten=False) \

.permute(2, 0, 1) \

.unsqueeze(0).expand(inp.shape[0], 2, *inp.shape[-2:])

self.inp_feat = self.encoder(inp, ref)

self.ref_feat_hr, self.ref_loss = self.local_enhanced_block(ref_hr)

self.inp_coeff = self.coef(self.inp_feat) # conv2d

self.inp_freqq = self.freq(self.inp_feat)

self.ref_feat_hr_res = self.ref_conv(self.ref_feat_hr)

return self.inp_feat, self.ref_feat_hr_res, self.ref_loss

研究结论:

为了研究矩形窗口的有效性,我们设计了一个变体,将矩形窗口替换为方形窗口(8×8),如表3所示。可以看出,方形窗口变体的PSNR值降低了约0.89dB,表明使用矩形窗口可以有效地建立更长距离的依赖关系,以加速感受野的增加。此外,我们利用局部归因图(LAM)[8]来可视化矩形窗口和方形窗口的感受野,如图9所示。请注意,LAM是指重建红色区域时其他区域像素的贡献。也就是说,可以利用的像素越多,网络的长程依赖性就越大。我们注意到,方形窗口变体只利用了有限范围的像素。相比之下,矩形窗口可以使用更长范围的像素,这意味着它有效地建立了更长范围的依赖关系。

探究矩形窗口有效性:可以利用的像素越多,网络的长程依赖性就越大。我们注意到,方形窗口变体仅利用有限范围的像素。相比之下,矩形窗口可以采用更长范围的像素,这意味着它有效地建立了更长范围的依赖关系。

此外,图7显示了我们的方法与其他任意尺度SR方法在尺度外8×([32×32]→[256×256])下使用单个网络的SR重建结果。即使在8倍的超大放大倍数下,我们的方法仍然可以重建最接近原始图像的图像,表明我们的方法具有显著的临床应用前景。

参考图像的效果。为了评估参考图像的贡献,我们通过去除参考图像(称为w/o参考)、去除Lref(称为w/w Lref)、去除RIA中的参考感知(称为w/o RIA)进行了三项消融研究。可以看出,在参考图像中使用补充信息可以提高目标SR重建的质量。此外,RIA可以有效地补充目标图像的高频信息,如图10所示。可以看出,无RIA的变体重建图像丢失了一些高频细节信息,导致重建误差较大。

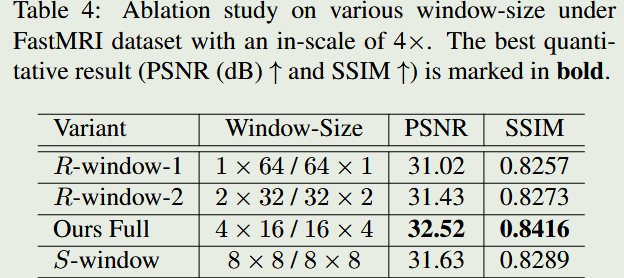

为了探索矩形窗口大小的有效性,我们设计了两个变体,将矩形窗口大小调整为1×64/64×1,称为R-window-1,并将矩形窗口尺寸调整为2×32/32×2,称为R-window-2,如表4所示。可以看出,R窗-1和R窗-2的PSNR值分别降低了约1.5dB和1.09dB,表明矩形窗宽/高压缩将导致网络重建性能的降低。

3574

3574

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?