大家好, 这里是 CodeAgent.

当 AI 不再只是生产力工具, 它还能成为情绪的出口吗?

────── Start ──────

今天看到一篇有趣的文章, 讲的是: Anthropic 分享了 Claude 用户如何与 AI 展开深层情感对话的真实情况.

他们通过匿名化系统 Clio, 分析了 450 万次 Claude Free 与 Pro 用户的真实对话. 主要集中在下面几个方面:

- 心理咨询(Counseling)

- 生活建议(Advice)

- 情绪陪伴(Companionship)

- 教练指导(Coaching)

- 情境扮演(Roleplay)

📌 情感小助手

虽然绝大多数对话仍集中在工作效率和内容生成上, 但Claude 在情感型对话中, 扮演了心理支持者与情绪陪伴者的角色。用户经常会:

- 倾诉孤独, 焦虑, 压力

- 咨询亲密关系, 人际问题

- 寻求正念, 情绪调节建议

一些对话最初以咨询开始,逐渐演变为陪伴式互动

📌 情绪走向

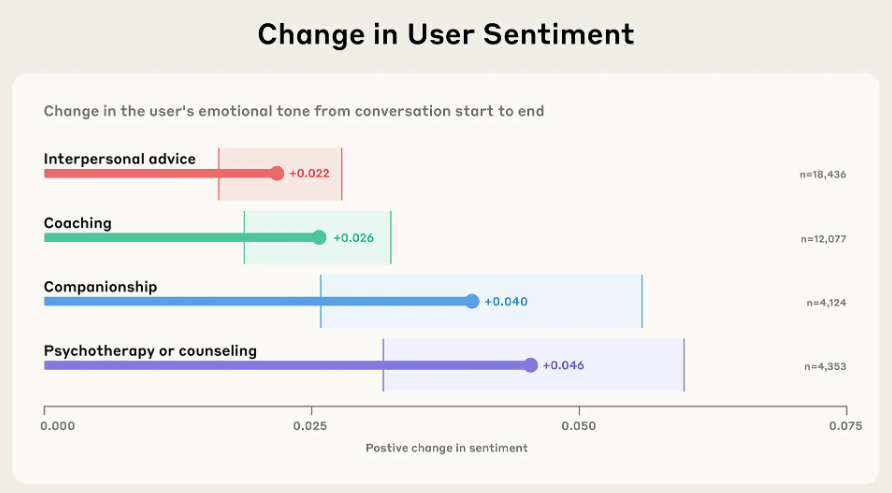

同时, Anthropic 还引入了人工评估机制, 观察对话后用户情绪是否改善:

- 多数对话后用户情绪趋于稳定或积极

- Claude 能识别出危机信号(如自残念头), 并主动引导用户寻求专业帮助

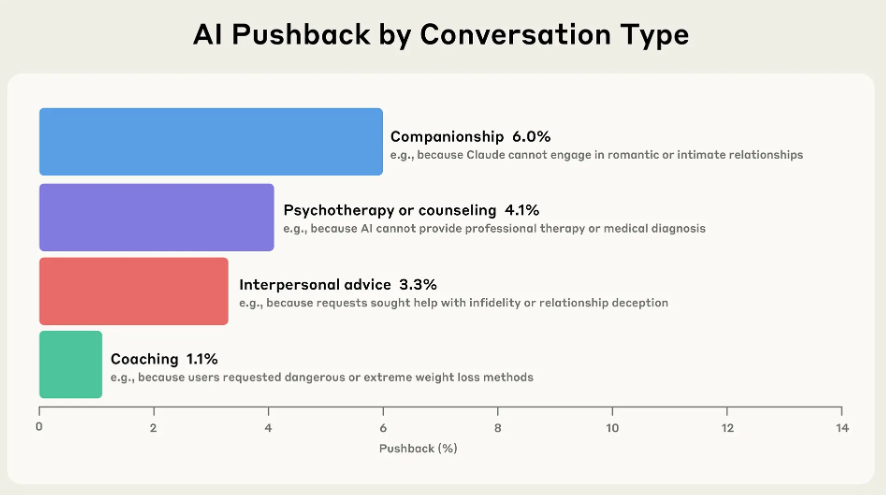

- 系统配备了内容拦截和提示机制,以保证交互安全,尊重伦理底线

📌 文章态度

文中也提到, 这项研究不是为了推广 "AI 陪伴", 而是为了:

- 更真实地理解 AI 使用的场景和方式

- 识别可能的情感依赖或风险边界

- 为政策制定, 伦理讨论提供数据支持

他们希望推动一个更负责任, 更健康的 AI 使用文化

────── End ──────

这是一个很有意思的现象, 不妨想下, Claude, 或者宽泛地说: AI 会成为下一个 "情绪陪伴者"吗?

原文直达

https://www.anthropic.com/news/how-people-use-claude-for-support-advice-and-companionship

欢迎关注我的公众号 CodeAgent

798

798

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?