关系数据库的数据入湖,有多种场景、多种工具、多种入湖时效要求等,本文梳理相关场景,以及对应的建议方案。

首先介绍下两种入湖工具:批量数据迁移工具(如CDM)和实时数据接入工具(如CDL)。

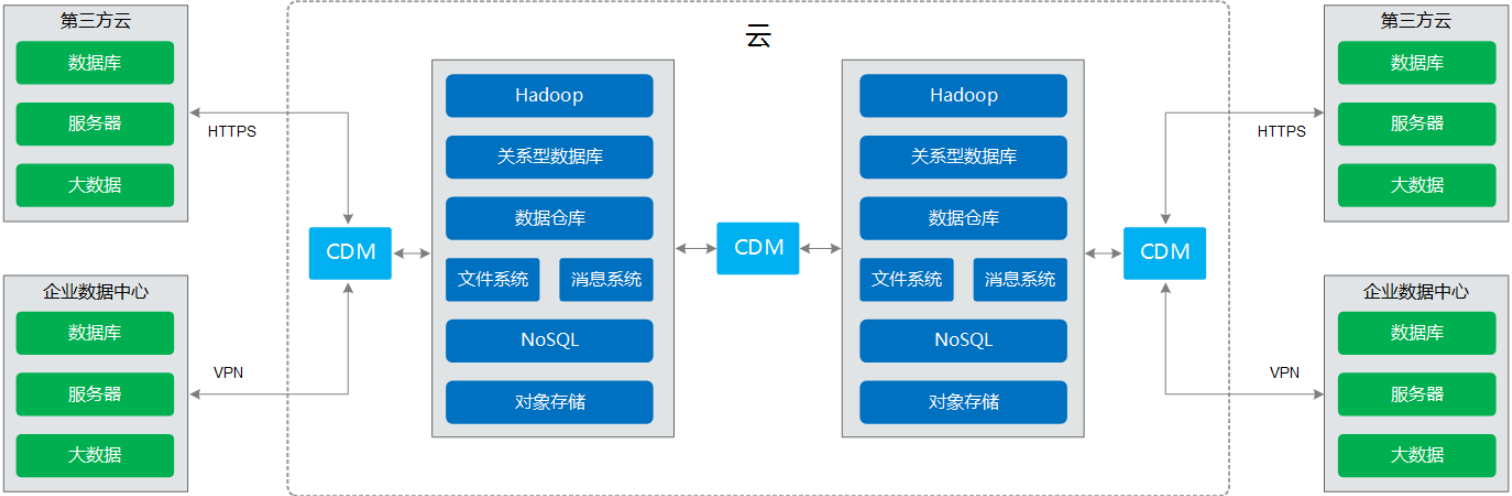

批量数据迁移工具,可以一次全量、一次全量+批次增量的方式将数据从关系数据库的数据迁移到数据湖,往往入湖时效性(从数据产生到数据进入数据湖贴源层)在10多分钟或更长,如15分钟左右,取决于批次增量迁移任务的时间间隔。以下是批量数据迁移工具(CDM)的功能架构图:

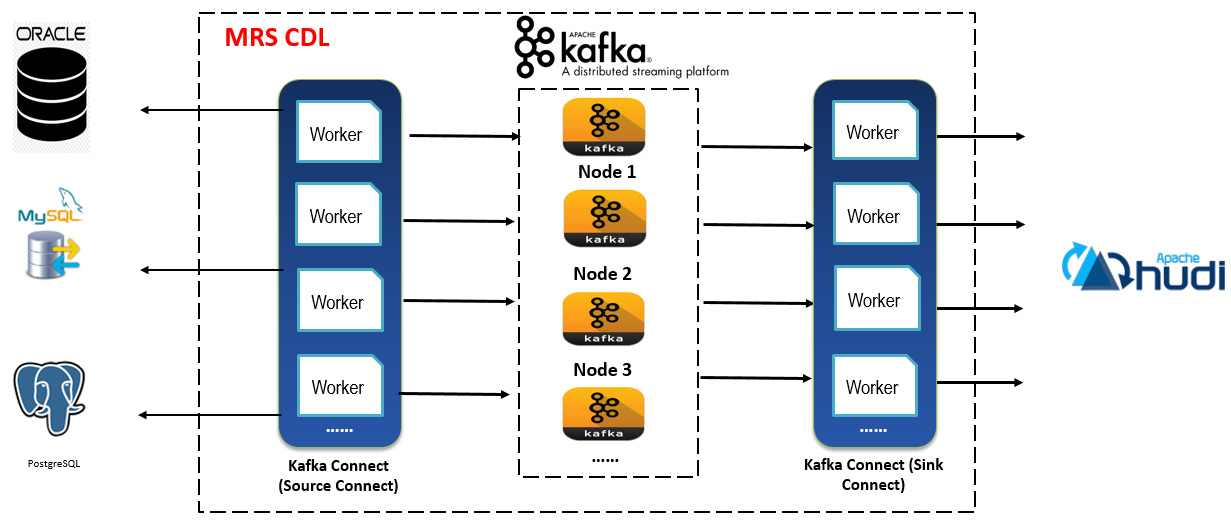

实时数据接入工具(如CDL),可以实时捕获关系数据库的binlog日志,保存在消息队列如Kafka,并支持实时解析binlog日志生成增删改命令来操作数据湖的数据记录,实现关系数据库的数据实时入湖,入湖时效性在秒级或分钟级,一般小于15分钟。以下是实时数据接入工具(CDL)的功能架构图:

场景1:关系数据库有存量历史数据,无实时产生的新数据

方案:

- 入湖工具:批量数据迁移工具(如CDM)

- 入湖方式:整表迁移,示意如下:

- 入湖流程:

- 使用入湖工具,配置关系数据库作为源端,配置HDFS/Hive的目录作为目的端;

- 用入湖工具启动入湖作业,关系数据库-》HDFS目

本文详细介绍了关系数据库数据入湖的四种场景及其对应方案,包括批量迁移工具(CDM)和实时数据接入工具(CDL)的应用,旨在实现数据的实时或近实时入湖。场景覆盖了历史数据一次性迁移、实时增量数据处理等不同需求,适用于各种业务场景。

本文详细介绍了关系数据库数据入湖的四种场景及其对应方案,包括批量迁移工具(CDM)和实时数据接入工具(CDL)的应用,旨在实现数据的实时或近实时入湖。场景覆盖了历史数据一次性迁移、实时增量数据处理等不同需求,适用于各种业务场景。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?