小白安装Docker遇到的问题总结## 标题

PS:每个人在安装过程中遇到的问题可能不同,同一问题的解决方法也可能不同,我仅提供自己的解决方法,不一定通用。

1.首先按照网络上的步骤安装后,出现了Error with pre-create check: "Get https://github.com/boot2docker/boot2docker这个问题

解决方法:下载boot2docker.iso文件,到C:\Users\XXX.docker\machine\cache路径下面,将未下载完成的文件删除,将下载好的文件放到该路径下面

注意:安装完成后,需在断网的条件下,重新启动Docker Quickstart Terminal

不然会提示boot2docker.iso out of date 重新下载如图

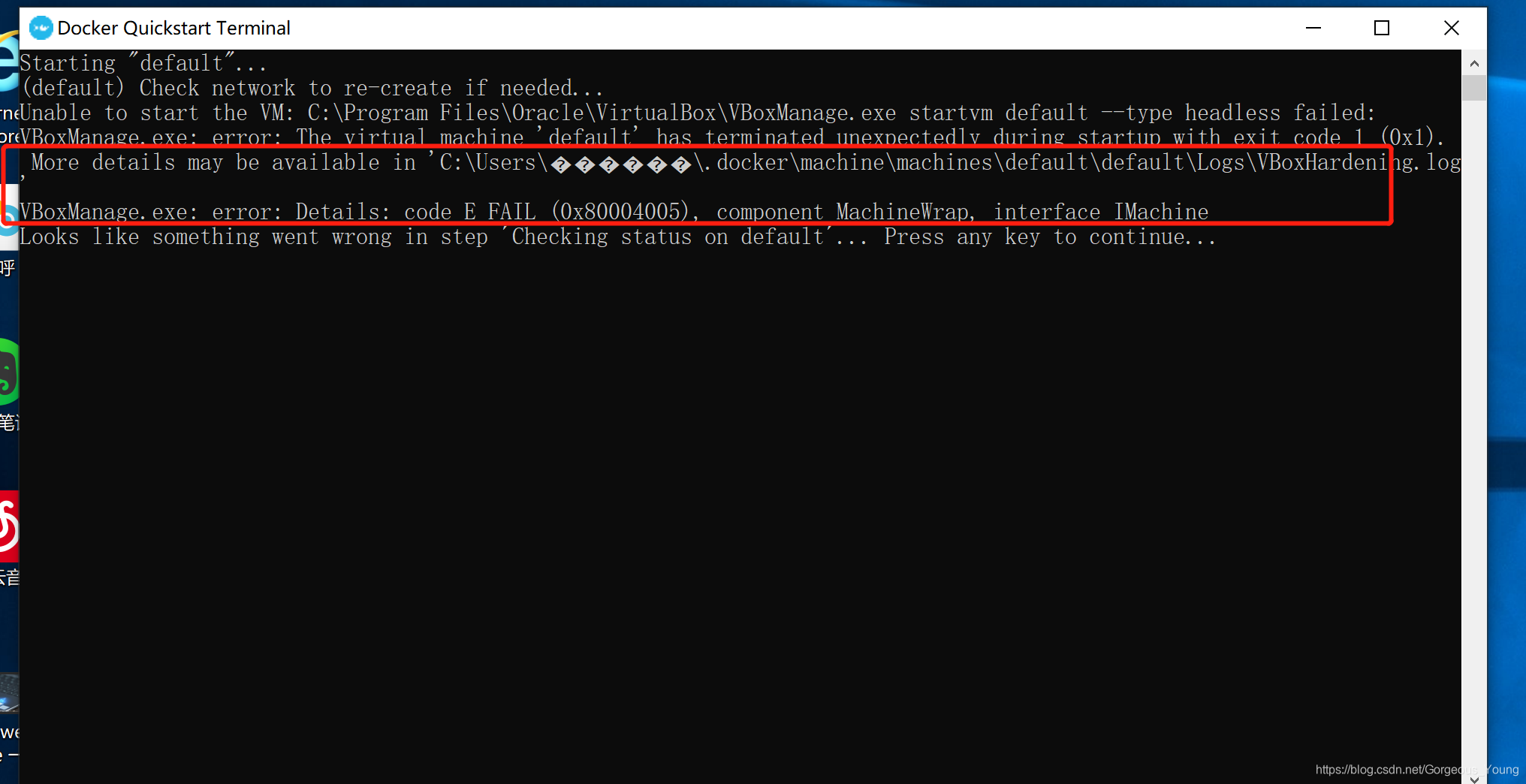

2.重新启动后会报 VBoxManage.exe: error: Details: code E_FAIL (0x80004005), component MachineW的错误

解决方法:重新装了Oracle VM VirtualBox,断网重新启动Docker Quickstart Terminal

下载地址:https://www.virtualbox.org/wiki/Downloads

本文总结了小白在安装Docker过程中遇到的常见问题及解决方案,包括Boot2Docker ISO文件错误、VirtualBox启动失败和IP获取停滞等,并提供了相应的解决步骤和参考资料。

本文总结了小白在安装Docker过程中遇到的常见问题及解决方案,包括Boot2Docker ISO文件错误、VirtualBox启动失败和IP获取停滞等,并提供了相应的解决步骤和参考资料。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

8345

8345

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?