更多Python学习内容:ipengtao.com

文本数据在机器学习和自然语言处理任务中扮演着重要角色,但原始文本数据通常需要经过预处理才能用于模型训练和分析。本文将介绍Python中常用的文本预处理技术,包括数据清洗、分词、词性标注、停用词去除、词向量表示等,通过丰富的示例代码帮助大家理解和应用这些技术。

数据清洗

1. 清除特殊字符

在文本预处理中,首先需要清除文本中的特殊字符,例如标点符号、数字等。

示例代码如下:

import re

text = "Hello, world! 123"

cleaned_text = re.sub(r'[^a-zA-Z\s]', '', text)

print(cleaned_text) # 输出 "Hello world"这段代码使用正则表达式去除了文本中的数字和标点符号,保留了字母和空格。

2. 大小写转换

为了统一文本数据的格式,通常需要将文本中的字母转换为统一的大小写。

示例代码如下:

text = "Hello World"

lowercased_text = text.lower()

print(lowercased_text) # 输出 "hello world"这段代码将文本中的字母转换为小写形式。

分词和词性标注

1. 分词

分词是将文本拆分为单词或词组的过程,常用的分词工具包括NLTK和spaCy。

示例代码如下:

import nltk

text = "Natural language processing is fun"

tokens = nltk.word_tokenize(text)

print(tokens) # 输出 ['Natural', 'language', 'processing', 'is', 'fun']这段代码使用NLTK进行分词,将文本拆分为单词列表。

2. 词性标注

词性标注是将单词与它们的词性(名词、动词、形容词等)进行关联的过程。

示例代码如下:

import nltk

text = "Natural language processing is fun"

tokens = nltk.word_tokenize(text)

pos_tags = nltk.pos_tag(tokens)

print(pos_tags) # 输出 [('Natural', 'JJ'), ('language', 'NN'), ('processing', 'NN'), ('is', 'VBZ'), ('fun', 'JJ')]这段代码使用NLTK进行词性标注,将单词与它们的词性关联起来。

停用词去除

停用词是指在文本分析中没有实际意义或者频率很高的词语,如“的”、“了”等。在文本预处理中,通常需要去除这些停用词以提高模型的准确性。

示例代码如下:

from nltk.corpus import stopwords

text = "This is an example sentence"

tokens = nltk.word_tokenize(text)

filtered_tokens = [word for word in tokens if word.lower() not in stopwords.words('english')]

print(filtered_tokens) # 输出 ['example', 'sentence']这段代码使用NLTK去除了文本中的停用词,保留了实际意义的单词。

词向量表示

词向量是将单词表示为向量形式的技术,常用的词向量模型包括Word2Vec、GloVe等。

示例代码如下:

from gensim.models import Word2Vec

sentences = [['natural', 'language', 'processing'], ['machine', 'learning']]

model = Word2Vec(sentences, vector_size=100, window=5, min_count=1, workers=4)

word_vector = model.wv['language']

print(word_vector) # 输出词向量表示这段代码使用Word2Vec模型将单词表示为100维的词向量。

文本规范化

文本规范化是文本预处理中的重要步骤之一,它包括词干化(Stemming)和词形归并(Lemmatization)等技术,用于将词语转换为其基本形式或规范形式。

1. 词干化(Stemming)

词干化是将词语转换为其词干或基本形式的过程,通常通过去除词尾来实现。

示例代码如下:

from nltk.stem import PorterStemmer

words = ['running', 'ran', 'runs']

stemmer = PorterStemmer()

stemmed_words = [stemmer.stem(word) for word in words]

print(stemmed_words) # 输出 ['run', 'ran', 'run']这段代码使用NLTK的PorterStemmer进行词干化处理,将单词转换为其词干形式。

2. 词形归并(Lemmatization)

词形归并是将词语转换为其在词典中的基本形式(词形)的过程,通常考虑词义和语境。

示例代码如下:

from nltk.stem import WordNetLemmatizer

words = ['running', 'ran', 'runs']

lemmatizer = WordNetLemmatizer()

lemmatized_words = [lemmatizer.lemmatize(word) for word in words]

print(lemmatized_words) # 输出 ['running', 'ran', 'run']这段代码使用NLTK的WordNetLemmatizer进行词形归并处理,将单词转换为其在词典中的基本形式。

文本向量化

文本向量化是将文本数据转换为数值向量的过程,常用的技术包括词袋模型(Bag of Words)、TF-IDF表示等。

1. 词袋模型(Bag of Words)

词袋模型将文本表示为单词出现的频率向量,每个单词对应一个维度。

示例代码如下:

from sklearn.feature_extraction.text import CountVectorizer

corpus = ['This is an example sentence.', 'Another example sentence.']

vectorizer = CountVectorizer()

X = vectorizer.fit_transform(corpus)

print(X.toarray()) # 输出文本的词袋表示这段代码使用CountVectorizer将文本转换为词袋模型表示。

2. TF-IDF表示

TF-IDF(Term Frequency-Inverse Document Frequency)表示考虑了单词在文档中的频率和在整个语料库中的重要性,常用于文本分类和信息检索任务。

示例代码如下:

from sklearn.feature_extraction.text import TfidfVectorizer

corpus = ['This is an example sentence.', 'Another example sentence.']

vectorizer = TfidfVectorizer()

X = vectorizer.fit_transform(corpus)

print(X.toarray()) # 输出文本的TF-IDF表示这段代码使用TfidfVectorizer将文本转换为TF-IDF表示。

总结

在Python中进行文本预处理是数据科学和自然语言处理领域中的关键步骤之一。本文详细介绍了常用的文本预处理技术,包括数据清洗、分词、词性标注、停用词去除、词干化、词形归并、文本向量化等。通过这些技术,可以有效地处理原始文本数据,为后续的文本分析和模型构建提供清洁、规范的数据基础。文中的示例代码和实用技巧有助于读者更好地理解和应用这些技术,提升文本处理的效率和准确性。总之,掌握Python中的文本预处理技术对于从事文本分析和自然语言处理的开发者和研究人员来说至关重要,希望本文能为大家在这方面的学习和实践提供有益的指导和启发。

如果你觉得文章还不错,请大家 点赞、分享、留言 ,因为这将是我持续输出更多优质文章的最强动力!

更多Python学习内容:ipengtao.com

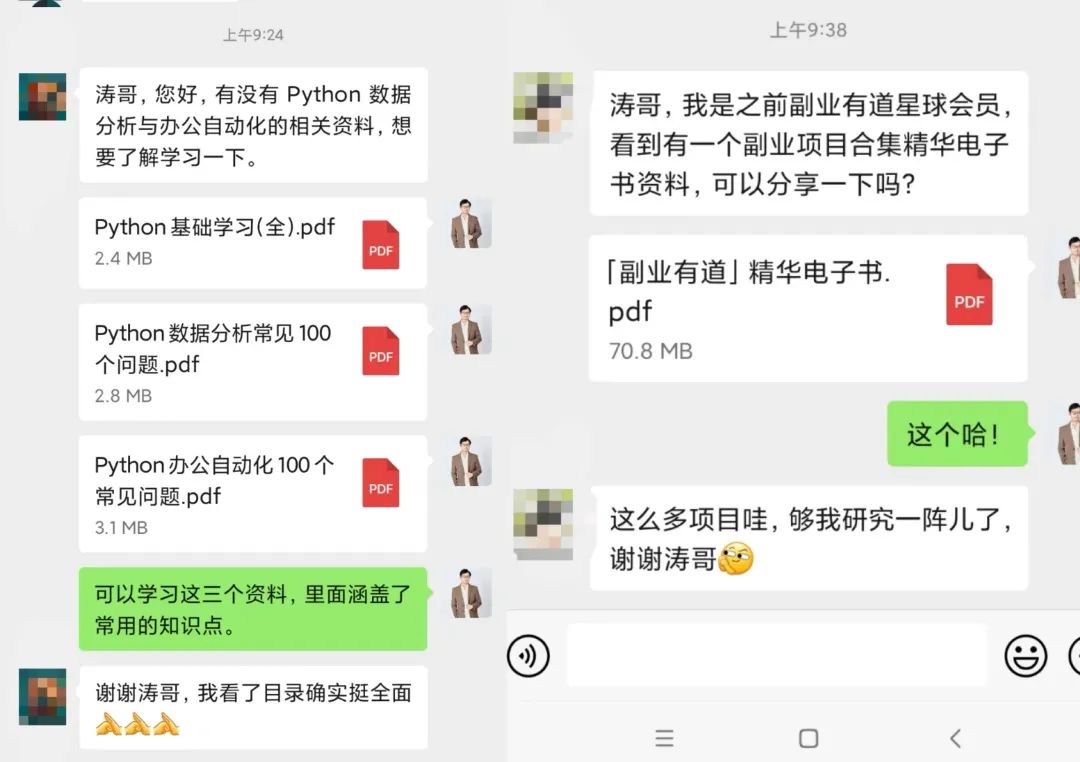

如果想要系统学习Python、Python问题咨询,或者考虑做一些工作以外的副业,都可以扫描二维码添加微信,围观朋友圈一起交流学习。

我们还为大家准备了Python资料和副业项目合集,感兴趣的小伙伴快来找我领取一起交流学习哦!

往期推荐

Python 中的 isinstance() 函数:类型检查的利器

点击下方“阅读原文”查看更多

本文详细介绍了Python中文本预处理技术,包括数据清洗、分词、词性标注、停用词去除、词向量表示、文本规范化和文本向量化。通过示例代码展示了如何应用这些技术,为机器学习和自然语言处理任务做准备。

本文详细介绍了Python中文本预处理技术,包括数据清洗、分词、词性标注、停用词去除、词向量表示、文本规范化和文本向量化。通过示例代码展示了如何应用这些技术,为机器学习和自然语言处理任务做准备。

398

398

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?