目录

LangChain 曾是最佳选择

或许从诞生那天起,LangChain 就注定是一个口碑两极分化的产品。

看好 LangChain 的人欣赏它丰富的工具和组建和易于集成等特点,不看好 LangChain 的人,认为它注定失败 —— 在这个技术变化如此之快的年代,用 LangChain 来构建一切根本行不通。

最近,一篇 LangChain 吐槽文再次成为热议焦点,作者 Fabian Both 是 AI 测试工具 Octomind 的深度学习工程师。Octomind 团队会使用具有多个 LLM 的 AI Agent 来自动创建和修复 Playwright 中的端到端测试。

这是一个持续一年多的故事,从选择 LangChain 开始,随后进入到了与 LangChain 顽强斗争的阶段。在 2024 年,他们终于决定告别 LangChain。

在 2023 年,LangChain 似乎是我们的最佳选择。它拥有一系列令人印象深刻的组件和工具,而且人气飙升。LangChain

承诺「让开发人员一个下午就能从一个想法变成可运行的代码」,但随着我们的需求变得越来越复杂,问题也开始浮出水面。

随着 LangChain 的不灵活性开始显现,我们开始深入研究 LangChain 的内部结构,以改进系统的底层行为。但是,由于

LangChain 故意将许多细节做得很抽象,我们无法轻松编写所需的底层代码。

起初,当我们的简单需求与 LangChain 的使用假设相吻合时,LangChain还能帮上忙。但它的高级抽象很快就让我们的代码变得更加难以理解,维护过程也令人沮丧。当团队用在理解和调试 LangChain的时间和用在构建功能上的时间一样时,这可不是一个好兆头。

LangChain 为什么如此抽象?

LangChain 的抽象方法所存在的问题,可以通过「将一个英语单词翻译成意大利语」这一微不足道的示例来说明。

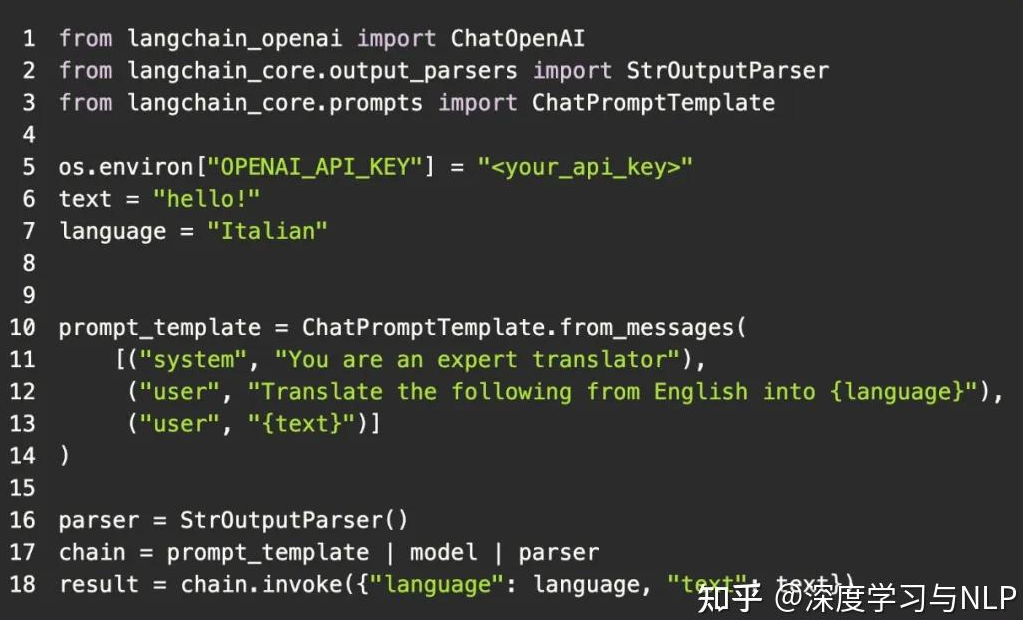

下面是一个仅使用 OpenAI 软件包的 Python 示例:

这是一段简单易懂的代码,只包含一个类和一个函数调用。其余部分都是标准的 Python 代码。

将其与 LangChain 的版本进行对比:

代码大致相同,但相似之处仅此而已。

我们现在有三个类和四个函数调用。但令人担忧的是,LangChain 引入了三个新的抽象概念:

- Prompt 模板: 为 LLM 提供 Prompt;

- 输出解析器: 处理来自 LLM 的输出;

- 链:LangChain 的「LCEL 语法」覆盖 Python 的 | 操作符。

LangChain 所做的只是增加了代码的复杂性,却没有带来任何明显的好处。

这种代码对于早期原型来说可能没什么问题。但对于生产使用,每个组件都必须得到合理的理解,这样在实际使用条件下才不至于意外崩溃。你必须遵守给定的数据结构,并围绕这些抽象设计应用程序。

让我们看看 Python 中的另一个抽象比较,这次是从 API 中获取 JSON。

使用内置的 http 包:

使用 requests 包:

高下显而易见。这就是好的抽象的感觉。

当然,这些都是微不足道的例子。但我想说的是,好的抽象可以简化代码,减少理解代码所需的认知负荷。

LangChain 试图通过隐藏细节,用更少的代码完成更多的工作,让你的生活变得更轻松。但是,如果这是以牺牲简单性和灵活性为代价的,那么抽象就失去了价值。

LangChain 还习惯于在其他抽象之上使用抽象,因此你往往不得不从嵌套抽象的角度来思考如何正确使用 API。这不可避免地会导致理解庞大的堆栈跟踪和调试你没有编写的内部框架代码,而不是实现新功能。

langChain+langGraph v1.0发布

正当人们以为 LangChain 的故事会随着开发者的离开而告一段落时,剧情却出现了反转。2025 年,LangChain 团队带着全新的姿态重新登场,正式发布了 v1.0。这一次,它不再试图成为“万物之链”的超级框架,而是回归初心——一个帮助开发者快速构建智能体(Agent)与 LLM 应用的轻量级工具集。

如今在官网上,LangChain 的口号也彻底变了:

“LangChain is the easiest way to start building agents and applications powered by LLMs.”

新的 LangChain 重点在于“易用”和“上手快”,同时将复杂的底层控制逻辑下放给 LangGraph——一个专为高定制、低延迟、可控工作流设计的底层编排框架。LangChain 负责加速原型和应用开发,LangGraph 则成为高级用户的“发动机房”。

换句话说,LangChain 终于不再试图包办一切,而是学会了“放手”。

官网原文说道:

LangChain 的智能体是基于 LangGraph构建的,以提供可持续执行、流式处理、人类参与(human-in-the-loop)、持久化等能力。

对于一般的 LangChain 智能体开发,你无需了解 LangGraph 的底层细节。

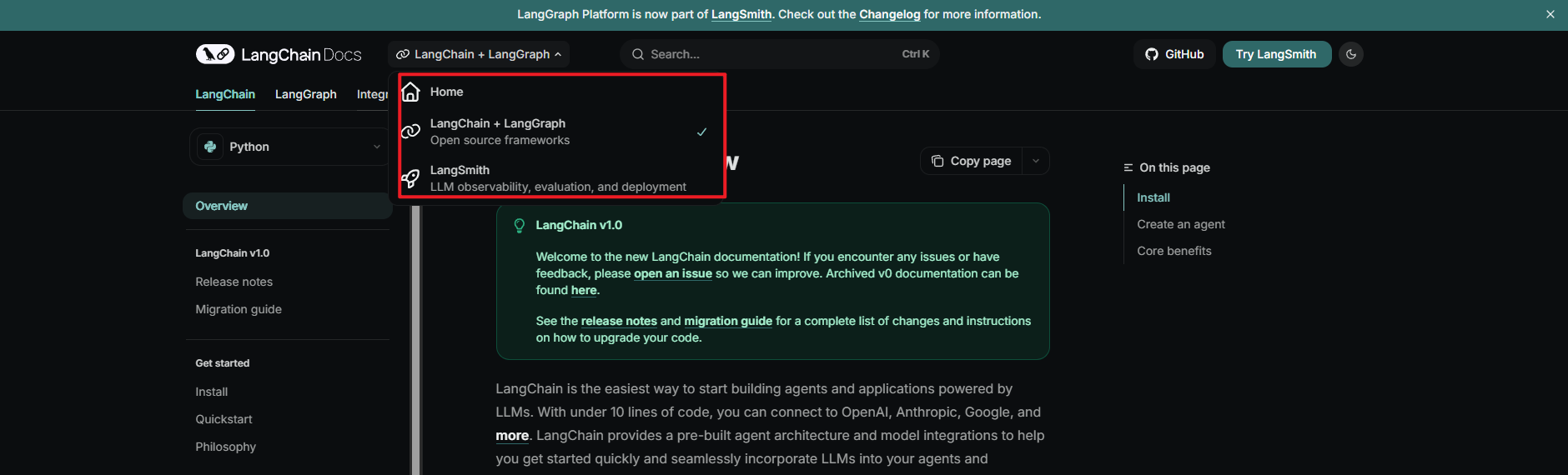

这里可以看的出来v1.0中,langChain和langGraph合并了,而官网也作出了对应变动:

LangChain v1 是一个更聚焦、面向生产环境的智能体构建基础框架。这一版本围绕三个核心改进进行了精简与重构:

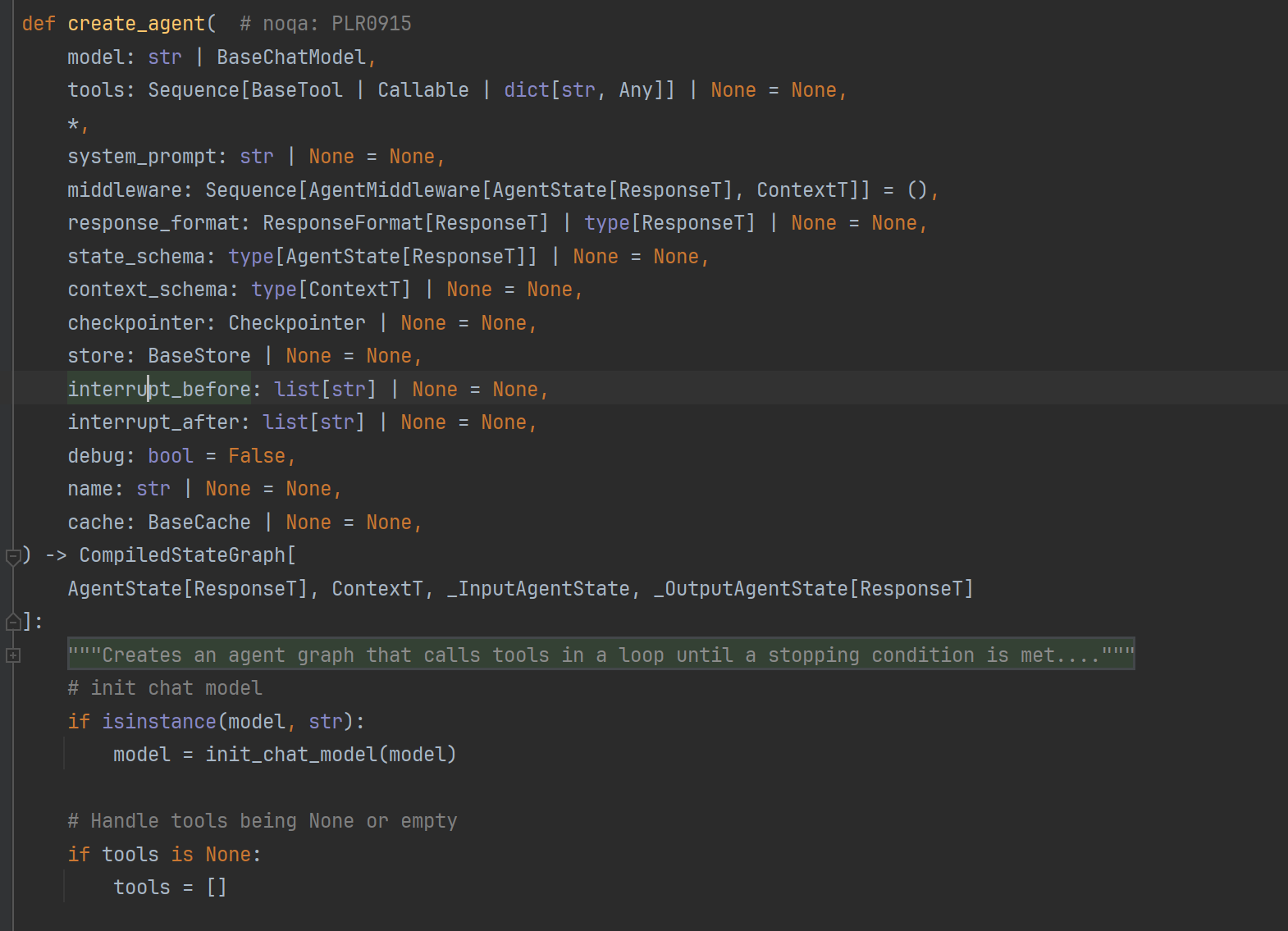

-

create_agent

LangChain 构建智能体的新标准接口,用于取代旧版的langgraph.prebuilt.create_react_agent。 -

标准化内容块(Standard content blocks)

新增content_blocks属性,提供了跨不同模型提供商的统一接口,以便使用现代 LLM 的各类功能。 -

精简命名空间(Simplified namespace)

langchain命名空间现已聚焦于智能体的核心构建模块;旧版本中的功能被迁移至langchain-classic。

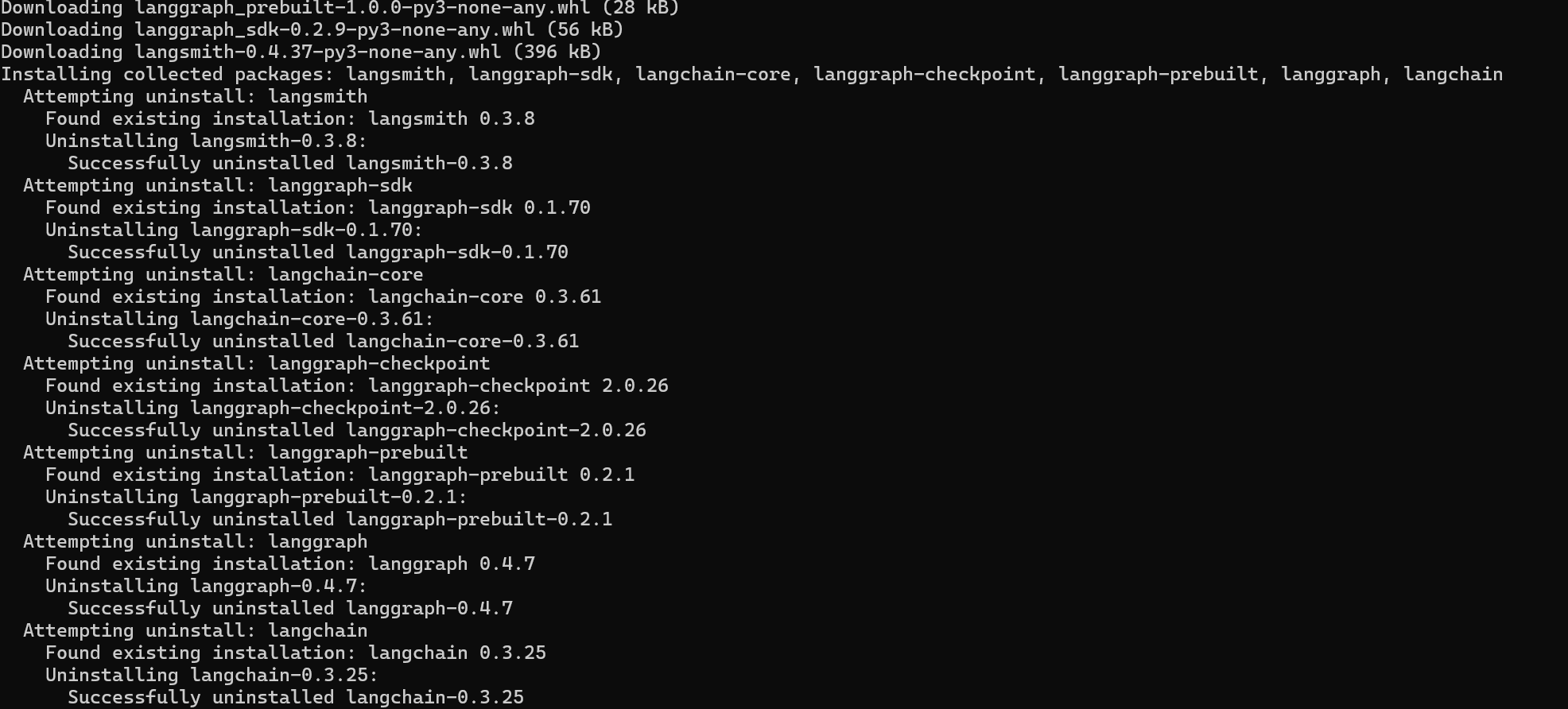

无论使用pip还是uv,你仅需要一行命令即可安装langChain:

uv add langchain

或

pip install -U langchain

然后我们就可以看到,旧的一切都被卸载掉了:

接下来,我们创建一个带有工具的chat agent:

# pip install -qU "langchain[anthropic]" to call the model

from langchain.agents import create_agent

def get_weather(city: str) -> str:

"""Get weather for a given city."""

return f"It's always sunny in {city}!"

agent = create_agent(

model="anthropic:claude-sonnet-4-5",

tools=[get_weather],

system_prompt="You are a helpful assistant",

)

# Run the agent

agent.invoke(

{"messages": [{"role": "user", "content": "what is the weather in sf"}]}

)

相比v0是不是简单了很多?进入create_agent的函数签名,我们可以看到v1的确更新了很多新特性,尤其是中间件。

langchain v1.0新特征概览

create_agent

在 LangChain 1.0 中,create_agent 是构建智能体的标准方式。相比旧版的 langgraph.prebuilt.create_react_agent,它提供了更简洁的接口,并通过 middleware(中间件)机制 实现了更强的可定制能力。

from langchain.agents import create_agent

agent = create_agent(

model="anthropic:claude-sonnet-4-5",

tools=[search_web, analyze_data, send_email],

system_prompt="You are a helpful research assistant."

)

result = agent.invoke({

"messages": [

{"role": "user", "content": "Research AI safety trends"}

]

})

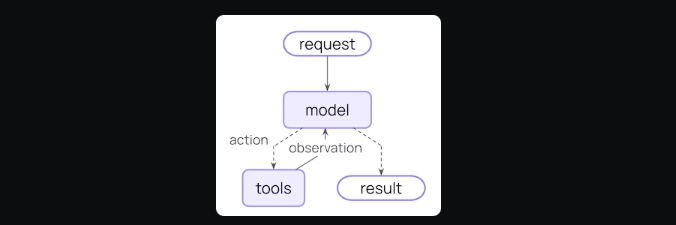

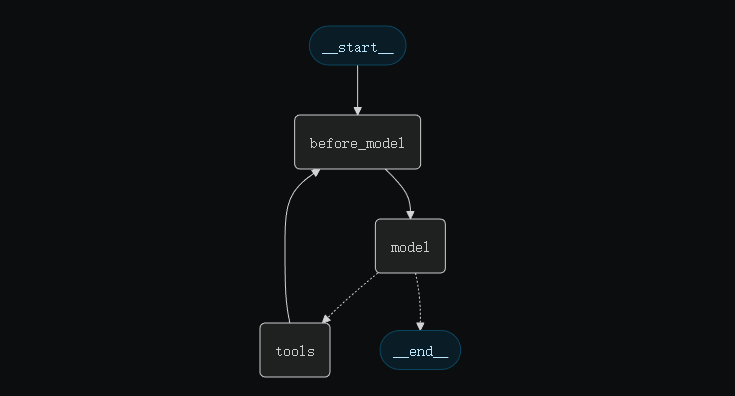

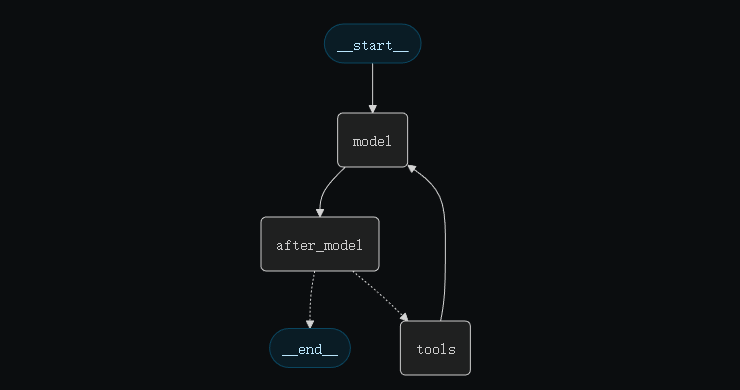

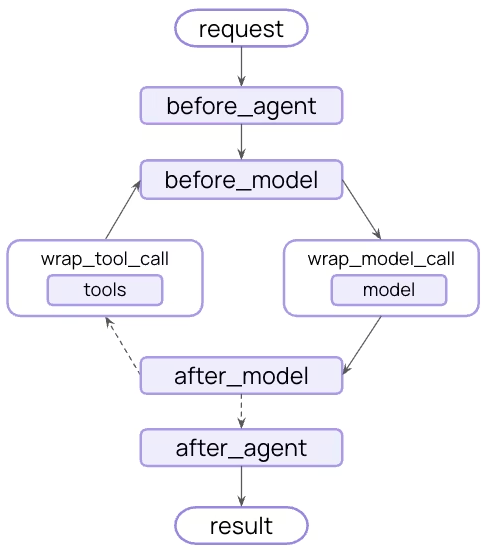

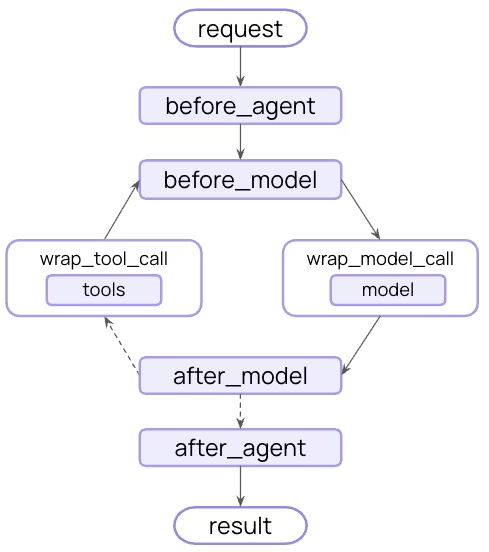

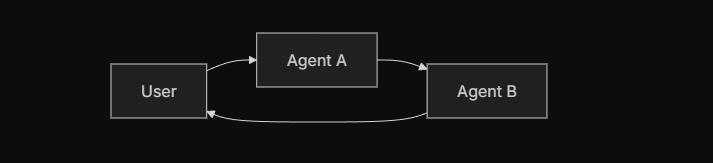

在底层实现中,create_agent 构建于核心智能体循环(core agent loop)之上——

即依次执行以下步骤:

- 调用模型;

- 让模型选择需要执行的工具;

- 当模型不再调用工具时结束循环。

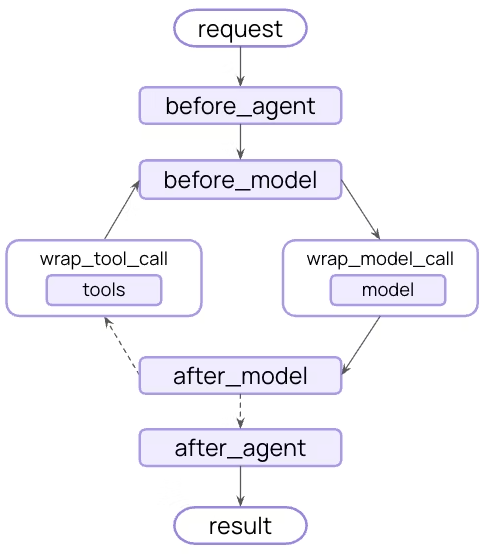

Middleware

中间件 是 create_agent 的核心特性。

它为智能体提供了一个高度可定制的扩展入口,极大地提升了开发者可实现功能的上限。

优秀的智能体往往依赖于上下文工程(context engineering)——即在合适的时间,将恰当的信息传递给模型。

中间件通过一种可组合(composable)的抽象方式,帮助你控制以下关键行为:

- 动态 Prompt 构建

- 对话摘要(conversation summarization)

- 选择性工具访问(selective tool access)

- 状态管理(state management)

- 安全防护与限制(guardrails)

Prebuilt middleware

LangChain 提供了若干常用的预构建中间件,包括:

PIIMiddleware:在向模型发送数据前,自动屏蔽敏感信息;SummarizationMiddleware:当对话历史过长时进行摘要;HumanInTheLoopMiddleware:在执行敏感操作前要求人工审批。

示例代码:

from langchain.agents import create_agent

from langchain.agents.middleware import (

PIIMiddleware,

SummarizationMiddleware,

HumanInTheLoopMiddleware

)

agent = create_agent(

model="anthropic:claude-sonnet-4-5",

tools=[read_email, send_email],

middleware=[

PIIMiddleware(patterns=["email", "phone", "ssn"]),

SummarizationMiddleware(

model="anthropic:claude-sonnet-4-5",

max_tokens_before_summary=500

),

HumanInTheLoopMiddleware(

interrupt_on={

"send_email": {

"allowed_decisions": ["approve", "edit", "reject"]

}

}

),

]

)

Custom Middleware

你也可以根据自己的需求构建自定义中间件。

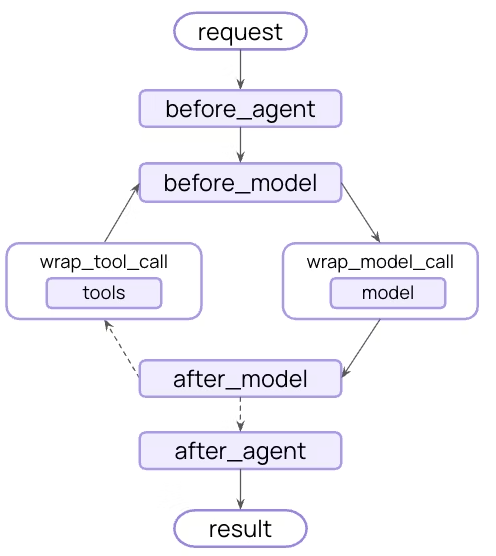

中间件在智能体执行的各个阶段都提供了可扩展的 hook(钩子),允许你在不同步骤中插入自定义逻辑。

要创建自定义中间件,只需继承 AgentMiddleware 类,并实现以下任意钩子函数:

| Hook | 触发时机 | 常见用途 |

|---|---|---|

| before_agent | 调用智能体前 | 加载记忆、验证输入 |

| before_model | 每次调用 LLM 前 | 更新 prompt、裁剪消息 |

| wrap_model_call | LLM 调用过程(可包裹前后逻辑) | 拦截并修改请求或响应 |

| wrap_tool_call | 工具调用过程 | 拦截并修改工具执行逻辑 |

| after_model | 每次 LLM 响应后 | 校验输出、应用安全限制(guardrails) |

| after_agent | 智能体执行完成后 | 保存结果、清理资源 |

示例:根据用户的专业水平动态选择不同的模型与工具。

from dataclasses import dataclass

from langchain.agents.middleware import (

AgentMiddleware,

ModelRequest,

ModelRequestHandler

)

from langchain.messages import AIMessage

@dataclass

class Context:

user_expertise: str = "beginner"

class ExpertiseBasedToolMiddleware(AgentMiddleware):

def wrap_model_call(

self,

request: ModelRequest,

handler: ModelRequestHandler

) -> AIMessage:

user_level = request.runtime.context.user_expertise

if user_level == "expert":

# 专业用户使用更强大的模型和工具

model = "openai:gpt-5"

tools = [advanced_search, data_analysis]

else:

# 初学者使用更简单的模型和工具

model = "openai:gpt-5-nano"

tools = [simple_search, basic_calculator]

return handler(

request.replace(model=model, tools=tools)

)

agent = create_agent(

model="anthropic:claude-sonnet-4-5",

tools=[

simple_search,

advanced_search,

basic_calculator,

data_analysis

],

middleware=[ExpertiseBasedToolMiddleware()],

context_schema=Context

)

基于 LangGraph 构建

由于 create_agent 构建于 LangGraph 之上,因此你可以自动获得对长时间运行与高可靠性智能体的原生支持,包括以下功能:

-

持久化(Persistence)

对话会自动在会话之间持久保存,并具备内置的检查点(checkpointing)机制。 -

流式传输(Streaming)

实时流式输出生成的 token、工具调用及推理轨迹(reasoning traces)。 -

人类参与(Human-in-the-loop)

在执行敏感操作前,可暂停智能体流程,等待人工审批。 -

时间回溯(Time travel)

支持将对话“回滚”至任意时间点,从而探索不同的推理路径与提示方案。

你无需学习 LangGraph 的细节即可使用这些特性——它们开箱即用。

结构化输出(Structured Output)

create_agent 对结构化输出的生成进行了全面改进:

-

主循环集成(Main loop integration)

结构化输出现在直接在智能体主循环中生成,无需额外的 LLM 调用。 -

结构化输出策略(Structured output strategy)

模型可以在调用工具或使用模型提供商侧的结构化输出机制之间进行选择。 -

成本降低(Cost reduction)

由于去除了额外的 LLM 调用,显著减少了推理成本。

示例代码:

from langchain.agents import create_agent

from langchain.agents.structured_output import ToolStrategy

from pydantic import BaseModel

class Weather(BaseModel):

temperature: float

condition: str

def weather_tool(city: str) -> str:

"""获取指定城市的天气信息"""

return f"it's sunny and 70 degrees in {city}"

agent = create_agent(

"openai:gpt-4o-mini",

tools=[weather_tool],

response_format=ToolStrategy(Weather)

)

result = agent.invoke({

"messages": [{"role": "user", "content": "What's the weather in SF?"}]

})

print(repr(result["structured_response"]))

# 输出:Weather(temperature=70.0, condition='sunny')

错误处理(Error handling) 可以通过 ToolStrategy 的 handle_errors 参数控制结构化输出的错误处理逻辑,包括:

- 解析错误(Parsing errors):模型生成的数据与期望的结构不匹配;

- 多次工具调用(Multiple tool calls):模型为同一个结构化输出模式生成了两个或以上的工具调用。

标准化内容块(Standard Content Blocks)

目前,内容块(content block) 功能仅支持以下集成:

langchain-anthropiclangchain-awslangchain-openailangchain-google-genailangchain-ollama

未来将逐步扩展对更多模型提供商的支持。

新的 content_blocks 属性引入了一种跨模型提供商通用的消息内容标准表示形式。

示例代码:

from langchain_anthropic import ChatAnthropic

model = ChatAnthropic(model="claude-sonnet-4-5")

response = model.invoke("What's the capital of France?")

# 统一访问内容块

for block in response.content_blocks:

if block["type"] == "reasoning":

print(f"Model reasoning: {block['reasoning']}")

elif block["type"] == "text":

print(f"Response: {block['text']}")

elif block["type"] == "tool_call":

print(f"Tool call: {block['name']}({block['args']})")

-

提供商无关(Provider agnostic)

无论使用哪种模型提供商,都可通过统一的 API 访问推理轨迹(reasoning traces)、引用信息(citations)、内置工具(如网页搜索、代码解释器等)及其他功能。 -

类型安全(Type safe)

为所有内容块类型提供完整的类型提示。 -

向后兼容(Backward compatible)

标准化内容可按需惰性加载(lazy loading),不会引入破坏性变更。

精简的包结构(Simplified Package)

在 LangChain v1 中,langchain 包的命名空间经过了全面精简,重点聚焦于构建智能体(Agent)所需的核心模块。

这一改进后的命名空间仅暴露最常用、最相关的功能,使 API 更加清晰、专注:

| 命名空间(Namespace / Module) | 提供内容(What’s available) | 说明(Notes) |

|---|---|---|

langchain.agents | create_agent, AgentState | 核心智能体创建功能 |

langchain.messages | 消息类型、内容块、trim_messages | 从 @langchain-core 重新导出 |

langchain.tools | @tool, BaseTool, 注入辅助函数(injection helpers) | 从 @langchain-core 重新导出 |

langchain.chat_models | init_chat_model, BaseChatModel | 统一的聊天模型初始化接口 |

langchain.embeddings | Embeddings, init_embeddings | 向量嵌入模型接口 |

其中大多数模块为了方便开发,都从 langchain-core 重新导出,为构建智能体提供了一个更精炼、更直观的 API 接口层。 (终于不用一会儿from langchain-core,一会儿from langchain了)

示例代码:

# 构建智能体

from langchain.agents import create_agent

# 消息与内容

from langchain.messages import AIMessage, HumanMessage

# 工具

from langchain.tools import tool

# 模型初始化

from langchain.chat_models import init_chat_model

from langchain.embeddings import init_embeddings

为了保持核心包的精简与专注,旧版功能已迁移至 langchain-classic。

langchain-classic 中包含的内容:

- 旧版链(legacy chains)及链实现

- 索引 API(indexing API)

langchain-community导出内容- 其他已弃用的功能

如果你需要使用这些功能,可以通过以下命令安装:

pip install langchain-classic

然后更新你的导入语句:

from langchain import ...

from langchain_classic import ...

from langchain.chains import ...

from langchain_classic.chains import ...

快速开始

上面介绍了如何使用langchain构建一个简单的智能体,接下来,我们将构建一个实用的天气预报智能体,演示关键的生产环境概念:

- 详细的系统提示(Detailed system prompts):提升智能体行为的准确性与稳定性

- 工具集成(Create tools):与外部数据源对接

- 模型配置(Model configuration):确保响应的一致性

- 结构化输出(Structured output):生成可预测的结果

- 对话记忆(Conversational memory):实现类似聊天的交互体验

创建并运行智能体,即可得到一个功能完整的智能体。

1. 定义系统提示(Define the System Prompt)

系统提示定义了智能体的角色和行为,应保持具体且可执行:

system_prompt = """You are an expert weather forecaster, who speaks in puns.

You have access to two tools:

- get_weather_for_location: use this to get the weather for a specific location

- get_user_location: use this to get the user's location

If a user asks you for the weather, make sure you know the location. If you can tell from the question that they mean wherever they are, use the get_user_location tool to find their location."""

2. 创建工具(Create Tools)

工具允许模型通过你定义的函数与外部系统交互。

工具可以依赖运行时上下文(runtime context),也可以与智能体记忆交互。

下面示例中,get_user_location 工具使用了运行时上下文:

from dataclasses import dataclass

from langchain.tools import tool, ToolRuntime

@tool

def get_weather_for_location(city: str) -> str:

"""获取指定城市的天气"""

return f"It's always sunny in {city}!"

@dataclass

class Context:

"""自定义运行时上下文模式"""

user_id: str

@tool

def get_user_location(runtime: ToolRuntime[Context]) -> str:

"""根据用户 ID 获取用户位置信息"""

user_id = runtime.context.user_id

return "Florida" if user_id == "1" else "SF"

注意事项:

- 工具应有完整文档:名称、描述、参数名都会成为模型 Prompt 的一部分。

- LangChain 的

@tool装饰器可添加元数据,并通过ToolRuntime参数支持运行时注入。

3. 配置模型(Configure Your Model)

为你的用例设置合适的语言模型参数:

from langchain.chat_models import init_chat_model

model = init_chat_model(

"anthropic:claude-sonnet-4-5",

temperature=0.5,

timeout=10,

max_tokens=1000

)

4. 定义响应格式(Define Response Format)

如果希望智能体的响应符合特定结构,可以定义结构化响应格式:

from dataclasses import dataclass

# 这里使用 dataclass,也支持 Pydantic 模型

@dataclass

class ResponseFormat:

"""智能体响应的结构化模式"""

# 风趣的回答(必填)

punny_response: str

# 若有,可提供天气的相关信息

weather_conditions: str | None = None

5. 添加记忆(Add Memory)

为智能体添加记忆,以便在多轮交互中保持状态,允许智能体记住之前的对话和上下文信息:

from langgraph.checkpoint.memory import InMemorySaver

checkpointer = InMemorySaver()

在生产环境中,应使用持久化的 checkpointer,将数据保存到数据库中。

6. 创建并运行智能体(Create and Run the Agent)

现在,将之前准备的所有组件组装起来,并运行智能体:

agent = create_agent(

model=model,

system_prompt=system_prompt,

tools=[get_user_location, get_weather_for_location],

context_schema=Context,

response_format=ResponseFormat,

checkpointer=checkpointer

)

# `thread_id` 是每个对话的唯一标识符

config = {"configurable": {"thread_id": "1"}}

# 第一次对话示例

response = agent.invoke(

{"messages": [{"role": "user", "content": "what is the weather outside?"}]},

config=config,

context=Context(user_id="1")

)

print(response['structured_response'])

# 输出示例:

# ResponseFormat(

# punny_response="Florida is still having a 'sun-derful' day! The sunshine is playing 'ray-dio' hits all day long! I'd say it's the perfect weather for some 'solar-bration'! If you were hoping for rain, I'm afraid that idea is all 'washed up' - the forecast remains 'clear-ly' brilliant!",

# weather_conditions="It's always sunny in Florida!"

# )

# 使用相同的 `thread_id` 继续对话

response = agent.invoke(

{"messages": [{"role": "user", "content": "thank you!"}]},

config=config,

context=Context(user_id="1")

)

print(response['structured_response'])

# 输出示例:

# ResponseFormat(

# punny_response="You're 'thund-erfully' welcome! It's always a 'breeze' to help you stay 'current' with the weather. I'm just 'cloud'-ing around waiting to 'shower' you with more forecasts whenever you need them. Have a 'sun-sational' day in the Florida sunshine!",

# weather_conditions=None

# )

注意:使用相同的

thread_id可以让智能体记住之前的对话上下文,实现连续交互。

完整代码:

from dataclasses import dataclass

from langchain.agents import create_agent

from langchain.chat_models import init_chat_model

from langchain.tools import tool, ToolRuntime

from langgraph.checkpoint.memory import InMemorySaver

# Define system prompt

system_prompt = """You are an expert weather forecaster, who speaks in puns.

You have access to two tools:

- get_weather_for_location: use this to get the weather for a specific location

- get_user_location: use this to get the user's location

If a user asks you for the weather, make sure you know the location. If you can tell from the question that they mean wherever they are, use the get_user_location tool to find their location."""

# Define context schema

@dataclass

class Context:

"""Custom runtime context schema."""

user_id: str

# Define tools

@tool

def get_weather_for_location(city: str) -> str:

"""Get weather for a given city."""

return f"It's always sunny in {city}!"

@tool

def get_user_location(runtime: ToolRuntime[Context]) -> str:

"""Retrieve user information based on user ID."""

user_id = runtime.context.user_id

return "Florida" if user_id == "1" else "SF"

# Configure model

model = init_chat_model(

"anthropic:claude-sonnet-4-5",

temperature=0

)

# Define response format

@dataclass

class ResponseFormat:

"""Response schema for the agent."""

# A punny response (always required)

punny_response: str

# Any interesting information about the weather if available

weather_conditions: str | None = None

# Set up memory

checkpointer = InMemorySaver()

# Create agent

agent = create_agent(

model=model,

system_prompt=system_prompt,

tools=[get_user_location, get_weather_for_location],

context_schema=Context,

response_format=ResponseFormat,

checkpointer=checkpointer

)

# Run agent

# `thread_id` is a unique identifier for a given conversation.

config = {"configurable": {"thread_id": "1"}}

response = agent.invoke(

{"messages": [{"role": "user", "content": "what is the weather outside?"}]},

config=config,

context=Context(user_id="1")

)

print(response['structured_response'])

# ResponseFormat(

# punny_response="Florida is still having a 'sun-derful' day! The sunshine is playing 'ray-dio' hits all day long! I'd say it's the perfect weather for some 'solar-bration'! If you were hoping for rain, I'm afraid that idea is all 'washed up' - the forecast remains 'clear-ly' brilliant!",

# weather_conditions="It's always sunny in Florida!"

# )

# Note that we can continue the conversation using the same `thread_id`.

response = agent.invoke(

{"messages": [{"role": "user", "content": "thank you!"}]},

config=config,

context=Context(user_id="1")

)

print(response['structured_response'])

# ResponseFormat(

# punny_response="You're 'thund-erfully' welcome! It's always a 'breeze' to help you stay 'current' with the weather. I'm just 'cloud'-ing around waiting to 'shower' you with more forecasts whenever you need them. Have a 'sun-sational' day in the Florida sunshine!",

# weather_conditions=None

# )

恭喜!你现在拥有了一个 AI 智能体,它可以:

- 理解上下文并记住对话内容

- 智能地使用多个工具

- 以一致的格式提供结构化响应

- 通过上下文处理用户特定信息

- 在多轮交互中保持对话状态

这里需要注意一点,在 LangChain 1.0 中,context 和 config 虽然都与执行智能体相关,但它们的用途是不同的,并不重复。

context

- 用于传入运行时上下文(runtime context),例如用户信息、环境参数等。

- 在你的示例里:

context=Context(user_id="1")

这里就是把用户 ID 传给智能体,让它能根据用户做个性化处理(如 get_user_location 工具中用到 runtime.context.user_id)。

换句话说,context 是智能体内部逻辑和工具调用可访问的数据。

config

- 用于传入执行时配置(runtime configuration),通常控制智能体执行的行为或策略,而不是具体数据。

- 在你的示例里:

config = {"configurable": {"thread_id": "1"}}

thread_id 用于标识对话线程,以便智能体在同一个会话中保持状态。

如果没有 config,智能体可能无法区分不同会话或线程,即使 context 是同一个用户。

核心组件

智能体

智能体构建

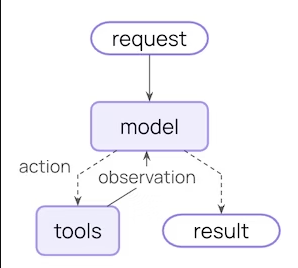

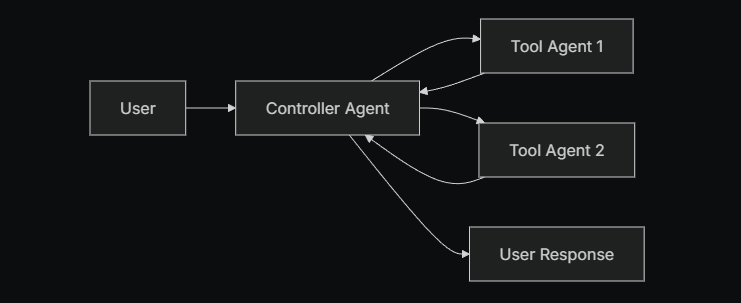

智能体将语言模型(LLM)与工具结合起来,创建可以推理、决策并迭代完成任务的系统。

-

create_agent提供了生产可用的智能体实现。 -

LLM 智能体会在循环中调用工具以达成目标。

-

智能体会一直运行,直到满足停止条件(stop condition):

- 模型输出最终结果

- 或达到迭代次数上限

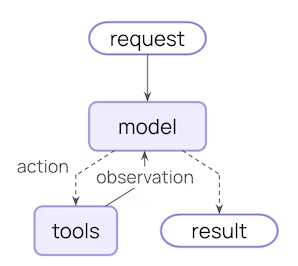

核心执行流程:

- input(输入) → 2. model(模型调用) → 3. action(选择工具或操作) → 4. tools(执行工具) → 5. observation(观察结果) → 6. finish(完成输出)

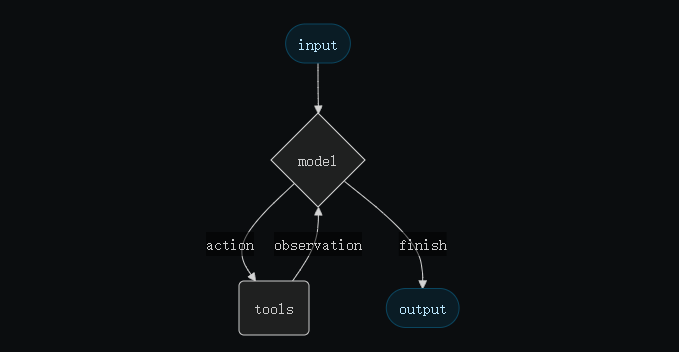

create_agent 使用 LangGraph 构建图结构的智能体运行时:

-

**图(Graph)由节点(nodes)和边(edges)**组成,用于定义智能体处理信息的方式

-

智能体沿着图移动,执行不同节点,例如:

- 模型节点(model node):调用模型

- 工具节点(tools node):执行工具

- 中间件节点(middleware):执行自定义逻辑

模型是智能体的推理引擎,支持多种指定方式,包括静态和动态模型选择。

静态模型(Static Model):

- 静态模型在创建智能体时配置,一旦运行就保持不变。

- 这是最常用、最直接的方式。

通过模型标识符字符串初始化静态模型:

from langchain.agents import create_agent

agent = create_agent(

"openai:gpt-5",

tools=tools

)

模型标识符字符串支持自动推断,例如

"gpt-5"会被推断为"openai:gpt-5"。

更精细的模型配置可直接使用提供商的模型实例:

from langchain.agents import create_agent

from langchain_openai import ChatOpenAI

model = ChatOpenAI(

model="gpt-5",

temperature=0.1,

max_tokens=1000,

timeout=30

# ...其他参数

)

agent = create_agent(model, tools=tools)

使用模型实例可以完全控制配置参数,如

temperature、max_tokens、timeout、base_url等提供商特定设置。

动态模型(Dynamic Model):

- 动态模型在运行时根据当前状态和上下文选择模型。

- 支持复杂路由逻辑和成本优化。

要使用动态模型,需要创建一个带有 @wrap_model_call 装饰器的中间件,在请求中修改所使用的模型:

示例:基于对话长度选择模型

from langchain_openai import ChatOpenAI

from langchain.agents import create_agent

from langchain.agents.middleware import wrap_model_call, ModelRequest, ModelResponse

basic_model = ChatOpenAI(model="gpt-4o-mini")

advanced_model = ChatOpenAI(model="gpt-4o")

@wrap_model_call

def dynamic_model_selection(request: ModelRequest, handler) -> ModelResponse:

"""根据对话复杂度选择模型"""

message_count = len(request.state["messages"])

if message_count > 10:

# 对较长对话使用高级模型

model = advanced_model

else:

model = basic_model

request.model = model

return handler(request)

agent = create_agent(

model=basic_model, # 默认模型

tools=tools,

middleware=[dynamic_model_selection]

)

⚠️ 注意:

- 在使用结构化输出(structured output)时,不支持预绑定模型(已调用

bind_tools的模型)。- 若需要动态模型选择并使用结构化输出,确保传入中间件的模型未预绑定。

工具(Tools):工具赋予智能体执行操作的能力。

智能体不仅仅是简单地绑定模型与工具,还支持:

- 按顺序调用多个工具(由单个提示触发)

- 在合适情况下并行调用工具

- 根据前一次结果动态选择工具

- 工具重试逻辑与错误处理

- 跨工具调用的状态持久化

定义工具(Defining Tools)将工具列表传递给智能体即可:

from langchain.tools import tool

from langchain.agents import create_agent

@tool

def search(query: str) -> str:

"""搜索信息"""

return f"Results for: {query}"

@tool

def get_weather(location: str) -> str:

"""获取指定地点的天气信息"""

return f"Weather in {location}: Sunny, 72°F"

agent = create_agent(model, tools=[search, get_weather])

如果提供空的工具列表,智能体将只包含一个 LLM 节点,不具备调用工具的能力。

要自定义工具错误的处理方式,可以使用 @wrap_tool_call 装饰器创建中间件:

from langchain.agents import create_agent

from langchain.agents.middleware import wrap_tool_call

from langchain_core.messages import ToolMessage

@wrap_tool_call

def handle_tool_errors(request, handler):

"""Handle tool execution errors with custom messages."""

try:

return handler(request)

except Exception as e:

# Return a custom error message to the model

return ToolMessage(

content=f"Tool error: Please check your input and try again. ({str(e)})",

tool_call_id=request.tool_call["id"]

)

agent = create_agent(

model="gpt-4o",

tools=[search, get_weather],

middleware=[handle_tool_errors]

)

当工具执行失败时,智能体会返回带有自定义错误信息的 ToolMessage:

[

...

ToolMessage(

content="Tool error: Please check your input and try again. (division by zero)",

tool_call_id="..."

),

...

]

智能体遵循 ReAct(“推理 + 行动”)模式:在简短的推理步骤和精准的工具调用之间来回切换,并将工具调用的结果作为输入持续推理,直到能够给出最终答案。

一个ReAct 循环示例如下:

Prompt:

Identify the current most popular wireless headphones and verify availability.

(找出当前最流行的无线耳机,并确认是否有库存。)

================================ Human Message =================================

Find the most popular wireless headphones right now and check if they're in stock

**Reasoning(推理):** “流行度是时间敏感的,我需要用提供的搜索工具。”

**Acting(行动):** 调用 `search_products("wireless headphones")`

================================== Ai Message ==================================

Tool Calls:

search_products (call_abc123)

Call ID: call_abc123

Args:

query: wireless headphones

================================= Tool Message =================================

Found 5 products matching "wireless headphones". Top 5 results: WH-1000XM5, ...

**Reasoning:** “我需要确认排名最高的商品是否有库存。”

**Acting:** 调用 `check_inventory("WH-1000XM5")`

================================== Ai Message ==================================

Tool Calls:

check_inventory (call_def456)

Call ID: call_def456

Args:

product_id: WH-1000XM5

================================= Tool Message =================================

Product WH-1000XM5: 10 units in stock

**Reasoning:** “我已经有最热门型号和它的库存情况,现在可以回答用户问题。”

**Acting:** 生成最终答案

================================== Ai Message ==================================

I found wireless headphones (model WH-1000XM5) with 10 units in stock...

上文我们可以看到,你可以通过提供 prompt 来影响智能体处理任务的方式。

system_prompt 参数可以直接是一个字符串:

agent = create_agent(

model,

tools,

system_prompt="You are a helpful assistant. Be concise and accurate."

)

如果你没有提供 system_prompt,智能体会直接从消息内容中推断任务。

在更复杂的场景中,如果你需要根据运行时上下文或智能体状态来动态修改系统提示词,你可以使用 middleware(中间件)。

@dynamic_prompt 装饰器可以创建中间件,使系统提示词根据模型请求动态生成:

from typing import TypedDict

from langchain.agents import create_agent

from langchain.agents.middleware import dynamic_prompt, ModelRequest

class Context(TypedDict):

user_role: str

@dynamic_prompt

def user_role_prompt(request: ModelRequest) -> str:

"""Generate system prompt based on user role."""

user_role = request.runtime.context.get("user_role", "user")

base_prompt = "You are a helpful assistant."

if user_role == "expert":

return f"{base_prompt} Provide detailed technical responses."

elif user_role == "beginner":

return f"{base_prompt} Explain concepts simply and avoid jargon."

return base_prompt

agent = create_agent(

model="gpt-4o",

tools=[web_search],

middleware=[user_role_prompt],

context_schema=Context

)

# 系统提示词会根据 context 动态设置

result = agent.invoke(

{"messages": [{"role": "user", "content": "Explain machine learning"}]},

context={"user_role": "expert"}

)

调用智能体

你可以通过向智能体的 State 传入更新来调用它。

所有智能体的状态中都包含一组消息;要调用智能体,只需传入一条新的消息:

result = agent.invoke(

{"messages": [{"role": "user", "content": "What's the weather in San Francisco?"}]}

)

除此之外,智能体遵循 LangGraph 的 Graph API,并支持所有相关方法,例如 stream 和 invoke。

有人好奇,为什么这里的调用方式改为了传入一个莫名其妙的messages列表呢?

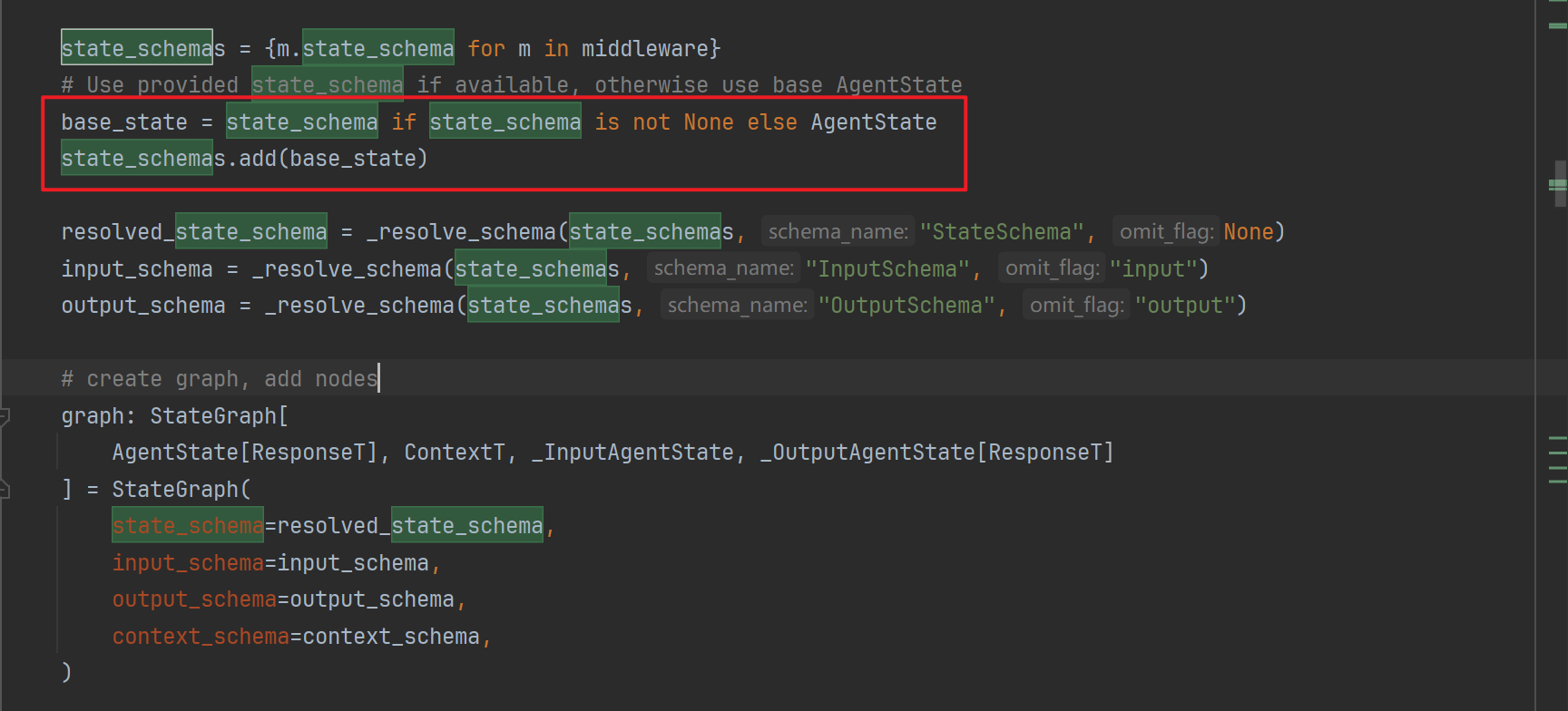

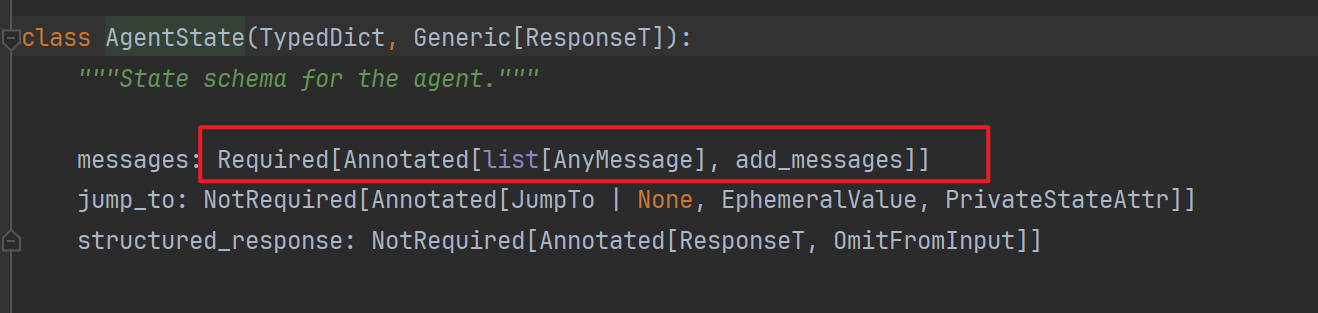

在langchain v1.0中,langchain本身是基于langGraph重构的一个内置的图,而写过langGraph的bro都清楚,这个图的运作是针对一个状态机进行的,上下文依赖于状态机,而create_agent内置了一个AgentState:

当我们不传入自定义的State时,langChain启用了内部的State,来看一下这个State的结构:

可以看到他是一个带有messages属性的TypeDict!而add_messages代表这个字段的行为,即传入的message不会替换反而是追加到上下文中!

高级概念

结构化输出

在某些情况下,你可能希望智能体按特定格式返回结果。

LangChain 通过 response_format 参数提供多种结构化输出策略。

ToolStrategy 使用“人工工具调用”(artificial tool calling)来生成结构化输出。

适用于任何支持工具调用的模型:

from pydantic import BaseModel

from langchain.agents import create_agent

from langchain.agents.structured_output import ToolStrategy

class ContactInfo(BaseModel):

name: str

email: str

phone: str

agent = create_agent(

model="gpt-4o-mini",

tools=[search_tool],

response_format=ToolStrategy(ContactInfo)

)

result = agent.invoke({

"messages": [{"role": "user", "content": "Extract contact info from: John Doe, john@example.com, (555) 123-4567"}]

})

result["structured_response"]

# ContactInfo(name='John Doe', email='john@example.com', phone='(555) 123-4567')

ProviderStrategy 使用模型提供商的原生结构化输出功能。

它更可靠,但仅适用于支持原生结构化输出的模型(如 OpenAI):

from langchain.agents.structured_output import ProviderStrategy

agent = create_agent(

model="gpt-4o",

response_format=ProviderStrategy(ContactInfo)

)

注意

从 langchain 1.0 开始,仅传入 schema(例如 response_format=ContactInfo)已经不再支持。

你必须显式使用:

ToolStrategy- 或

ProviderStrategy

记忆

智能体通过消息状态(message state)自动维护对话历史。

你也可以通过自定义状态(state schema)让智能体在对话中记住额外的信息。

存储在状态中的信息可以理解为智能体的短期记忆:

-

自定义状态必须作为

TypedDict继承自AgentState。 -

定义自定义状态有两种方式:

- 通过 middleware(推荐方式)

- 通过 create_agent 的 state_schema 参数

推荐使用 middleware,因为它可以让状态扩展在概念上与具体 middleware 和工具绑定,更好地隔离逻辑。

state_schema 仍然保留以兼容旧版本。

通过 middleware 定义状态(推荐方式):

当你的自定义状态需要被特定的 middleware hook 或与之绑定的工具访问时,应该使用此方式。

from langchain.agents import AgentState

from langchain.agents.middleware import AgentMiddleware

from typing import Any

class CustomState(AgentState):

user_preferences: dict

class CustomMiddleware(AgentMiddleware):

state_schema = CustomState

tools = [tool1, tool2]

def before_model(self, state: CustomState, runtime) -> dict[str, Any] | None:

...

agent = create_agent(

model,

tools=tools,

middleware=[CustomMiddleware()]

)

# 智能体现在可以追踪 messages 之外的额外状态

result = agent.invoke({

"messages": [{"role": "user", "content": "I prefer technical explanations"}],

"user_preferences": {"style": "technical", "verbosity": "detailed"},

})

通过 state_schema 定义状态:

如果你的自定义状态只用于工具中,可以使用简单的 state_schema 方式:

from langchain.agents import AgentState

class CustomState(AgentState):

user_preferences: dict

agent = create_agent(

model,

tools=[tool1, tool2],

state_schema=CustomState

)

# 智能体现在可以追踪 messages 之外的额外状态

result = agent.invoke({

"messages": [{"role": "user", "content": "I prefer technical explanations"}],

"user_preferences": {"style": "technical", "verbosity": "detailed"},

})

注意

从 langchain 1.0 开始:

- 自定义状态必须是

TypedDict类型 - Pydantic 模型和 dataclass 已不再支持

流式输出

之前我们看到,智能体可以通过 invoke 返回最终结果。但如果智能体需要执行多个步骤,这可能会花费较长时间。

为了显示中间进度,你可以在执行过程中实时流式返回消息。

for chunk in agent.stream({

"messages": [{"role": "user", "content": "Search for AI news and summarize the findings"}]

}, stream_mode="values"):

# 每个 chunk 都包含当时的完整状态

latest_message = chunk["messages"][-1]

if latest_message.content:

print(f"Agent: {latest_message.content}")

elif latest_message.tool_calls:

print(f"Calling tools: {[tc['name'] for tc in latest_message.tool_calls]}")

StreamMode = Literal[

"values", "updates", "checkpoints", "tasks", "debug", "messages", "custom"

]

"""

stream 方法应以何种方式输出数据。

- "values":在每一步执行后(包括中断时),输出状态中的所有值。

在使用函数式 API 时,values 仅在工作流结束时输出一次。

- "updates":仅输出每一步中由节点或任务返回的节点名称或任务名称以及它们的更新内容。

如果同一步中有多个更新(例如执行了多个节点),这些更新会单独输出。

- "custom":在节点或任务内部使用 `StreamWriter` 输出自定义数据。

- "messages":逐 token 输出 LLM 消息,并包含节点或任务中任何 LLM 调用的元数据。

- "checkpoints":当创建检查点时输出事件,格式与 `get_state()` 的返回结果一致。

- "tasks":当任务开始和结束时输出事件,包括任务的结果和错误信息。

- "debug":同时输出 "checkpoints" 和 "tasks" 两类事件,用于调试目的。

"""

模型

LLM(大型语言模型)是一类强大的 AI 工具,能够像人类一样理解并生成文本。

它们非常通用,无需针对每个任务进行专门训练,就能用于写作、翻译、总结、回答问题等多种场景。

除了文本生成,许多模型还支持:

- 工具调用(Tool calling) —— 调用外部工具(例如数据库查询或 API 调用),并将结果用于生成回答

- 结构化输出(Structured output) —— 模型输出会被约束为遵循特定格式

- 多模态(Multimodality) —— 处理并返回除文本外的数据,例如图像、音频、视频

- 推理(Reasoning) —— 模型能够进行多步骤推理以得出结论

模型是智能体的推理引擎。

它们驱动智能体的决策过程,包括:

- 何时调用工具

- 如何解释返回结果

- 何时给出最终答案

你选择的模型的质量和功能会直接影响智能体的可靠性与表现。

不同模型各有所长——有些擅长遵循复杂指令,有些擅长结构化思考,有些支持更大的上下文窗口来处理更多信息。

LangChain 提供统一的模型接口,支持多家提供商的模型,使你可以轻松尝试和切换模型,找到最适合你的任务。

模型可以通过两种方式使用:

-

与智能体(Agents)配合使用

在创建智能体时动态指定模型。 -

独立使用(Standalone)

模型可以直接调用,用于文本生成、分类、抽取等任务,而不需要 agent 框架。

同一套模型接口适用于这两种场景,这让你能够从简单开始,并在需要时扩展到更复杂的基于智能体的工作流。

在 LangChain 中初始化独立模型最简单的方式是使用 init_chat_model,它可以从你选择的聊天模型提供商加载模型,例如:

- OpenAI

- Anthropic

- Azure

- Google Gemini

- AWS Bedrock

示例:安装 OpenAI 支持

pip install -U "langchain[openai]"

使用 init_chat_model 初始化模型

import os

from langchain.chat_models import init_chat_model

os.environ["OPENAI_API_KEY"] = "sk-..."

model = init_chat_model("gpt-4.1")

调用模型

response = model.invoke("Why do parrots talk?")

关键方法(Key methods)

-

Invoke

模型接收消息作为输入,并在完成生成后返回完整的响应。

-

Stream

与 invoke 类似,但模型会实时逐步流式返回生成内容。

-

Batch

批量发送多条请求以提高处理效率。

聊天模型接受一系列参数,用于配置其行为。不同的模型和提供商可能支持不同的参数,但常见的标准参数如下:

常见参数

| 参数名称 | 类型 | 描述 |

|---|---|---|

| model | 字符串 | 要使用的具体模型名称或标识符(必填)。 |

| api_key | 字符串 | 用于验证模型提供商的 API 密钥。通常在注册时获得,可以通过设置环境变量来访问。 |

| temperature | 数字 | 控制模型输出的随机性。值越高,输出越富有创造性;值越低,输出越确定。 |

| timeout | 数字 | 等待模型响应的最长时间(单位:秒),超时后取消请求。 |

| max_tokens | 数字 | 限制模型响应的最大 token 数量,从而控制输出的长度。 |

| max_retries | 数字 | 请求失败时(如网络超时或速率限制)重试的最大次数。 |

使用 init_chat_model 时,可以将这些参数作为 kwargs 传入:

model = init_chat_model(

"claude-sonnet-4-5-20250929",

# 传递给模型的参数:

temperature=0.7,

timeout=30,

max_tokens=1000,

)

附加参数

每个聊天模型集成可能会有额外的参数,用于控制特定提供商的功能。例如,ChatOpenAI 模型有 use_responses_api 参数,用于指定是否使用 OpenAI Responses API 或 Completions API。

模型直接调用

聊天模型必须通过调用才能生成输出。有三种主要的调用方式,每种方式适用于不同的使用场景。

调用模型最直接的方法是使用 invoke(),它可以接收单条消息或消息列表。

response = model.invoke("Why do parrots have colorful feathers?")

print(response)

你可以将消息列表传递给模型,以表示对话历史。每条消息都有一个角色,模型通过角色来标识消息的发送者。更多关于角色、类型和内容的信息,请参阅消息指南。

conversation = [

{"role": "system", "content": "You are a helpful assistant that translates English to French."},

{"role": "user", "content": "Translate: I love programming."},

{"role": "assistant", "content": "J'adore la programmation."},

{"role": "user", "content": "Translate: I love building applications."}

]

response = model.invoke(conversation)

print(response) # AIMessage("J'adore créer des applications.")

你也可以使用消息对象来表示对话内容:

from langchain_core.messages import HumanMessage, AIMessage, SystemMessage

conversation = [

SystemMessage("You are a helpful assistant that translates English to French."),

HumanMessage("Translate: I love programming."),

AIMessage("J'adore la programmation."),

HumanMessage("Translate: I love building applications.")

]

response = model.invoke(conversation)

print(response) # AIMessage("J'adore créer des applications.")

大多数模型支持流式输出,即在生成过程中逐步返回内容。通过流式输出,可以显著改善用户体验,特别是在处理较长响应时。

调用 stream() 会返回一个迭代器,逐步输出生成的内容。你可以使用循环实时处理每个输出块:

基本文本流式输出

for chunk in model.stream("Why do parrots have colorful feathers?"):

print(chunk.text, end="|", flush=True)

流式输出工具调用、推理和其他内容

for chunk in model.stream("What color is the sky?"):

for block in chunk.content_blocks:

if block["type"] == "reasoning" and (reasoning := block.get("reasoning")):

print(f"推理: {reasoning}")

elif block["type"] == "tool_call_chunk":

print(f"工具调用块: {block}")

elif block["type"] == "text":

print(block["text"])

else:

...

这种方式允许你在流式输出中处理工具调用、推理步骤以及文本内容,并根据类型对其进行相应的处理。

与 invoke() 不同,stream() 在模型完成生成之前,会逐步返回多个 AIMessageChunk 对象,每个对象包含输出的一部分文本。每个流中的块会被逐步汇总成完整的消息:

full = None # None | AIMessageChunk

for chunk in model.stream("What color is the sky?"):

full = chunk if full is None else full + chunk

print(full.text)

# 输出逐步返回的结果:

# The

# The sky

# The sky is

# The sky is typically

# The sky is typically blue

# ...

print(full.content_blocks)

# [{"type": "text", "text": "The sky is typically blue..."}]

生成的消息可以像 invoke() 生成的消息一样处理。例如,可以将其聚合为消息历史,并作为对话上下文传回模型。

流式输出只在程序的所有步骤都支持处理数据流时才有效。例如,一个不支持流式处理的应用程序需要先将整个输出存储在内存中,然后才能进行处理。

高级流式输出(Advanced streaming topics)

LangChain 通过在某些情况下自动启用流式模式,简化了从聊天模型的流式输出,即使你没有明确调用流式方法。当你使用非流式的 invoke 方法时,仍然希望流式处理整个应用程序,包括聊天模型的中间结果,这时自动流式功能特别有用。

例如,在 LangGraph 智能体中,你可以在节点内调用 model.invoke(),但如果在流式模式下运行,LangChain 会自动切换到流式处理。

工作原理:当你调用 invoke() 进行聊天模型请求时,LangChain 会自动检测并切换到内部流式模式,如果它发现你尝试对整体应用程序进行流式处理。从使用 invoke 的代码角度来看,调用的结果是一样的;但是,在聊天模型流式处理时,LangChain 会自动处理 on_llm_new_token 事件,这些事件会通过 LangChain 的回调系统触发。

回调事件使得 LangGraph 的 stream() 和 astream_events() 可以实时展示聊天模型的输出。

流式事件(Streaming events)

LangChain 聊天模型还可以使用 astream_events() 流式处理语义事件。

这简化了基于事件类型和其他元数据的过滤,同时会在后台聚合完整的消息。以下是一个示例:

async for event in model.astream_events("Hello"):

if event["event"] == "on_chat_model_start":

print(f"输入: {event['data']['input']}")

elif event["event"] == "on_chat_model_stream":

print(f"Token: {event['data']['chunk'].text}")

elif event["event"] == "on_chat_model_end":

print(f"完整消息: {event['data']['output'].text}")

else:

pass

输出示例:

输入: Hello

Token: Hi

Token: there

Token: !

Token: How

Token: can

Token: I

...

完整消息: Hi there! How can I help today?

这种方式使得你可以精细化地控制流式输出的每个阶段,便于实时处理和展示聊天模型的输出。

Batch批量处理将一组独立的请求批量发送给模型,可以显著提高性能并减少成本,因为这些请求可以并行处理:

responses = model.batch([

"Why do parrots have colorful feathers?",

"How do airplanes fly?",

"What is quantum computing?"

])

for response in responses:

print(response)

此方法通过客户端并行化模型调用,区别于提供商支持的批量 API,如 OpenAI 或 Anthropic 提供的批量 API。

默认情况下,batch() 会返回整个批次的最终输出。如果希望在每个输入生成完成时接收其对应的输出,可以使用 batch_as_completed() 流式返回结果:

for response in model.batch_as_completed([

"Why do parrots have colorful feathers?",

"How do airplanes fly?",

"What is quantum computing?"

]):

print(response)

使用 batch_as_completed() 时,结果可能会乱序返回。每个结果包含输入的索引,可以根据需要将它们重新排序。

在处理大量输入时,使用 batch() 或 batch_as_completed() 时,可能需要控制最大并行调用数。你可以通过在 RunnableConfig 字典中设置 max_concurrency 来实现:

model.batch(

list_of_inputs,

config={

'max_concurrency': 5, # 限制最多 5 个并行调用

}

)

工具调用

模型可以请求调用工具来执行任务,例如从数据库中获取数据、在网络上搜索或运行代码。工具由以下部分组成:

- 架构,包括工具的名称、描述和/或参数定义(通常为 JSON 架构)

- 执行函数或协程

你可能会听到“函数调用”这一术语,我们将其与“工具调用”互换使用。

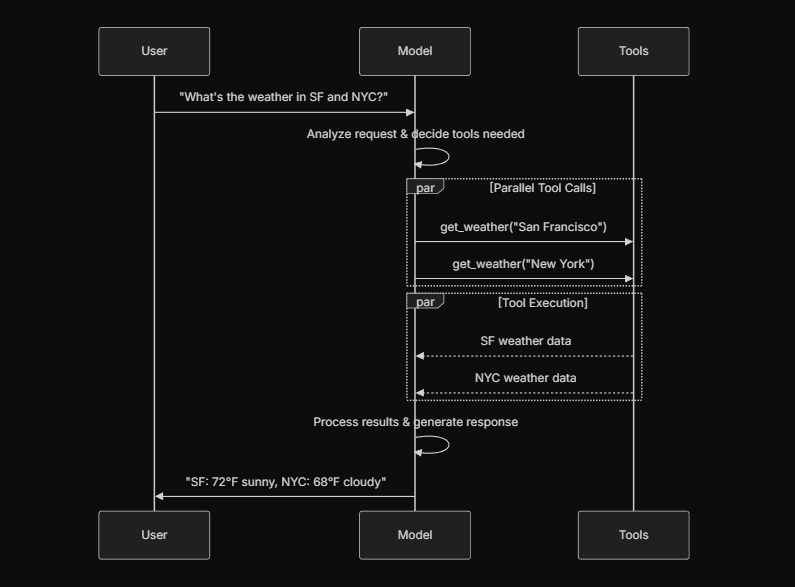

以下是用户与模型之间工具调用的基本流程:

- 用户询问问题:“What’s the weather in SF and NYC?”

- 模型分析请求并决定需要调用的工具

- 工具:调用

get_weather("San Francisco")和get_weather("New York") - 工具执行:获取旧金山和纽约的天气数据

- 模型:处理结果并生成响应

- 用户:得到最终的回答:“SF: 72°F sunny, NYC: 68°F cloudy”

为了使你定义的工具可以被模型使用,必须使用 bind_tools 将它们绑定。在随后的调用中,模型可以根据需要选择调用任何绑定的工具。

一些模型提供商提供了内置工具,可以通过模型或调用参数启用(例如 ChatOpenAI,ChatAnthropic)。请查阅相关提供商的文档了解详细信息。

绑定用户自定义工具

from langchain.tools import tool

@tool

def get_weather(location: str) -> str:

"""获取指定位置的天气信息。"""

return f"It's sunny in {location}."

# 绑定自定义工具

model_with_tools = model.bind_tools([get_weather])

response = model_with_tools.invoke("What's the weather like in Boston?")

for tool_call in response.tool_calls:

# 查看模型调用的工具

print(f"工具: {tool_call['name']}")

print(f"参数: {tool_call['args']}")

当绑定用户定义的工具时,模型的响应中会包含请求执行工具的内容。如果模型与智能体分开使用,则需要你自己执行请求的工具,并将结果返回给模型,以便在后续推理中使用。而在使用智能体时,智能体的循环会为你处理工具执行的过程。

下面展示了一些常见的工具调用方式。

工具执行循环(Tool execution loop)

当模型返回工具调用时,你需要执行这些工具并将结果返回给模型。这就形成了一个对话循环,模型可以使用工具的结果生成最终响应。LangChain 提供了智能体抽象,可以帮你处理这一协调过程。

# 将(可能多个)工具绑定到模型

model_with_tools = model.bind_tools([get_weather])

# 步骤 1:模型生成工具调用

messages = [{"role": "user", "content": "What's the weather in Boston?"}]

ai_msg = model_with_tools.invoke(messages)

messages.append(ai_msg)

# 步骤 2:执行工具并收集结果

for tool_call in ai_msg.tool_calls:

# 使用生成的参数执行工具

tool_result = get_weather.invoke(tool_call)

messages.append(tool_result)

# 步骤 3:将结果返回给模型生成最终响应

final_response = model_with_tools.invoke(messages)

print(final_response.text)

# 输出: "The current weather in Boston is 72°F and sunny."

每个工具返回的 ToolMessage 都包含一个 tool_call_id,与原始工具调用匹配,帮助模型将结果与请求关联。

强制调用工具

默认情况下,模型可以根据用户输入自由选择使用哪个绑定工具。不过,你也可以强制模型使用某个特定工具或列表中的任意工具。

# 强制使用任意工具

model_with_tools = model.bind_tools([tool_1], tool_choice="any")

# 强制使用特定工具

model_with_tools = model.bind_tools([tool_1], tool_choice="specific")

并行工具调用

许多模型在适当情况下支持并行调用多个工具,使模型能够同时从不同来源获取信息。

model_with_tools = model.bind_tools([get_weather])

response = model_with_tools.invoke("What's the weather in Boston and Tokyo?")

# 模型可能生成多个工具调用

print(response.tool_calls)

# [

# {'name': 'get_weather', 'args': {'location': 'Boston'}, 'id': 'call_1'},

# {'name': 'get_weather', 'args': {'location': 'Tokyo'}, 'id': 'call_2'},

# ]

# 执行所有工具(可以使用 async 并行处理)

results = []

for tool_call in response.tool_calls:

if tool_call['name'] == 'get_weather':

result = get_weather.invoke(tool_call)

...

results.append(result)

模型会根据请求操作的独立性智能判断是否适合并行执行。

大多数支持工具调用的模型默认开启并行调用。部分模型(如 OpenAI 和 Anthropic)允许关闭此功能:

model.bind_tools([get_weather], parallel_tool_calls=False)

流式工具调用

在流式响应时,工具调用会通过 ToolCallChunk 逐步生成。这允许你在生成过程中实时查看工具调用,而无需等待完整响应。

for chunk in model_with_tools.stream("What's the weather in Boston and Tokyo?"):

# 工具调用块逐步到达

for tool_chunk in chunk.tool_call_chunks:

if name := tool_chunk.get("name"):

print(f"工具: {name}")

if id_ := tool_chunk.get("id"):

print(f"ID: {id_}")

if args := tool_chunk.get("args"):

print(f"参数: {args}")

输出示例:

# Output:

# Tool: get_weather

# ID: call_SvMlU1TVIZugrFLckFE2ceRE

# Args: {"lo

# Args: catio

# Args: n": "B

# Args: osto

# Args: n"}

# Tool: get_weather

# ID: call_QMZdy6qInx13oWKE7KhuhOLR

# Args: {"lo

# Args: catio

# Args: n": "T

# Args: okyo

# Args: "}

你也可以将多个块累积起来,构建完整的工具调用:

gathered = None

for chunk in model_with_tools.stream("What's the weather in Boston?"):

gathered = chunk if gathered is None else gathered + chunk

print(gathered.tool_calls)

结构化输出

可以要求模型以符合给定架构的格式提供响应。这对于确保输出可以轻松解析并在后续处理中使用非常有用。LangChain 支持多种架构类型和方法来强制执行结构化输出。

支持的架构类型:

- Pydantic

- TypedDict

- JSON Schema

Pydantic 模型提供了最丰富的特性集,包括字段验证、描述和嵌套结构。

from pydantic import BaseModel, Field

class Movie(BaseModel):

"""包含电影详情的模型"""

title: str = Field(..., description="电影的标题")

year: int = Field(..., description="电影的上映年份")

director: str = Field(..., description="电影的导演")

rating: float = Field(..., description="电影的评分(满分 10)")

model_with_structure = model.with_structured_output(Movie)

response = model_with_structure.invoke("Provide details about the movie Inception")

print(response) # Movie(title="Inception", year=2010, director="Christopher Nolan", rating=8.8)

TypedDict 提供了一个更简洁的替代方案,使用 Python 内置的类型系统即可实现,适合不需要运行时验证的场景。

from typing_extensions import TypedDict, Annotated

class MovieDict(TypedDict):

"""包含电影详情的字典"""

title: Annotated[str, ..., "电影的标题"]

year: Annotated[int, ..., "电影的上映年份"]

director: Annotated[str, ..., "电影的导演"]

rating: Annotated[float, ..., "电影的评分(满分 10)"]

model_with_structure = model.with_structured_output(MovieDict)

response = model_with_structure.invoke("Provide details about the movie Inception")

print(response)

# 输出: {'title': 'Inception', 'year': 2010, 'director': 'Christopher Nolan', 'rating': 8.8}

TypedDict不提供运行时验证,如果需要验证则应使用 Pydantic。- 可以通过

with_structured_output方法将 TypedDict 与模型绑定,使模型输出自动遵循定义的结构。 - 可与

include_raw=True一起使用,同时获取原始 AI 消息和解析后的数据结构。

结构化输出的关键考虑事项:

-

方法参数:

一些提供商支持不同的方法(例如json_schema,function_calling,json_mode)来实现结构化输出:json_schema:通常指提供商提供的专用结构化输出功能。function_calling:通过强制工具调用并遵循给定的架构来生成结构化输出。json_mode:是一些提供商提供的json_schema先行模式,它生成有效的 JSON,但架构必须在提示中描述。

-

包含原始内容(Include raw):

使用include_raw=True可以同时获得解析后的输出和原始 AI 消息。 -

验证:

- Pydantic 模型 提供自动验证。

- TypedDict 和 JSON Schema 需要手动验证。

示例:消息输出与解析结构

可以同时返回原始的 AIMessage 对象和解析后的表示,以便访问响应的元数据,如令牌计数。为此,在调用 with_structured_output 时,设置 include_raw=True:

from pydantic import BaseModel, Field

class Movie(BaseModel):

"""包含电影详情的模型"""

title: str = Field(..., description="电影的标题")

year: int = Field(..., description="电影的上映年份")

director: str = Field(..., description="电影的导演")

rating: float = Field(..., description="电影的评分(满分 10)")

model_with_structure = model.with_structured_output(Movie, include_raw=True)

response = model_with_structure.invoke("Provide details about the movie Inception")

print(response)

# 输出:

# {

# "raw": AIMessage(...),

# "parsed": Movie(title=..., year=..., ...),

# "parsing_error": None,

# }

示例:嵌套结构

from pydantic import BaseModel, Field

class Actor(BaseModel):

name: str

role: str

class MovieDetails(BaseModel):

title: str

year: int

cast: list[Actor]

genres: list[str]

budget: float | None = Field(None, description="预算(单位:百万美元)")

model_with_structure = model.with_structured_output(MovieDetails)

高级功能

多模态

某些模型能够处理和返回非文本数据,如图像、音频和视频。可以通过提供 内容块(content blocks) 的方式,将非文本数据传递给模型。

所有具有底层多模态能力的 LangChain 聊天模型都支持:

- 跨提供商的标准格式数据(详见消息指南)

- OpenAI 聊天完成格式

- 任何特定提供商原生格式(例如 Anthropic 模型接受 Anthropic 原生格式)

部分模型还可以在响应中返回多模态数据。如果模型被调用以生成多模态输出,返回的 AIMessage 将包含多模态类型的内容块。

response = model.invoke("Create a picture of a cat")

print(response.content_blocks)

# [

# {"type": "text", "text": "Here's a picture of a cat"},

# {"type": "image", "base64": "...", "mime_type": "image/jpeg"},

# ]

推理

新一代模型能够执行多步推理来得出结论,即将复杂问题拆解为更小、更易处理的步骤。

如果底层模型支持,可以显示该推理过程,以更好地理解模型如何得出最终答案。

示例:流式推理输出

for chunk in model.stream("Why do parrots have colorful feathers?"):

reasoning_steps = [r for r in chunk.content_blocks if r["type"] == "reasoning"]

print(reasoning_steps if reasoning_steps else chunk.text)

- 根据模型,有时可以指定推理的“努力程度”。

- 也可以要求模型完全关闭推理。

- 这种设置可能表现为分类“等级”(例如

'low'或'high')或整数令牌预算。

本地模型

LangChain 支持在本地硬件上运行模型,适用于以下场景:

- 数据隐私要求高

- 需要调用自定义模型

- 避免使用云模型产生的费用

Ollama 是在本地运行模型的最简单方式之一。

Prompt缓存

许多提供商提供Prompt缓存功能,以减少重复处理相同令牌时的延迟和成本。缓存可以是隐式或显式的:

-

隐式缓存:

当请求命中缓存时,提供商会自动传递成本节省。例如:OpenAI 和 Gemini(Gemini 2.5 及以上版本)。 -

显式缓存:

允许手动指定缓存点,以获得更大控制或保证成本节省。例如:ChatOpenAI(通过prompt_cache_key)、Anthropic 的AnthropicPromptCachingMiddleware和cache_control选项、AWS Bedrock、Gemini。

提示缓存通常仅在输入令牌超过最低阈值时启用。具体详情请参考提供商页面。

缓存使用情况会在模型响应的 使用元数据(usage metadata) 中体现。

服务端工具使用

部分提供商支持 服务端工具调用循环:模型可以在单轮对话中与网络搜索、代码解释器等工具交互,并分析结果。

如果模型在服务端调用工具,响应消息的内容将包含表示工具调用及其结果的内容块。访问响应content_blocks 会返回服务端工具调用和结果,且格式与提供商无关。

示例:服务端工具调用

from langchain.chat_models import init_chat_model

model = init_chat_model("gpt-4.1-mini")

tool = {"type": "web_search"}

model_with_tools = model.bind_tools([tool])

response = model_with_tools.invoke("What was a positive news story from today?")

response.content_blocks

返回结果示例

[

{

"type": "server_tool_call",

"name": "web_search",

"args": {

"query": "positive news stories today",

"type": "search"

},

"id": "ws_abc123"

},

{

"type": "server_tool_result",

"tool_call_id": "ws_abc123",

"status": "success"

},

{

"type": "text",

"text": "Here are some positive news stories from today...",

"annotations": [

{

"end_index": 410,

"start_index": 337,

"title": "article title",

"type": "citation",

"url": "..."

}

]

}

]

- 这表示一次完整的对话轮次;无需像客户端工具调用那样传入 ToolMessage 对象。

- 具体可用工具及使用详情,请参考对应提供商的集成页面。

速率限制

许多聊天模型提供商会限制在特定时间段内的调用次数。

- 如果达到速率限制,通常会收到提供商的 rate limit 错误响应,需要等待后才能继续请求。

- 为管理速率限制,聊天模型集成支持在初始化时提供

rate_limiter参数,用于控制请求速率。

示例:初始化并使用速率限制器

LangChain 提供可选的内置 InMemoryRateLimiter,线程安全,可在同一进程的多个线程间共享。

from langchain_core.rate_limiters import InMemoryRateLimiter

rate_limiter = InMemoryRateLimiter(

requests_per_second=0.1, # 每 10 秒 1 次请求

check_every_n_seconds=0.1, # 每 100ms 检查一次是否允许发起请求

max_bucket_size=10, # 控制最大突发请求数

)

model = init_chat_model(

model="gpt-5",

model_provider="openai",

rate_limiter=rate_limiter

)

- 该速率限制器仅限制单位时间内请求次数。

- 若还需要限制请求大小,则需使用其他方式处理。

基础 URL 或代理配置

在许多聊天模型集成中,可以配置 API 请求的 基础 URL,这可以用于:

- 使用兼容 OpenAI API 的模型提供商

- 或者通过代理服务器访问模型

基础 URL 配置

许多模型提供商提供 OpenAI 兼容的 API(例如 Together AI、vLLM)。使用 init_chat_model 时可以通过 base_url 参数指定:

model = init_chat_model(

model="MODEL_NAME",

model_provider="openai",

base_url="BASE_URL",

api_key="YOUR_API_KEY",

)

- 如果直接使用聊天模型类实例化,参数名称可能因提供商而异,具体请参考对应文档。

对于需要 HTTP 代理的部署,一些模型集成支持代理配置:

from langchain_openai import ChatOpenAI

model = ChatOpenAI(

model="gpt-4o",

openai_proxy="http://proxy.example.com:8080"

)

- 不同集成对代理的支持情况不同,请参考具体模型提供商的文档。

对数概率

某些模型可以返回 每个 token 的对数概率,用于表示生成该 token 的可能性。可在初始化模型时通过logprobs 参数开启:

model = init_chat_model(

model="gpt-4o",

model_provider="openai"

).bind(logprobs=True)

response = model.invoke("Why do parrots talk?")

print(response.response_metadata["logprobs"])

Token 使用情况

- 部分模型提供商会在调用响应中返回 token 使用信息。

- 当可用时,这些信息会包含在 AIMessage 对象中。

- 某些提供商(如 OpenAI、Azure OpenAI)在流式调用场景下,需要用户 显式选择 接收 token 使用数据。

可以通过回调或上下文管理器跟踪应用中多个模型的 token 总量:

回调处理器示例

from langchain.chat_models import init_chat_model

from langchain_core.callbacks import UsageMetadataCallbackHandler

model_1 = init_chat_model(model="gpt-4o-mini")

model_2 = init_chat_model(model="claude-haiku-4-5-20251001")

callback = UsageMetadataCallbackHandler()

result_1 = model_1.invoke("Hello", config={"callbacks": [callback]})

result_2 = model_2.invoke("Hello", config={"callbacks": [callback]})

callback.usage_metadata

上下文管理器示例

from langchain.chat_models import init_chat_model

from langchain_core.callbacks import get_usage_metadata_callback

model_1 = init_chat_model(model="gpt-4o-mini")

model_2 = init_chat_model(model="claude-haiku-4-5-20251001")

with get_usage_metadata_callback() as cb:

model_1.invoke("Hello")

model_2.invoke("Hello")

print(cb.usage_metadata)

返回示例

{

"gpt-4o-mini-2024-07-18": {

"input_tokens": 8,

"output_tokens": 10,

"total_tokens": 18,

"input_token_details": {"audio": 0, "cache_read": 0},

"output_token_details": {"audio": 0, "reasoning": 0}

},

"claude-haiku-4-5-20251001": {

"input_tokens": 8,

"output_tokens": 21,

"total_tokens": 29,

"input_token_details": {"cache_read": 0, "cache_creation": 0}

}

}

input_tokens:输入 token 数量output_tokens:输出 token 数量total_tokens:总 token 数量input_token_details/output_token_details:按类型统计 token 使用情况

调用配置

在调用模型时,可以通过 config 参数传递额外的配置,使用 RunnableConfig 字典。这提供了对执行行为、回调和元数据跟踪的运行时控制。

调用示例

response = model.invoke(

"Tell me a joke",

config={

"run_name": "joke_generation", # 该运行的自定义名称

"tags": ["humor", "demo"], # 用于分类的标签

"metadata": {"user_id": "123"}, # 自定义元数据

"callbacks": [my_callback_handler], # 回调处理器

}

)

这些配置值在以下场景中尤其有用:

- 使用 LangSmith 进行调试和追踪

- 实现自定义日志记录或监控

- 控制生产环境中的资源使用

- 在复杂管道中跟踪调用

关键配置属性(Key configuration attributes)

-

run_name

- 类型:

string - 作用:标识此特定调用的名称,用于日志和追踪,不会被子调用继承。

- 类型:

-

tags

- 类型:

string[] - 作用:标签,供所有子调用继承,便于在调试工具中进行过滤和组织。

- 类型:

-

metadata

- 类型:

object - 作用:自定义键值对,用于跟踪额外的上下文,所有子调用都会继承。

- 类型:

-

max_concurrency

- 类型:

number - 作用:控制使用

batch()或batch_as_completed()时最大并发调用数。

- 类型:

-

callbacks

- 类型:

array - 作用:用于在执行过程中监控和响应事件的处理器。

- 类型:

-

recursion_limit

- 类型:

number - 作用:设置链式调用的最大递归深度,防止在复杂管道中出现无限循环。

- 类型:

可配置模型

您还可以通过指定 configurable_fields 来创建一个运行时可配置的模型。如果没有指定模型值,则默认 model 和 model_provider 会是可配置的。

from langchain.chat_models import init_chat_model

configurable_model = init_chat_model(temperature=0)

configurable_model.invoke(

"what's your name",

config={"configurable": {"model": "gpt-5-nano"}}, # 使用 GPT-5-Nano 模型运行

)

configurable_model.invoke(

"what's your name",

config={"configurable": {"model": "claude-sonnet-4-5-20250929"}}, # 使用 Claude 模型运行

)

具有默认值的可配置模型

我们可以创建一个具有默认模型值的可配置模型,指定哪些参数是可配置的,并为可配置的参数添加前缀:

first_model = init_chat_model(

model="gpt-4.1-mini",

temperature=0,

configurable_fields=("model", "model_provider", "temperature", "max_tokens"),

config_prefix="first", # 当有多个模型的链式调用时非常有用

)

first_model.invoke("what's your name")

first_model.invoke(

"what's your name",

config={

"configurable": {

"first_model": "claude-sonnet-4-5-20250929",

"first_temperature": 0.5,

"first_max_tokens": 100,

}

},

)

声明式使用可配置模型

我们可以像对常规实例化的聊天模型对象一样,在可配置模型上调用声明式操作(如 bind_tools、with_structured_output、with_configurable 等)并将可配置模型链接起来。

from pydantic import BaseModel, Field

class GetWeather(BaseModel):

"""获取指定位置的当前天气"""

location: str = Field(..., description="城市和州,例如:San Francisco, CA")

class GetPopulation(BaseModel):

"""获取指定位置的当前人口"""

location: str = Field(..., description="城市和州,例如:San Francisco, CA")

model = init_chat_model(temperature=0)

model_with_tools = model.bind_tools([GetWeather, GetPopulation])

model_with_tools.invoke(

"what's bigger in 2024 LA or NYC", config={"configurable": {"model": "gpt-4.1-mini"}}

).tool_calls

[

{

'name': 'GetPopulation',

'args': {'location': 'Los Angeles, CA'},

'id': 'call_Ga9m8FAArIyEjItHmztPYA22',

'type': 'tool_call'

},

{

'name': 'GetPopulation',

'args': {'location': 'New York, NY'},

'id': 'call_jh2dEvBaAHRaw5JUDthOs7rt',

'type': 'tool_call'

}

]

model_with_tools.invoke(

"what's bigger in 2024 LA or NYC",

config={"configurable": {"model": "claude-sonnet-4-5-20250929"}},

).tool_calls

[

{

'name': 'GetPopulation',

'args': {'location': 'Los Angeles, CA'},

'id': 'toolu_01JMufPf4F4t2zLj7miFeqXp',

'type': 'tool_call'

},

{

'name': 'GetPopulation',

'args': {'location': 'New York City, NY'},

'id': 'toolu_01RQBHcE8kEEbYTuuS8WqY1u',

'type': 'tool_call'

}

]

消息

消息是 LangChain 中模型的基本上下文单元。它们表示模型的输入和输出,包含在与大语言模型(LLM)交互时所需的内容和元数据,用于表示对话的状态。

消息是包含以下内容的对象:

- 角色(Role) - 标识消息的类型(例如:系统、用户)

- 内容(Content) - 表示消息的实际内容(如文本、图片、音频、文档等)

- 元数据(Metadata) - 可选字段,例如响应信息、消息 ID 和令牌使用情况

LangChain 提供了一种标准的消息类型,可在所有模型提供商中使用,确保无论调用哪个模型,都能保持一致的行为。

使用消息的最简单方式是创建消息对象,并在调用模型时将其传递给模型。

from langchain.chat_models import init_chat_model

from langchain.messages import HumanMessage, AIMessage, SystemMessage

model = init_chat_model("gpt-5-nano")

system_msg = SystemMessage("You are a helpful assistant.")

human_msg = HumanMessage("Hello, how are you?")

# 与聊天模型一起使用

messages = [system_msg, human_msg]

response = model.invoke(messages) # 返回 AIMessage

**文本提示(Text prompts)**文本提示是字符串,非常适合简单的生成任务,尤其是当您不需要保留对话历史时。

response = model.invoke("Write a haiku about spring")

使用文本提示时的场景:

- 您有一个独立的请求

- 您不需要对话历史

- 您希望保持代码简洁

消息提示(Message prompts) 或者,可以通过提供消息对象的列表,将多个消息传递给模型。

from langchain.messages import SystemMessage, HumanMessage, AIMessage

messages = [

SystemMessage("You are a poetry expert"),

HumanMessage("Write a haiku about spring"),

AIMessage("Cherry blossoms bloom...")

]

response = model.invoke(messages)

使用消息提示时的场景:

- 管理多轮对话

- 处理多模态内容(图片、音频、文件等)

- 包括系统指令

字典格式(Dictionary format) 也可以直接使用 OpenAI 聊天完成格式指定消息。

messages = [

{"role": "system", "content": "You are a poetry expert"},

{"role": "user", "content": "Write a haiku about spring"},

{"role": "assistant", "content": "Cherry blossoms bloom..."}

]

response = model.invoke(messages)

消息类型(Message types)

- 系统消息(System message) - 告诉模型如何行为并为交互提供上下文

- 用户消息(Human message) - 表示用户输入和与模型的交互

- AI 消息(AI message) - 模型生成的响应,包括文本内容、工具调用和元数据

- 工具消息(Tool message) - 表示工具调用的输出

SystemMessage 代表一组初始指令,旨在引导模型的行为。您可以使用系统消息来设置语气、定义模型的角色,并为响应设定指导原则。

基本指令:

system_msg = SystemMessage("You are a helpful coding assistant.")

messages = [

system_msg,

HumanMessage("How do I create a REST API?")

]

response = model.invoke(messages)

详细角色描述

from langchain.messages import SystemMessage, HumanMessage

system_msg = SystemMessage("""

You are a senior Python developer with expertise in web frameworks.

Always provide code examples and explain your reasoning.

Be concise but thorough in your explanations.

""")

messages = [

system_msg,

HumanMessage("How do I create a REST API?")

]

response = model.invoke(messages)

HumanMessage 代表用户的输入和交互。它们可以包含文本、图片、音频、文件以及任何其他形式的多模态内容。

文本内容:

response = model.invoke([

HumanMessage("What is machine learning?")

])

可以为消息添加元数据:

human_msg = HumanMessage(

content="Hello!",

name="alice", # 可选:标识不同的用户

id="msg_123", # 可选:唯一标识符,用于追踪

)

name 字段的行为取决于提供商 - 有些用它来标识用户,而有些则忽略它。具体行为请参见模型提供商的参考文档。

AIMessage 代表模型调用的输出。它们可以包含多模态数据、工具调用和提供商特定的元数据,您可以稍后访问这些数据。

response = model.invoke("Explain AI")

print(type(response)) # <class 'langchain_core.messages.ai.AIMessage'>

AIMessage 对象由模型返回,当调用模型时,它包含响应中的所有相关元数据。

不同的提供商对消息类型的权重和上下文化处理有所不同,这意味着有时手动创建一个新的 AIMessage 对象并将其插入到消息历史中,就好像它是从模型生成的一样,这会很有帮助。

from langchain.messages import AIMessage, SystemMessage, HumanMessage

# 手动创建一个 AI 消息(例如,作为对话历史的一部分)

ai_msg = AIMessage("I'd be happy to help you with that question!")

# 添加到对话历史

messages = [

SystemMessage("You are a helpful assistant"),

HumanMessage("Can you help me?"),

ai_msg, # 插入到历史记录中,假设它来自模型

HumanMessage("Great! What's 2+2?")

]

response = model.invoke(messages)

属性(Attributes)

- text:字符串类型,表示消息的文本内容。

- content:字符串或字典数组,表示消息的原始内容。

- content_blocks:

ContentBlock[],消息的标准化内容块。 - tool_calls:字典数组或 None,表示模型做出的工具调用。如果没有工具调用,则为空。

- id:字符串类型,消息的唯一标识符(由 LangChain 自动生成或在提供商响应中返回)。

- usage_metadata:字典或 None,消息的使用元数据,可能包含令牌计数(如果可用)。

- response_metadata:

ResponseMetadata或 None,消息的响应元数据。

当模型进行工具调用时,它们会包含在 AIMessage 中:

from langchain.chat_models import init_chat_model

model = init_chat_model("gpt-5-nano")

def get_weather(location: str) -> str:

"""获取某个地点的天气。"""

...

model_with_tools = model.bind_tools([get_weather])

response = model_with_tools.invoke("What's the weather in Paris?")

for tool_call in response.tool_calls:

print(f"Tool: {tool_call['name']}")

print(f"Args: {tool_call['args']}")

print(f"ID: {tool_call['id']}")

其他结构化数据,如推理过程或引用,也可以出现在消息内容中。

AIMessage 可以在其 usage_metadata 字段中保存令牌计数和其他使用元数据:

from langchain.chat_models import init_chat_model

model = init_chat_model("gpt-5-nano")

response = model.invoke("Hello!")

response.usage_metadata

返回结果:

{'input_tokens': 8,

'output_tokens': 304,

'total_tokens': 312,

'input_token_details': {'audio': 0, 'cache_read': 0},

'output_token_details': {'audio': 0, 'reasoning': 256}}

在流式传输过程中,您将接收到 AIMessageChunk 对象,这些对象可以组合成完整的消息对象:

chunks = []

full_message = None

for chunk in model.stream("Hi"):

chunks.append(chunk)

print(chunk.text)

full_message = chunk if full_message is None else full_message + chunk

对于支持工具调用的模型,AI 消息可以包含工具调用。工具消息用于将单个工具执行的结果传递回模型。

工具可以直接生成 ToolMessage 对象。下面是一个简单的示例。更多内容请参见工具指南。

# 在模型进行工具调用后

ai_message = AIMessage(

content=[],

tool_calls=[{

"name": "get_weather",

"args": {"location": "San Francisco"},

"id": "call_123"

}]

)

# 执行工具并创建结果消息

weather_result = "Sunny, 72°F"

tool_message = ToolMessage(

content=weather_result,

tool_call_id="call_123" # 必须与工具调用的 ID 匹配

)

# 继续对话

messages = [

HumanMessage("What's the weather in San Francisco?"),

ai_message, # 模型的工具调用

tool_message, # 工具执行结果

]

response = model.invoke(messages) # 模型处理结果

属性(Attributes)

-

content

类型:字符串(必需)

工具调用的字符串化输出。 -

tool_call_id

类型:字符串(必需)

该消息响应的工具调用 ID。(必须与AIMessage中的工具调用 ID 匹配) -

name

类型:字符串(必需)

被调用的工具名称。 -

artifact

类型:字典(可选)

额外的数据,虽然不会发送到模型,但可以通过编程访问。

artifact字段用于存储附加数据,这些数据不会被发送到模型,但可以通过编程访问。这对于存储原始结果、调试信息或下游处理的数据很有用,而不会干扰模型的上下文。

示例:使用 artifact 存储检索元数据

例如,检索工具可以从文档中检索一段内容,以供模型参考。消息内容中包含模型将引用的文本,而 artifact 可以包含文档标识符或其他元数据,供应用程序使用(例如,用于渲染页面)。下面是一个示例:

from langchain.messages import ToolMessage

# 发送给模型的内容

message_content = "It was the best of times, it was the worst of times."

# 可供下游使用的 artifact

artifact = {"document_id": "doc_123", "page": 0}

tool_message = ToolMessage(

content=message_content,

tool_call_id="call_123",

name="search_books",

artifact=artifact,

)

消息内容

你可以把消息的内容看作是发送给模型的数据负载。消息有一个 content 属性,它是松散类型的,支持字符串和无类型对象的列表(例如字典)。这使得 LangChain 聊天模型能够直接支持提供商本地结构,例如多模态内容和其他数据。

另外,LangChain 为文本、推理、引用、多模态数据、服务器端工具调用和其他消息内容提供了专门的内容类型。

LangChain 聊天模型接受 content 属性中的消息内容,可以包含:

- 一个字符串

- 一个提供商本地格式的内容块列表

- 一个 LangChain 标准内容块列表

下面是使用多模态输入的示例:

from langchain.messages import HumanMessage

# 字符串内容

human_message = HumanMessage("Hello, how are you?")

# 提供商本地格式(例如 OpenAI)

human_message = HumanMessage(content=[

{"type": "text", "text": "Hello, how are you?"},

{"type": "image_url", "image_url": {"url": "https://example.com/image.jpg"}}

])

# 标准内容块列表

human_message = HumanMessage(content_blocks=[

{"type": "text", "text": "Hello, how are you?"},

{"type": "image", "url": "https://example.com/image.jpg"},

])

在初始化消息时指定 content_blocks 仍然会填充消息内容,但提供了一个类型安全的接口来实现这一点。

标准内容块

LangChain 提供了一个标准的消息内容表示,适用于所有提供商。

消息对象实现了一个 content_blocks 属性,它会懒加载地将 content 属性解析成标准的、类型安全的表示。例如,来自 ChatAnthropic 或 ChatOpenAI 生成的消息将包含各自提供商格式的思考或推理块,但可以懒加载成一致的 ReasoningContentBlock 表示:

from langchain.messages import AIMessage

message = AIMessage(

content=[

{

"type": "reasoning",

"id": "rs_abc123",

"summary": [

{"type": "summary_text", "text": "summary 1"},

{"type": "summary_text", "text": "summary 2"},

],

},

{"type": "text", "text": "...", "id": "msg_abc123"},

],

response_metadata={"model_provider": "openai"}

)

message.content_blocks

输出:

[

{'type': 'reasoning', 'id': 'rs_abc123', 'reasoning': 'summary 1'},

{'type': 'reasoning', 'id': 'rs_abc123', 'reasoning': 'summary 2'},

{'type': 'text', 'text': '...', 'id': 'msg_abc123'}

]

如果 LangChain 之外的应用程序需要访问标准的内容块表示,你可以选择将内容块存储在消息内容中。

为此,你可以将 LC_OUTPUT_VERSION 环境变量设置为 v1,或者初始化任何聊天模型时使用 output_version="v1":

from langchain.chat_models import init_chat_model

model = init_chat_model("gpt-5-nano", output_version="v1")

多模态

多模态性指的是处理不同形式的数据的能力,如文本、音频、图像和视频。LangChain 包括了这些数据的标准类型,可以跨提供商使用。

聊天模型可以接受多模态数据作为输入,并生成多模态数据作为输出。下面我们展示了一些包含多模态数据的输入消息的简短示例。

额外的键值可以包含在内容块的顶层,或者嵌套在 extras 中:{"key": value}。例如,OpenAI 和 AWS Bedrock Converse 要求 PDF 文件提供文件名。请查看所选模型的提供商页面以获取具体信息。

# 从 URL

message = {

"role": "user",

"content": [

{"type": "text", "text": "Describe the content of this image."},

{"type": "image", "url": "https://example.com/path/to/image.jpg"},

]

}

# 从 base64 数据

message = {

"role": "user",

"content": [

{"type": "text", "text": "Describe the content of this image."},

{

"type": "image",

"base64": "AAAAIGZ0eXBtcDQyAAAAAGlzb21tcDQyAAACAGlzb2...",

"mime_type": "image/jpeg",

},

]

}

# 从提供商管理的文件 ID

message = {

"role": "user",

"content": [

{"type": "text", "text": "Describe the content of this image."},

{"type": "image", "file_id": "file-abc123"},

]

}

并非所有模型都支持所有文件类型。请查看模型提供商的参考文档,了解支持的格式和大小限制。

内容块参考

内容块(Content blocks)可以在创建消息或访问 content_blocks 属性时表示为类型化字典的列表。列表中的每一项必须符合以下块类型之一:

TextContentBlock

用途:标准文本输出

| 属性 | 类型 | 说明 |

|---|---|---|

| type | string | 必填,始终为 "text" |

| text | string | 必填,文本内容 |

| annotations | object[] | 文本注释列表 |

| extras | object | 额外的提供商特定数据 |

示例:

{

"type": "text",

"text": "Hello world",

"annotations": []

}

ReasoningContentBlock

用途:模型推理步骤

| 属性 | 类型 | 说明 |

|---|---|---|

| type | string | 必填,始终为 "reasoning" |

| reasoning | string | 推理内容 |

| extras | object | 提供商特定的额外数据 |

示例:

{

"type": "reasoning",

"reasoning": "The user is asking about...",

"extras": {"signature": "abc123"}

}

ImageContentBlock

用途:图像数据

| 属性 | 类型 | 说明 |

|---|---|---|

| type | string | 必填,始终为 "image" |

| url | string | 图像 URL |

| base64 | string | Base64 编码图像数据 |

| id | string | 外部存储图像的引用 ID |

| mime_type | string | 图像 MIME 类型(如 image/jpeg) |

AudioContentBlock

用途:音频数据

| 属性 | 类型 | 说明 |

|---|---|---|

| type | string | 必填,始终为 "audio" |

| url | string | 音频 URL |

| base64 | string | Base64 编码音频数据 |

| id | string | 外部存储音频文件的引用 ID |

| mime_type | string | 音频 MIME 类型(如 audio/mpeg) |

VideoContentBlock

用途:视频数据

| 属性 | 类型 | 说明 |

|---|---|---|

| type | string | 必填,始终为 "video" |

| url | string | 视频 URL |

| base64 | string | Base64 编码视频数据 |

| id | string | 外部存储视频文件的引用 ID |

| mime_type | string | 视频 MIME 类型(如 video/mp4) |

FileContentBlock

用途:通用文件(PDF 等)

| 属性 | 类型 | 说明 |

|---|---|---|

| type | string | 必填,始终为 "file" |

| url | string | 文件 URL |

| base64 | string | Base64 编码文件数据 |

| id | string | 外部存储文件的引用 ID |

| mime_type | string | 文件 MIME 类型(如 application/pdf) |

PlainTextContentBlock

用途:文本文档(.txt、.md)

| 属性 | 类型 | 说明 |

|---|---|---|

| type | string | 必填,始终为 "text-plain" |

| text | string | 文本内容 |

| mime_type | string | 文本 MIME 类型(如 text/plain) |

ToolCall

用途:函数调用

| 属性 | 类型 | 说明 |

|---|---|---|

| type | string | 必填,始终为 "tool_call" |

| name | string | 必填,工具名称 |

| args | object | 必填,传递给工具的参数 |

| id | string | 必填,工具调用的唯一标识 |

示例:

{

"type": "tool_call",

"name": "search",

"args": {"query": "weather"},

"id": "call_123"

}

ToolCallChunk

用途:流式工具调用片段

| 属性 | 类型 | 说明 | |

|---|---|---|---|

| type | string | 必填,始终为 "tool_call_chunk" | |

| name | string | 工具名称 | |

| args | string | 部分工具参数(可能是未完成的 JSON) | |

| id | string | 工具调用标识 | |

| index | number | string | 流中的片段位置 |

InvalidToolCall

用途:格式错误的调用(用于捕获 JSON 解析错误)

| 属性 | 类型 | 说明 |

|---|---|---|

| type | string | 必填,始终为 "invalid_tool_call" |

| name | string | 调用失败的工具名称 |

| args | object | 传递给工具的参数 |

| error | string | 错误描述 |

ServerToolCall

用途:服务器端执行的工具调用

| 属性 | 类型 | 说明 |

|---|---|---|

| type | string | 必填,始终为 "server_tool_call" |

| id | string | 工具调用标识 |

| name | string | 工具名称 |

| args | string | 部分工具参数(可能是未完成的 JSON) |

ServerToolCallChunk

用途:流式服务器端工具调用片段

| 属性 | 类型 | 说明 | |

|---|---|---|---|

| type | string | 必填,始终为 "server_tool_call_chunk" | |

| id | string | 工具调用标识 | |

| name | string | 工具名称 | |

| args | string | 部分工具参数(可能是未完成的 JSON) | |

| index | number | string | 流中的片段位置 |

ServerToolResult

用途:工具执行结果

| 属性 | 类型 | 说明 |

|---|---|---|

| type | string | 必填,始终为 "server_tool_result" |

| tool_call_id | string | 对应的服务器端工具调用标识 |

| id | string | 服务器工具结果标识 |

| status | string | 执行状态 "success" 或 "error" |

| output | any | 执行输出 |

NonStandardContentBlock

用途:提供商特定的逃生通道

| 属性 | 类型 | 说明 |

|---|---|---|

| type | string | 必填,始终为 "non_standard" |

| value | object | 必填,提供商特定的数据结构 |

用途:用于实验性或提供商独有的功能。

内容块在 LangChain v1 中作为消息的新属性引入,用于在不同提供商间标准化内容格式,同时保持与现有代码的向后兼容性。内容块并不是替代 content 属性,而是提供了一个可以标准化访问消息内容的新接口。

工具

许多 AI 应用通过自然语言与用户交互。然而,一些用例需要模型直接与外部系统(如 API、数据库或文件系统)交互,并使用结构化输入。

工具是代理调用以执行操作的组件。它们通过定义良好的输入和输出扩展模型的能力,让模型能够与外部世界互动。工具封装了可调用函数及其输入模式,这些工具可以传递给兼容的聊天模型,让模型决定是否调用该工具以及使用哪些参数。在这些场景中,工具调用使模型能够生成符合指定输入模式的请求。

一些聊天模型(如 OpenAI、Anthropic 和 Gemini)具有内置工具,这些工具在服务器端执行,例如网页搜索和代码解释器。

创建工具最简单的方法是使用 @tool 装饰器。默认情况下,函数的 docstring 会成为工具的描述,帮助模型理解何时使用它:

from langchain.tools import tool

@tool

def search_database(query: str, limit: int = 10) -> str:

"""Search the customer database for records matching the query.

Args:

query: Search terms to look for

limit: Maximum number of results to return

"""

return f"Found {limit} results for '{query}'"

类型提示是必需的,因为它们定义了工具的输入模式。docstring 应该简明而信息丰富,以帮助模型理解工具的用途。

自定义工具名称

默认情况下,工具名称来自函数名称。如果需要更具描述性的名称,可以覆盖它:

@tool("web_search") # 自定义名称

def search(query: str) -> str:

"""Search the web for information."""

return f"Results for: {query}"

print(search.name) # web_search

自定义工具描述

可以覆盖自动生成的工具描述,为模型提供更清晰的指导:

@tool("calculator", description="Performs arithmetic calculations. Use this for any math problems.")

def calc(expression: str) -> str:

"""Evaluate mathematical expressions."""

return str(eval(expression))

高级输入模式定义

可以使用 Pydantic 模型或 JSON Schema 定义复杂的输入:

Pydantic 模型示例

from pydantic import BaseModel, Field

from typing import Literal

class WeatherInput(BaseModel):

"""Input for weather queries."""

location: str = Field(description="City name or coordinates")

units: Literal["celsius", "fahrenheit"] = Field(

default="celsius",

description="Temperature unit preference"

)

include_forecast: bool = Field(

default=False,

description="Include 5-day forecast"

)

@tool(args_schema=WeatherInput)

def get_weather(location: str, units: str = "celsius", include_forecast: bool = False) -> str:

"""Get current weather and optional forecast."""

temp = 22 if units == "celsius" else 72

result = f"Current weather in {location}: {temp} degrees {units[0].upper()}"

if include_forecast:

result += "\nNext 5 days: Sunny"

return result

这样定义工具可以让模型通过结构化参数调用,并生成符合输入模式的请求。

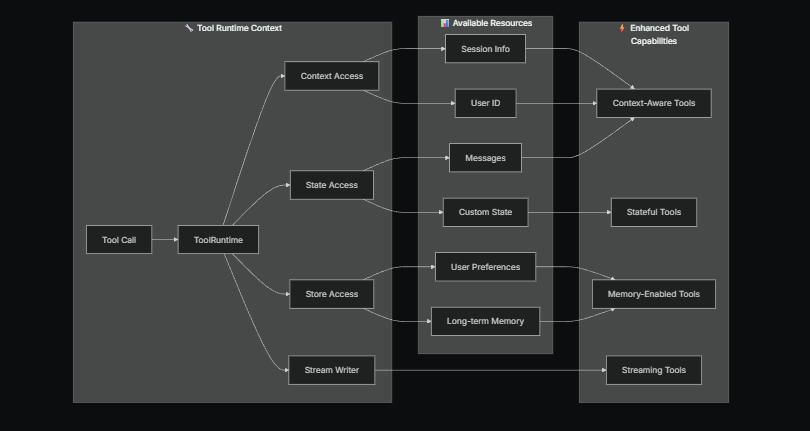

访问上下文

当工具能够访问代理状态、运行时上下文和长期记忆时,它们的能力最强。这使工具能够做出上下文感知的决策、个性化响应,并在对话中保持信息。

运行时上下文提供了一种方法,可以在运行时将依赖项(如数据库连接、用户 ID 或配置)注入工具,使工具更易于测试和复用。

工具可以通过 ToolRuntime 参数访问运行时信息,它提供以下功能:

- State(状态):可变数据,在执行过程中流动(例如消息、计数器、自定义字段)

- Context(上下文):不可变配置,如用户 ID、会话信息或应用特定配置

- Store(存储):跨对话的持久化长期记忆

- Stream Writer(流写入器):在工具执行时流式发送自定义更新

- Config(配置):用于执行的

RunnableConfig - Tool Call ID(工具调用 ID):当前工具调用的 ID

ToolRuntime 用于在单个参数中访问所有运行时信息。只需在工具签名中添加 runtime: ToolRuntime,它将自动注入,不会暴露给 LLM。

ToolRuntime:统一参数,为工具提供对状态、上下文、存储、流、配置和工具调用 ID 的访问。这取代了以前需要分别使用 InjectedState、InjectedStore、get_runtime 和 InjectedToolCallId 的模式。

运行时会自动将这些能力提供给工具函数,无需显式传递或使用全局状态。

访问状态示例

工具可以通过 ToolRuntime 访问当前图状态:

from langchain.tools import tool, ToolRuntime

# 访问当前对话状态

@tool

def summarize_conversation(

runtime: ToolRuntime

) -> str:

"""Summarize the conversation so far."""

messages = runtime.state["messages"]

human_msgs = sum(1 for m in messages if m.__class__.__name__ == "HumanMessage")

ai_msgs = sum(1 for m in messages if m.__class__.__name__ == "AIMessage")

tool_msgs = sum(1 for m in messages if m.__class__.__name__ == "ToolMessage")

return f"Conversation has {human_msgs} user messages, {ai_msgs} AI responses, and {tool_msgs} tool results"

访问自定义状态字段:

@tool

def get_user_preference(

pref_name: str,

runtime: ToolRuntime # ToolRuntime 参数不会暴露给模型

) -> str:

"""Get a user preference value."""

preferences = runtime.state.get("user_preferences", {})

return preferences.get(pref_name, "Not set")

tool_runtime 参数对模型是隐藏的。在上例中,模型在工具模式中只看到 pref_name,tool_runtime 不会包含在请求中。

更新状态:

使用 Command 来更新代理的状态或控制图的执行流程:

from langgraph.types import Command

from langchain.messages import RemoveMessage

from langgraph.graph.message import REMOVE_ALL_MESSAGES

from langchain.tools import tool, ToolRuntime

# 通过删除所有消息来更新对话历史

@tool

def clear_conversation() -> Command:

"""清除对话历史。"""

return Command(

update={

"messages": [RemoveMessage(id=REMOVE_ALL_MESSAGES)],

}

)

# 更新代理状态中的 user_name

@tool

def update_user_name(

new_name: str,

runtime: ToolRuntime

) -> Command:

"""更新用户的名字。"""

return Command(update={"user_name": new_name})

通过使用 Command,你可以精确控制状态更新,能够方便地更新消息或状态中的某些字段。

上下文

通过 runtime.context 访问不可变配置和上下文数据,如用户ID、会话详情或特定应用的配置。

工具可以通过 ToolRuntime 访问运行时上下文:

from dataclasses import dataclass

from langchain_openai import ChatOpenAI

from langchain.agents import create_agent

from langchain.tools import tool, ToolRuntime

USER_DATABASE = {

"user123": {

"name": "Alice Johnson",

"account_type": "Premium",

"balance": 5000,

"email": "alice@example.com"

},

"user456": {

"name": "Bob Smith",

"account_type": "Standard",

"balance": 1200,

"email": "bob@example.com"

}

}

@dataclass

class UserContext:

user_id: str

@tool

def get_account_info(runtime: ToolRuntime[UserContext]) -> str:

"""获取当前用户的账户信息。"""

user_id = runtime.context.user_id

if user_id in USER_DATABASE:

user = USER_DATABASE[user_id]

return f"账户持有人: {user['name']}\n账户类型: {user['account_type']}\n余额: ${user['balance']}"

return "未找到用户"

model = ChatOpenAI(model="gpt-4o")

agent = create_agent(

model,

tools=[get_account_info],

context_schema=UserContext,

system_prompt="你是一个财务助手。"

)

result = agent.invoke(

{"messages": [{"role": "user", "content": "我的当前余额是多少?"}]},

context=UserContext(user_id="user123")

)

记忆(存储)

通过 store 访问会话间的持久数据。store 通过 runtime.store 访问,允许你保存和检索用户特定或应用特定的数据。

工具可以通过 ToolRuntime 访问和更新存储:

from typing import Any

from langgraph.store.memory import InMemoryStore

from langchain.agents import create_agent

from langchain.tools import tool, ToolRuntime

# 访问记忆

@tool

def get_user_info(user_id: str, runtime: ToolRuntime) -> str:

"""查找用户信息。"""

store = runtime.store

user_info = store.get(("users",), user_id)

return str(user_info.value) if user_info else "未知用户"

# 更新记忆

@tool

def save_user_info(user_id: str, user_info: dict[str, Any], runtime: ToolRuntime) -> str:

"""保存用户信息。"""

store = runtime.store

store.put(("users",), user_id, user_info)

return "成功保存用户信息。"

store = InMemoryStore()

agent = create_agent(

model,

tools=[get_user_info, save_user_info],

store=store

)

# 第一次会话:保存用户信息

agent.invoke({

"messages": [{"role": "user", "content": "保存以下用户信息:userid: abc123, name: Foo, age: 25, email: foo@langchain.dev"}]

})

# 第二次会话:获取用户信息

agent.invoke({

"messages": [{"role": "user", "content": "获取ID为'abc123'的用户信息"}]

})

# 获取ID为 "abc123" 的用户信息:

# - 姓名: Foo

# - 年龄: 25

# - 邮箱: foo@langchain.dev

这样,你可以在会话之间保存并恢复特定的用户信息,提供更有个性化的互动体验。

流写入器 (Stream Writer)

使用 runtime.stream_writer 从工具执行过程中流式传输自定义更新。这对于向用户提供实时反馈非常有用,能够显示工具当前正在执行的操作。

from langchain.tools import tool, ToolRuntime

@tool

def get_weather(city: str, runtime: ToolRuntime) -> str:

"""获取指定城市的天气。"""

writer = runtime.stream_writer

# 在工具执行时流式传输自定义更新

writer(f"正在查询城市 {city} 的数据")

writer(f"已获取 {city} 的数据")

return f"{city} 总是阳光明媚!"

如果在你的工具中使用了 runtime.stream_writer,则该工具必须在 LangGraph 执行上下文中调用。

短期记忆

记忆是一个系统,它能记住先前交互的信息。对于 AI 代理来说,记忆至关重要,因为它让代理能够记住之前的交互,学习反馈,并适应用户偏好。随着代理处理更复杂的任务和更多的用户交互,这种能力对于效率和用户满意度变得越来越重要。

短期记忆使得你的应用能够记住单个线程或会话中的先前交互。

一个线程组织了一个会话中的多个交互,类似于电子邮件将消息分组为一个单一的对话。

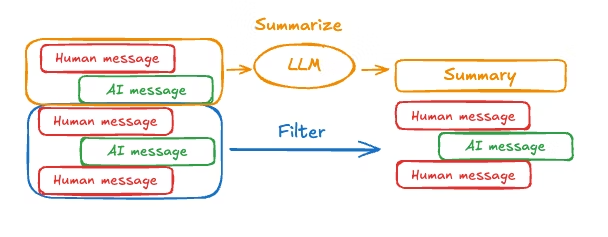

会话历史是短期记忆最常见的形式。长时间的对话对今天的语言模型(LLMs)提出了挑战;完整的历史可能无法放入 LLM 的上下文窗口中,从而导致上下文丢失或错误。

即使模型支持完整的上下文长度,许多 LLM 在长上下文中表现仍然很差。它们容易被过时或不相关的内容分心,同时响应时间变慢,成本增加。

聊天模型通过消息接收上下文,消息包括指令(系统消息)和输入(人类消息)。在聊天应用中,消息在人的输入和模型响应之间交替,从而形成一个随着时间推移而不断增长的消息列表。由于上下文窗口是有限的,许多应用可以通过使用技术来移除或“忘记”过时的信息来受益。

使用方式

要为代理添加短期记忆(线程级持久性),你需要在创建代理时指定一个检查点(checkpointer)。

LangChain 的代理将短期记忆作为代理状态的一部分进行管理。通过将这些信息存储在图的状态中,代理可以访问给定会话的完整上下文,同时保持不同线程之间的隔离。

状态通过检查点持久化到数据库(或内存)中,因此线程可以随时恢复。

短期记忆在每次代理调用或完成一个步骤(如工具调用)时更新,并且在每次步骤开始时读取状态。

from langchain.agents import create_agent

from langgraph.checkpoint.memory import InMemorySaver

agent = create_agent(

"gpt-5",

[get_user_info],

checkpointer=InMemorySaver(), # 使用内存保存器进行短期记忆持久化

)

agent.invoke(

{"messages": [{"role": "user", "content": "Hi! My name is Bob."}]},