创建用户 hadoop 并设置密码

useradd hadoop

passwd hadoop

把hadoop用户添加到sudoers 里

vi /etc/sudoers

在root ALL=(ALL) ALL 下面一行添加

hadoop ALL=(ALL) NOPASSWD: ALL

强制保存退出 :wq!

同步系统时间

sudo ntpdate cn.pool.ntp.org

sudo hwclock -w

在/opt 目录下创建software和moudle 目录

mkdir /opt/software /opt/moudle

更改 software和moudle 目录所属用户及用户组

chown hadoop:hadoop /opt/software /opt/moudle

修改配置 /etc/hosts

sudo vi /etc/hosts

192.168.56.101 centos

安装Hadoop

将hadoop-2.7.3.tar.gz 解压到/opt/moudle 目录下

tar -zxvf hadoop-2.7.3.tar.gz -C /opt/moudle/

配置环境变量

假设已经安装过了jdk1.8,编辑配置 sudo vi /etc/profile

export JAVA_HOME=/opt/moudle/jdk1.8.0_131

export HADOOP_HOME=/opt/moudle/hadoop-2.7.3

export PATH=$PATH:$JAVA_HOME/bin:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

使更改生效source /etc/profile

修改需要修改hadoop配置,Hadoop配置文件都在/opt/moudle/hadoop-2.7.3/etc/hadoop 目录下。将etc/hadoop/hadoop-env.sh 中的export JAVA_HOME 指向JDK的绝对路径。

vi hadoop-env.sh

将 export JAVA_HOME=${JAVA_HOME} 改为 export JAVA_HOME=/opt/moudle/jdk1.8.0_131

HDFS的配置

修改配置 etc/hadoop/core-site.xml

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://centos:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/opt/moudle/hadoop-2.7.3/data</value>

</property>

</configuration>

修改配置 etc/hadoop/hdfs-site.xml

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

</configuration>

格式化Hadoop文件系统

$ hdfs namenode -format

看到如下输出,说明格式化成功了,注意不能多次格式化。

19/12/05 14:38:10 INFO common.Storage: Storage directory /opt/moudle/hadoop-2.7.3/data/dfs/name has been successfully formatted.

19/12/05 14:38:10 INFO namenode.FSImageFormatProtobuf: Saving image file /opt/moudle/hadoop-2.7.3/data/dfs/name/current/fsimage.ckpt_0000000000000000000 using no compression

19/12/05 14:38:11 INFO namenode.FSImageFormatProtobuf: Image file /opt/moudle/hadoop-2.7.3/data/dfs/name/current/fsimage.ckpt_0000000000000000000 of size 353 bytes saved in 0 seconds.

启动namenode

hadoop-daemon.sh start namenode

通过jps 查看namenode 进程

[hadoop@centos hadoop-2.7.3]$ jps

28267 NameNode

28443 Jps

启动datanode

hadoop-daemon.sh start datanode

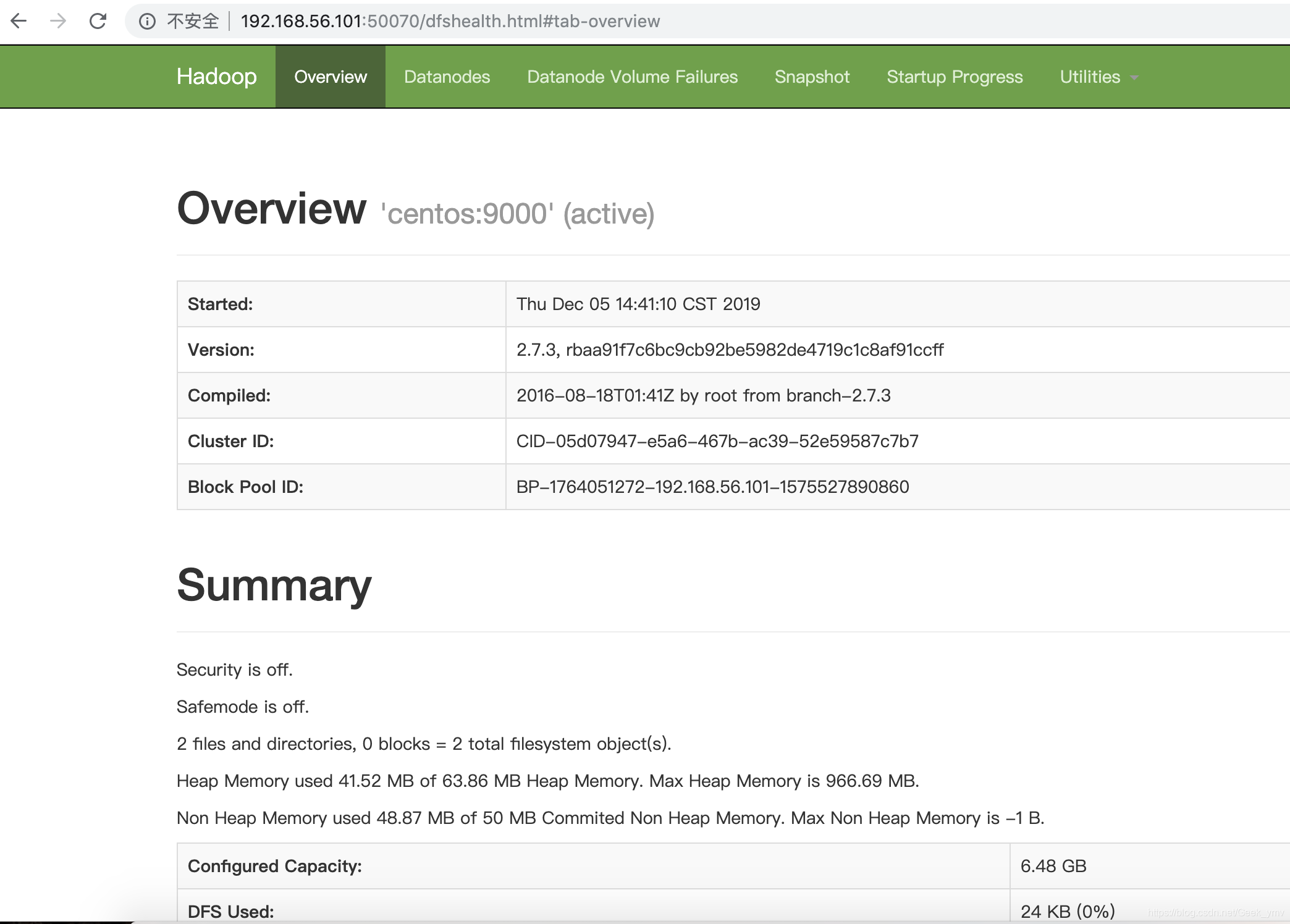

访问http://192.168.56.101:50070/

HDFS 命令使用

- 创建目录

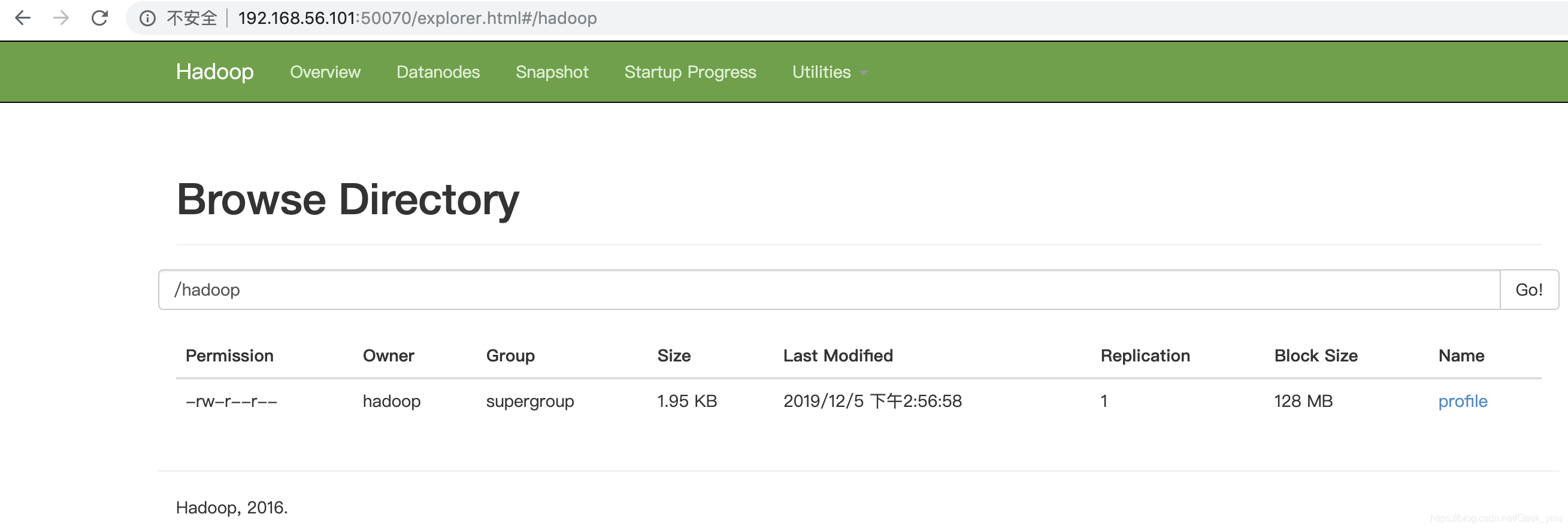

hadoop fs -mkdir /hadoop - 上传文件到/hadoop 目录

hadoop fs -put /etc/profile /hadoop/

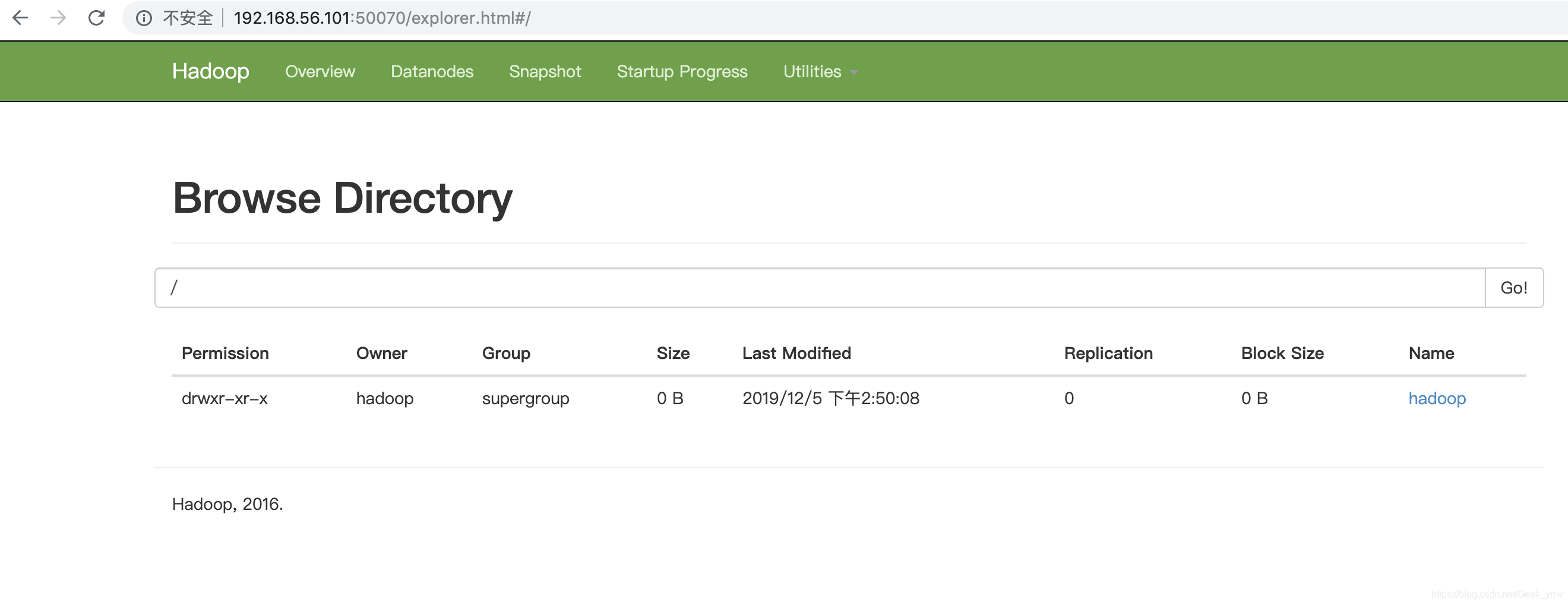

通过Utilities 可以看到我们创建到目录和上传到文件

MapReduce的配置

修改配置 etc/hadoop/mapred-site.xml

拷贝模版文件 mapred-site.xml.template

cp mapred-site.xml.template mapred-site.xml

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

</configuration>

修改配置 etc/hadoop/yarn-site.xml

<configuration>

<property>

<name>yarn.resourcemanager.hostname</name>

<value>centos</value>

</property>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

</configuration>

启动ResourceManager yarn-daemon.sh start resourcemanager

启动NodeManager yarn-daemon.sh start nodemanager

32720 NodeManager

25088 NameNode

31924 ResourceManager

25364 DataNode

3623 Jps

45万+

45万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?