DeepSeek-V3:新一代AI模型的突破与开源

引言

在人工智能领域,模型的迭代更新总是令人充满期待。今天,我们迎来了DeepSeek系列的最新成员——DeepSeek-V3。这不仅是一个技术突破,更是开源社区的一大盛事。本文将带你深入了解DeepSeek-V3的特性、性能以及它为AI领域带来的新机遇。

DeepSeek-V3的发布

DeepSeek-V3是DeepSeek系列的最新模型,它在今天正式发布并同步开源。用户现在可以登录官网chat.deepseek.com与最新版V3模型进行对话,体验其卓越的性能。值得注意的是,API服务已经同步更新,且接口配置无需改动,但当前版本的DeepSeek-V3暂不支持多模态输入输出。

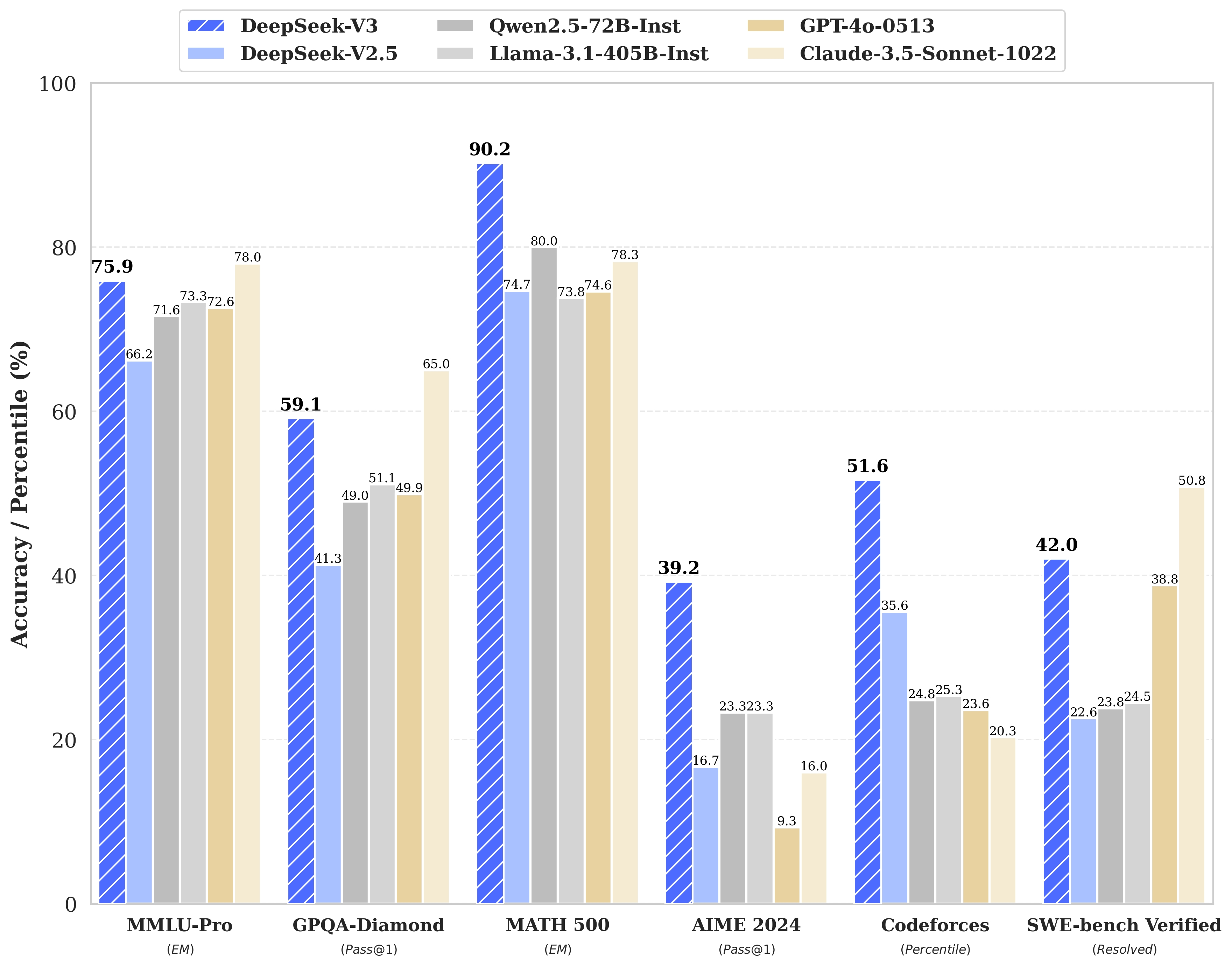

性能对齐海外领军闭源模型

DeepSeek-V3是一款自研的MoE模型,拥有671B参数和37B激活,在14.8T token上进行了预训练。根据官方发布的论文,DeepSeek-V3在多项评测中超越了Qwen2.5-72B和Llama-3.1-405B等其他开源模型,并在性能上与世界顶尖的闭源模型GPT-4o以及Claude-3.5-Sonnet不分伯仲。

百科知识与长文本处理

在知识类任务上,DeepSeek-V3的表现相比前代DeepSeek-V2.5有了显著提升,接近当前表现最好的模型Claude-3.5-Sonnet-1022。在长文本测评中,DeepSeek-V3在DROP、FRAMES和LongBench v2上的平均表现超越了其他模型。

代码与数学能力

DeepSeek-V3在算法类代码场景(Codeforces)中远远领先于市面上已有的全部非o1类模型,并在工程类代码场景(SWE-Bench Verified)逼近Claude-3.5-Sonnet-1022。在数学领域,DeepSeek-V3在美国数学竞赛(AIME 2024, MATH)和全国高中数学联赛(CNMO 2024)上大幅超过了所有开源闭源模型。

中文能力

DeepSeek-V3在教育类测评C-Eval和代词消歧等评测集上与Qwen2.5-72B表现相近,但在事实知识C-SimpleQA上更为领先。

生成速度提升至3倍

DeepSeek-V3通过算法和工程上的创新,将生成吐字速度从20 TPS大幅提高至60 TPS,实现了3倍的提升,为用户提供了更加迅速流畅的使用体验。

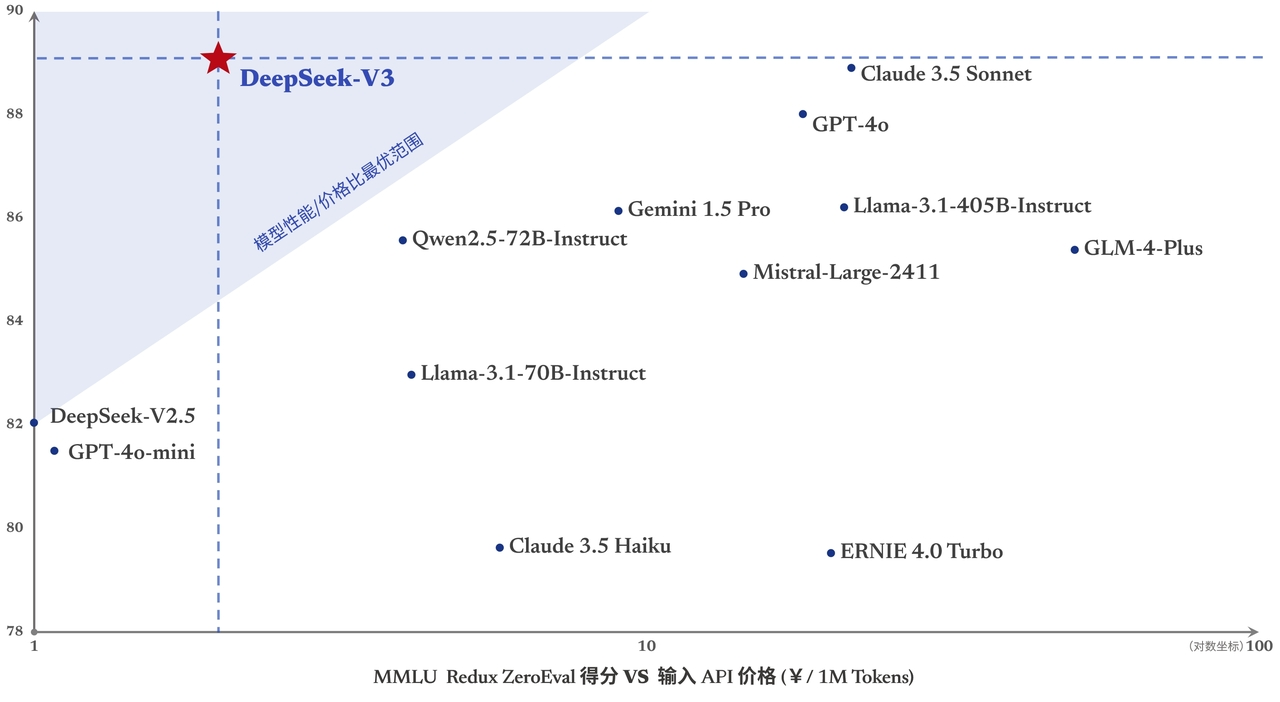

API服务价格调整

为庆祝新模型的发布,DeepSeek-V3的API服务价格在45天的优惠价格体验期内为每百万输入tokens 0.1元(缓存命中)/1元(缓存未命中),每百万输出tokens 2元。

开源权重和本地部署

DeepSeek-V3采用FP8训练,并开源了原生FP8权重。得益于开源社区的支持,SGLang和LMDeploy第一时间支持了V3模型的原生FP8推理,同时TensorRT-LLM和MindIE实现了BF16推理。此外,为了方便社区适配和拓展应用场景,提供了从FP8到BF16的转换脚本。

模型权重下载和更多本地部署信息请参考: https://huggingface.co/deepseek-ai/DeepSeek-V3-Base

结语

DeepSeek-V3的发布不仅是技术的一次飞跃,更是开源精神的体现。它不仅在性能上与世界顶尖的闭源模型媲美,更以开源的方式,推动了人工智能技术的普惠发展。我们期待DeepSeek-V3在未来能够带来更多的创新和突破,为AI领域的发展贡献力量。

441

441

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?