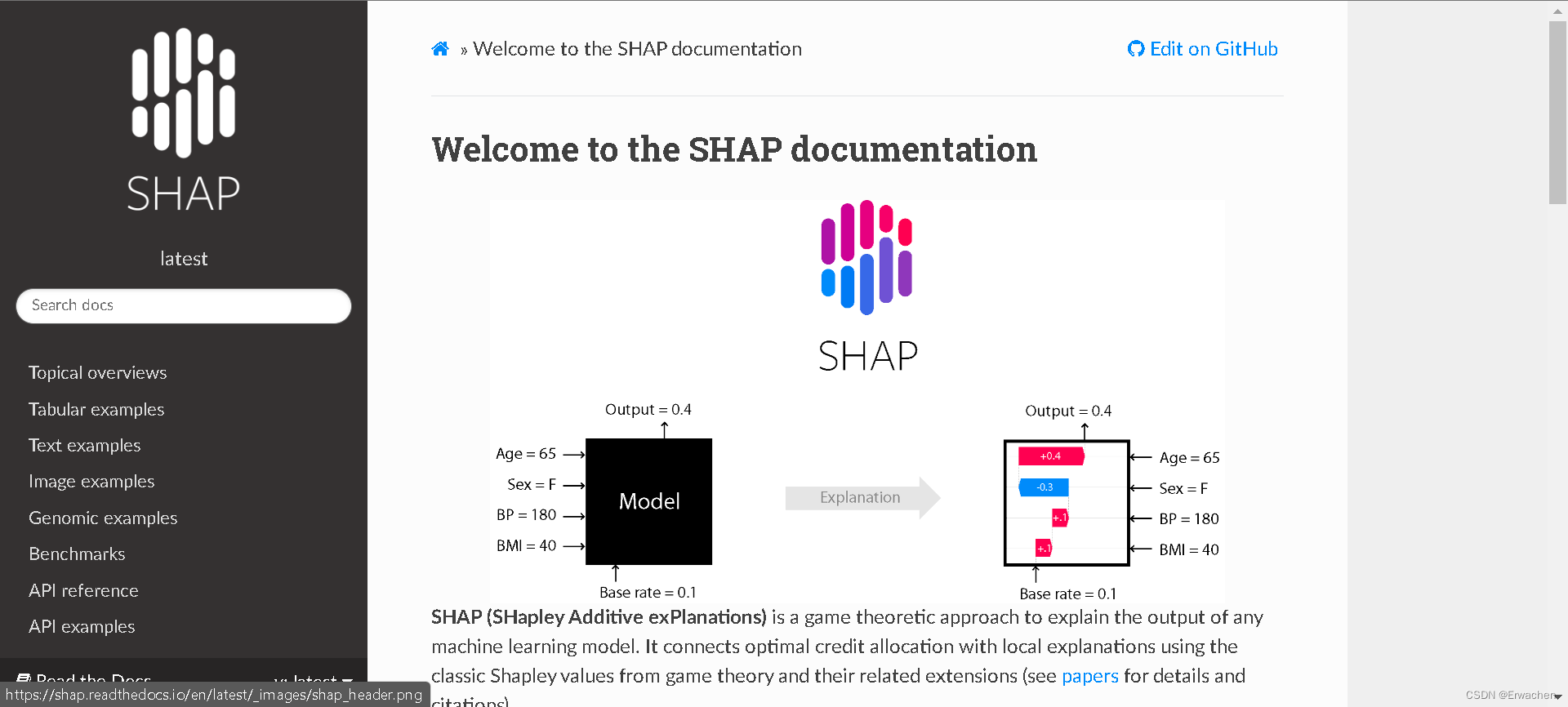

SHAP:Shapley additive explanations.一种博弈论方法,用于解释任何机器学习模型的输出。

官方解释文档:Welcome to the SHAP documentation — SHAP latest documentation

下面笔者将实例进行简单的运用讲解:

实例:用ResNet50网络对Imagenet50数据集进行分类

#导入必要库

import json

import numpy as np

import tensorflow as tf

from tensorflow.keras.applications.resnet50 import ResNet50, preprocess_input

import shap

# 加载预训练模型和数据集

model = ResNet50(weights='imagenet')

X, y = shap.datasets.imagenet50()

# 获取 ImageNet 1000 class names

url = "https://s3.amazonaws.com/deep-learning-models/image-models/imagenet_class_index.json"

with open(shap.datasets.cache(url)) as file:

cl

本文通过使用SHAP库解释ResNet50模型对Imagenet50数据集的分类结果,展示了如何利用masker突出图像中的关键特征,并讨论了不同参数设置对解释结果的影响。

本文通过使用SHAP库解释ResNet50模型对Imagenet50数据集的分类结果,展示了如何利用masker突出图像中的关键特征,并讨论了不同参数设置对解释结果的影响。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

3065

3065

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?