网络爬虫的原理:爬虫根据一定的网页分析算法过滤与主题无关的链接,保留有用的链接并将其放入等待抓取的URL队列。然后,它将根据一定的搜索策略从队列中选择下一步要抓取的网页URL,并重复上述过程,直到达到系统的某一条件时停止。另外,所有被爬虫抓取的网页将会被系统存贮,进行一定的分析、过滤,并建立索引,以便之后的查询和检索;对于聚焦爬虫来说,这一过程所得到的分析结果还可能对以后的抓取过程给出反馈和指导。

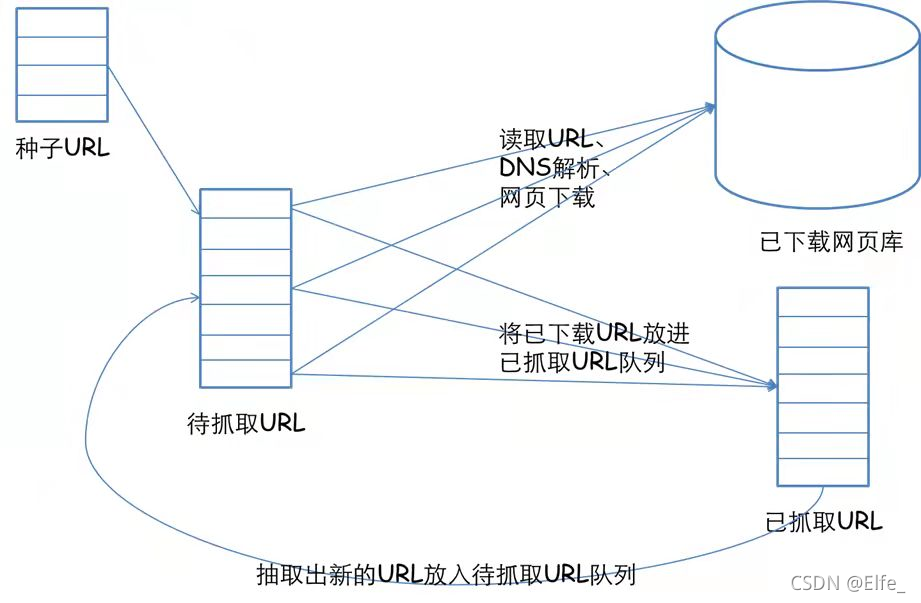

一个通用的网络爬虫的框架如图所示:

不同类型的网络爬虫,其实现原理也是不同的,但这些实现原理中,会存在很多共性。在此将以两种典型的网络爬虫为例(即通用网络爬虫和聚焦网络爬虫),讲解网络爬虫的实现原理。

1. 通用网络爬虫

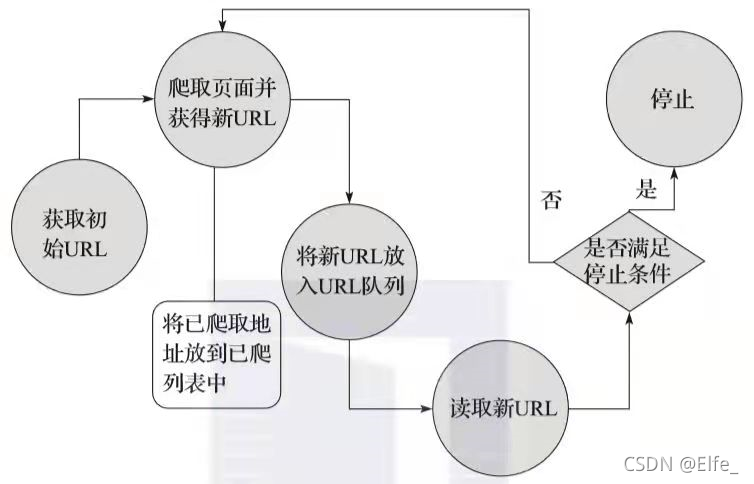

首先我们来看通用网络爬虫的实现原理。通用网络爬虫的实现原理及过程可以简要概括如图:

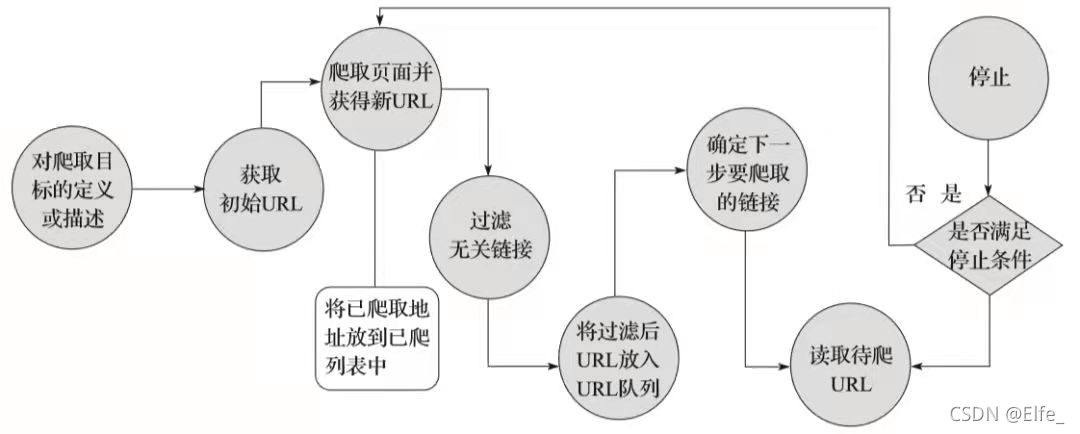

2. 聚焦网络爬虫

聚焦网络爬虫,由于其需要有目的地进行爬取,所以对于通用网络爬虫来说,必须要增加目标的定义和过滤机制,具体来说,此时,其执行原理和过程需要比通用网络爬虫多出三步,即目标的定义、无关链接的过滤、下一步要爬取的URL地址的选取等,如图:

网络爬虫是一个自动提取网页的程序,它为搜索引擎从万维网上下载网页,是搜索引擎的重要组成。传统爬虫从一个或若干初始网页的URL开始,获得初始网页上的URL,在抓取网页的过程中,不断从当前页面上抽取新的URL放入队列,直到满足系统的一定停止条件。

网络爬虫通过网页分析算法过滤无关链接,保留有用信息,放入待抓取URL队列。按照搜索策略从队列中选择URL进行抓取,直至满足停止条件。被抓取网页会被分析、过滤并建立索引。通用网络爬虫与聚焦网络爬虫的主要区别在于聚焦爬虫增加了目标定义、无关链接过滤和下一步URL选取机制。

网络爬虫通过网页分析算法过滤无关链接,保留有用信息,放入待抓取URL队列。按照搜索策略从队列中选择URL进行抓取,直至满足停止条件。被抓取网页会被分析、过滤并建立索引。通用网络爬虫与聚焦网络爬虫的主要区别在于聚焦爬虫增加了目标定义、无关链接过滤和下一步URL选取机制。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

554

554

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?