该博客基于搭建好的Hadoop-spark集群(docker下搭建),感兴趣的可以去看怎么搭建https://blog.youkuaiyun.com/Destiny_where/article/details/135589182

项目介绍:提取CSV中的电影基础数据和电影评分数据,写成spark临时表并通过sql计算 前十 的电影评分。

数据下载:https://download.youkuaiyun.com/download/Destiny_where/88878744,该博客使用到了 movies.csv 和 ratings.csv 两个数据文件。

流程:

-

上传movies.csv数据到hdfs:

hadoop fs -put movies.csv / -

使用

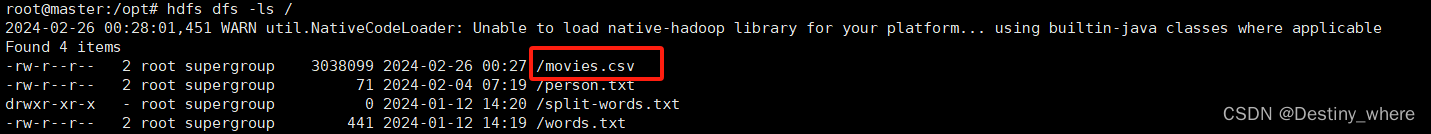

hdfs dfs -ls /查看刚刚上传的文件

-

同 步骤 1和2 , 上传ratings.csv文件

-

使用

spark-submit deal_movies.py指令提交代码到spark服务器执行。

deal_movies.py代码

import pyspark

from pyspark.sql

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

3345

3345

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?