1. 论文:

https://arxiv.org/pdf/1906.08237.pdf

XLNet是一个语言模型。和ELMO,GPT,BERT一脉相承,同时借鉴Transformer-XL,故称XLNet(XL含义为衣服尺码,意思是模型横向更宽),其参数规模远大于BERT

2. 基本思路:

通过排列组合的方式将一部分下文单词放到上文单词的位置,但实际形式还是一个从左到右预测的自回归语言模型。

3. 优化:

- 结合了自回归(AR , Autoregressive)模型和自编码(AE , Autoencoding )模型的优点,解决bert中mask带来的负面影响( pretrain-finetune discrepancy预训练和微调数据的不统一), eliminating the independence assumption made in BERT,capturing bidirectional context by maximizing the expected log likelihood of a sequence w.r.t. all possible permutations of the factorization order

- 双流注意力机制(新的分布计算方法,来实现目标位置感知)

- 引入transformer-XL

『自回归 / 自编码区别』

自回归,时间序列分析或者信号处理领域常用词汇,根据上文预测当前词

自编码,是无监督的,mask掉一个词,然后根据上下文来预测这个词

『双流注意力机制』

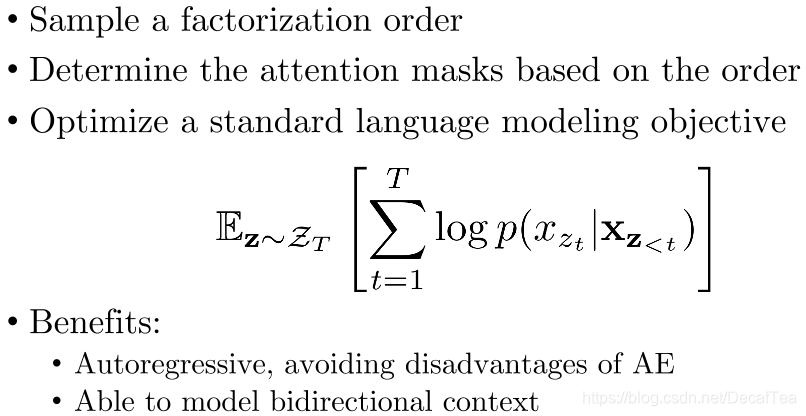

Permutation Language Model

通过随机取一句话排列的一种,然后将末尾一定量的词给 “遮掩”(和 BERT 里的直接替换 “[MASK]” 有些不同)掉,最后用 AR 的方式来按照这种排列方式依此预测被 “遮掩” 掉的词。

XLNet maximizes the expected log likelihood of a sequence w.r.t. all possible permutations of the factorization order. 从所有的排列中采样一种,然后根据这个排列来分解联合概率成条件概率的乘积,然后将所有排列情况的probability求和。

Note:句子原顺序(the original sequence:word embedding+positional embedding)不更改,更改的是permutations of the factorization order排列组合顺序,通过a proper attention mask in Transformer。Note that this choice is necessary, since the model will only encounter text sequences with the natural order during finetunin

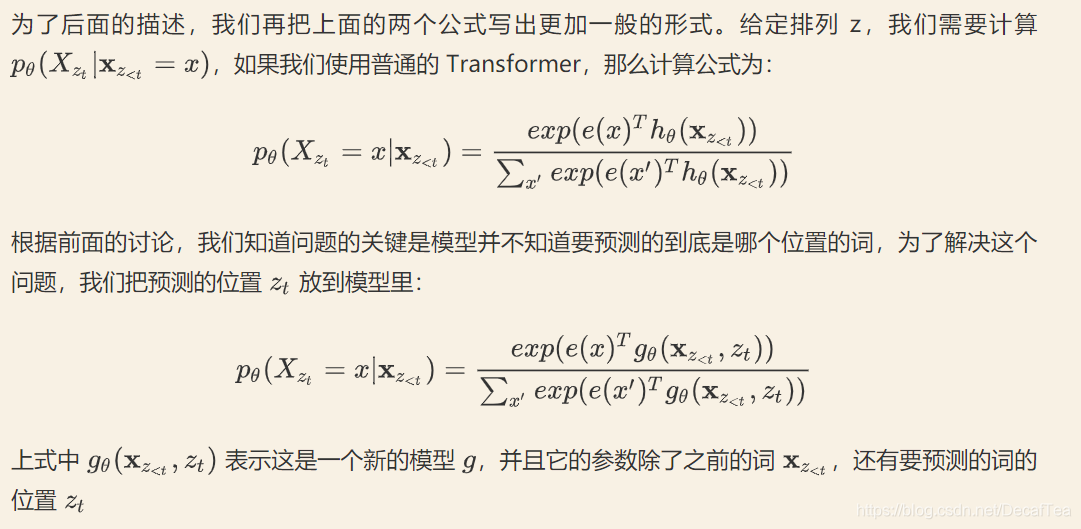

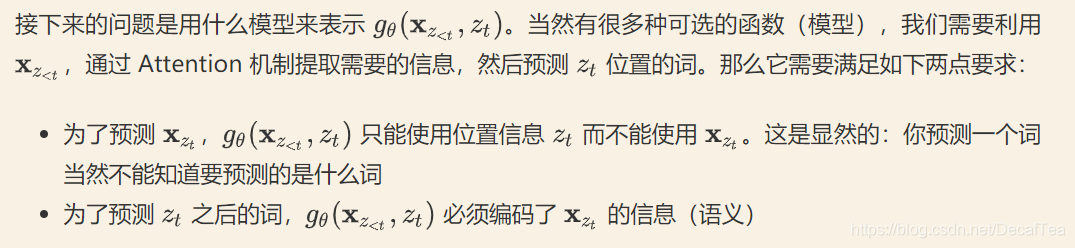

模型不可能知道它要预测的词到底是哪个位置的词,所以我们必须 “显式” 的告诉模型我要预测哪个位置的词

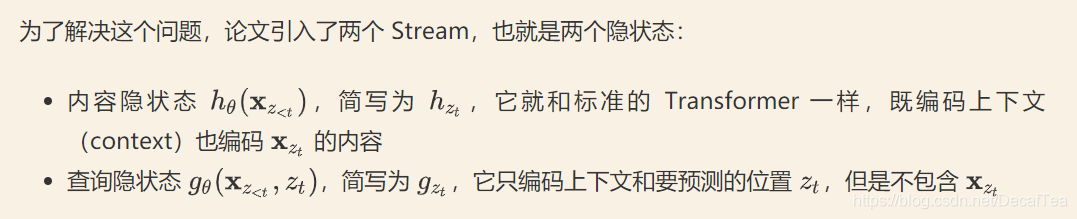

Two-Stream Self-Attention

XLNet是一个超越BERT的预训练语言模型,它结合了自回归和自编码模型的优势,解决了BERT中预训练和微调的不一致性问题。通过排列组合的方式处理输入序列,XLNet能捕捉到双向上下文信息,优化了Transformer-XL的双流注意力机制,以最大化所有可能的因子顺序下的序列期望对数似然性。这种方法允许模型在预测时考虑所有可能的词序,而不仅仅是自然顺序,从而提供更全面的上下文理解。

XLNet是一个超越BERT的预训练语言模型,它结合了自回归和自编码模型的优势,解决了BERT中预训练和微调的不一致性问题。通过排列组合的方式处理输入序列,XLNet能捕捉到双向上下文信息,优化了Transformer-XL的双流注意力机制,以最大化所有可能的因子顺序下的序列期望对数似然性。这种方法允许模型在预测时考虑所有可能的词序,而不仅仅是自然顺序,从而提供更全面的上下文理解。

895

895

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?