1. 基本介绍

北京时间2025年4月17日,OpenAI 发布了 o3 和 o4-mini 两个模型,再度引发强烈关注。

o3 是 OpenAI 目前最强推理模型,在编码、数学、科学、视觉感知等方面都有明显进步。o3 在 Codeforces 、SWE-bench 等基准测试中表现优异,适合复杂查询任务,在视觉任务中表现尤其出色。此外,与 o1 相比,o3 在完成现实任务中的错误率降低20%,能够在编程、商业/咨询和创意构思等领域提供重要帮助。

o4-mini 是一款体型更小的模型,专为快速、经济高效的推理做出了优化,同时保证了卓越的性能。o4-mini是在 AIME 2024和2025基准测试中表现最佳的模型,在非 STEM 任务以及数据科学等领域的表现也优于其前身 o3-mini。成本和性能共同使o4-mini成为解决推理问题的强大解决方案。

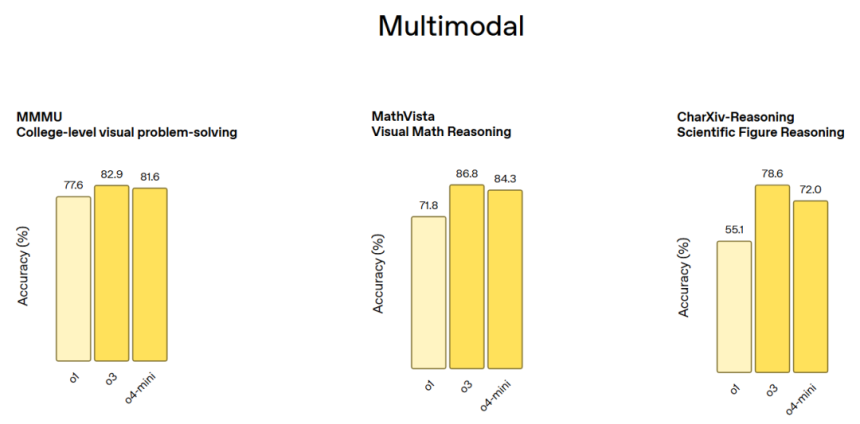

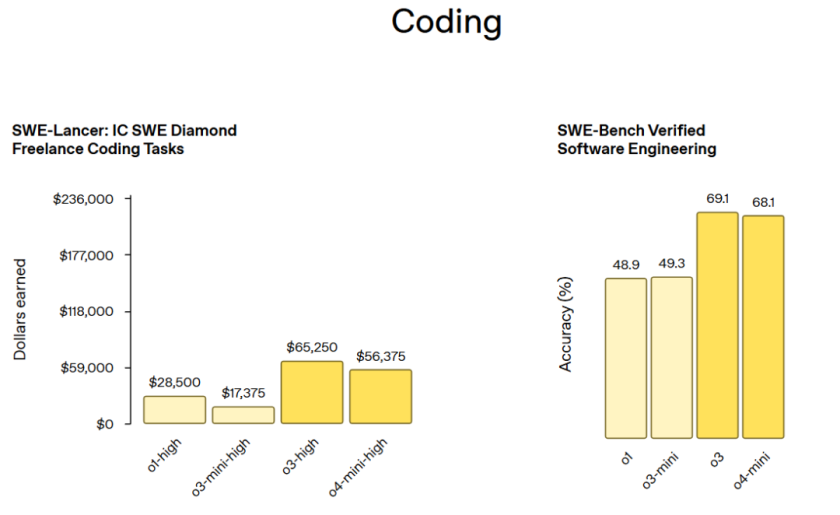

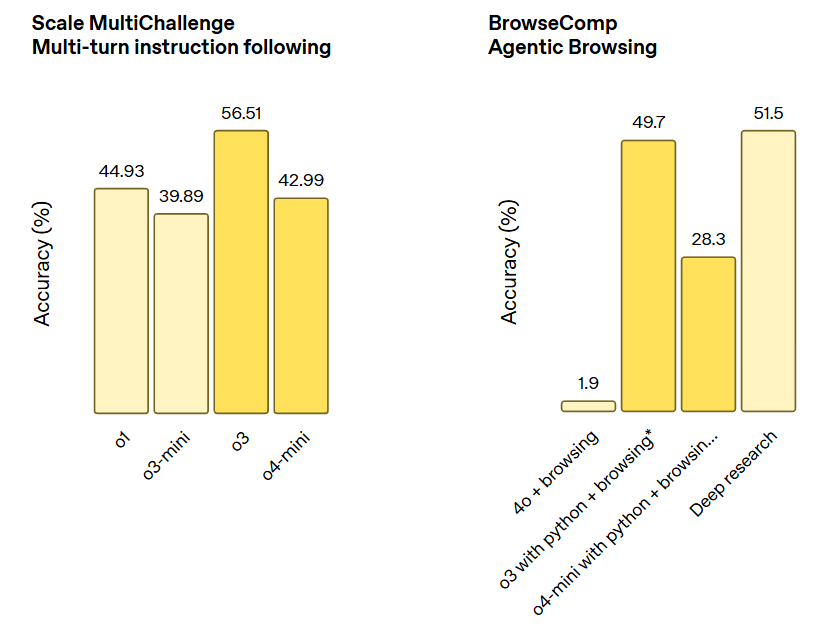

以下是 OpenAI o3 和 OpenAI o4-mini 在各类测试集上的表现(部分):

更多详细评测结果请参考:https://openai.com/index/introducing-o3-and-o4-mini/

2. 技术原理:强化学习拓展模型多模态推理能力边界

在 o3 的开发过程中,OpenAI 观察到大规模强化学习呈现出与 GPT 系列预训练中相同的“计算量越大,性能越好”的趋势。据此,OpenAI 提高了强化学习中的训练计算量和推理时间,研究团队在训练计算量和推理时间方面都提升了一个数量级,并看到了明显的模型性能提升,这证明了模型的性能会随着思考时间的增加而持续提升。

此外,OpenAI 还发现可以通过强化学习训练模型多模态推理能力。模型通过强化学习,不仅学会了如何使用工具,还学会了推理何时使用工具。o3 和 o4-mini 能够根据期望结果部署工具,这使得它们在多模态推理场景中表现更佳,尤其是在涉及视觉推理和多步骤工作流程的情况下。根据早期测试人员的报告,这种进步在学术基准测试和实际任务中均有体现。

3. 关键进展:工具调用和视觉推理能力大幅提升

3.1. 工具调用

OpenAI o3 和 o4-mini 可以访问 ChatGPT 中的工具,并能通过 API 中的函数调用访问用户自定义的工具。这些模型经过训练,能够推理解决问题的方法,自行决定何时及如何使用工具,并以正确的输出格式快速生成详细周到的答案,通常在不到一分钟内完成。

例如,对于“加州夏季的能源使用量与去年相比如何”的问题,o3 模型可搜索网络公共事业数据,编写 Python 代码预测,生成图表或图像,并解释预测的关键因素,还能在需要时多次搜索网络,尝试新搜索以获取更多信息。

3.2. 视觉推理

OpenAI o3 模型首次将图像直接整合到思维链中,不仅能看图,还能用图思考,开启了融合视觉和文本推理的全新问题解决方式,在多模态基准测试中表现顶尖。

视觉推理能力的基础是强大的自主工具调用能力。例如,用户上传的白板照片、教科书图表或手绘草图,即使模糊、反转或质量低下,模型也能解读并借助工具动态操作图像,如旋转、缩放或变换等,实现了视觉感知任务的一流准确率。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?