Kimi K2(月之暗面 Moonshot AI 推出的开源大模型)的全面解析,整合核心架构、性能表现、应用场景及部署方案,基于 2025 年 7 月最新行业数据整理:

⚙️ 一、核心架构与技术特性

-

MoE 稀疏架构

- 总参数量 1 万亿,但每次推理仅激活 32B 参数(384 个专家中动态选择 8 个 + 1 个共享专家),显著降低计算负载。

- 对比传统密集模型(如 DeepSeek-V3),同规模 GPU 推理效率提升 3 倍(例如 70B 模型原需 2×H100,现单卡可运行)。

-

训练稳定性创新

- 采用自研 MuonClip 优化器,在 15.5T Token 训练中实现零 Loss 波动,解决超大规模模型训练不稳定性问题。

- 训练数据涵盖多语言代码、学术论文及 仿真工具调用场景,强化 Agent 任务泛化能力。

-

上下文与功能支持

- 128K 长上下文(约 25 万汉字),支持一次性解析整本技术文档或项目代码库。

- 原生集成 ToolCall 工具调用、JSON Mode、联网搜索,但不支持视觉功能(需搭配 Kimi-Vision 模型)。

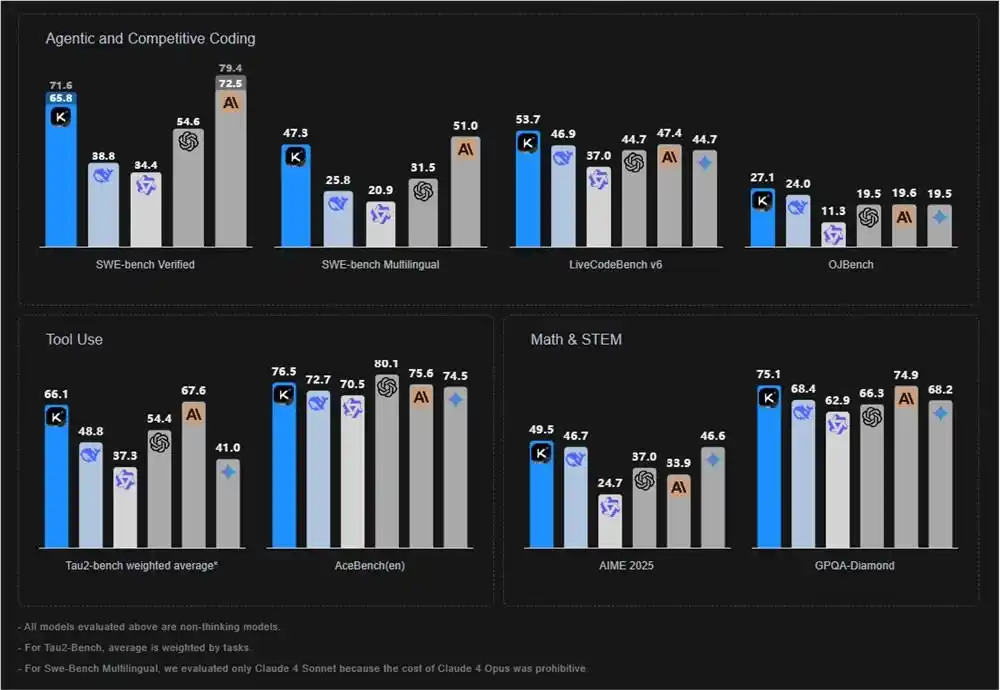

🚀 二、性能表现:超越闭源模型

关键基准测试结果

| 测试集 | Kimi K2 | GPT-4.1 | Claude Sonnet 4 | 优势领域 |

|---|---|---|---|---|

| SWE-Bench Verified | 65.8% | 54.6% | ~61% | 代码任务修复 |

| LiveCodeBench | 53.7% | 44.7% | 47.4% | 实时编程能力 |

| Math-500 | 97.4% | 92.4% | – | 数学推理竞赛题 |

| Agent 任务(TAU2) | 70.6% | 45.2% | ~72.7% | 多步骤工具调用 。 |

💡 核心优势:在 编程、数学推理、Agent 工作流 三大场景全面领先闭源模型,尤其适合复杂问题自动化处理。

⚡️ 三、部署与成本方案

1. API 服务

| 计费类型 | 价格(每百万 Token) | 说明 |

|---|---|---|

| 输入(缓存命中) | ¥1.00 | 复用已处理内容(如重复查询) |

| 输入(缓存未命中) | ¥4.00 | 全新请求内容 |

| 输出 | ¥16.00 | 生成结果统一计价 。 |

- 对比竞品:成本仅为 Claude 4 Sonnet 的 1/5(输入 $0.6 vs $3)。

2. 本地化部署

- 支持 vLLM、TensorRT-LLM、SGLang 推理框架,可通过 Hugging Face 获取权重。

- 硬件需求示例:

- 70B 等效模型 → 单卡 A100/H100(INT8 量化下显存 18GB)。

3. 高速推理平台

- Groq:吞吐量 152 TPS(Token/秒),延迟 4.6 秒,适合实时 Agent 任务。

- OpenRouter:支持多供应商自动路由,输入 $0.55/M,灵活应对高并发场景。

🛠️ 四、应用场景与案例

企业级自动化

- 代码生成与运维:自动编写 Dockerfile、调试 SQL 注入漏洞、生成 API 文档,减少人工干预 60%。

- 合规审计:一次性解析万页法律协议,对比条款差异并标记风险点。

科研与教育

- 数学推导:输入竞赛题(如 AIME)或论文公式,输出 LaTeX 格式推导过程 + Python 验证脚本。

- 教育助手:分步骤讲解递归算法、生成可交互学习案例。

Agent 工作流

- 用户请求 → 2. 自主规划工具调用链 → 3. 执行代码/API/文件操作 → 4. 返回完整解决方案

案例:从自然语言描述到部署完整网站(含身份验证、测试用例)。

⚖️ 五、生态定位与竞品对比

| 维度 | Kimi K2 | DeepSeek-V3 / GPT-4.1 | 优势 |

|---|---|---|---|

| 开源程度 | 权重/代码全开源(MIT) | 闭源/部分开源 | 支持私有化定制 |

| 推理成本 | ¥16/百万输出 Token | ¥80~120/百万 Token | 成本降低 80% |

| Agent 能力 | 原生多步骤工具链 | 依赖插件扩展 | 任务闭环效率提升 3 倍 |

| 适用开发者 | 初创企业/高校/边缘计算 | 企业级付费用户 | 长尾市场覆盖更广 。 |

💎 总结:Kimi K2 的核心价值

- ✅ 技术突破:万亿 MoE 架构 + MuonClip 训练稳定性,实现开源模型性能天花板。

- ✅ 成本革命:API 成本仅为竞品 1/5,推动 AI 普惠化。

- ✅ Agent 优先:从“对话应答”迈向“自主执行”,重塑工作流自动化范式。

- ✅ 中国开源标杆:继 DeepSeek-V3 后,再次确立国产大模型的全球竞争力。

开发者建议:优先通过 Groq 体验高速推理,或访问 Hugging Face 获取本地部署指南。对于复杂 Agent 任务,结合 LangChain 编排工具链可最大化发挥潜力 🔥。

728

728

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?