大型模型问答(推理)、**微调(Fine-tuning)和训练(Training)**三个阶段的GPU资源需求差异分析,涵盖显存、算力、网络和硬件选型等核心维度:

一、GPU资源需求对比总表

| 需求维度 | 问答(推理) | 微调(Fine-tuning) | 训练(Training) |

|---|---|---|---|

| 核心目标 | 低延迟响应请求 | 高效适配特定任务 | 从零学习参数 |

| 显存需求 | 模型参数+少量缓存 | 参数+梯度+优化器状态 | 参数+梯度+优化器+激活值 |

| 算力类型 | INT8/FP16推理加速 | FP16混合精度 | FP32/FP16混合精度 |

| 通信需求 | 无/单卡内通信 | 中等(数据并行) | 极高(模型/数据并行) |

| 典型硬件 | L4/T4/A10/A30 | A100/A800/RTX 6000 Ada | H100/H800/MI300X |

| 持续负载 | 突发性负载 | 中强度持续负载 | 7×24高强度负载 |

| 能效比 | 高(Tokens/Watt) | 中 | 低 |

二、显存需求差异详解

1. 显存占用公式

-

推理(Inference):

显存 ≥ 模型参数 + 激活值 + 缓存

例:7B模型(FP16)≈ 14GB参数 + 2GB缓存 = 16GB -

微调(Fine-tuning):

显存 ≥ (参数+梯度+优化器) × 并行数 + 激活值

例:7B模型(QLoRA微调)≈ 4GB参数 + 0.5GB梯度 + 0.5GB优化器 = 5GB -

训练(Training):

显存 ≥ 2×参数 + 2×梯度 + 12×优化器 + 激活值

例:7B模型(全参训练)≈ 14GB×2 + 14GB×2 + 14GB×12 = 224GB

2. 各阶段显存优化技术

| 技术 | 推理适用性 | 微调适用性 | 训练适用性 |

|---|---|---|---|

| 量化(INT8/FP8) | ★★★★★ | ★★★☆☆ | ★☆☆☆☆ |

| 梯度检查点 | ✘ | ★★★★☆ | ★★★★★ |

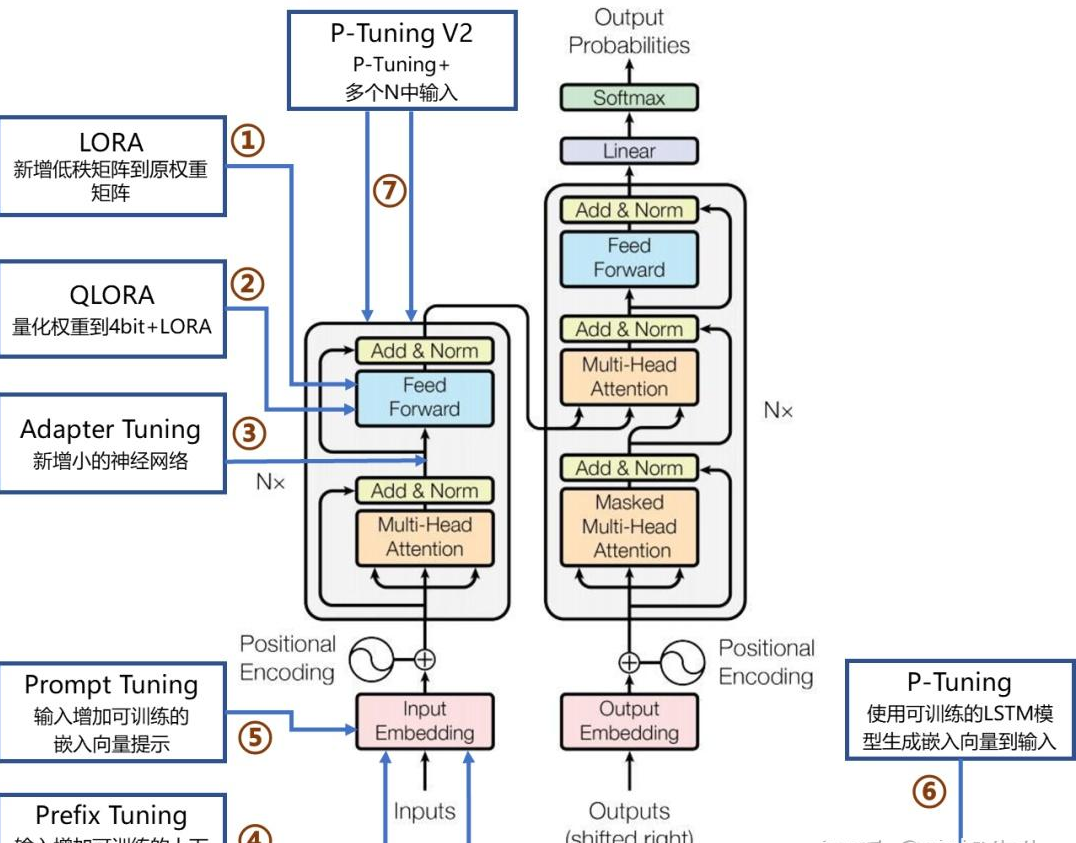

| LoRA/QLoRA | ✘ | ★★★★★ | ✘ |

| ZeRO-3 | ✘ | ★★★☆☆ | ★★★★★ |

注:H100对7B模型全参训练需 8卡(80GB×8),同模型推理仅需 1卡(24GB)

三、算力与硬件选型

1. 算力需求特征

| 阶段 | 计算密集度 | 典型算力需求(TFLOPS) | 推荐架构 |

|---|---|---|---|

| 推理 | 中 | 100-500 | Ampere/Ada Lovelace |

| 微调 | 中高 | 500-2000 | Ampere/Hopper | </

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

819

819

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?