注:文章来源:https://blog.youkuaiyun.com/weixin_44791964/article/details/102646387

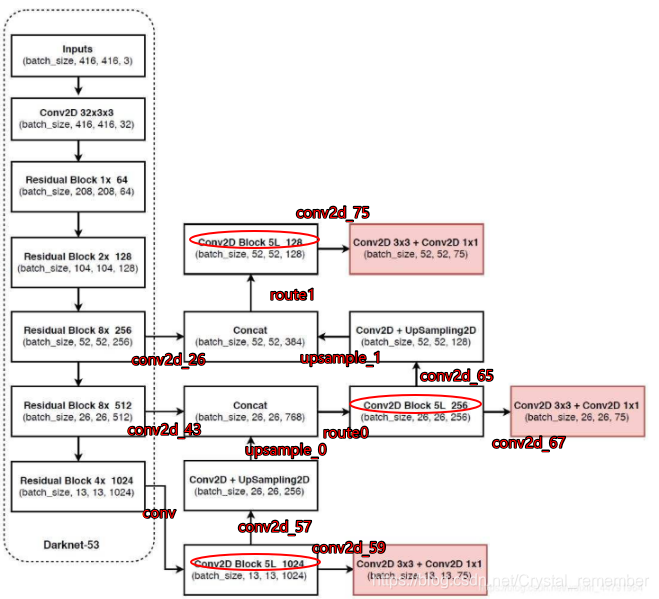

我对他的框图加了注释,便于理解,红色圈为yolo_block,深红色注解为前一模块的输出,请对照代码

YOLOv3相比于之前的yolo1和yolo2,改进较大,主要改进方向有:

1、使用了残差网络Residual,残差卷积就是进行一次3X3的卷积,然后保存该卷积layer,再进行一次1X1的卷积和一次3X3的卷积,并把这个结果加上layer作为最后的结果, 残差网络的特点是容易优化,并且能够通过增加相当的深度来提高准确率。其内部的残差块使用了跳跃连接,缓解了在深度神经网络中增加深度带来的梯度消失问题。

2、提取多特征层进行目标检测,一共提取三个特征层(粉色方框图),它的shape分别为(13,13,75),(26,26,75),(52,52,75)最后一个维度为75是因为该图是基于voc数据集的,它的类为20种,yolo3只有针对每一个特征层存在3个先验框,所以最后维度为3x25。

3、其采用反卷积UmSampling2d设计,逆卷积相对于卷积在神经网络结构的正向和反向传播中做相反的运算,其可以更多更好的提取出特征

# l2 正则化

def _batch_normalization_layer(self, input_layer, name = None, training = True, norm_decay = 0.99, norm_epsilon = 1e-3):

'''

Introduction

------------

对卷积层提取的feature map使用batch normalization

Parameters

----------

input_layer: 输入的四维tensor

name: batchnorm层的名字

trainging: 是否为训练过程

norm_decay: 在预测时计算moving average时的衰减率

norm_epsilon: 方差加上极小的数,防止除以0的情况

Returns

-------

bn_layer: batch normalization处理之后的feature map

'''

bn_layer = tf.layers.batch_normalization(inputs = input_layer,

momentum = norm_decay, epsilon = norm_epsilon, center = True,

scale = True, training = training, name = name)

return tf.nn.leaky_relu(bn_layer, alpha = 0.1)

# 这个就是用来进行卷积的

def _conv2d_layer(self, inputs, filters_num, kernel_size, name, use_bias = False, strides = 1):

"""

Introduction

------------

使用tf.layers.conv2d减少权重和偏置矩阵初始化过程,以及卷积后加上偏置项的操作

经过卷积之后需要进行batch norm,最后使用leaky ReLU激活函数

根据卷积时的步长,如果卷积的步长为2,则对图像进行降采样

比如,输入图片的大小为416*416,卷积核大小为3,若stride为2时,(416 - 3 + 2)/ 2 + 1, 计算结果为208,相当于做了池化层处理

因此需要对stride大于1的时候,先进行一个padding操作, 采用四周都padding一维代替'same'方式

Parameters

----------

inputs: 输入变量

filters_num: 卷积核数量

strides: 卷积步长

name: 卷积层名字

trainging: 是否为训练过程

use_bias: 是否使用偏置项

kernel_size: 卷积核大小

Returns

-------

conv: 卷积之后的feature map

"""

conv = tf.layers.conv2d(

inputs = inputs, filters = filters_num,

kernel_size = kernel_size, strides = [strides, strides], kernel_initializer = tf.glorot_uniform_initializer(),

padding = ('SAME' if strides == 1 else 'VALID'), kernel_regularizer = tf.contrib.layers.l2_regularizer(scale = 5e-4), use_bias = use_bias, name = nam

本文详细介绍了YOLOv3的改进之处,包括引入残差网络以优化深度学习模型,通过多尺度特征层进行目标检测,以及使用反卷积来提取特征。残差块利用跳跃连接缓解梯度消失问题,模型在13x13、26x26、52x52三个尺度上检测目标,每个尺度有3个先验框,总共75个输出通道。此外,还展示了darknet53网络结构及yolo_block的设计,用于生成最终的检测特征层。

本文详细介绍了YOLOv3的改进之处,包括引入残差网络以优化深度学习模型,通过多尺度特征层进行目标检测,以及使用反卷积来提取特征。残差块利用跳跃连接缓解梯度消失问题,模型在13x13、26x26、52x52三个尺度上检测目标,每个尺度有3个先验框,总共75个输出通道。此外,还展示了darknet53网络结构及yolo_block的设计,用于生成最终的检测特征层。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

6704

6704

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?