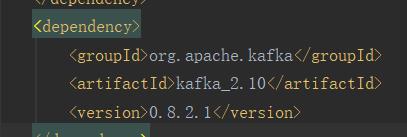

Note:spark1.6版本,kafka版本要是0.8.21

咳咳,pom文件自己去配

代码示例:

def main(args:Array[String]):Uint={

val conf=new SparkConf().setAppName("test) //在集群中运行可以不指定master

val sc=new SparkContext(conf)

// 定义topic

val topic=Set("callcentor") //callcentor为topic的名称

//定义bootstraps

val bootstraps="localhost:9092" //我是在集群单机版测试的,localhost 可以改成对应的地址

//定义kafka参数

val kafkaparams=Map[String,String](

"bootstrap.servers"->bootstraps,

"groupid"->"test",//消费者组的名字

"auto.offset.reset"->"smallest" //从最小的offset可以取

"key.deserializer"->"org.apache.kafka.common.serialization.StringDeserializer",

"value.deserializer"->"org.apache.kafka.common.serialization.StringDeserializer"

)

//创建streaming

val ssc=new StreamingContext(sc,Mil

本文介绍了在Spark 1.6版本中如何使用Spark Streaming与Kafka进行集成。通过设置SparkConf和SparkContext,定义Kafka的topic和bootstrap servers,以及配置kafkaparams,创建DirectStream并进行数据处理。示例代码展示了如何从Kafka的'callcentor'主题读取数据,并打印每个RDD中的消息内容。

本文介绍了在Spark 1.6版本中如何使用Spark Streaming与Kafka进行集成。通过设置SparkConf和SparkContext,定义Kafka的topic和bootstrap servers,以及配置kafkaparams,创建DirectStream并进行数据处理。示例代码展示了如何从Kafka的'callcentor'主题读取数据,并打印每个RDD中的消息内容。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?