论文笔记 |【AAAI2022】Best-Buddy GANs for Highly Detailed Image Super-Resolution

目录

1 Motivation

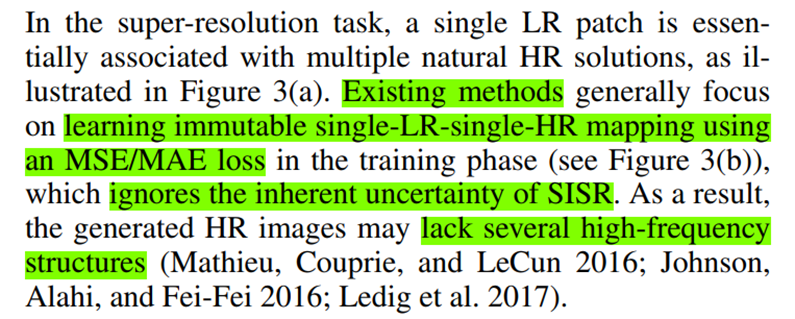

- 深度学习方法用于图像超分领域:PSNR、SSIM指标结果很好,但视觉效果模糊。

- 为了提高图像的感知质量,使用对抗学习和感知损失(adversarial learing and perceptual loss),但是:① 无法解决由一对一的MSE / MAE损失(L1L2损失)引起的过度平滑问题 ② 容易产生伪影效果

- 超分问题是病态问题,对于一个LR图像,对应有多个HR解,难以决定最好的解。

(MAE:平均绝对误差损失,L1;MSE:均方差损失,L2)

贡献

- Best-Buddy GAN 损失函数(一种改进的一对多MAE损失),生成更丰富和逼真的纹理细节。

- 区域感知的对抗学习策略,增强图片视觉质量

- 高分辨率4K图像数据集,公开

2 Method

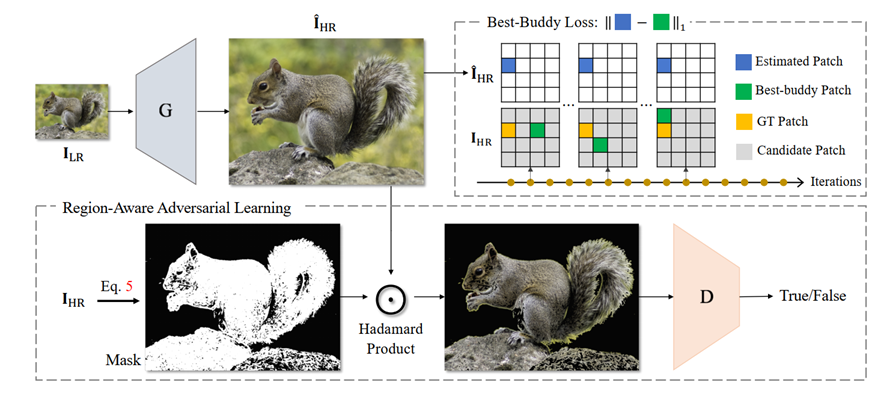

GAN: generator用于生成HR图像/discriminator用于分辨真假图像

generator: 经典的预训练RRDB模型(重要,因为这个模型的学习能力是已经被认可了的,所以后面的假设中才能认为generator生成的结果是具有合理性的)

2.1 Best-Buddy Loss

起因:

- 提出一个一对多的best buddy损失,寻找一个灵活但值得信任的监督patch,基于这个patch构建loss函数。

- key核心:一个预测出的HRpatch,在训练的不同迭代轮次中,可以对应多个目标监督patch。这个方法的本质就是,对于一个预测出的HRpatch Pi,我们寻找一个对应的,合理的监督patch gi*。

- 这个gi*需要满足两个限制,两个条件:一个是和GT对应的那个patch gi相近(也就是原来要作为监督的那个patch);另一个是要和生成的预测pi相近(因为generator已经是一个有比较强的学习能力的生成器了,有理由认为它的预测是合理的)。

过程如下:

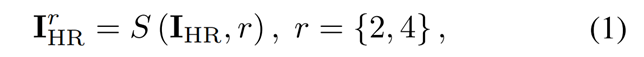

对于GT高分图像I-HR,对它做两次下采样:

把这些下采样的图像按照3×3切分展开成patch,那么我们要找的合理监督就应该在这些patch里,是其中一个。

为了满足

Best-BuddyGANs图像超分

Best-BuddyGANs图像超分

提出Best-BuddyGANs方法,通过Best-Buddy Loss和区域感知对抗学习策略,有效提升图像超分辨率生成的质量,生成更丰富细腻的纹理。

提出Best-BuddyGANs方法,通过Best-Buddy Loss和区域感知对抗学习策略,有效提升图像超分辨率生成的质量,生成更丰富细腻的纹理。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

630

630

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?