-

需求:在机器A联网下载模型及依赖环境,再拷到不联网机器B,实现离线部署。

-

方案:ollama+Chatbox+AnythingLLM

-

会遇到的报错:ollama拉取模型错误

1.本地部署

1.1 本地部署ollama

-

联网下载ollama安装包

- 官网下载(慢)

- Git上用迅雷下载(快)

- 或自行解决网络问题

-

ollama默认安装在C盘,将安装包放到D盘。

- 点击地址栏-清空-cmd-OllamaSetup.exe /DIR=D:\Ollama

- 输入格式:安装软件包名.exe /DIR=安装包所在目录

- 自动进入ollama安装步骤

-

修改大模型存储目录

- 在安装目录D:Ollama中,创建models文件夹。

- 新建该文件夹的环境变量,变量名OLLAMA_MODELS,变量值:浏览目录-D盘-Ollama-models

- 删除原C盘-用户文件夹中,.ollama文件夹里原先的models文件夹

-

检查ollama安装情况

- cmd——>Ollama --version

- 若出现版本信息,则安装成功。

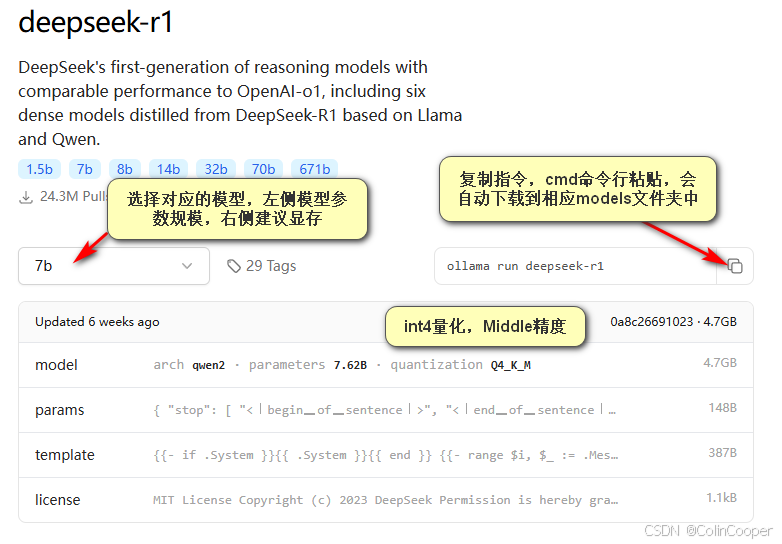

1.2 下载deepseek

![[图片]](https://i-blog.csdnimg.cn/direct/85a5f3805b954d9cbad5b96dd542e439.png) </

</

Deepseek本地部署与离线部署(以及ollama模型拉取报错)

最新推荐文章于 2025-10-09 14:59:45 发布

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2029

2029

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?