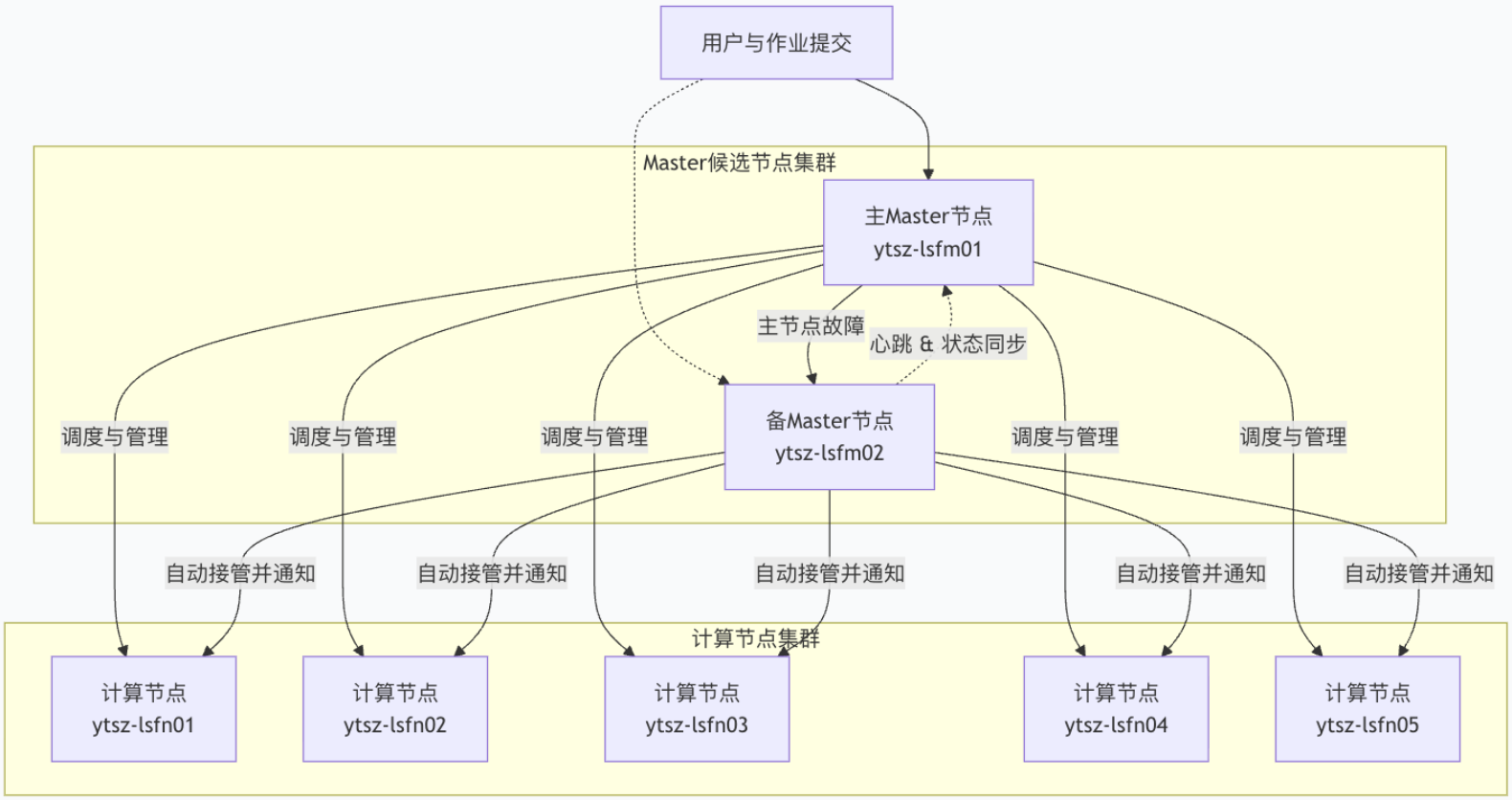

一、集群架构规划

1.1 架构概述

采用 "双Master高可用 + 5计算节点" 的标准生产架构,确保服务的可靠性和可扩展性。

1.2 节点规划

1.3 架构工作流程

上图展示了LSF核心组件在两个Master节点上的分布情况,以及故障转移的路径:

-

主Master节点 (ytsz-lsfm01): 运行着所有的管理守护进程,是集群的“大脑”。

-

备Master节点 (ytsz-lsfm02): 实时同步集群状态,并准备在主节点故障时瞬间接管。

-

故障转移 (Failover): 当主节点失效,备节点会自动升级为主节点,接管所有调度和管理职能,保障集群业务不中断。

二、部署前准备

2.1 系统基础配置

设置主机名和静态IP 「以 ytsz-lsfm01 为例」

hostnamectl set-hostname ytsz-lsfm01

nmcli connection modify ens33 \

ipv4.addresses 10.1.100.81/24 \

ipv4.gateway 10.1.100.254 \

ipv4.dns "10.1.100.2 10.1.100.1" \

ipv4.method manual

配置主机名解析 「所有节点」

echo "10.1.100.81 ytsz-lsfm01

10.1.100.82 ytsz-lsfm02

10.1.100.83 ytsz-lsfn01

10.1.100.84 ytsz-lsfn02

10.1.100.85 ytsz-lsfn03

10.1.100.86 ytsz-lsfn04

10.1.100.87 ytsz-lsfn05" >> /etc/hosts

2.2 SSH免密登录配置「Master节点上操作」

# 生成SSH密钥对

ssh-keygen -t rsa -b 4096

# 将公钥拷贝到所有节点

for host in ytsz-lsfm01 ytsz-lsfm02 ytsz-lsfn01 ytsz-lsfn02 \

ytsz-lsfn03 ytsz-lsfn04 ytsz-lsfn05 ytsz-lsfn06; do

ssh-copy-id $host

done

2.3 挂载共享存储 (NFS)

LSF要求所有节点共享一个安装目录。生产环境一般都有存储服务器,按需挂载即可。

本次实验目的,以 ytsz-lsfm01 为例,部署NFS服务器。

# 创建共享目录

mkdir /tools

# 安装NFS服务

dnf install nfs-utils -y

# 配置exports

echo "/tools 10.1.100.0/24(rw,sync,no_root_squash)" >> /etc/exports

# 应用配置并启动服务

exportfs -ra

systemctl start nfs-server.service

systemctl enable nfs-server.service

# 配置防火墙

firewall-cmd --permanent --add-service=nfs

firewall-cmd --permanent --add-service=mountd

firewall-cmd --permanent --add-service=rpc-bind

firewall-cmd --reload

NFS客户端挂载(所有节点)

# 安装NFS客户端

dnf install nfs-utils -y

# 创建挂载点并挂载

mkdir /tools

mount -t nfs ytsz-lsfm01:/tools /tools

# 设置开机自动挂载

echo "ytsz-lsfm01:/tools /tools nfs defaults 0 0" >> /etc/fstab

2.4 创建LSF管理员账户 (所有节点)

useradd lsfadmin

2.5 防火墙设置

# Master节点防火墙规则

firewall-cmd --permanent --add-port={7869,6878,6881,6882,6891}/tcp

firewall-cmd --permanent --add-port=7869/udp

firewall-cmd --reload

# 计算节点防火墙规则

firewall-cmd --permanent --add-port={7869,6878,6882}/tcp

firewall-cmd --permanent --add-port=7869/udp

firewall-cmd --reload

三、LSF安装步骤

3.1 安装依赖项

# Master节点依赖

dnf install -y ed libnsl

# 计算节点依赖

dnf install -y libnsl

3.2 准备安装文件

NSF共享上创建两个文件夹,/tools/lsf_distrib 和 /tools/lsf ,前者用于存放安装文件,后者用作LSF安装目录。

将IBM LSF 10.1的安装包上传到 /tools/lsf_distrib目录下。

# 检查安装文件

[root@ytsz-lsfm01 lsf_distrib]# ls

lsf10.1_lnx310-lib217-x86_64.tar.Z

lsf10.1_lsfinstall_linux_x86_64.tar.Z

lsf_std_entitlement.dat

# 安装解压工具并解压

yum install -y ncompress

tar -xZvf lsf10.1_lsfinstall_linux_x86_64.tar.Z

# 进入安装目录

cd lsf10.1_lsfinstall

3.3 配置安装参数 (install.config)

编辑 vim install.config 文件。以下是关键配置项:

LSF_TOP="/tools/lsf"

# LSF的安装目录,必须位于NFS共享上

LSF_ADMINS="lsfadmin"

# LSF管理员账号(需提前创建或使用现有账号)

LSF_CLUSTER_NAME="ytsz-lsfcluster"

# 集群名称

LSF_MASTER_LIST="ytsz-lsfm01 ytsz-lsfm02"

# 两个Master节点的主机名,这是实现高可用的关键

LSF_ENTITLEMENT_FILE="/tools/lsf_distrib/lsf_std_entitlement.dat"

# 许可证文件路径

LSF_TARDIR="/tools/lsf_distrib"

# LSF安装包tar.Z文件所在的目录

CONFIGURATION_TEMPLATE="HIGH_THROUGHPUT"

# 配置模板,高性能计算常用此模板

LSF_ADD_SERVERS="ytsz-lsfn01 ytsz-lsfn02 ytsz-lsfn03 ytsz-lsfn04 ytsz-lsfn05"

# 所有计算节点的主机名

# LSF_ADD_CLIENTS=""

# 如果需要专门的提交节点,在此列出

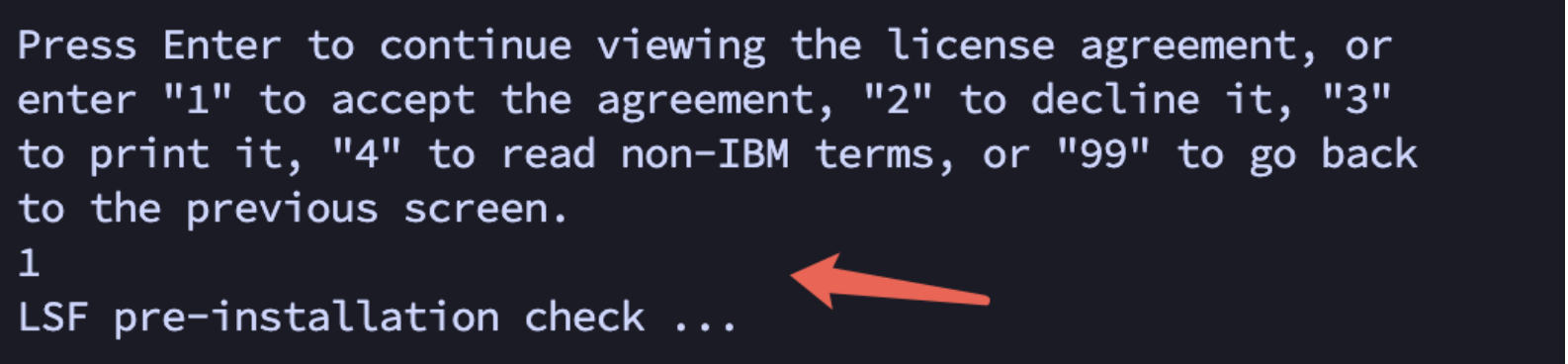

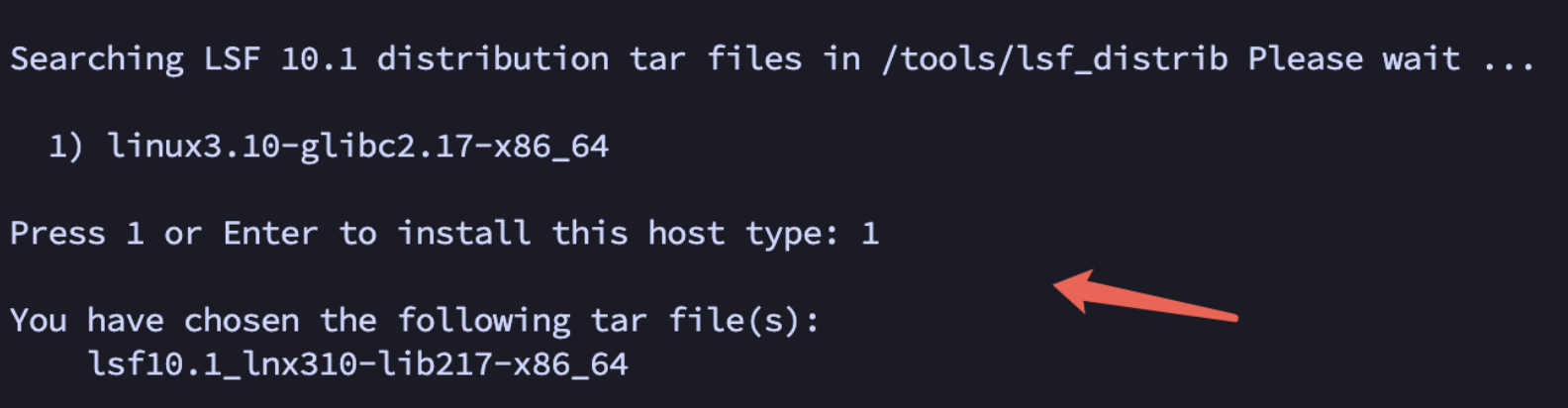

3.4 执行安装

# 执行lsf安装脚本

./lsfinstall -f install.config

注意:遵循安装脚本的提示完成安装(安装过程输入两次1)。安装过程可能会持续一段时间,它会将LSF安装到 LSF_TOP 指定的共享目录中。

四、集群配置与启动

4.1 环境变量配置

# 所有节点

source /tools/lsf/conf/profile.lsf

cp /tools/lsf/conf/profile.lsf /etc/profile.d/

4.2 配置LSF使用SSH通信

echo "LSF_RSH=ssh" >> /tools/lsf/conf/lsf.conf

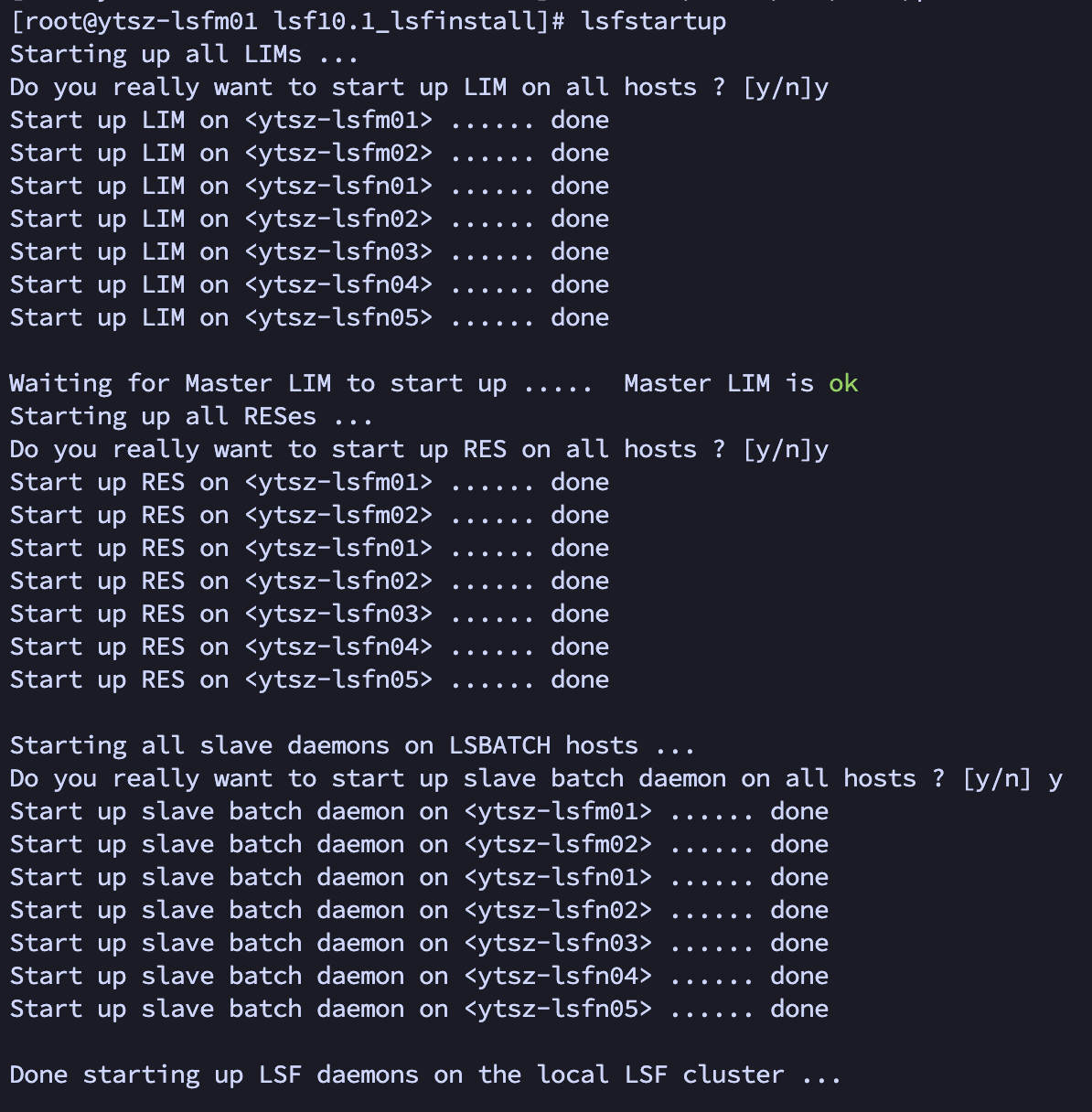

4.3 集群初始化与启动

# 所有节点(包括Master和计算节点)执行

/tools/lsf/10.1/install/hostsetup --top="/tools/lsf" --boot="y"

# 启动LSF集群

# 在主Master节点执行

lsfstartup

五、安装验证

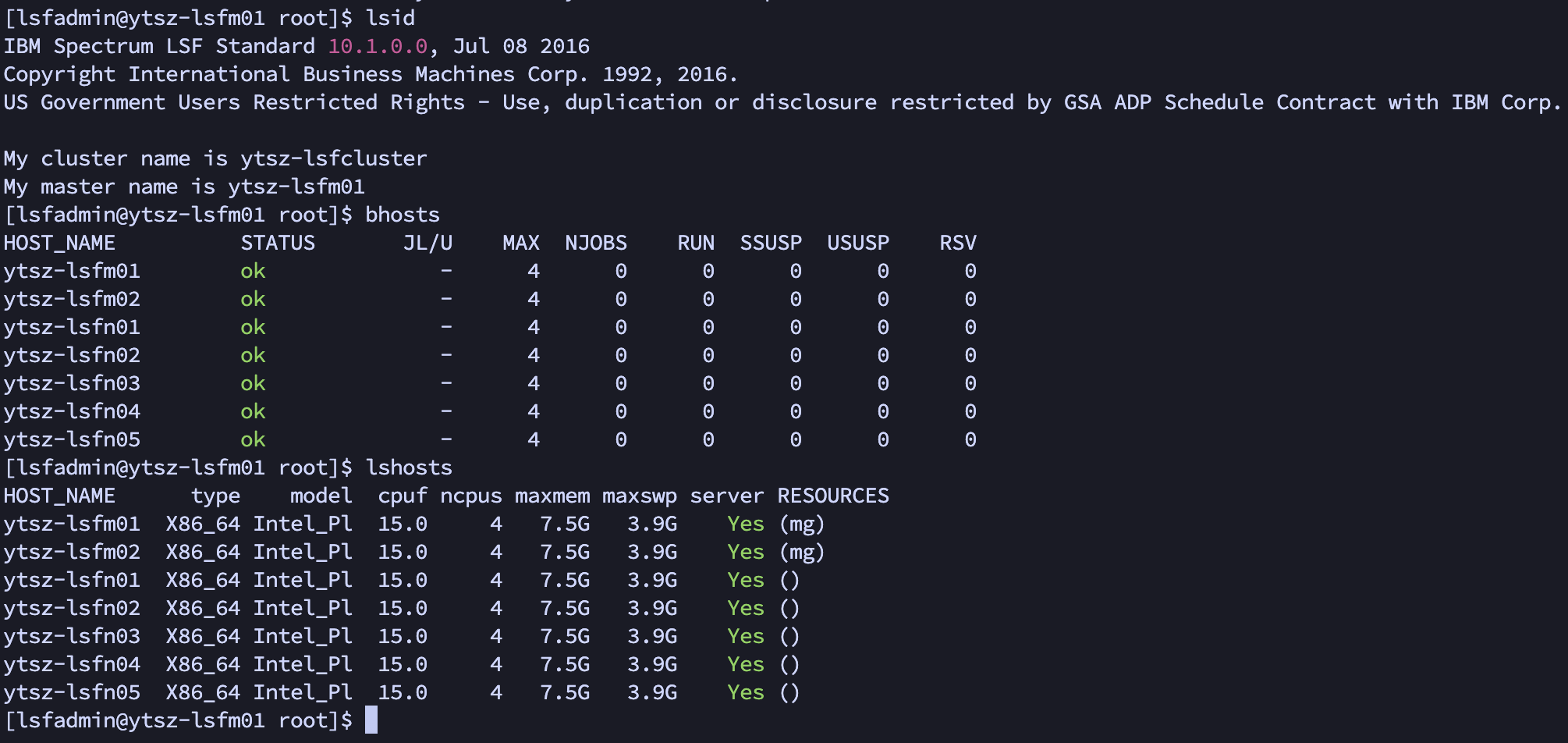

5.1 检查集群状态

# 显示集群名称和主Master信息

lsid

# 列出所有计算节点状态(正常应显示为 ok)

bhosts

# 显示节点静态资源信息

lshosts

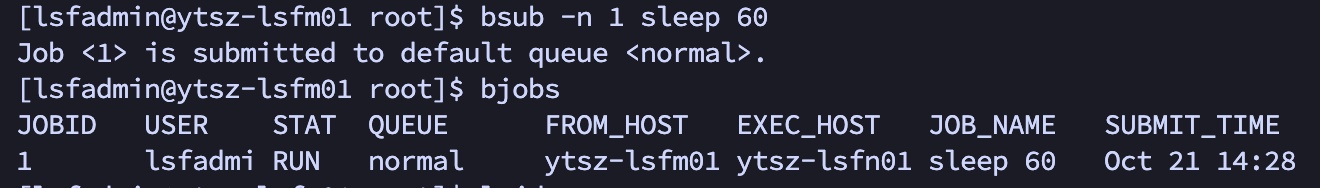

5.2 提交测试作业

# 提交简单测试作业

bsub -n 1 sleep 60

# 查看作业状态

bjobs

5.3 验证清单

-

lsid命令正常显示集群信息 -

bhosts显示所有计算节点状态为ok -

lshosts正确显示节点资源信息 -

测试作业能够正常提交和执行

-

bjobs能够正确显示作业状态

文档信息

版本: v1.0

适用环境: 生产环境

最后更新: 2024年10月

注意事项: 生产环境建议使用专用存储服务器替代NFS ,和活动目录统一管理计算机账户。

1255

1255

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?