点击下方卡片,关注“大模型之心Tech”公众号

在大语言模型(LLM)的发展赛道上,闭源与开源阵营的实力差距曾一度呈现扩大态势。随着OpenAI等巨头持续加码算力与数据投入,其闭源模型在复杂推理、工具使用等核心能力上不断突破;而开源社区虽不乏创新尝试,但受限于架构效率、训练资源等多重因素,在高端任务场景中始终难以望其项背。这种不平衡的发展格局,让业界对开源模型的上限充满疑虑——开源LLM是否注定只能成为闭源模型的"简化版替代品"?

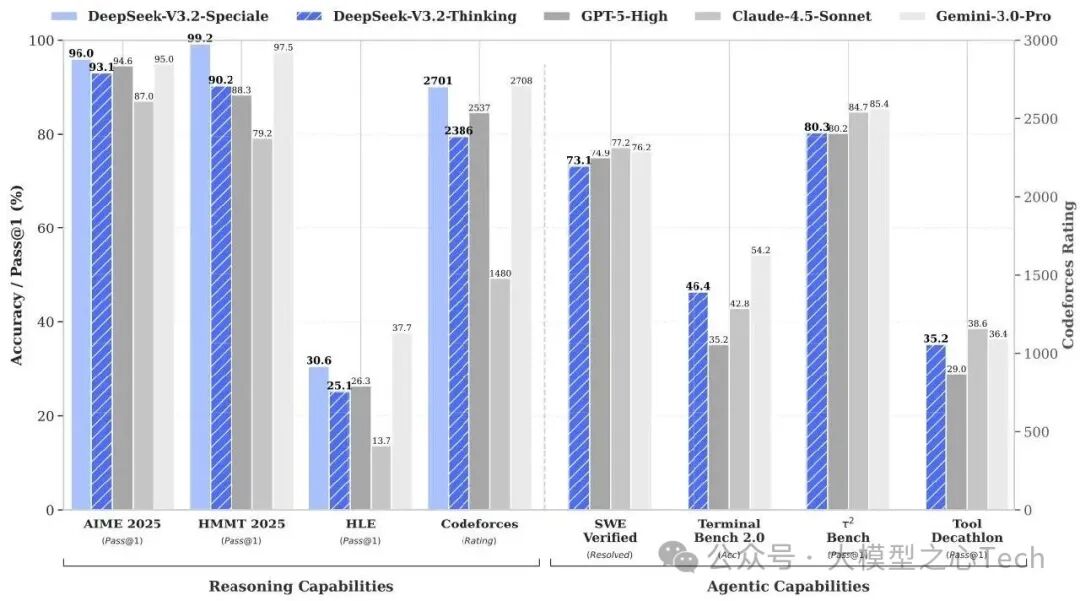

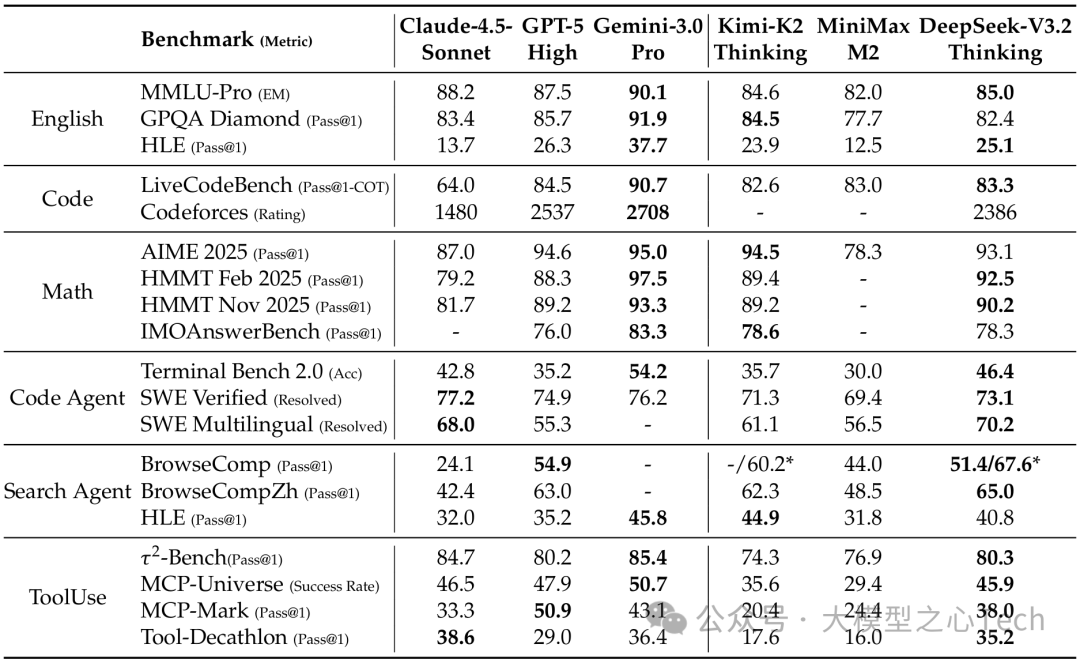

面对这一趋势,DeepSeek团队并未止步,而是通过系统性技术创新,推出了DeepSeek-V3.2。这款兼顾计算效率、推理能力与智能体性能的开源大语言模型,通过三大核心技术突破,不仅在多项权威基准测试中追平GPT-5等强力闭源模型,其高性能变体更在国际数学奥林匹克(IMO)、国际信息学奥林匹克(IOI) 等顶级赛事中斩获金牌,为开源模型的发展树立了新的里程碑。

论文链接:https://arxiv.org/pdf/2512.02556

开源模型的三大痛点

要理解DeepSeek-V3.2的突破性,首先需要正视当前开源模型普遍面临的三大核心困境。

从架构层面看,传统开源模型大多依赖标准注意力机制(vanilla attention) ,这种机制在处理长序列文本时,计算复杂度会随序列长度的平方增长(O(L²)),不仅导致推理速度缓慢,更限制了模型在长上下文场景中的部署与后续训练优化。

在资源分配上,闭源模型往往会投入巨额算力用于后训练(post-training) ,而开源模型受限于成本,后续训练阶段的算力投入普遍不足,这直接导致其在数学推理、代码生成等硬核任务上的性能难以提升。

在智能体能力方面,开源模型在工具使用、场景泛化和指令遵循等关键指标上,与闭源模型存在明显差距。复杂的现实环境要求模型具备灵活调用工具、适应多样化任务的能力,而开源模型此前缺乏系统性的训练方案支撑这种能力的落地。

针对这三大痛点,DeepSeek-V3.2团队提出了针对性的破局方案:通过创新注意力机制解决效率问题,通过加大后训练算力投入提升硬核性能,通过大规模智能体任务合成 pipeline 强化工具使用与泛化能力。三大技术路径相互支撑,共同构建起模型的核心竞争力。

核心技术解析

DeepSeek稀疏注意力(DSA)

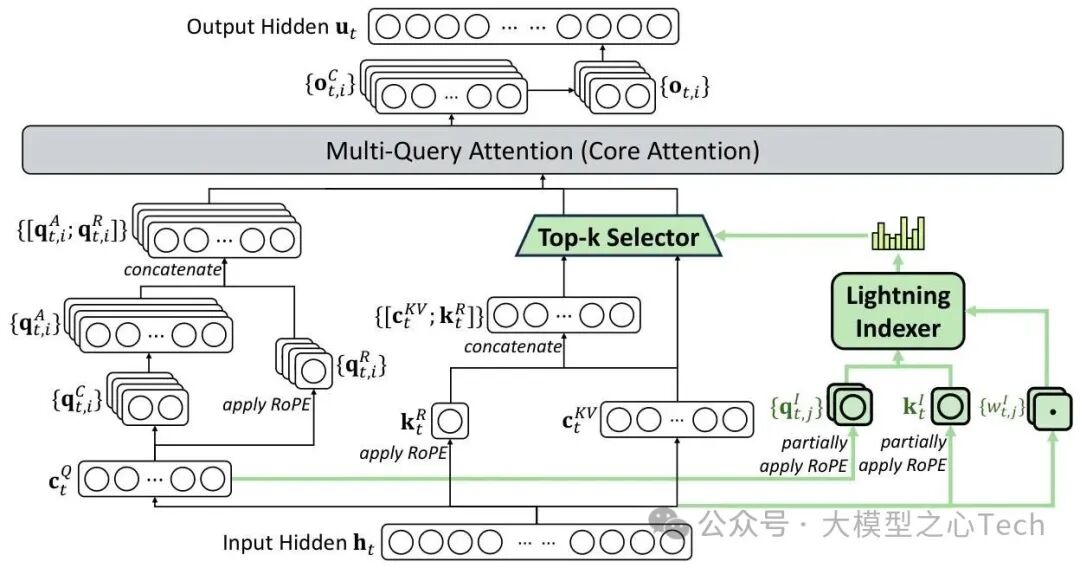

DeepSeek-V3.2最关键的架构创新,是引入了DeepSeek稀疏注意力(DSA)机制。

与传统稠密注意力不同,DSA通过"lightning indexer(闪电索引器)+fine-grained token selection(细粒度token选择)"的双组件设计,在保持模型性能的同时,将核心注意力计算复杂度从O(L²)降至O(Lk)(k为选中的token数,远小于序列长度L)。

闪电索引器

闪电索引器的核心作用是快速计算查询令牌与前文所有令牌的相关性得分,为后续筛选提供依据。其设计充分兼顾了效率与准确性:一方面,索引器仅设置少量索引头(H¹),且采用FP8精度进行计算,相较于传统注意力机制的FP16/FP32精度,计算量显著降低;另一方面,通过特定的计算逻辑生成索引得分Iₜ,ₛ,公式如下:

其中,qₜ,ⱼ¹和wₜ,ⱼ¹由查询令牌hₜ衍生而来,kₛ¹由前文令牌hₛ衍生,ReLU激活函数的选择进一步优化了计算吞吐量。这种轻量化设计让闪电索引器在保持相关性判断准确性的同时,实现了极高的计算效率。

细粒度token选择

在得到索引得分Iₜ,ₛ后,细粒度token选择机制会筛选出Top-k得分对应的键值条目(cₛ),仅让查询令牌hₜ与这些核心条目进行注意力计算,最终生成注意力输出uₜ,公式为:

这一过程避免了传统稠密注意力中大量无效的低相关性计算,同时通过Top-k的动态筛选确保核心语义关联不丢失。对于128K长度的长序列,k值通常设置为2048,仅需处理传统计算量的1.6%(2048/128000),效率提升极为显著。

基于MLA架构的实例化与两阶段训练

为确保与现有模型架构的兼容性,DSA基于DeepSeek团队此前提出的MLA(Multi-Level Attention)架构,采用多查询注意力(MQA)模式实现——每个潜在向量(MLA的键值条目)可被查询令牌的所有查询头共享,进一步优化了计算资源利用率。

DSA的训练分为两个关键阶段:

密集预热阶段:保留稠密注意力机制,冻结模型其他参数,仅训练闪电索引器。通过聚合所有注意力头的得分并进行L1归一化,生成目标分布pₜ,:,再以KL散度损失(ℒ¹)训练索引器,使其输出与目标分布对齐,确保索引得分的可靠性;

稀疏训练阶段:引入细粒度token选择机制,解冻所有模型参数,让整个模型适应稀疏注意力模式。此时KL散度损失仅针对选中的令牌集合Sₜ计算,同时将索引器输入从计算图中分离,确保索引器与主模型的优化互不干扰。

最终,DSA在长上下文任务中实现了端到端的显著提速,且在短文本任务上未出现性能退化,完美解决了传统模型"长序列效率低、短序列性能折损"的两难问题。

2. 可扩展强化学习框架:算力驱动的性能跃升

如果说DSA解决了"跑得动"的问题,那么可扩展强化学习(RL)框架则是DeepSeek-V3.2"跑得好"的核心保障。不同于多数开源模型后续训练算力投入不足的现状,DeepSeek-V3.2将后续训练的算力预算提升至预训练成本的10%以上,通过稳定的训练框架充分释放算力价值,实现了推理性能的跨越式提升。

核心算法:GRPO

模型仍然采用前序DeepSeek系列的GRPO算法作为强化学习的核心框架。

四大优化策略

为应对大算力投入下的训练震荡问题,团队提出了四大关键优化策略:

无偏KL估计:修正传统K3估计器的系统误差,通过新旧策略的重要性采样比调整KL散度计算,确保梯度更新无偏,避免低概率令牌导致的梯度爆炸;

离策略序列掩码:引入二进制掩码Mᵢ,ₜ,过滤掉优势值为负且策略分歧超过阈值δ的序列,避免高分歧负样本对训练的干扰。

保持路由机制:对于MoE(混合专家)模型,保留推理阶段的专家路由路径,确保训练与推理时的专家激活一致性,避免参数 subspace 突变导致的训练不稳定;

保持采样掩码:保留π_old采样时使用的top-p/top-k截断掩码,确保π_θ与π_old的动作空间一致,维护重要性采样的有效性,同时避免低概率令牌影响样本质量。

变体优化

为探索推理能力的上限,团队推出了高性能变体DeepSeek-V3.2-Speciale:在训练中仅使用推理类数据,降低长度惩罚系数,同时融入DeepSeekMath-V2的数学证明数据集与奖励方法,强化复杂推理能力。通过这一系列优化,该变体在IMO 2025、IOI 2025、ICPC世界总决赛2025等顶级赛事中均斩获金牌,性能比肩Gemini-3.0-Pro,成为首个在国际顶级竞赛中达到金牌水平的开源模型。

大规模智能体任务合成

智能体能力的短板,一直是开源模型落地的主要障碍。DeepSeek-V3.2通过"冷启动+大规模任务合成"的两步策略,系统性提升了模型在工具使用场景中的泛化能力与指令遵循性。

冷启动阶段

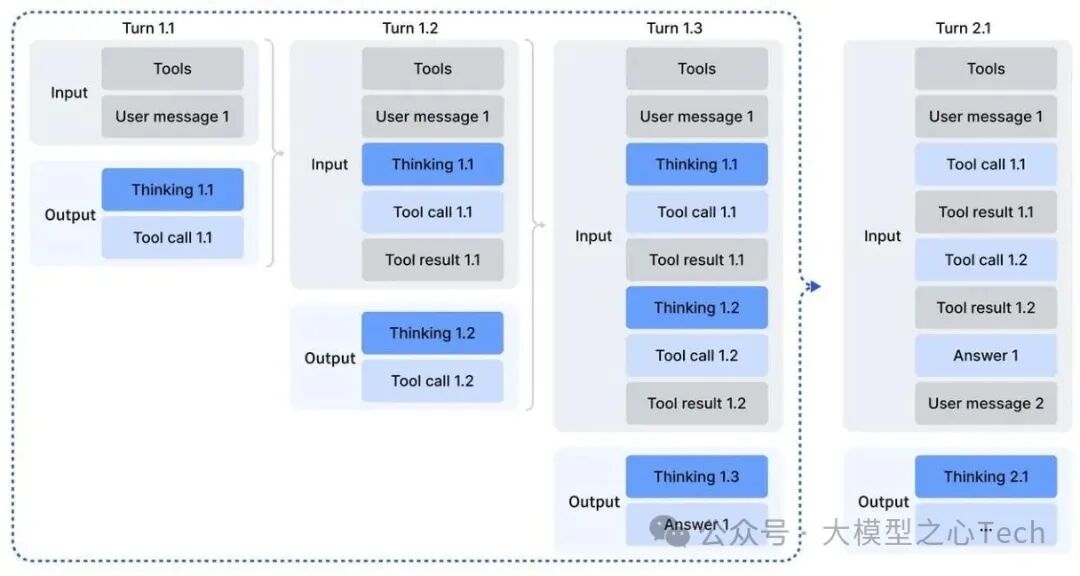

冷启动阶段的目标是将模型的推理能力与工具使用能力在训练初期进行对齐和融合,为后续的大规模强化学习奠定基础。

核心方法:

利用DeepSeek-V3方法论:在初始阶段,采用DeepSeek-V3(DeepSeek-AI, 2024)的方法,将推理过程与工具调用统一在单条训练轨迹中。

提示工程引导:通过精心设计的系统提示(System Prompt),明确指示模型在思考过程中嵌入工具调用。例如:

在推理任务中,系统提示要求模型在

<think>标签内进行思考,并允许在思考过程中多次调用Python解释器等工具(见表8)。在非推理的智能体任务中,系统提示直接提供工具描述和调用格式,指导模型执行工具调用(见表7)。

数据混合采样:从已有的推理数据(非智能体)和非推理的智能体数据中采样,通过提示设计促使模型学会在推理中自然调用工具。

冷启动的意义:

尽管这种方式生成的轨迹在工具使用模式上可能缺乏鲁棒性,但模型已初步学会在推理过程中调用工具,为后续大规模强化学习提供了高质量的初始策略。

实现了从“纯推理”和“纯工具调用”到“推理驱动型工具使用”的能力过渡。

大规模智能体任务合成阶段

为了克服真实用户交互数据稀缺、成本高的问题,团队构建了一个自动化的智能体任务合成流水线,生成了大规模、多样化、高质量的智能体训练数据。

合成流水线的核心工作流程如下:

环境与工具集构建:给定一个任务类别(例如“旅行规划”),智能体在沙盒环境中使用Bash和搜索工具,从互联网生成或检索相关数据,并存入沙盒数据库。

任务特定工具合成:智能体根据任务需求,合成一组特定的工具函数(例如,

get_all_hotels_by_city,get_weather_by_city_date等)。任务与解决方案协同生成:

智能体基于当前数据库,提出一个初始任务及其解决方案(用Python实现的解决函数)和验证函数。

关键约束:解决函数只能调用工具函数或进行逻辑计算,不能直接访问数据库或其他函数,确保任务必须通过工具接口解决。

解决方案的输出必须能通过验证函数的检验。如果验证失败,智能体会迭代修改解决方案或验证函数,直至通过。

智能体随后逐步提升任务难度,并同步更新解决方案和验证函数。如果现有工具集不足以解决新任务,则会自动扩展工具集。

各类型智能体任务的具体构建方法如下:

搜索智能体:采用基于DeepSeek-V3.2的多智能体管道。

实体采样:从大规模网络语料中采样多样化的长尾实体。

问题构建:使用搜索工具探索实体,整合信息生成问答对。

答案生成:多个异构配置的答案生成智能体为每个QA对生成多样候选答案。

验证过滤:具备搜索能力的验证智能体多轮验证答案,仅保留事实正确且所有候选答案均被验证为错误的样本。

数据混合:补充来自现有RL数据集的过滤样本,确保数据兼具事实可靠性和实际帮助性。

代码智能体:

数据挖掘:从GitHub挖掘数百万个Issue-Pull Request对。

环境构建:使用DeepSeek-V3.2驱动的自动化环境设置智能体,为每个高质量Issue-PR对构建可执行环境(处理安装、依赖、测试)。

成功标准:仅当应用“黄金补丁”后,测试结果出现“假阳转真阳”(F2P)且无“真阳转假阳”(P2F)时,环境才被视为构建成功。

成果:成功构建了涵盖Python、Java、JavaScript等多语言的数万个可复现问题解决环境。

代码解释器智能体:使用Jupyter Notebook作为代码解释器,针对数学、逻辑、数据科学等需要代码执行能力的复杂推理任务进行训练。

策略成效

提供丰富的训练信号:大规模、结构化的合成任务为强化学习提供了海量、高质量的训练数据,驱动模型在复杂、交互式环境中学习有效的工具使用策略。

增强泛化性:在MCP-Universe、MCP-Mark等未见过的工具使用基准测试中,DeepSeek-V3.2表现出色,证明了其能将推理策略泛化到域外的智能体场景。

提升指令遵循鲁棒性:通过在不同环境、工具集和任务约束下的训练,模型学会了更精确地理解并遵循复杂、多步骤的指令。

成本效益高:与闭源前沿模型相比,DeepSeek-V3.2以显著更低的成本,在智能体场景中大幅缩小了性能差距,成为高效的替代方案。

结论:通过“冷启动”奠定能力基础,再通过“大规模任务合成”实现能力扩展与强化,DeepSeek-V3.2成功构建了一套可扩展的智能体后训练方法学。这不仅系统性提升了模型在工具使用场景中的性能,也为开源大语言模型在真实、复杂环境中的部署和应用提供了新的可能性。

工具调用场景下的思维保留机制。 实测表现

在多项权威基准测试中,DeepSeek-V3.2的表现充分印证了其技术方案的有效性。

DeepSeek-V3.2 与闭源 / 开源模型的对比。 在推理能力方面,模型在MMLU-Pro(85.0)、GPQA Diamond(82.4) 等通用基准上与GPT-5-High水平相当;在数学领域,AIME 2025通过率达93.1%,HMMT 2025二月赛通过率92.5% ,均处于开源模型前列。

代码能力方面,DeepSeek-V3.2在LiveCodeBench的COT模式下通过率83.3% ,Codeforces评级达2386分,在SWE-Verified(软件工程师验证基准)中解决率73.1% ,显著优于其他开源模型,具备支撑真实软件开发场景的潜力。

工具使用能力是模型的另一大亮点。在中文搜索基准BrowseCompZh中通过率达65.0% ;在τ²-bench(多领域对话智能体基准)中通过率80.3% ,在MCP-Universe(真实世界模型上下文协议基准)中成功率45.9% ,大幅缩小了与闭源模型的差距。

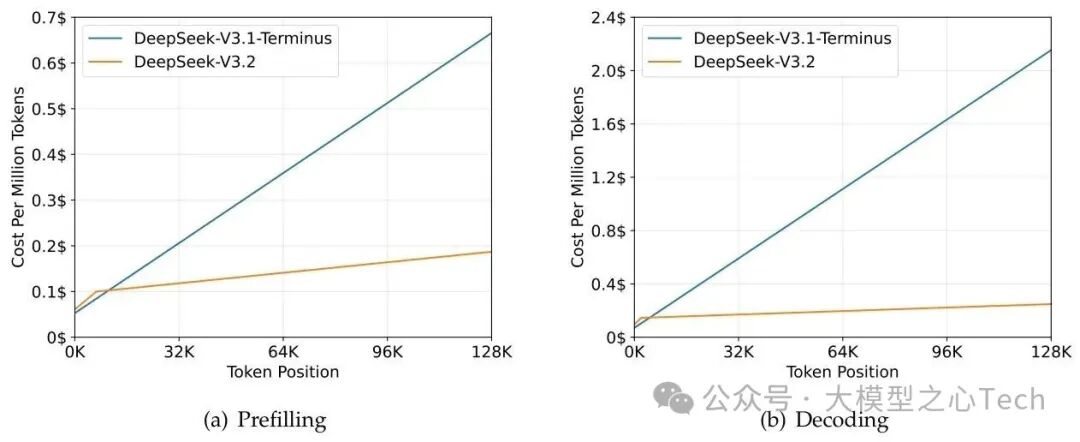

值得注意的是,DeepSeek-V3.2在保持高性能的同时,展现出优异的成本效率。通过DSA机制,模型在H800 GPU上的推理成本显著低于前代产品,长序列解码时的成本优势尤为明显,为大规模部署提供了可行性。

总结

DeepSeek-V3.2的发布,不仅填补了开源模型在高端推理与智能体能力上的短板,更证明了开源模型通过架构创新、算力投入与数据工程的结合,完全有能力挑战闭源模型的主导地位。其三大核心技术突破各有侧重:DSA机制解决了长上下文效率的关键瓶颈,可扩展RL框架释放了算力的价值,大规模智能体任务合成则打通了技术落地的最后一公里。

在大模型技术日趋成熟的今天,DeepSeek-V3.2的出现再次证明:开源与闭源并非零和博弈,而是推动技术进步的双轮。随着开源模型在核心能力上的持续追赶,整个行业将迎来更加多元、健康的发展生态。

104

104

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?