点击下方卡片,关注“自动驾驶之心”公众号

戳我-> 领取自动驾驶近15个方向学习路线

今天自动驾驶之心为大家分享香港科技大学最新多传感器融合的工作BiCo-Fusion!在Lidar-Camera 3D目标检测上取得了新SOTA!如果您有相关工作需要分享,请在文末联系我们!

自动驾驶课程学习与技术交流群事宜,也欢迎添加小助理微信AIDriver004做进一步咨询

论文作者 | Yang Song等

编辑 | 自动驾驶之心

写在前面&笔者的个人理解

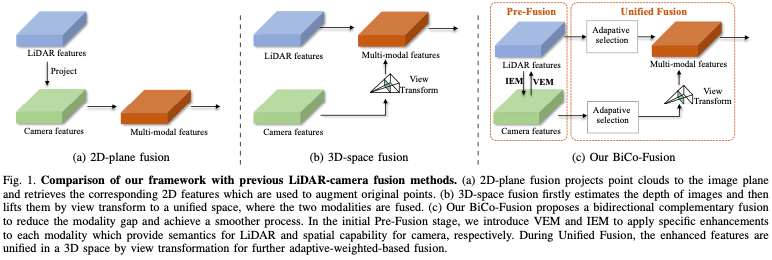

3D目标检测是自动驾驶领域中广泛应用的一项重要任务。近期合并多模态输入,即激光雷达和相机数据,已成为一种新趋势。然而,现有的方法要么忽略了激光雷达特征的稀疏性,要么由于模态间隙而无法同时保持激光雷达的原始空间结构和相机特征的语义密度。为了解决这些问题,本文提出了一种新的双向互补激光雷达相机融合框架,称为BiCo-Fusion ,可以实现鲁棒的语义和空间感知的3D目标检测。关键的点是将多模态特征相互融合,以增强激光雷达特征的语义和相机特征的空间感知,并从两种模态中自适应地选择特征,从而构建统一的3D表示。具体而言,我们引入了预融合,该预融合由体素增强模块(VEM)和图像增强模块(IEM)组成,前者用于增强2D相机特征中体素特征的语义,后者用于增强3D体素特征中相机特征的空间特征。VEM和IEM都是双向更新的,以有效减少模态差距。然后,我们引入统一融合自适应加权,从迷人的激光雷达和相机特征中选择特征,以构建统一的3D表示。大量实验证明了我们的BiCo-Fusion相对于现有技术的优越性。

项目主页:https://t-ys.github.io/BiCo-Fusion/

在nuScenes基准上进行的大量实验表明,我们的BiCo-Fusion方法实现了最先进的(SoTA)性能,在测试集上具有72.4%的mAP和74.5%的NDS。总之,我们的贡献有三个方面:

(I)我们提出了一种新的用于3D目标检测任务的多模态融合框架,采用双向互补的激光雷达相机融合来保留来自激光雷达的空间结构和来自相机的语义,这减少了模态间隙,允许更全面的3D表示;

(II) 我们提出了使用VEM的预融合来增强体素的语义,使用IEM来增强相机数据的空间感知,以及使用统一融合来自适应地统一3D体素空间中的表示;

(III) 我们在具有挑战性的nuScenes数据集上实现了SOTA 3D检测性能。

相关工作回顾

基于激光雷达的3D目标检测。激光雷达点云本质上适合于3D目标检测,因为它们可以提供准确的3D空间信息。然而点云数据是稀疏、无序和冗余的,这导致点云数据无法直接输入CNN网络进行特征提取。PointNet是第一个能够提取点云特征的主干,此后,人们提出了许多后续工作,例如。后来为了获得更规则的点云数据,研究人员选择将点云数据光栅化为离散的网格表示,如体素和柱。这些方法能够使用卷积网络进行直接特征提取。然而,它们无法打破使用单一模态的限制,并且在特殊情况下(如小物体和远处物体)由于语义缺失而导致错误检测。相反,我们的方法同时使用激光雷达和相机数据,并可变地融合多模态特征,以增强激光雷达特征的语义和相机特征的空间感知。

基于激光雷达相机融合的3D目标检测。这已经成为一种新趋势,致力于最大限度地利用这两个世界。早期的作品通常使用投影策略来检索用于装饰点云的图像特征。PointPainting是通过将图像的语义分割标签投影到点云空间来增强语义能力的开创性工作。而MV3D将3D方案投影到2D平面中,用于连接两种模态。TransFusion使用注意力机制将相关图像特征选择性地融合到点云。得益于lift splat shoot(LSS),最近的研究工作主要基于它将相机特征转换到与LiDAR相同的统一空间中。BEVFusion提供了一种新的管道,将两种模式统一在鸟瞰图(BEV)空间中。而UVTR通过在体素空间中统一这两种模式来避免高度塌陷的错位效应。然而,由于模态间隙的存在,这些方法无法同时保持激光雷达的原始空间结构和相机特征的语义密度。相比之下,我们的BiCo Fusion提出了一种双向互补策略来相互融合多模态特征,以增强激光雷达特征的语义和相机特征的空间感知,并对其进行自适应加权,以构建统一的3D表示。

方法详解

框架概览

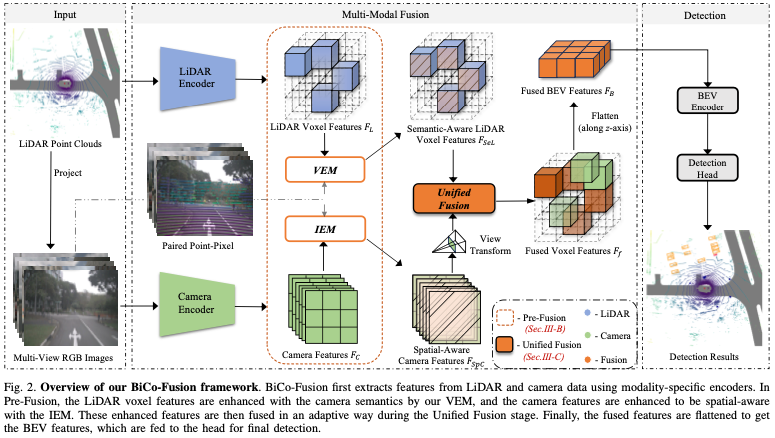

如图2所示,给定原始激光雷达和RGB相机数据作为输入,我们首先从特定编码器中提取特征。在BEVFusion之后,我们分别使用VoxelNet作为LiDAR编码器和Swin Transformer作为视觉编码器。

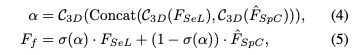

然后使用我们设计的方法,将提取的激光雷达体素特征FL和相机特征FC相互作用并融合。我们的多模式融合空间包含两个融合,在预融合阶段,我们的体素增强模块(VEM)和图像增强模块(IEM)对两种模式进行特定的双向互补增强,以提高体素的语义能力和图像的空间能力,有效地避免了弱表示带来的负面影响,也为下一步准备了更全面的特征。然后,在统一融合阶段(U-Fusion)中,通过视图变换将增强的空间感知相机特征FSpC提升到3D体素空间中,并以自适应的方式与语义感知激光雷达体素特征FSeL进一步融合。

最后,按照基于体素的方法的工作流程,我们折叠融合的体素特征Ff的高度,以便将它们转换到BEV空间中,然后BEV特征FB经过基于卷积的BEV编码器和检测头,以获得最终的3D检测结果。在UVTR之后,在训练期间应用匈牙利算法来匹配预测和地面实况。同时,Focal loss和L1 loss分别用于分类和3D边界框回归。

Pre-Fusion

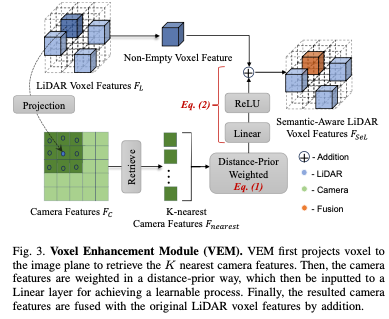

预融合由两个关键模块组成:VEM和IEM。这两个模块以双向互补的方式工作,以增强体素的语义和图像的空间特征。它缓解了激光雷达和相机的弱表示。同时它们的强表示被保留,从而允许更全面的3D表示。1)体素增强模块:尽管具有强大的空间定位能力,但从激光雷达分支获得的激光雷达体素特征FL缺乏重要的语义信息。这个缺点可以通过统一融合过程传播。为了克服这个问题并为统一融合提供更全面的功能,我们设计了VEM,如图3所示。

在VEM中,首先使用内外参将每个非空体素的中心点投影到图像坐标上。为了减少不正确的对齐,我们随后检索投影点周围的K个最近的相机特征。在融合过程中,这些相机特征的贡献应该是不同的,因此我们设计了一个距离优先加权方案。具体而言,对于K个相机特征,我们首先计算到投影点的距离的倒数,表示为Lnearest,其形成为Fnearest的权重。然后得到距离先验加权的相机特征Fweighted

最后,我们使用线性层和激活函数,然后进行加法,以实现可学习的融合过程,从而产生语义感知的体素特征,表示为FSeL。整个过程可以定义为:

2)图像增强模块:相机特征缺乏对三维空间信息的感知能力,这对三维物体检测任务至关重要。为了从这个角度增强它们,我们提出了IEM,如图4所示。我们首先将点云投影到图像平面上以获得稀疏深度图Dsparse。受[39]的启发,我们使用深度补全[40],然后进行特征提取,以获得密集的深度特征图Ddense。最后,我们将密集深度特征图与相机特征FC连接起来,并使用卷积层将它们融合,得到空间感知相机特征FSpC:

由于空间感知相机特征的几何能力,将其提升到3D空间可确保更准确的过程,为后续的统一融合奠定坚实的基础。

Unified Fusion

在获得语义感知的激光雷达体素特征和空间感知的相机特征后,我们在预融合过程中进行了特定的双向互补,并在U-Fusion阶段进一步融合它们,以确保语义和空间层面的强表示的完整性。

先前的工作通过视图变换将BEV空间中的两种模态统一起来。虽然这提高了效率,但它有一个固有的局限性,阻止了细粒度融合,而细粒度融合对更好的性能至关重要。因此,在将相机特征提升到体素表示后,我们保留其状态,从而获得F^SpC。

考虑到具有相同空间维度的激光雷达和相机的增强功能,一个简单的想法是直接将它们连接起来。受[41]的启发,为了从两种模态中动态选择特征,我们使用了一种自适应加权方法来执行统一融合,如下所示:

实验结果

主要结果

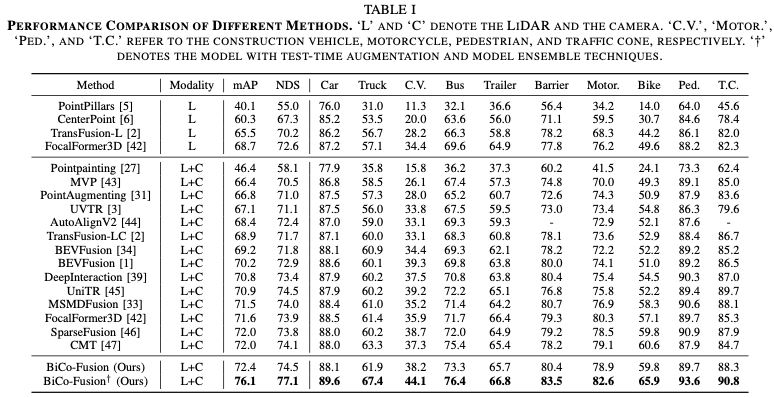

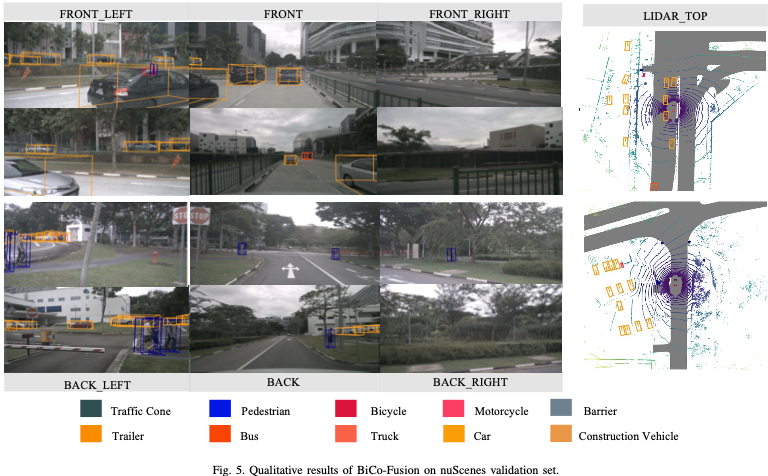

我们将我们的BiCo-Fusion与nuScenes测试集上的领先方法进行了比较,如表I所示。这表明,由于多模态的额外融合,BiCo-Fusion显著提高了仅激光雷达的基线TransFusion-L 6.9%的mAP和4.3%的NDS。更重要的是,与之前的作品相比,BiCo Fusion实现了卓越的性能,具有72.4%的mAP和74.5%的NDS。通过结合测试时间增强和模型集成技术,BiCo Fusion†进一步实现了最先进的(SOTA)性能。在图5中,我们还展示了nuScenes验证集的一些定性结果,这表明即使当小物体被遮挡或许多物体紧密堆积在一起时,我们的方法也可以检测到具有挑战性的情况。

消融实验

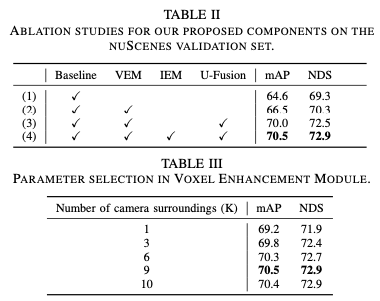

1)组合消融:如表II所示,我们对nuScenes验证集上的拟议模块进行消融研究。在表II(1)中,我们重新实现TransFusion-L作为我们的仅激光雷达基线。根据表II(2),在结合VEM后,我们将mAP和NDS分别提高了1.9%和1%,这表明了增强体素特征语义能力的有效性。此外,结合统一融合(U-Fusion)可进一步提高3.5%的mAP和2.2%的NDS(表II(3))。需要强调的是,与Unified Fusion的结合有助于实现如此大的改进,主要有两个原因:

a)预融合中的体素增强模块减少了模态间隙,为融合的第二步奠定了基础。

b) 统一体素空间中的融合填充了许多非空体素,补偿了激光雷达模态的几何稀疏性。最后,将所有这些成分组合在一起(表II(4)),最终的mAP和NDS分别实现了70.5%和72.9%的显著增强,这表明增强相机特征的空间能力可以进一步减少负面影响,并有助于确保强表示能够得到保持。

2)关于体素增强模块的讨论:我们分析了体素增强模型中每个体素(K)的周围相机特征数量的选择。如表III所示,当K从1增加到9时,mAP和NDS逐渐升高。当K增加到10时,NDS没有变化,但mAP降低,所以我们选择K=9作为框架。

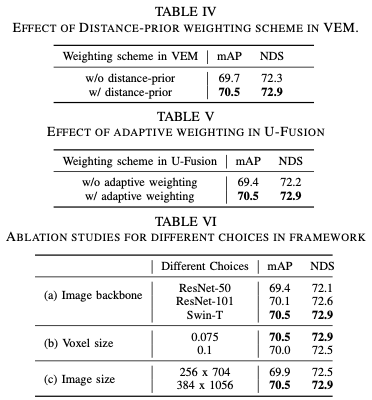

表IV展示了我们的距离先验加权方案在体素增强模块中的有效性,它分别将mAP和NDS提高了0.8%和0.6%。

3)关于统一融合的讨论:在统一融合(U-Fusion)中,我们使用自适应加权融合方法,该方法从两种模态中动态选择特征,以便在统一体素空间中进行融合。我们在表V中对其进行了消融,这表明与简单级联相比,我们的方案提高了1.1%的mAP和0.7%的NDS的性能。

4)框架中不同选择的消融:我们在BiCo-Fusion框架中进一步构建了不同选择的消融研究。如表VI(a)所示,我们的框架可以受益于更强大的图像主干。Swin-T实现了最佳性能,与ResNet相比,mAP提高了1.1%。表VI(b)表明,较小的体素大小可以带来小规模的改善,mAP和NDS都有约0.5%的改善。与体素大小相同,使用更大的图像分辨率(例如384×1056)也会带来轻微的性能改进,如 如表VI(c)所示。

结论

本文介绍了BiCo Fusion,这是一种新的框架,它采用双向互补的激光雷达相机融合策略来保持激光雷达的空间结构和相机的语义特征,确保减少用于鲁棒3D目标检测的模态间隙。我们引入了预融合和统一融合(U-Fusion)来增强激光雷达体素特征的语义和相机特征的空间能力,并在统一的体素空间中自适应地融合来自两种模态的增强特征。大量的实验证明了这些组件和我们提出的框架的有效性。

局限性和未来工作。目前,BiCo Fusion在Pre-Fusion中使用了一种简单的投影和检索机制,该机制依赖于nuScenes数据集上的对齐。我们相信,可以通过引入更柔和的注意力机制来更好地优化这一点,以避免一些校准不准确。此外,监督深度估计能够进一步增强相机分支的最终3D表示的空间结构,从而确保更好的性能。我们将这些限制留给未来的工作。

参考

[1] BiCo-Fusion: Bidirectional Complementary LiDAR-Camera Fusion for Semantic- and Spatial-Aware 3D Object Detection

投稿作者为『自动驾驶之心知识星球』特邀嘉宾,欢迎加入交流!

① 全网独家视频课程

BEV感知、BEV模型部署、BEV目标跟踪、毫米波雷达视觉融合、多传感器标定、多传感器融合、多模态3D目标检测、车道线检测、轨迹预测、在线高精地图、世界模型、点云3D目标检测、目标跟踪、Occupancy、cuda与TensorRT模型部署、大模型与自动驾驶、Nerf、语义分割、自动驾驶仿真、传感器部署、决策规划、轨迹预测等多个方向学习视频(扫码即可学习)

网页端官网:www.zdjszx.com

网页端官网:www.zdjszx.com

② 国内首个自动驾驶学习社区

国内最大最专业,近3000人的交流社区,已得到大多数自动驾驶公司的认可!涉及30+自动驾驶技术栈学习路线,从0到一带你入门自动驾驶感知(2D/3D检测、语义分割、车道线、BEV感知、Occupancy、多传感器融合、多传感器标定、目标跟踪)、自动驾驶定位建图(SLAM、高精地图、局部在线地图)、自动驾驶规划控制/轨迹预测等领域技术方案、大模型、端到端等,更有行业动态和岗位发布!欢迎扫描下方二维码,加入自动驾驶之心知识星球,这是一个真正有干货的地方,与领域大佬交流入门、学习、工作、跳槽上的各类难题,日常分享论文+代码+视频

③【自动驾驶之心】技术交流群

自动驾驶之心是首个自动驾驶开发者社区,聚焦感知、定位、融合、规控、标定、端到端、仿真、产品经理、自动驾驶开发、自动标注与数据闭环多个方向,目前近60+技术交流群,欢迎加入!扫码添加汽车人助理微信邀请入群,备注:学校/公司+方向+昵称(快速入群方式)

④【自动驾驶之心】全平台矩阵

BiCo-Fusion:3D目标检测新突破

BiCo-Fusion:3D目标检测新突破

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?