提示:文章写完后,目录可以自动生成,如何生成可参考右边的帮助文档

目录

创新点

1.用最小二乘拟合模块代替大多数深度完井网络中使用的最后1×1卷积层

2.使用了非线性最小二乘法,处理实际数据中的噪声测量和异常值

一、文章概述

主要是替换了多变单通道的卷积层

二、方法详解

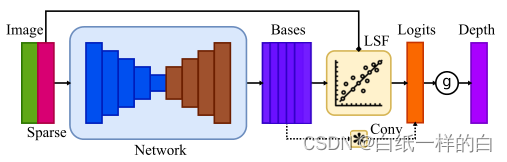

1.网络结构

实线表示模块的数据流,而虚线表示基线方法的数据流。baseline只是一个卷积层。我们的LSF模块可以取代卷积层,而不改变网络的其余部分。

2.具体方法

线性最小二乘法拟合模块(LSF)

*最小二乘法对异常值很敏感

模块输入多通道的特征和稀疏深度,输出单通道的结果L,一般深度估计网络最后卷积层把多通道的特征B转换为单通道结果L,称为logits层,最后一层的输入范围较大,使用非线性激活函数g将值映射到正深度,本文选择的g为

![]()

a控制最小深度的比例因子,设为1

该文章提出了用最小二乘拟合模块替换深度网络中的1×1卷积层,以处理噪声和异常值。网络结构中,LSF模块接收多通道特征并输出单通道深度,利用非线性最小二乘法解决拟合问题。通过自监督的多尺度训练,提高了深度估计的准确性。这种方法通过动态权重调整,减少了对固定权重的依赖,增强了网络的适应性。

该文章提出了用最小二乘拟合模块替换深度网络中的1×1卷积层,以处理噪声和异常值。网络结构中,LSF模块接收多通道特征并输出单通道深度,利用非线性最小二乘法解决拟合问题。通过自监督的多尺度训练,提高了深度估计的准确性。这种方法通过动态权重调整,减少了对固定权重的依赖,增强了网络的适应性。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

995

995

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?