本文来源于阿里云-云栖社区,原文点击这里。

DeepMind与来自普林斯顿、NYU、达特茅斯学院、UCL和哈佛大学的研究人员合作,探索了人类行为中的强化学习,为开发智能体强化学习提供了新的策略。

研究人员具体探讨了一种存在于无模型和基于模型的学习算法之间的方法,基于后继表示(successor representation,SR),将长期状态预测存入缓存中。作者预计,这些发现将为计算科学、电生理学和神经影像学研究开辟新的途径去研究评估机制的神经基础。相关论文《The successor representation in human reinforcement learning》日前在Nature子刊《自然-人类行为》上发表。

人类和其他动物在不断变化的环境中适时适机进行决策,这底层的算法是什么?发现其中的机制对于完成序列决策(比如国际象棋和迷宫导航)尤其重要。

过去20年,大部分致力于解决多步骤问题的研究,都关注强化学习(RL)的两类算法,即无模型(MF)和基于模型的(MB)算法。

MF和BM都将决策形式化为长期奖励预期与不同的候选行动之间的关系,但在表示(representation)和计算方面却不尽相同。

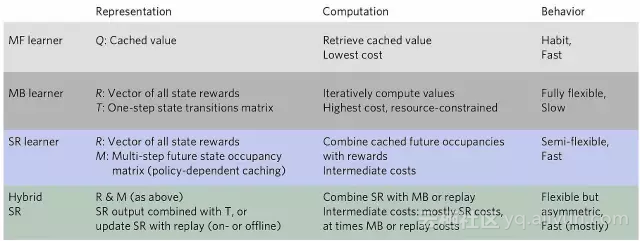

突1:无模型、基于模型和基于后继表示的学习算法在表示、计算和行为上的特点对比。来源:论文

MF vs. MB两者的对立使人产生了这样一种观点,那就是在决策的速度和准确性之间有明显的tradeoff:MF将预计算长期行动值直接存储起来,而MB算法则更加灵活,会通过对短期环境的建模来重估行动值,但这样对计算力有更大需求。

长期以来,由于这种速度和精度之间的tradeoff,人们一直以为要实现自主化、仔细思考(deliberation)和控制,需要消耗很多计算资源。同时,MF也被视为适应不良习惯和强迫行为(比如吸毒)的原因。

尽管有实验证明人类和其他动物在某些情况下的决策能够彻底打败MF选择,但极少有证据表明人类大脑是如何进行MB重计算的,甚至人类大脑究竟有没有进行MB重计算。

DeepMind与多所高校合作,提出结合无模型和基于模型学习算法的后继表示方法,该方法可在缓存中存储长期状态预测,为研究决策机制提供新思路。

DeepMind与多所高校合作,提出结合无模型和基于模型学习算法的后继表示方法,该方法可在缓存中存储长期状态预测,为研究决策机制提供新思路。

2352

2352

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?