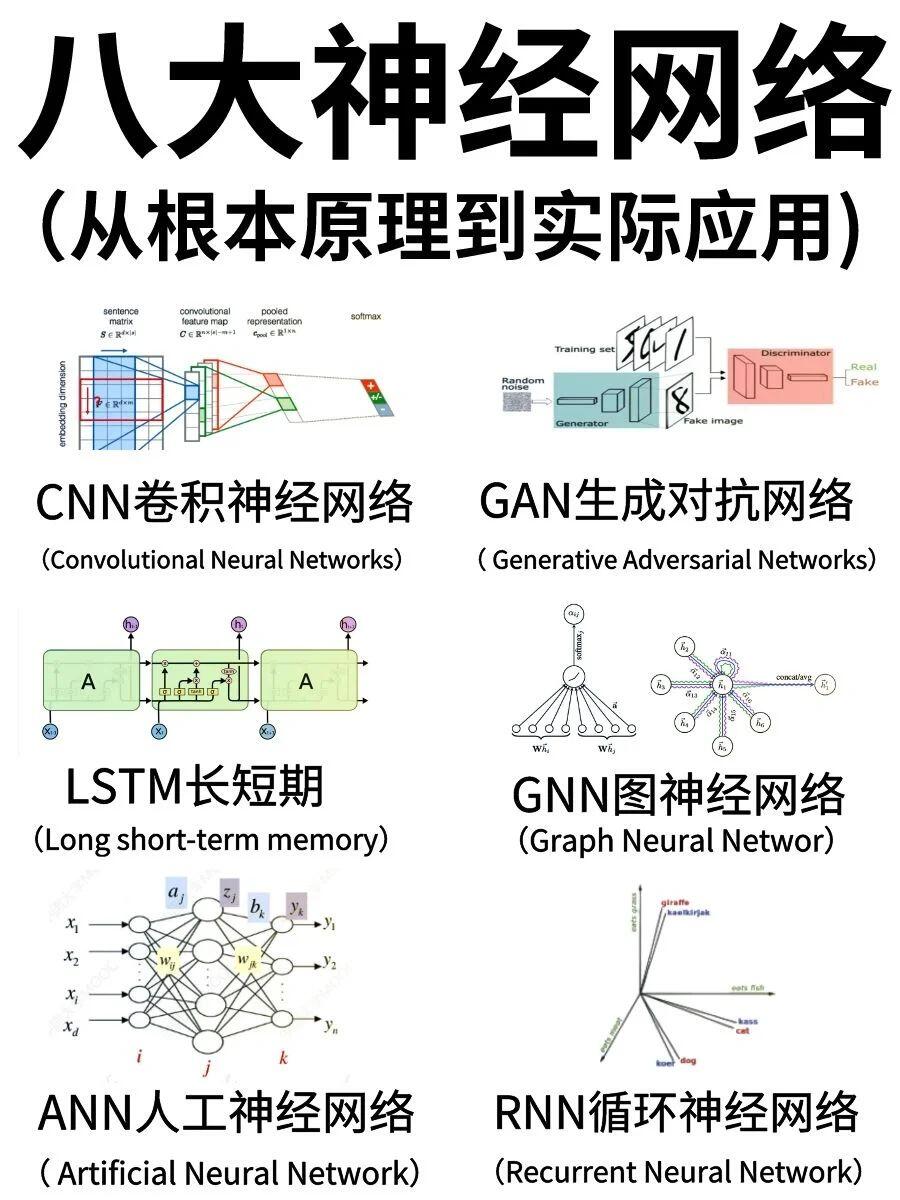

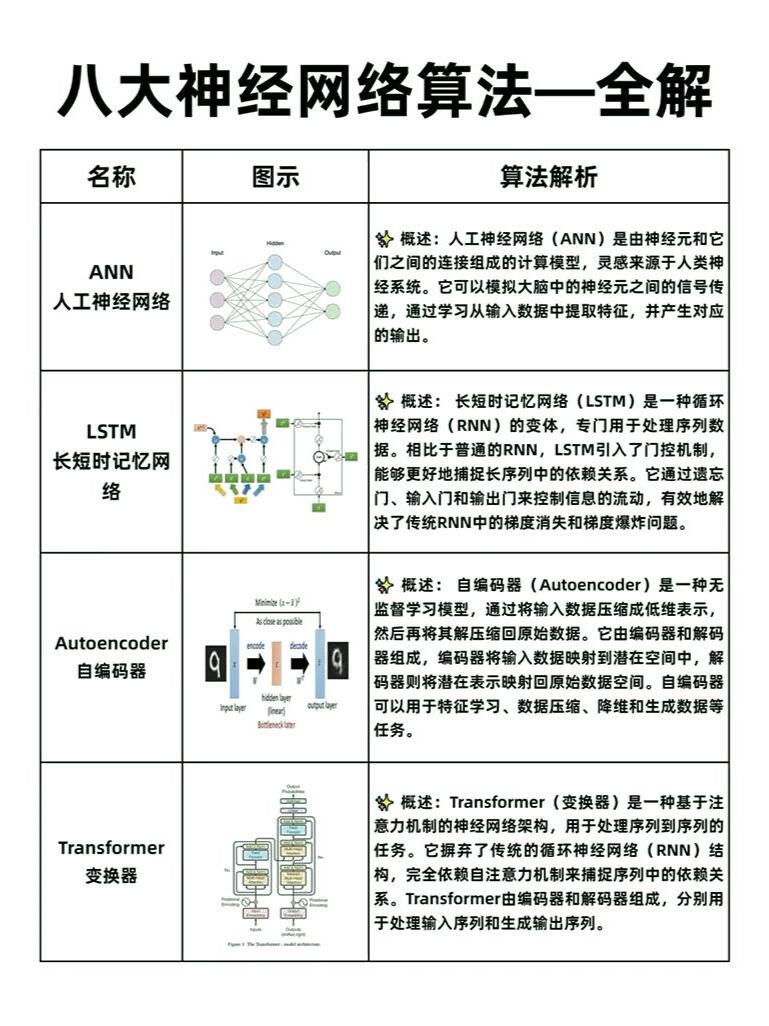

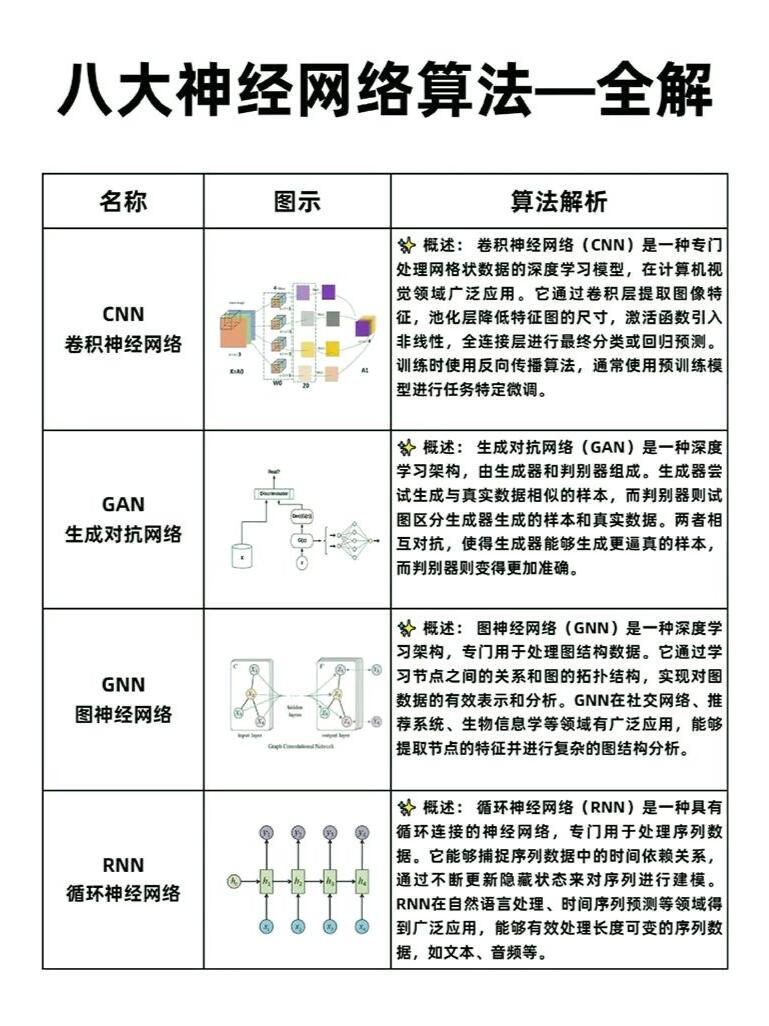

1. 卷积神经网络(Convolutional Neural Networks, CNN)

核心机制:

- 空间特征提取:通过局部感受野(Local Receptive Field)、权值共享(Weight Sharing)及下采样(Pooling)实现空间不变性特征学习

- 层次化特征表示:低层提取边缘/纹理特征,高层捕获语义信息

典型应用:

- 图像分类(ImageNet挑战赛冠军模型:AlexNet/ResNet)

- 目标检测(YOLO系列:单阶段实时检测)

- 医学影像分析(如U-Net用于医学分割)

关键技术演进:

- LeNet-5(1998):首个卷积网络,验证CNN在MNIST手写数字识别的有效性

- AlexNet(2012):引入ReLU激活、Dropout正则化及GPU加速训练

- ResNet(2015):残差连接(Residual Connection)突破深度网络训练瓶颈

- 现代优化:空洞卷积(Dilated Convolution)、深度可分离卷积(Depthwise Separable Convolution)、注意力机制(如CBAM)

2. 循环神经网络(Recurrent Neural Networks, RNN)

核心机制:

- 时间序列建模:通过隐藏状态(Hidden State)传递历史信息,实现短期记忆能力

- 梯度传播:采用BPTT(Backpropagation Through Time)算法优化

典型应用:

- 文本生成(GPT系列)、时间序列预测(LSTM-FCN)、语音识别(DeepSpeech)

关键模型改进:

- LSTM(1997):引入输入门、遗忘门、输出门控制信息流

- GRU(2014):简化LSTM结构,合并遗忘门与输入门

局限性与替代:

- 并行计算效率低(需按时间步展开)

- 被Transformer架构逐步取代(如BERT在NLP领域的主导地位)

3. 生成对抗网络(Generative Adversarial Networks, GAN)

核心机制:

- 对抗训练:生成器(Generator)与判别器(Discriminator)通过零和博弈优化数据分布

- 损失函数演进:从原始GAN的最小化JS散度到WGAN的Wasserstein距离

典型应用:

- 图像生成(StyleGAN系列)、数据增强(如医学影像数据扩增)

- 跨模态生成(CycleGAN实现无配对数据翻译)

关键变体:

- DCGAN(2015):采用卷积网络替代全连接层,提升生成质量

- CycleGAN(2017):基于循环一致性损失实现跨域图像转换

4. Transformer架构

核心机制:

- 自注意力机制(Self-Attention):通过Query-Key-Value矩阵计算实现全局依赖建模

- 多头注意力(Multi-Head Attention):并行计算不同子空间特征

- 位置编码(Positional Encoding):注入序列顺序信息

典型应用:

- NLP:BERT(双向Transformer编码器)、GPT(单向生成模型)

- CV:Vision Transformer(ViT)将图像分块处理为序列输入

优势:

- 并行计算效率显著优于RNN

- 跨模态统一建模能力(如CLIP实现图文联合表示)

5. 自编码器(Autoencoder)

核心机制:

- 编码-解码结构:通过瓶颈层实现数据降维与特征重构

关键变体:

- VAE(Variational Autoencoder):引入概率潜在空间,实现生成式建模

- Denoising AE:通过噪声输入增强模型鲁棒性

典型应用:

- 异常检测(如工业缺陷识别)、推荐系统特征提取

6. 深度强化学习(Deep Reinforcement Learning, DRL)

核心框架:

- 马尔可夫决策过程(MDP)建模环境动态

- 深度神经网络拟合策略(Policy)与价值函数(Value Function)

经典算法:

- DQN(2013):经验回放(Experience Replay)与目标网络(Target Network)稳定训练

- PPO(2017):裁剪策略更新(Clipped Surrogate Objective)提升训练稳定性

- AlphaGo(2016):结合蒙特卡洛树搜索(MCTS)与策略价值网络(Policy-Value Network)

挑战:

- 样本效率低(需大量交互数据)

- 奖励函数设计敏感(需领域专家知识)

7. 图神经网络(Graph Neural Networks, GNN)

核心机制:

- 消息传递(Message Passing):通过聚合邻居节点特征实现节点级/图级表示学习

基础模型:

- GCN(Graph Convolutional Network):谱域图卷积实现特征平滑

- GraphSAGE:归纳式学习支持动态图结构

- GAT(Graph Attention Network):注意力机制增强节点特征选择

典型应用:

- 社交网络分析(节点分类/链接预测)

- 分子属性预测(如DrugBAN用于药物发现)

8. 扩散模型(Diffusion Models)

核心机制:

- 前向过程:逐步向数据添加高斯噪声

- 反向过程:通过去噪网络预测噪声实现生成

优势:

- 生成质量超越GAN(如FID/IS指标显著提升)

- 训练稳定性高(无需对抗训练)

代表工作:

- DDPM(Denoising Diffusion Probabilistic Models, 2020):基于去噪分数匹配(Score Matching)

- Stable Diffusion:潜在空间扩散实现高效生成

算法演进趋势与挑战

- 架构统一化:Transformer在CV/NLP领域的跨模态应用(如ViT、CLIP)

- 生成模型突破:扩散模型逐步取代传统GAN架构(如Stable Diffusion的商业化落地)

- 计算效率优化:混合专家模型(MoE)、稀疏化训练方法(如Switch Transformers)

- 理论深化:神经切线核(NTK)、双层优化(Bi-Level Optimization)等理论框架发展

关键挑战:

- 模型可解释性(如黑箱问题)

- 小样本学习能力(需结合元学习/自监督学习)

- 能耗与计算成本(需硬件加速与算法优化)

36万+

36万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?