深度学习的轻量化神经网络结构研究综述

发展趋势:智能移动设备趋向于边缘化和移动化发展,但却受限于设备本身的硬件条件,深度卷积神经网络轻量化的目标就是在低硬件条件的设备上仍能够保持良好的网络性能。

轻量化的本质:在硬件条件不足的设备上解决存储空间和能耗对于传统神经网络性能的限制,在保持传统神经网络精度的基础上,通过人工设计、神经结构搜索或自动化机器学习等方法降低网络模型对存储空间的要求。

1.人工设计的轻量化神经网络:基于深度可分离卷积的SqueezeNet, MobileNet, MobileNet V2, ShuffleNet, ShuffleNet V2, 基于Octave卷积的改进基线网络,基于Ghost特征的GhostNet等。

1.1组卷积

1.2深度可分离卷积

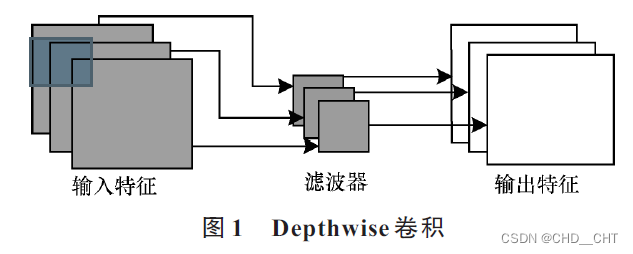

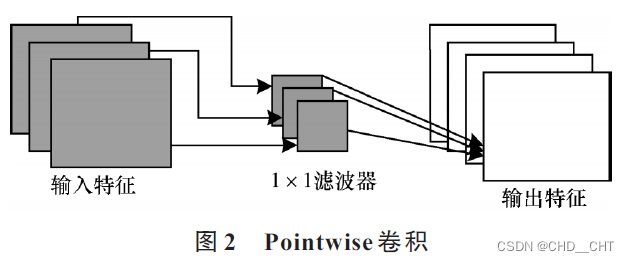

由Depthwise和Pointwise卷积组成

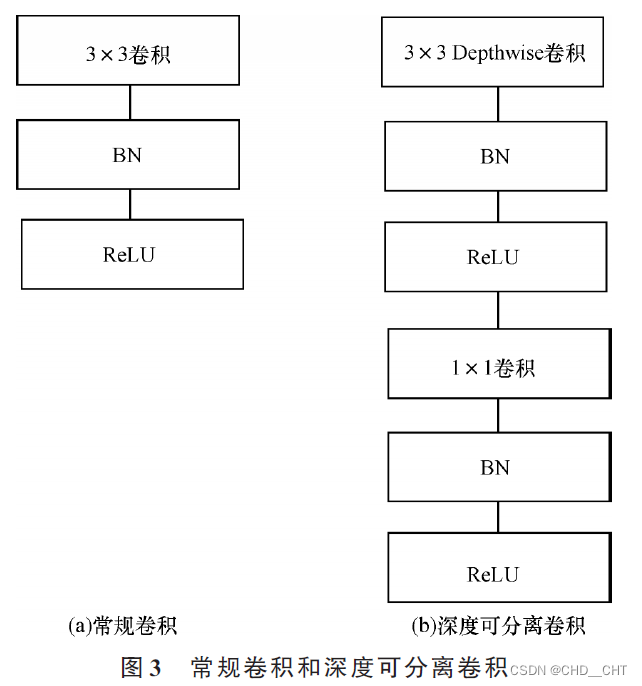

先使用Depthwise卷积对输入按特征通道分别进行卷积,然后对输出特征使用Pointwise卷积(1x1卷积核)。相较于常规卷积,能够减少2/3的参数量。

1.3基于深度可分离卷积的MobileNet

基本思想就是使用深度可分离卷积代替常规卷积。

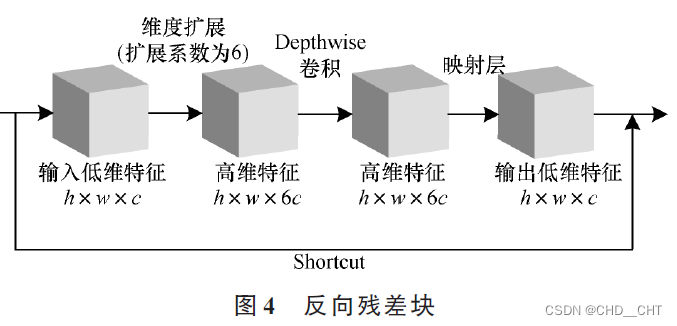

MobileNet V2在MobileNet的基础上,引入了反向残差块(先升维,再降维)。首先对输入进行特征扩展(升维),对高维特征使用Depthwise卷积代替常规3x3卷积,最后使用Pointwise卷积(1x1卷积降维)。

优点:有效解决了ReLU函数导致的神经元失活问题。

缺点:实际训练过程中,由于深度可分离卷积的卷积核和常规卷积相比较小,在激活函数的非线性激活作用下输出易于趋近0,通常会出现卷积核失活的问题。

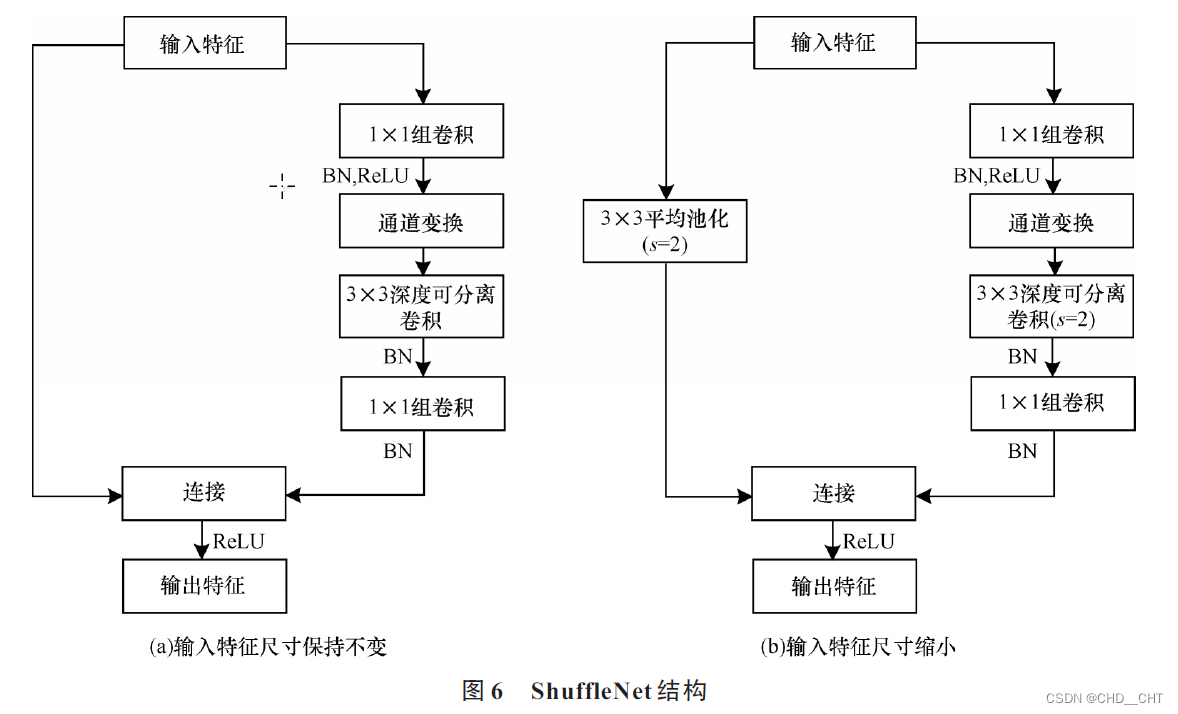

1.4基于深度可分离卷积的ShuffleNet

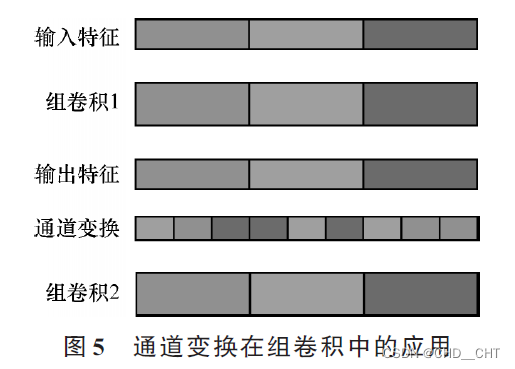

组卷积存在一个问题:不同组之间没有信息交换,会大幅降低深度神经网络的特征提取能力。MobileNet通过1x1 Pointwise卷积解决。ShuffleNet则是通过通道变换来解决该问题。

通道变化:对组卷积之后的特征图在通道上进行随机均匀打乱,再进行下一步操作,这样能保证执行下一个组卷积操作的输入特征来自上一个组卷积中的不同组。

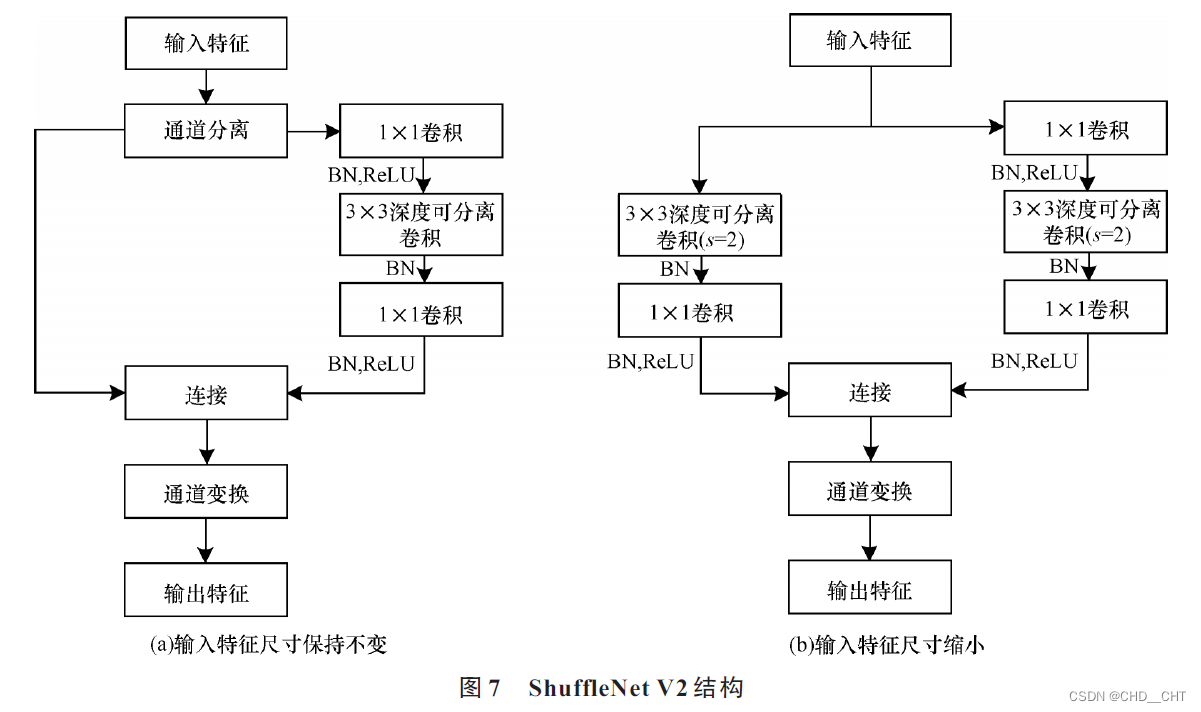

ShuffleNet V2

MA对于轻量化网络提出了4条实用的指导原则:1.尽量使用和输入特征通道数相同的卷积核个数来最小化内存使用量。2.减少组卷积的使用量以降低内存使用量。3.尽量减少碎片化的网络结构以增加并行度。4.减少元素级操作:如激活函数和特征图相加。

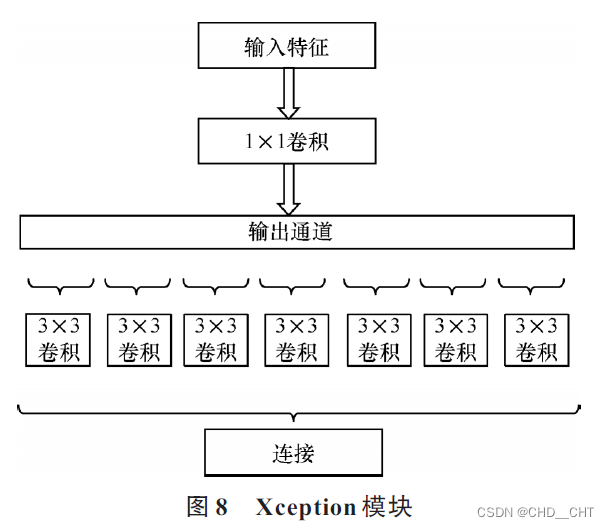

1.5 Xception

深度可分离卷积的优点:大幅减少计算量,保持较高的精度

深度可分离卷积的缺点:计算零散

Xception与深度可分离卷积的区别在于:深度可分离卷积先进行同一平面卷积获取空间相关性,再在不同通道之间进行卷积获得通道相关性。Xception与之相反,先获得通道相关性,再学习空间相关性。并且Xception在空间相关性和通道相关性的学习过程中未使用激活函数,能够提升网络的性能。

1.6基于Octave卷积的改进基线网络(*优化存储结构)

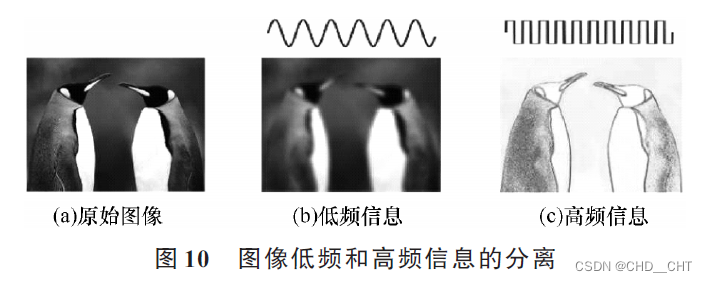

图片中不同的信息都以不同的频率传递,主要分为高频信息和低频信息。由高频信息和低频信息组成的特征图就是Octave特征图。

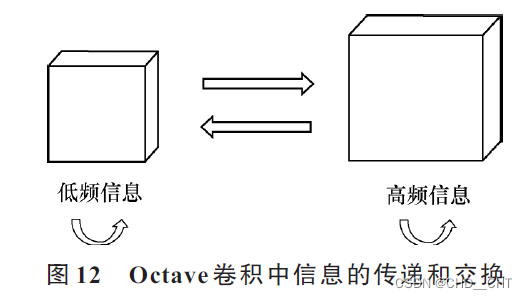

传统卷积方式中用同一种方式存储高频信息和低频信息,这对与低频信息而言会造成存储冗余并增加计算成本。Octave卷积将特征图根据不同的频率进行因式分解,对不同频率的信息进行不同的存储和操作,再在不同频率的信息之间进行信息交换。

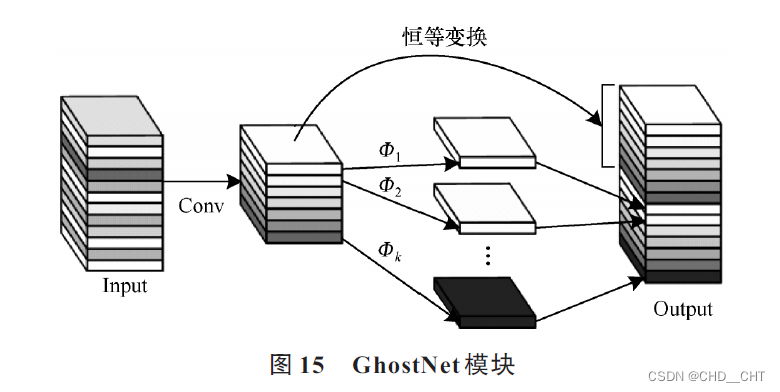

1.7基于Ghost特征的GhostNet(*优化运算速度)

关注常规卷积中特征图的冗余性,从特征图冗余性的角度实现网络结构轻量化。

2.神经结构搜索的自动轻量化网络:NasNet, MnasNet等。

文章探讨了深度学习中轻量化神经网络的研究,重点介绍了基于深度可分离卷积的模型如MobileNetV2和ShuffleNet,以及优化运算速度的GhostNet和存储结构的Octave卷积,旨在在低硬件条件下保持网络性能。

文章探讨了深度学习中轻量化神经网络的研究,重点介绍了基于深度可分离卷积的模型如MobileNetV2和ShuffleNet,以及优化运算速度的GhostNet和存储结构的Octave卷积,旨在在低硬件条件下保持网络性能。

893

893

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?