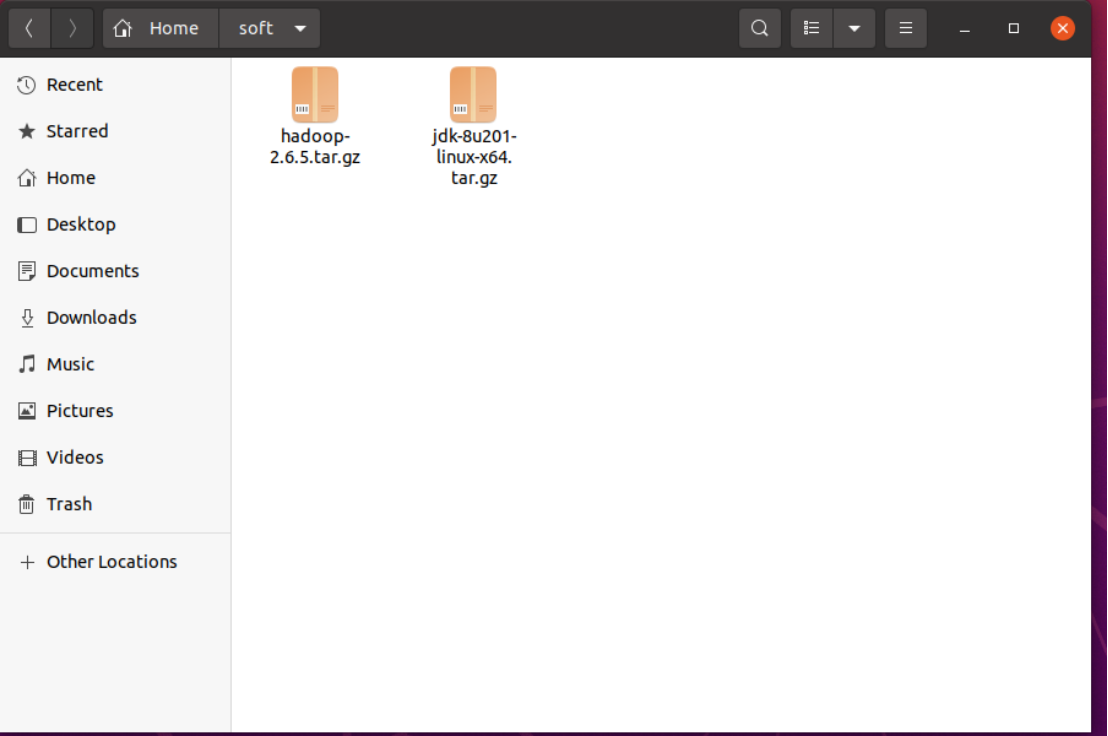

这里和装jdk一样需要先将压缩包移到soft下

然后 cd ~/soft

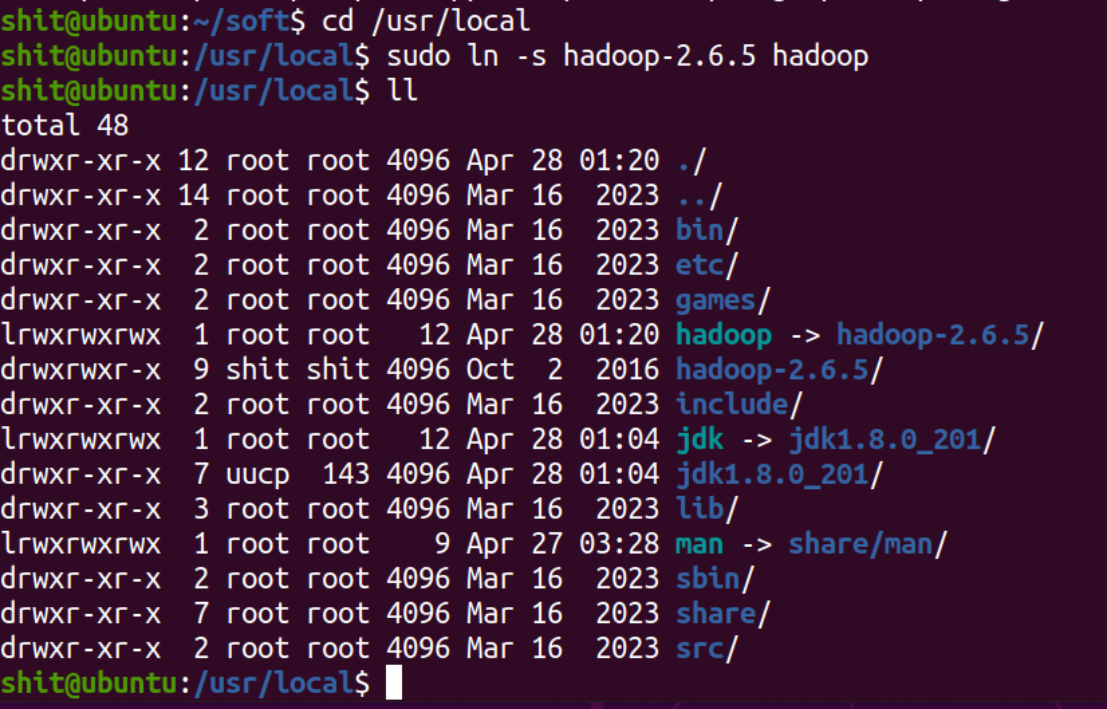

sudo tar -zxvf hadoop-2.6.5.tar.gz -C /usr/local

然后输入spark的密码

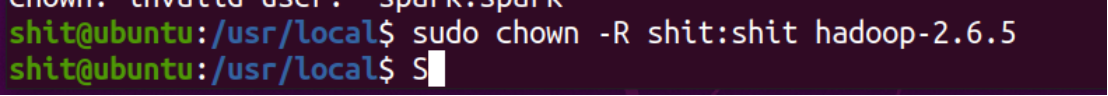

将解压的hadoop-2.6.5目录的用户和组权限设一下,方便启动Hadoop的时候能够完全控制这个目录,避免因为文件的访问权限导致出现问题。

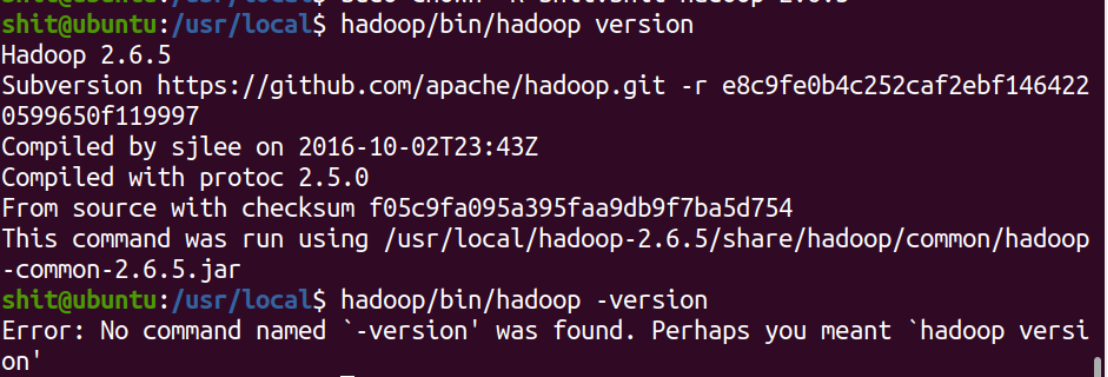

我这里的用户名是shit,所以是shit:shit 如果在version前加 - ,像java那样,就会报错。-version 被误认为是选项,但 Hadoop 并未定义该选项。

如果在version前加 - ,像java那样,就会报错。-version 被误认为是选项,但 Hadoop 并未定义该选项。

16万+

16万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?