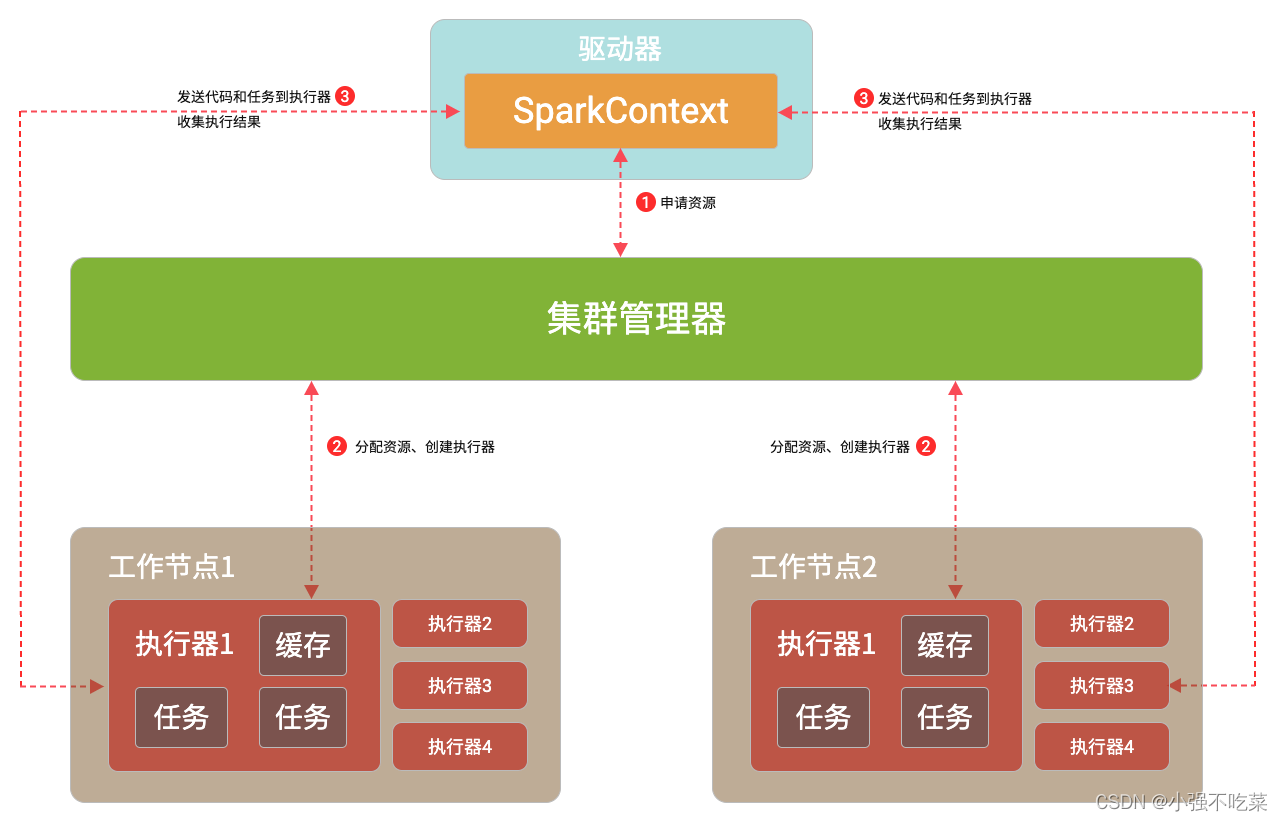

如下图所示,Spark集群主要包括5个部分:集群管理器、工作节点、执行器、应用程序、驱动器。

1.集群管理器

集群管理器用于Spark集群的资源管理和分配

2.工作节点

工作节点用于执行和提交Spark中的任务。工作节点的职责如下:

- 工作节点通过注册机制想寄去管理器发送自身的CPU、内存等资源使用数据

- 工作节点在Spark主节点的控制下创建和启动执行器,执行器是承载计算任务的重要组件。

- Spark主节点将任务分配给工作节点的执行器并运行任务。

- 工作节点同步资源信息与执行器状态信息到集群管理器

3.执行器

执行器是真正承担计算任务的组件,在工作节点上占据一个进程,负责运行任务,并将任务处理结果保存到内存或磁盘中。

4.应用程序

Spark应用程序是基于SparkAPI便携的,宝库实现驱动器功能的驱动程序,以及运行在多个节点的执行器程序。一个应用程序通常会包含一个或多个作业。

5.驱动器

驱动器包含了运行应用程序的主函数和构建Spark Context的程序。Spark应用程序,需要通过驱动器与集群管理器,实现与执行器的通信。驱动器既可以运行在应用程序节点,也可以由应用程序提交给集群管理器,再有集群管理器安排给工作节点运行。当执行器运行完毕后,驱动器负责将SparkContext关闭。驱动器的职责如下:

- 驱动器包含运行应用程序的主函数。

- SparkContext是在驱动器中创建。SparkContext负责和集群管理器通信,进行资源申请、任务分配、任务监控等工作。

- Spark在驱动器中划分RDD并生成DAG。

- Spark在驱动器中构建作业并将作业划分为多个Stage,各个Stage相互独立。一个作业往往是由多个Stage构建的并行计算任务,而具体的计算则由Spark的Action操作出发。

- 驱动器能与Spark中的其他组件进行资源调度。

- Spark是在驱动器生成任务,并将任务发送到执行器上运行。

本文介绍了Spark集群的五大核心组成部分:集群管理器、工作节点、执行器、应用程序和驱动器。详细阐述了各部分的功能及相互间的关系,为理解Spark的工作原理提供了清晰的视角。

本文介绍了Spark集群的五大核心组成部分:集群管理器、工作节点、执行器、应用程序和驱动器。详细阐述了各部分的功能及相互间的关系,为理解Spark的工作原理提供了清晰的视角。

412

412

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?