在上一篇伪分布式的基础上搭建完全分布式集群

一、配置环境

1. 每一台主机安装jdk

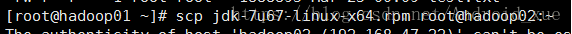

hadoop01已经安装过了,先把安装包,远程发送给hadoop02 hadoop03 hadoop04服务器

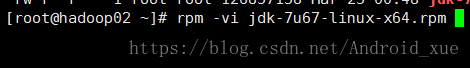

然后给每一台都安装

配置环境变量(第二步免秘钥配完更统一配置,通过分发更快)

2. 免秘钥

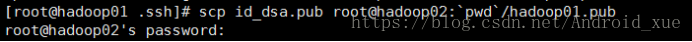

hadoop01作为namenode 其他三台作为datanode,他们需要拿到hadoop01的公钥(后面写一个hadoop01.pub是为了区分是谁发过来的公钥),这个操作之前在hadoop02-04分别运行一个命令:ssh localhost

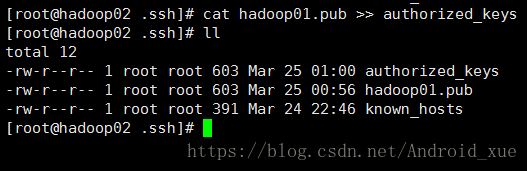

然后做如下操作:(公钥存放在用户打算连接的所有机器的authorized_keys文件中)

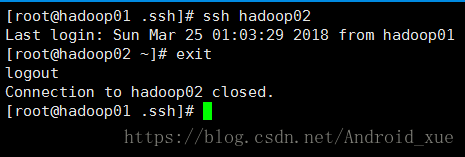

这时候再用hadoop01登录hadoop02-04就不要输入密码了

检验完后记得退出,说明管理节点到其他节点免密成功。

把环境变量的文件远程传送给hadoop02-04:

配置完环境变量都重新加载一下

二、配置Hadoop

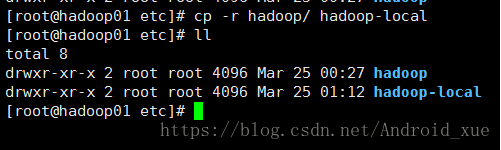

先把之前的伪分布式拷贝一份

然后直接配置hadoop这个文件

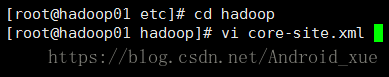

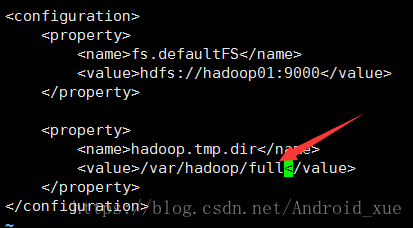

1. 配置核心配置文件(主要是配置namenode)

由于还是用hadoop01做namenode,所以只需要修改数据的存储路径即可

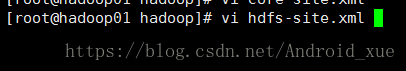

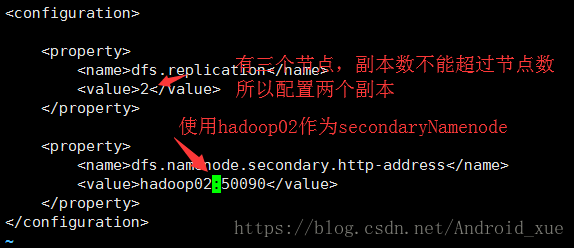

2. 配置hdfs-site.xml(主要是配置secondarynamenode)

3. 配置slaves(主要是配置datanode)

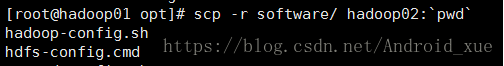

4. 配置hadoop环境(直接把hadoop01配置好的software目录全部远程传送到hadoop02 hadoop03 hadoop04即可)

之后重新加载

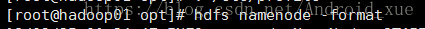

5. 格式化

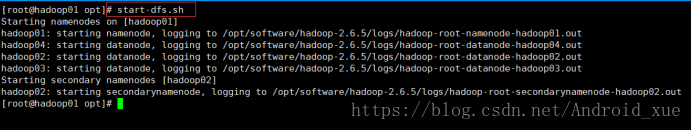

6. 启动

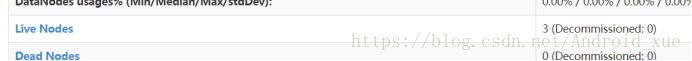

可以看到都启动成功了。

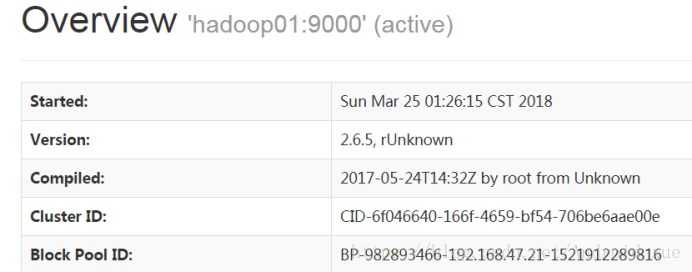

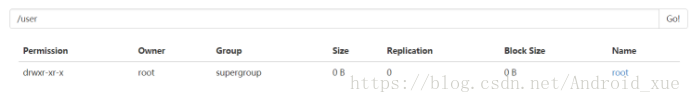

访问浏览器

使用hadoop01创建一个目录:

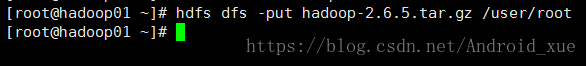

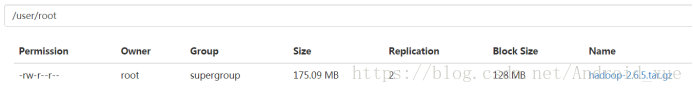

上传一个文件

好了,以上就是完全分布式的全部步骤了

本文详细介绍如何从伪分布式环境升级到Hadoop的完全分布式集群,包括多主机JDK安装与环境配置、免密钥SSH配置、核心配置文件调整、HDFS启动与验证等关键步骤。

本文详细介绍如何从伪分布式环境升级到Hadoop的完全分布式集群,包括多主机JDK安装与环境配置、免密钥SSH配置、核心配置文件调整、HDFS启动与验证等关键步骤。

363

363

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?