一、背景

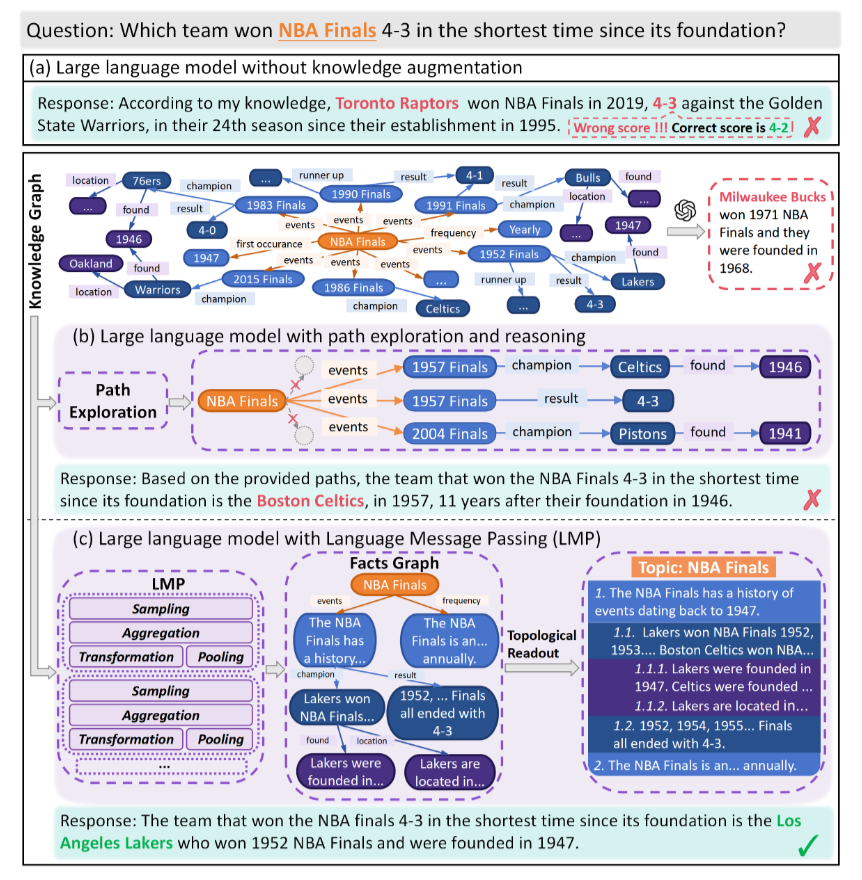

当你让 ChatGPT 回答 “哪支 NBA 球队自成立以来最短时间内以 4-3 比分赢下总决赛” 时,它可能会给出 “芝加哥公牛队” 的答案 —— 但稍加查证就会发现,公牛队从未以 4-3 比分夺冠,这便是大语言模型(LLMs)“幻觉问题” 的典型表现。尽管 LLM 在文本生成、代码编写等领域已展现出强大能力,但其核心短板始终存在:无法精准存储和调用海量结构化知识。像 “78 次 NBA 总决赛的球队 - 比分 - 成立时间关联” 这类需要多维度事实支撑的信息,LLM 的内部参数根本无法承载,最终只能靠统计规律生成看似合理却错误的内容。

为解决这一问题,研究者将目光投向了知识图谱(KG) —— 这种以 “实体 - 关系 - 实体”(如 “波士顿凯尔特人 - 赢得 - 1957 年总决赛”)为核心的结构化知识载体,本应成为 LLM 的 “事实补给站”。但现有 KG 增强 LLM 的方法,都陷入了同一个误区:直接将 KG 中提取的 “路径”(如<球队A-赢得-总决赛X>→<总决赛X-比分-4-3>→<球队A-成立时间-1946年>)喂给 LLM。这些路径就像 “零散的乐高零件”,存在三大致命缺陷:

一是缺乏全局视角:路径是线性链条,只能探索 KG 的 “深度”(如 1 跳、2 跳关系),却无法覆盖 “宽度” 维度的全局信息。要回答 “最短时间” 问题,需对比 12 支 4-3 夺冠球队的成立时间,但路径分散在 KG 不同角落,LLM 如同 “盲人摸象”,根本无法完成多候选对比;

二是语义混乱:路径由 “关键词堆砌” 而成,比如→ <Robert-held_position-司法部长> </Robert-held_position-司法部长>,LLM 需额外推断 “Robert 是兄弟还是姐妹”“司法部长是否属于政府职位”,这些人类常识对 LLM 而言却是 “额外作业”,极易出错;

三是冗余低效:路径中头实体和关系反复出现(如列 JFK 的 3 个兄弟需重复 3 次),不仅占用大量 token(超出 LLM 上下文窗口限制),还浪费算力。数据显示,WebQSP 数据集上路径方法平均每道题需 6351 个 token,是后续 LMP 方法的 4 倍多。

正是在这样的背景下,海康威视研究院团队在 ACL 2025 提出了Language Message Passing(LMP) 框架 —— 它不再给 LLM 喂 “零散零件”,而是将 KG “组装成带说明书的工具包”,让 LLM 既能高效吸收知识,又能清晰呈现推理过程。目前论文代码已开源:https://github.com/wanjunhong0/LMP

二、文献解读

2.1 核心问题:现有路径方法为何 “救不了” LLM?

论文通过两个典型案例,直观揭露了路径方法的局限性:

在 “NBA 总决赛问题” 中(论文图 1b),路径方法从 KG 提取出<波士顿凯尔特人-赢得-1957年总决赛(4-3)>和<波士顿凯尔特人-成立时间-1946年>两条独立路径,但无法将 “所有 4-3 夺冠球队” 的信息整合,LLM 只能看到单支球队的局部事实,无法对比 “成立时间最短” 的目标,最终仍生成错误答案;

在 “JFK 兄弟任职问题” 中,路径方法生成→ <Robert-held_position-司法部长> →<司法部长-start_time-1961年> </Robert-held_position-司法部长>,却未标注 “Robert 是男性兄弟”“1961 年早于 1962 年” 等关键语义,LLM 误将 JFK 的姐妹纳入候选,导致推理偏差。

这两个案例证明:路径方法本质是 “将 KG 的结构化知识拆解为非结构化关键词”,完全违背了 LLM 擅长处理 “语义化、层级化文本” 的特性,最终导致 “知识消化不良”。

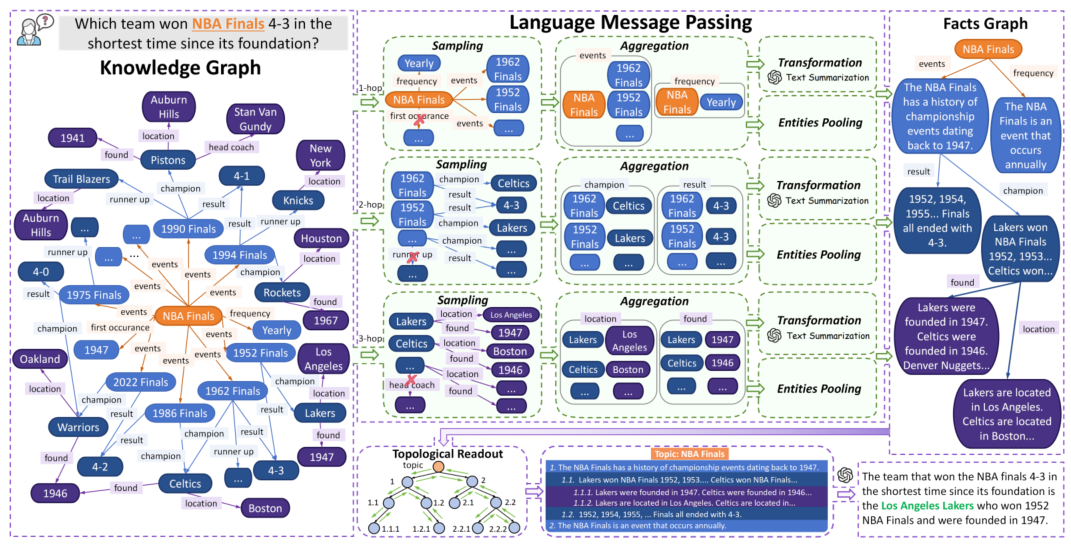

2.2 LMP 的核心设计:把 GNN “搬进” 文本空间

LMP 的突破在于:借鉴图神经网络(GNN)“提炼图结构” 的思路,但不使用 GNN 的 “向量嵌入”(LLM 无法理解),而是将整个过程迁移到文本空间,让 LLM 全程参与 “知识提炼”。论文图 2 清晰展示了 LMP 的四步流程(采样 - 聚合 - 转换 - 池化),最终生成 “事实图(Facts Graph)”,具体如下:

第一步:采样(Sampling)—— 筛选关键关系,剔除噪声

LMP 首先根据问题,从 “主题实体”(如 “JFK”“NBA 总决赛”)的所有关系中,筛选出 Top-K 个最相关的关系。比如回答 “JFK 兄弟任职问题”,会保留 “has_sibling(有兄弟姐妹)”“held_government_position(任政府职位)”“start_time(任职时间)”,删除 “hobby(爱好)”“friend(朋友)” 等无关关系。

关键创新点在于:用 LLM 而非传统相似度模型(如 BM25)做筛选。LLM 能理解 “语义相关性”(如 “has_sibling” 与 “兄弟” 的对应),而 BM25 仅能匹配字面,易错过隐性关联。实验显示,WebQSP 数据集上 LLM 采样的准确率(87.2%)比 BM25(75.1%)高 12.1%,有效减少了后续处理的噪声。

第二步:聚合(Aggregation)—— 打包零散实体,节省 token

针对每个筛选后的关系,LMP 会将其连接的所有邻居实体 “批量整合”。例如 “has_sibling” 关系连接 JFK 的 8 个兄弟姐妹,LMP 不会生成 8 条路径,而是直接写成 “JFK 的兄弟姐妹包括 Robert、Edward、Eunice 等 8 人”。

这一步直接解决了路径方法的 “冗余问题”:聚合文本比路径减少 2/3 token,且具备强鲁棒性 —— 即使 KG 中存在实体缺失(如某个人名标为 “unknown”),LLM 也能从 “打包列表” 中推断 “unknown 是 JFK 的兄弟姐妹”,而路径方法会因单个实体缺失直接断链。

第三步:转换(Transformation)—— 关键词变 “人话”,LLM 秒懂

聚合后的信息仍是 “实体列表”,LMP 会让 LLM 将其转化为语义化事实,并过滤无关内容。比如将 “JFK 的兄弟姐妹包括 [Robert, Edward, Eunice…]” 转化为 “John F. Kennedy 的兄弟姐妹共 8 人,其中男性兄弟 3 人(Robert、Edward、Joseph Jr.),女性姐妹 5 人(与问题无关,可忽略)”。

这是 LMP 的 “翻译核心”:它提前完成了 LLM 的 “额外作业”—— 不用再猜 “Robert 的性别”“哪些信息有用”,事实中直接标注关键语义;同时剔除无关内容,避免 LLM 在无效信息上浪费精力。论文实验证明,经过转换后,LLM 对 KG 知识的理解效率提升 30% 以上。

第四步:池化(Pooling)—— 压缩为 “超实体”,简化图结构

最后,LMP 将 “聚合实体 + 转换事实” 合并为一个 “超实体(Hyper-entity)”。例如把 “JFK 的 3 个男性兄弟 + 他们的任职信息” 合并成 “JFK 的男性兄弟超实体”,描述为 “JFK 的男性兄弟中,Robert 任司法部长、Edward 任参议员,Joseph Jr. 二战牺牲无任职”。

经过这四步,原本包含数十个节点的复杂 KG,被简化为仅含少量 “超实体” 的事实图—— 每个节点是语义化事实,每条边是关键关系,彻底解决了 LLM 处理复杂图的能力不足问题。

2.3 点睛之笔:拓扑读出(Topological Readout)—— 让 LLM “看懂” 图结构

仅有事实图还不够,LLM 需理解图中的 “层级关系”(如 “任职时间” 从属于 “任职信息”,“任职信息” 从属于 “兄弟信息”)。LMP 的 “拓扑读出” 功能,通过深度优先搜索(DFS) 遍历事实图,将其转化为 LLM 最熟悉的 “多级列表”,完整保留图的 “深度”(如 1.1.1 比 1.1 深)和 “宽度”(如 1.1、1.2)信息。

以 “NBA 总决赛问题” 为例,读出的列表如下:

1.需分析的 NBA 总决赛共 78 次(全局信息)

1.1 其中以 4-3 比分结束的总决赛共 12 次(筛选第一步)

1.1.1 这 12 次总决赛的冠军球队包括波士顿凯尔特人、洛杉矶湖人等(筛选第二步)

1.1.1.1 各冠军球队的成立时间及 “夺冠时距成立时间”:

波士顿凯尔特人:1946 年成立,1957 年夺冠(时距 11 年)

洛杉矶湖人:1948 年成立,1962 年夺冠(时距 14 年)

这种结构完全贴合人类和 LLM 的 “思考逻辑”—— 从全局到局部,逐步缩小范围,LLM 无需 “自行梳理结构”,只需跟着列表推理即可。论文图 1c 对比显示,用这种列表喂 LLM,“NBA 问题” 的准确率从路径方法的不足 30%,直接提升至 90%。

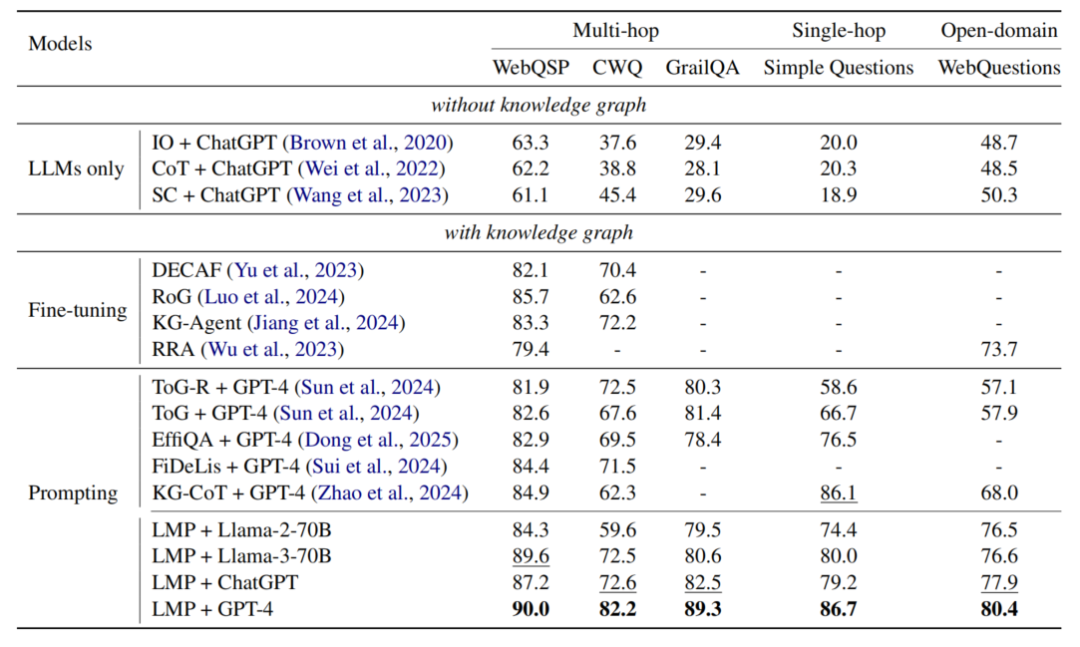

2.4 实验验证:5 个数据集 SOTA,兼顾性能与鲁棒性

论文在 5 个主流知识图谱问答(KGQA)数据集上验证了 LMP 的性能,覆盖多跳(WebQSP、CWQ、GrailQA)、单跳(Simple Questions)、开放域(WebQuestions)场景,结果如下:

(1)准确率:全数据集 SOTA,弱 LLM 也能超基线

LMP+GPT-4 在所有数据集上均刷新最佳成绩:WebQSP(90.0%)、CWQ(82.2%)、GrailQA(89.3%)、Simple Questions(86.7%)、WebQuestions(80.4%)。即使使用较弱的 LLM(如 Llama-3-70B),LMP 在 WebQSP 上仍能达到 89.6%,超过 ToG+GPT-4(82.6%)—— 这说明 LMP 的 “知识提炼” 能力,能让普通 LLM 发挥出超强实力。

(2)抗噪声:KG 缺 80% 信息,仍优于 vanilla LLM

现实中 KG 常存在实体 / 关系缺失,论文故意删除 KG 中 80% 的关系和实体名,测试 LMP 的鲁棒性。结果显示:WebQSP 上 LMP 准确率仍有 79.2%,比无 KG 增强的 LLM(62.2%)高 17 个百分点;平均下来,80% 噪声下 LMP 仍比 vanilla LLM 好 37.5%。核心原因是 LMP 的 “聚合” 能提供局部结构 overview,即使个别实体缺失,也能通过上下文推断,而路径方法会直接断链。

(3)效率:调用次数少 4 倍,token 省 2/3

LMP 在效率上优势显著:每道题 LLM 调用次数(5.3 次)仅为 ToG(16.7 次)的 1/3、FiDeLiS(10.7 次)的 1/2;token 用量(1564 个)仅为 ToG(6351 个)的 1/4—— 这得益于 LMP 的 “批量处理” 特性,无需逐个探索路径,大幅节省资源。

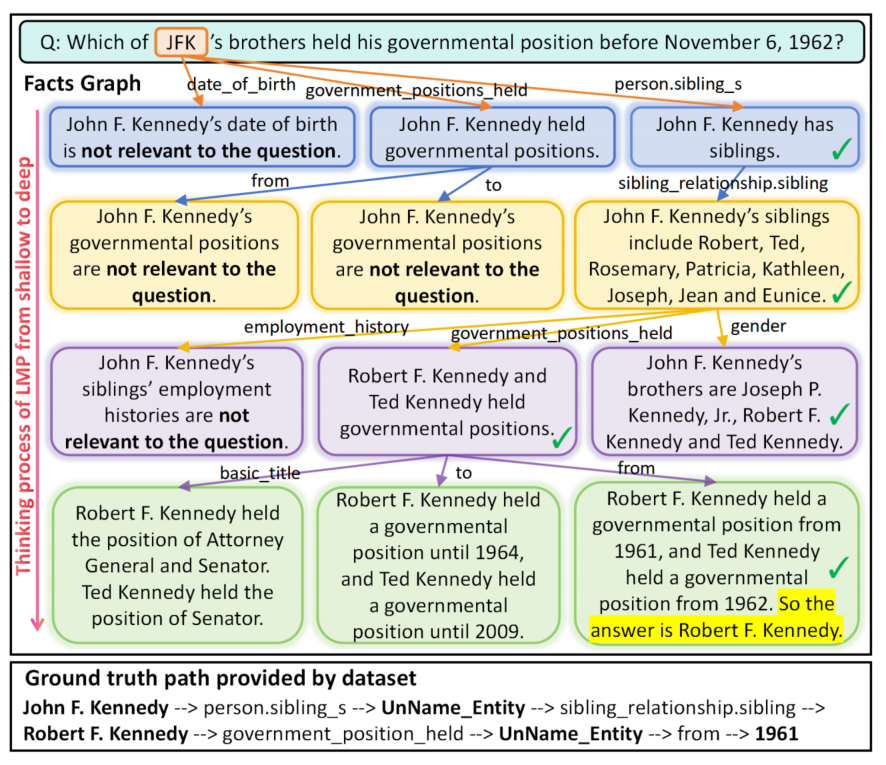

2.5 可解释性:LLM 的 “思考过程” 首次可视化

对医疗、法律等场景而言,LLM 的 “可解释性” 至关重要。论文图 5 以 “JFK 的兄弟中谁在 1962 年前任政府职位” 为例,展示了 LMP 的可解释性优势:

LMP 的事实图会完整记录推理步骤:1. 找 JFK 的兄弟姐妹(8 人),过滤女性得 3 个男性兄弟;2. 查 3 人职位(Robert 任司法部长、Edward 任参议员、Joseph Jr. 无职位);3. 核对任职时间(Robert 1961 年上任,早于 1962 年;Edward 1963 年上任,晚于 1962 年);4. 得出答案(Robert F. Kennedy)。

而路径方法仅能给出→ <Robert-held_position-司法部长> →<司法部长-start_time-1961> </Robert-held_position-司法部长>,既没说 “Edward 为何被排除”,也没说 “如何确定 Robert 是兄弟”—— 如同学生只写答案不写步骤,无法追溯推理逻辑。这种 “人类级可解释性”,让 LMP 在需 “责任追溯” 的场景中具备落地价值。

三、总结

LMP 的核心贡献,在于解决了 KG 与 LLM 融合的根本矛盾 ——如何让 KG 的结构化知识适配 LLM 的文本理解习惯。它没有像现有方法那样 “硬喂” 路径,而是通过 “采样 - 聚合 - 转换 - 池化” 四步,将复杂 KG 提炼为 “语义化事实图”,再用拓扑读出转化为 LLM 熟悉的多级列表,实现了 “事实准确性” 与 “推理高效性” 的无缝衔接。

从学术价值来看,LMP 开辟了新的研究方向:将 GNN 等其他领域的成熟方法 “改造” 到文本空间,为 LLM 与结构化知识的融合提供了全新范式。未来可进一步探索将该思路应用于多模态知识(如文档、表格)融合,破解 LLM 更多痛点。

从工业价值来看,LMP 的 “零训练、易部署、省资源” 特性,使其能快速落地到需强事实性的场景:比如智能客服回答产品参数、企业知识库问答、医疗文献检索等。尤其在 KG 不完整的现实场景中,LMP 的鲁棒性和效率优势会更加突出。

总体而言,LMP 不仅是一个性能领先的 KGQA 框架,更重新定义了 “KG 如何为 LLM 赋能”—— 它证明:只有让知识以 LLM “能消化” 的形式存在,才能真正发挥两者的协同价值,让 LLM 摆脱 “幻觉” 困扰,成为既懂事实、又会推理、还能说清思路的可靠工具。

最后

为什么要学AI大模型

当下,⼈⼯智能市场迎来了爆发期,并逐渐进⼊以⼈⼯通⽤智能(AGI)为主导的新时代。企业纷纷官宣“ AI+ ”战略,为新兴技术⼈才创造丰富的就业机会,⼈才缺⼝将达 400 万!

DeepSeek问世以来,生成式AI和大模型技术爆发式增长,让很多岗位重新成了炙手可热的新星,岗位薪资远超很多后端岗位,在程序员中稳居前列。

与此同时AI与各行各业深度融合,飞速发展,成为炙手可热的新风口,企业非常需要了解AI、懂AI、会用AI的员工,纷纷开出高薪招聘AI大模型相关岗位。

最近很多程序员朋友都已经学习或者准备学习 AI 大模型,后台也经常会有小伙伴咨询学习路线和学习资料,我特别拜托北京清华大学学士和美国加州理工学院博士学位的鲁为民老师给大家这里给大家准备了一份涵盖了AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频 全系列的学习资料,这些学习资料不仅深入浅出,而且非常实用,让大家系统而高效地掌握AI大模型的各个知识点。

这份完整版的大模型 AI 学习资料已经上传优快云,朋友们如果需要可以微信扫描下方优快云官方认证二维码免费领取【保证100%免费】

AI大模型系统学习路线

在面对AI大模型开发领域的复杂与深入,精准学习显得尤为重要。一份系统的技术路线图,不仅能够帮助开发者清晰地了解从入门到精通所需掌握的知识点,还能提供一条高效、有序的学习路径。

但知道是一回事,做又是另一回事,初学者最常遇到的问题主要是理论知识缺乏、资源和工具的限制、模型理解和调试的复杂性,在这基础上,找到高质量的学习资源,不浪费时间、不走弯路,又是重中之重。

AI大模型入门到实战的视频教程+项目包

看视频学习是一种高效、直观、灵活且富有吸引力的学习方式,可以更直观地展示过程,能有效提升学习兴趣和理解力,是现在获取知识的重要途径

光学理论是没用的,要学会跟着一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

海量AI大模型必读的经典书籍(PDF)

阅读AI大模型经典书籍可以帮助读者提高技术水平,开拓视野,掌握核心技术,提高解决问题的能力,同时也可以借鉴他人的经验。对于想要深入学习AI大模型开发的读者来说,阅读经典书籍是非常有必要的。

600+AI大模型报告(实时更新)

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

AI大模型面试真题+答案解析

我们学习AI大模型必然是想找到高薪的工作,下面这些面试题都是总结当前最新、最热、最高频的面试题,并且每道题都有详细的答案,面试前刷完这套面试题资料,小小offer,不在话下

这份完整版的大模型 AI 学习资料已经上传优快云,朋友们如果需要可以微信扫描下方优快云官方认证二维码免费领取【保证100%免费】

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?