前言

本地显卡不够、显存爆了、加载模型半天动不了?

Ollama 最近的「云模型」功能,可能正好能帮助到你。

一、Ollama 云模型是什么

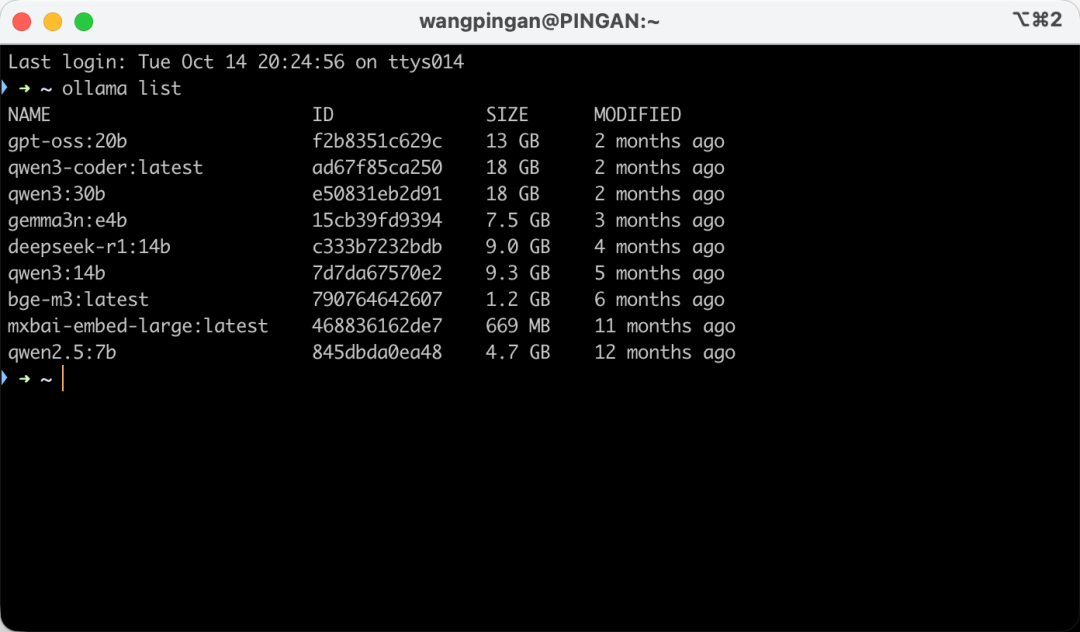

如果你用过 Ollama,大概率是因为它能在本地跑各种大模型:

下载一个模型,用 ollama run 一敲,就能聊起来。

但问题也来了—— 模型太大了,本地电脑吃不消, 显存不够、风扇狂转、系统一卡一卡的。

Ollama 新推出的云模型(Cloud Models)就是为了解决这个问题:

你还是用熟悉的命令,但模型不是在你电脑上跑的,而是在 Ollama 的云端跑完后,把结果传回来。

也就是说,你能像本地一样用 Ollama,却能跑更大的模型。

二、本地模式 vs 云模式

其实 Ollama 现在有两种运行方式:

| 模式 | 本地模型(local) | 云模型(cloud) |

|---|---|---|

| 运行位置 | 在你电脑上跑 | 在 Ollama 云端跑 |

| 算力需求 | 高,需要显卡支持 | 几乎不占本地资源 |

| 延迟 | 很低 | 会有点网络延迟 |

| 模型体积 | 受限于你电脑性能 | 想多大有多大(甚至上百 B) |

| 隐私性 | 完全本地 | 数据需上传云端 |

| 成本 | 免费(除了电费) | 可能会按调用计费 |

一句话总结:

👉 本地模型:快,但受限于设备。

👉 云模型:灵活,不挑硬件。

三、支持的云模型

目前 Ollama 云端能用的模型都带 -cloud 后缀,目前仅支持:

deepseek-v3.1:671b-cloudgpt-oss:120b-cloudkimi-k2:1t-cloudqwen3-coder:480b-cloud

这些名字后面都有个“-cloud”,代表模型在云端运行。

这些模型都是参数体量超大的模型,但你本地照样能用。

四、如何使用

其实用起来很简单,分三步就行 👇

步骤 1:登录账号

先登录 Ollama:

ollama signin

```

这里需要注意,需要把上面中的 `https://ollama.com/connect?name=.....`链接复制到浏览器打开,然后登录你的账号,确认授权:

或者使用 API 时,把 Key 设置好:

```plaintext

export OLLAMA_API_KEY=你的密钥

获取 API Key: https://ollama.com/settings/keys

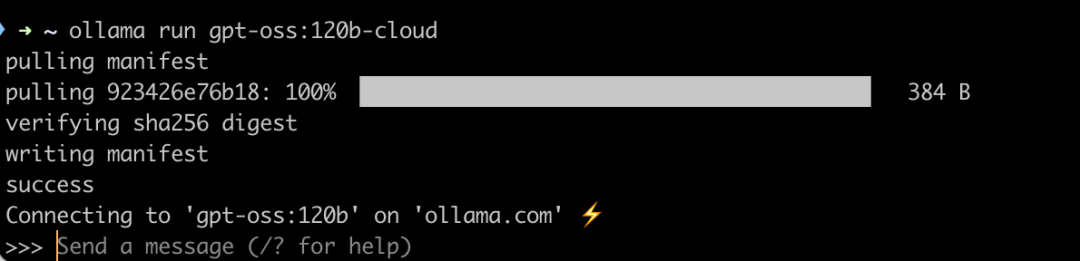

步骤 2:直接运行云模型

然后直接在终端运行模型,比如:

ollama run gpt-oss:120b-cloud

和本地模型几乎一样,只是这次在云端跑。

步骤 3:用 API 调用(比如 Python)

想在自己的项目里接入也行。

示例代码如下:

import osfrom ollama import Clientclient = Client( host="https://ollama.com", headers={'Authorization': 'Bearer ' + os.environ.get('OLLAMA_API_KEY')})messages = [{'role': 'user', 'content': '为什么天空是蓝色的?'}]for part in client.chat('gpt-oss:120b', messages=messages, stream=True): print(part['message']['content'], end='', flush=True)

就这样,你的本地脚本就能直接调用云端模型。

五、什么时候使用

Chris 这里帮你总结下:

✅ 用本地模型的情况:

- 模型小,电脑能跑

- 想完全离线

- 不想上传任何数据

✅ 用云模型的情况:

- 想跑大模型,电脑带不动

- 想省事,不折腾驱动和显卡

- 不介意稍微的网络延迟

很多人会两者结合:比如小任务用本地模型,大任务临时切云模型。更多介绍可以查看官网:https://docs.ollama.com/cloud

六、使用注意

虽然云模型很方便,但也有一些要注意的:

- 网络稳定很重要:网络波动可能让调用中断,记得加重试机制。

- API Key 别泄露:否则别人可能白嫖你的额度。

- 费用问题:官方现在还在预览期,可能未来会有计费。

- 隐私数据要小心:上传前记得脱敏。

- 第一次会慢点:云端模型有冷启动时间,多等几秒。

七、实战建议:从本地切换到云模型

假设你原本这样写的:

ollama run gpt-oss:20b

现在只要改成:

ollama run gpt-oss:120b-cloud

或者在代码里做个小判断 👇

model = "gpt-oss:120b-cloud" if use_cloud else "gpt-oss:20b"

这样就能随时切换运行模式,想本地跑就本地跑,想云跑就云跑。开发调试更灵活,也方便部署。

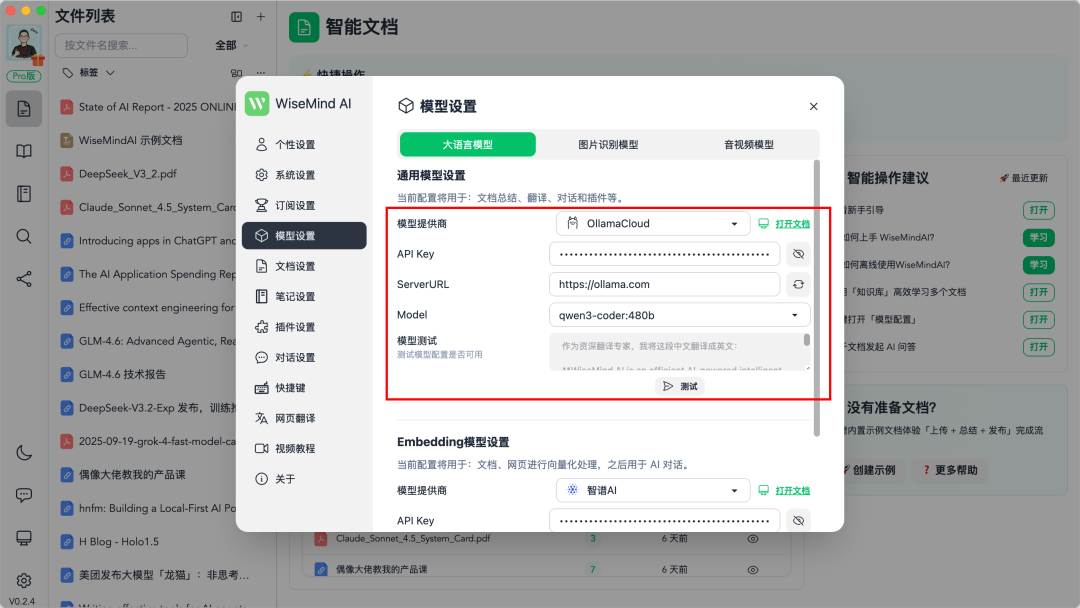

另外,在 Chris 开发的 AI 本地知识库软件 WiseMindAI 上,也即将支持 Ollama Cloud 模型了,预计 10 月底 v0.2.5 版本上线:

八、收费情况

Ollama 的云服务包含小时和每日限制,以避免容量问题。目前支持免费和专业版订阅(20 美元),只是免费版的每日限制,官方还没有确定,目前可以免费使用:

总结

Ollama 的云模型功能,可以说是「让你不买显卡,也能玩大模型」,使用的时候:

- 调用方式跟本地一模一样;

- 不占本地算力;

- 能跑超大模型;

- 而且适合个人开发者和轻量部署。

最后

为什么要学AI大模型

当下,⼈⼯智能市场迎来了爆发期,并逐渐进⼊以⼈⼯通⽤智能(AGI)为主导的新时代。企业纷纷官宣“ AI+ ”战略,为新兴技术⼈才创造丰富的就业机会,⼈才缺⼝将达 400 万!

DeepSeek问世以来,生成式AI和大模型技术爆发式增长,让很多岗位重新成了炙手可热的新星,岗位薪资远超很多后端岗位,在程序员中稳居前列。

与此同时AI与各行各业深度融合,飞速发展,成为炙手可热的新风口,企业非常需要了解AI、懂AI、会用AI的员工,纷纷开出高薪招聘AI大模型相关岗位。

最近很多程序员朋友都已经学习或者准备学习 AI 大模型,后台也经常会有小伙伴咨询学习路线和学习资料,我特别拜托北京清华大学学士和美国加州理工学院博士学位的鲁为民老师给大家这里给大家准备了一份涵盖了AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频 全系列的学习资料,这些学习资料不仅深入浅出,而且非常实用,让大家系统而高效地掌握AI大模型的各个知识点。

这份完整版的大模型 AI 学习资料已经上传优快云,朋友们如果需要可以微信扫描下方优快云官方认证二维码免费领取【保证100%免费】

AI大模型系统学习路线

在面对AI大模型开发领域的复杂与深入,精准学习显得尤为重要。一份系统的技术路线图,不仅能够帮助开发者清晰地了解从入门到精通所需掌握的知识点,还能提供一条高效、有序的学习路径。

但知道是一回事,做又是另一回事,初学者最常遇到的问题主要是理论知识缺乏、资源和工具的限制、模型理解和调试的复杂性,在这基础上,找到高质量的学习资源,不浪费时间、不走弯路,又是重中之重。

AI大模型入门到实战的视频教程+项目包

看视频学习是一种高效、直观、灵活且富有吸引力的学习方式,可以更直观地展示过程,能有效提升学习兴趣和理解力,是现在获取知识的重要途径

光学理论是没用的,要学会跟着一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

海量AI大模型必读的经典书籍(PDF)

阅读AI大模型经典书籍可以帮助读者提高技术水平,开拓视野,掌握核心技术,提高解决问题的能力,同时也可以借鉴他人的经验。对于想要深入学习AI大模型开发的读者来说,阅读经典书籍是非常有必要的。

600+AI大模型报告(实时更新)

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

AI大模型面试真题+答案解析

我们学习AI大模型必然是想找到高薪的工作,下面这些面试题都是总结当前最新、最热、最高频的面试题,并且每道题都有详细的答案,面试前刷完这套面试题资料,小小offer,不在话下

这份完整版的大模型 AI 学习资料已经上传优快云,朋友们如果需要可以微信扫描下方优快云官方认证二维码免费领取【保证100%免费】

2612

2612

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?