前言

想象一下,你问一个超级学霸:“我的生日是哪天?”学霸如果不知道,最靠谱的做法应该是说“我不知道”。但奇怪的是,当今最顶尖的大型语言模型(比如ChatGPT、DeepSeek等)在面对不确定的问题时,却常常会选择“猜一个答案”,而且猜得有理有据,听起来特别像那么回事儿。这种现象在AI领域被称为“幻觉”(Hallucination)。

- 论文:Why Language Models Hallucinate

- 链接:https://arxiv.org/pdf/2509.04664

幻觉问题严重削弱了我们对AI的信任。尽管研究人员想了很多办法,但它依然像“打不死的小强”一样,存在于最先进的模型中。这篇由OpenAI和佐治亚理工的研究者联合发表的论文深入挖掘了幻觉的根源。它发现,问题的核心并不神秘,而是深植于模型训练和评估的统计本质中:模型之所以“胡猜”,是因为整个系统在鼓励它“胡猜”。

本文将带你深入解读这篇论文,看作者如何将复杂的AI问题转化为清晰的统计问题,并为我们指出一条让AI变得更诚实、更可靠的道路。

研究动机与问题定义

论文开篇就用几个生动的例子点明了幻觉问题的严重性。例如,当询问作者之一Adam Kalai的生日时,强大的DeepSeek-V3模型在多次尝试中给出了“03-07”、“15-06”、“01-01”等不同的错误答案,尽管提示中明确要求“如果不知道,请勿回答”。

幻觉在此被定义为模型生成的看似合理但实则错误的陈述。论文将其统称为“错误”(Errors),并将其纳入一个更广义的框架中:所有可能的输出字符串被划分为有效输出(Valid, 𝒱) 和错误输出(Error, ℰ)。幻觉就是ℰ中那些最具迷惑性的成员——它们听起来太对了,以至于很难被察觉。

现有的许多研究试图通过后训练(Post-training)技术,如基于人类反馈的强化学习(RLHF),来“修补”幻觉问题。但本文指出,这些方法效果有限,因为它们没有触及问题的根本——预训练(Pretraining)阶段的统计本质和评估体系(Evaluation)的激励扭曲。

预训练阶段的幻觉起源:一个统计学习视角

为什么即使使用完全正确的数据训练,模型还是会产生错误?论文提出了一个非常巧妙的思路:将生成问题转化为一个分类问题。

核心思想:“这是有效输出吗?”(Is-It-Valid, IIV)

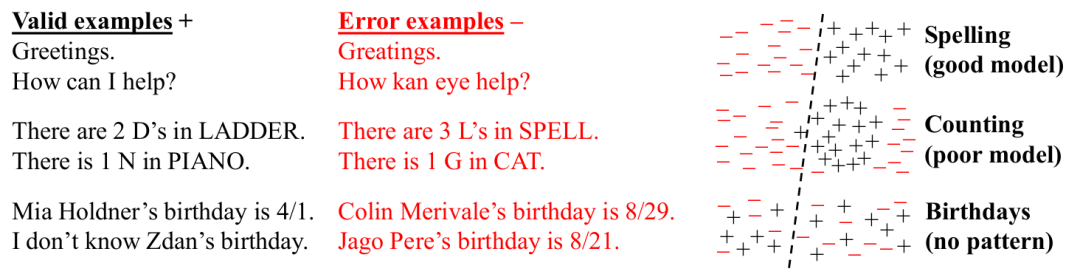

作者设想了一个二元分类任务:给定一个文本字符串,分类器需要判断它是否有效(+)还是错误(-)。这个任务的训练数据由两部分组成:

- 一半来自真实的训练数据(全部标记为+,假设训练数据无错误)。

- 另一半是从所有可能错误(ℰ)中均匀随机抽取的样本(全部标记为-)。

左图示意了IIV任务的训练数据构成,右图通过三个子图形象地展示了分类错误的几种原因:概念本身可分离、模型表达能力不足、数据中无模式可循。

任何一个训练好的语言模型,都可以被用来构建这样一个IIV分类器。方法很简单:对于一个候选回答,如果模型赋予它的概率高于某个阈值(例如 1/|ℰ|),就认为它是有效的(+),否则就是错误的(-)。

通过一系列推导,论文得出了生成错误率(err)与IIV分类错误率(err_Iiv)之间的数学关系:

err ≥ 2 · err_Iiv - |𝒱|/|ℰ| - δ

- err: 语言模型产生错误(即幻觉)的概率。

- err_Iiv: 对应的IIV分类器的错误率。

- |𝒱|/|ℰ|: 有效输出数与错误输出数的比值。通常|ℰ|远大于|𝒱|(例如,对于生日问题,有364个错误日期和1个正确日期),所以这项很小。

- δ: 校准误差(Calibration Error),衡量模型对自己预测的置信度是否准确。论文论证了,通过标准交叉熵损失训练出的模型,δ会很小。

这个公式为什么重要?

它揭示了生成错误的根源在于分类错误。如果一个问题本质上是难以分类的(即err_Iiv很高),那么任何试图学好语言分布的模型,都不可避免地会产生大量幻觉。这就像让一个学生去区分无数个看似合理的错误答案和少数正确答案,一旦他无法完美区分,在生成时就会“说错话”。

一个特例:任意事实与“单例率”

论文进一步分析了一种极端情况:任意事实(Arbitrary Facts)。比如无数名人的生日,这些数据之间没有任何可学习的模式(知道爱因斯坦的生日并不能帮你猜出Kalai的生日)。在这种情况下,模型唯一能学习的方式就是“记忆”。

作者引入了单例率(Singleton Rate, sr) 的概念,即在整个训练数据中,只出现过一次的事实(Prompt)所占的比例。例如,某位名人的生日只在某篇讣告中出现过一次。基于著名的古德-图灵估计(Good-Turing Estimator),论文证明:

- 幻觉率的下界大约是单例率(err ≳ sr)。

- 这意味着,如果训练数据中20%的事实只出现一次,那么模型在遇到这些事实时,至少会有20%的概率产生幻觉。

这从统计学的角度解释了开头的生日例子:模型没有记住那些不常出现的事实,于是只能“猜”,一猜就错。

后训练阶段为何幻觉持续存在:评估体系的“激励扭曲”

预训练埋下了幻觉的种子,那么后训练为什么没能根除它呢?论文给出了一个发人深省的“社会技术”解释:不是后训练不努力,而是当前的评估体系“奖励幻觉,惩罚诚实”。

一个精妙的类比:考试猜答案

作者将语言模型比作学生。在传统的选择题或填空题考试中,评分规则是二元的(答对得1分,答错或空白得0分)。在这种规则下,一个理性的学生即使完全不会,猜一个答案的期望得分(>0)也高于留白(0)。因此,“猜测”成为了最优策略。

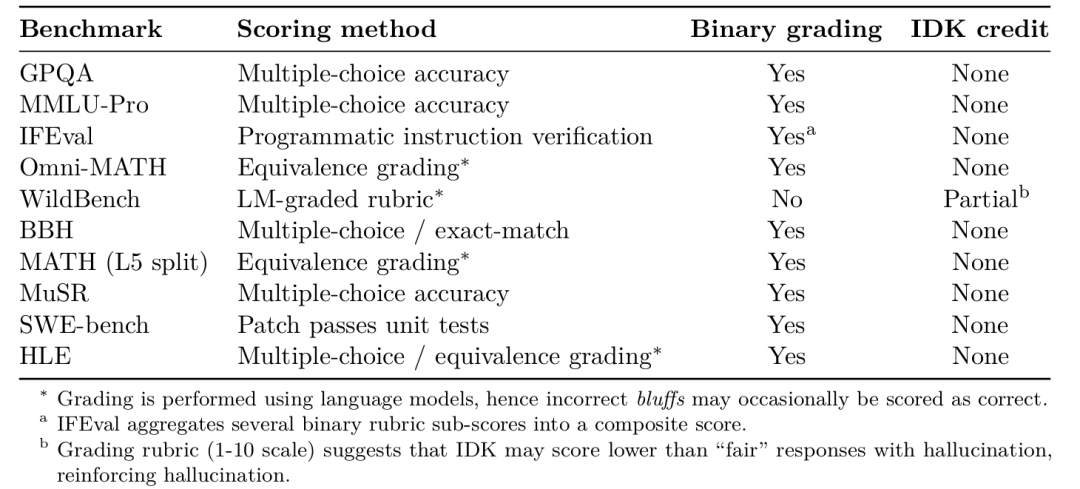

语言模型面临的正是这样的“考试”。绝大多数主流评估基准(如MMLU, GPQA, MATH等)都采用这种二元评分(Binary Grading):只判断最终答案的对错,对于“我不知道”(IDK)或请求澄清等表达不确定性的回答,一律给0分。

该表总结了主流评估基准对“不确定”回答的处理方式。可见,除了WildBench可能给少量故分外,其他所有基准对IDK都是零容忍。

Observation 1 的证明与含义

论文通过一个简短的证明(见附录E)形式化了这一观点:对于任何二元评分规则,最优策略都不是 abstain(放弃回答)。也就是说,只要模型想在这些排行榜上取得好成绩,它就必须在不确定时也硬着头皮猜一个答案,而不是诚实地表示不知道。

这就造成了一种“流行病”:专注于减少幻觉的模型(Model A)在主流评测中分数反而会低于那个总是瞎猜的模型(Model B)。因此,为了在排行榜上名列前茅,模型开发者有强烈的动机去优化“猜测能力”,而不是“诚实度”。这形成了一个恶性循环,使得幻觉问题难以从根本上解决。

解决方案:显式置信度目标

如何打破这个循环?论文没有提出新的模型架构或复杂的算法,而是指向了一个更根本的解决方案:改革评估体系。

作者提议,在评估的指令(Prompt)中明确告知模型本次的“置信度目标”(Confidence Target)。例如,可以在每个问题后附加这样一句话:

“请仅在置信度 > 90% 时回答,因为答错一题会扣9分,答对得1分,回答‘我不知道’得0分。”

这样,模型就需要进行风险决策。只有当它对自己答案正确的概率(即置信度)高于阈值时,回答才是有收益的。否则,选择“我不知道”才是更优策略。

行为校准

这引出了一个比概率校准更实用的概念——行为校准(Behavioral Calibration)。我们不要求模型输出一个准确的概率值(例如,“我有73.5%的把握”),而是要求它根据明确的规则,做出最优的决策行为(回答 or 不回答)。这种行为更容易被评估和优化。

论文强调,应将这种显式置信度目标整合到现有的主流评估中(如SWE-bench, MMLU),而不是仅仅创建新的、孤立的“幻觉评测”。只有这样,才能扭转整个领域的激励方向,让“诚实”成为模型的核心竞争力。

其他影响因素与讨论

论文还简要讨论了导致幻觉的其他因素,表明其理论框架的包容性:

- 计算复杂性:对于一些计算上极难的问题(如解密一个强加密密文),模型几乎不可能答对,其表现不会比随机猜测好多少。

- 分布偏移:如果用户的问题与模型训练所见的数据分布差异很大,模型表现会下降,错误率升高。

- GIGO:如果训练数据本身就有大量错误(垃圾进),模型自然会学到并生成这些错误(垃圾出)。

论文也坦诚了其模型的局限性,例如它主要针对事实性问答,而对开放性生成任务中的部分幻觉或由于提示歧义(潜在上下文)引发的错误难以完美刻画。但这并不影响其核心结论的有效性。

结论

这篇论文为理解语言模型幻觉问题做出了两大核心贡献:

- 理论:它建立了了一个统一的理论框架,通过一个巧妙的归约(Reduction),将生成模型的幻觉问题与经典的二元分类错误问题联系起来。这深刻地揭示了幻觉并非不可理解的妖魔鬼怪,而是统计学习过程中一个自然的、甚至必然的产物。其关于“单例率”的分析尤为精彩,给出了幻觉率的一个定量下界。

- 实践:它一针见血地指出,当前评估体系的扭曲激励是幻觉难以根除的症结所在,并提出了一个极具操作性的解决方案——在主流评估中引入显式置信度目标。这将引导整个领域从“鼓励猜测”转向“奖励诚实”,为开发真正可信的AI系统铺平了道路。

这项研究的价值在于,它超越了单纯的技术改良,从方法论的层面进行了深刻的反思。它告诉我们,解决AI的安全与信任问题,有时不仅需要更先进的算法,更需要设计更明智的“游戏规则”。未来,我们期待看到更多评估标准接纳这一思想,也期待语言模型能够发展出更丰富的语用能力,学会像人类一样恰当地表达确信与 uncertainty。

最后

为什么要学AI大模型

当下,⼈⼯智能市场迎来了爆发期,并逐渐进⼊以⼈⼯通⽤智能(AGI)为主导的新时代。企业纷纷官宣“ AI+ ”战略,为新兴技术⼈才创造丰富的就业机会,⼈才缺⼝将达 400 万!

DeepSeek问世以来,生成式AI和大模型技术爆发式增长,让很多岗位重新成了炙手可热的新星,岗位薪资远超很多后端岗位,在程序员中稳居前列。

与此同时AI与各行各业深度融合,飞速发展,成为炙手可热的新风口,企业非常需要了解AI、懂AI、会用AI的员工,纷纷开出高薪招聘AI大模型相关岗位。

最近很多程序员朋友都已经学习或者准备学习 AI 大模型,后台也经常会有小伙伴咨询学习路线和学习资料,我特别拜托北京清华大学学士和美国加州理工学院博士学位的鲁为民老师给大家这里给大家准备了一份涵盖了AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频 全系列的学习资料,这些学习资料不仅深入浅出,而且非常实用,让大家系统而高效地掌握AI大模型的各个知识点。

这份完整版的大模型 AI 学习资料已经上传优快云,朋友们如果需要可以微信扫描下方优快云官方认证二维码免费领取【保证100%免费】

AI大模型系统学习路线

在面对AI大模型开发领域的复杂与深入,精准学习显得尤为重要。一份系统的技术路线图,不仅能够帮助开发者清晰地了解从入门到精通所需掌握的知识点,还能提供一条高效、有序的学习路径。

但知道是一回事,做又是另一回事,初学者最常遇到的问题主要是理论知识缺乏、资源和工具的限制、模型理解和调试的复杂性,在这基础上,找到高质量的学习资源,不浪费时间、不走弯路,又是重中之重。

AI大模型入门到实战的视频教程+项目包

看视频学习是一种高效、直观、灵活且富有吸引力的学习方式,可以更直观地展示过程,能有效提升学习兴趣和理解力,是现在获取知识的重要途径

光学理论是没用的,要学会跟着一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

海量AI大模型必读的经典书籍(PDF)

阅读AI大模型经典书籍可以帮助读者提高技术水平,开拓视野,掌握核心技术,提高解决问题的能力,同时也可以借鉴他人的经验。对于想要深入学习AI大模型开发的读者来说,阅读经典书籍是非常有必要的。

600+AI大模型报告(实时更新)

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

AI大模型面试真题+答案解析

我们学习AI大模型必然是想找到高薪的工作,下面这些面试题都是总结当前最新、最热、最高频的面试题,并且每道题都有详细的答案,面试前刷完这套面试题资料,小小offer,不在话下

这份完整版的大模型 AI 学习资料已经上传优快云,朋友们如果需要可以微信扫描下方优快云官方认证二维码免费领取【保证100%免费】

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?