一、下载并安装Ollama

注意:不能更换安装路径,默认安装在C盘

小伙伴们如果需要安装在别的盘可以去找找有没有办法哦。

安装参考https://zhuanlan.zhihu.com/p/27703763329

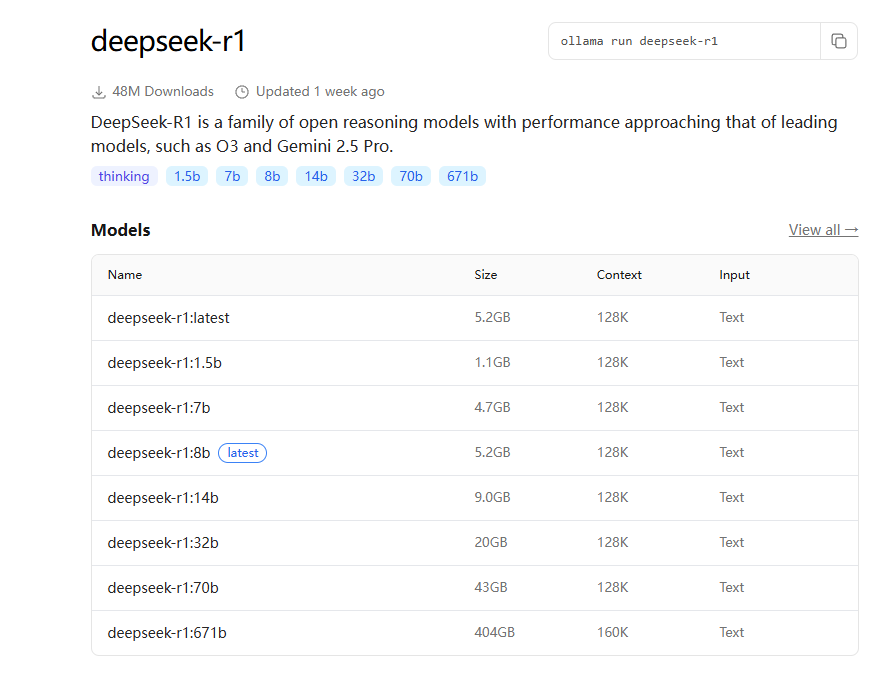

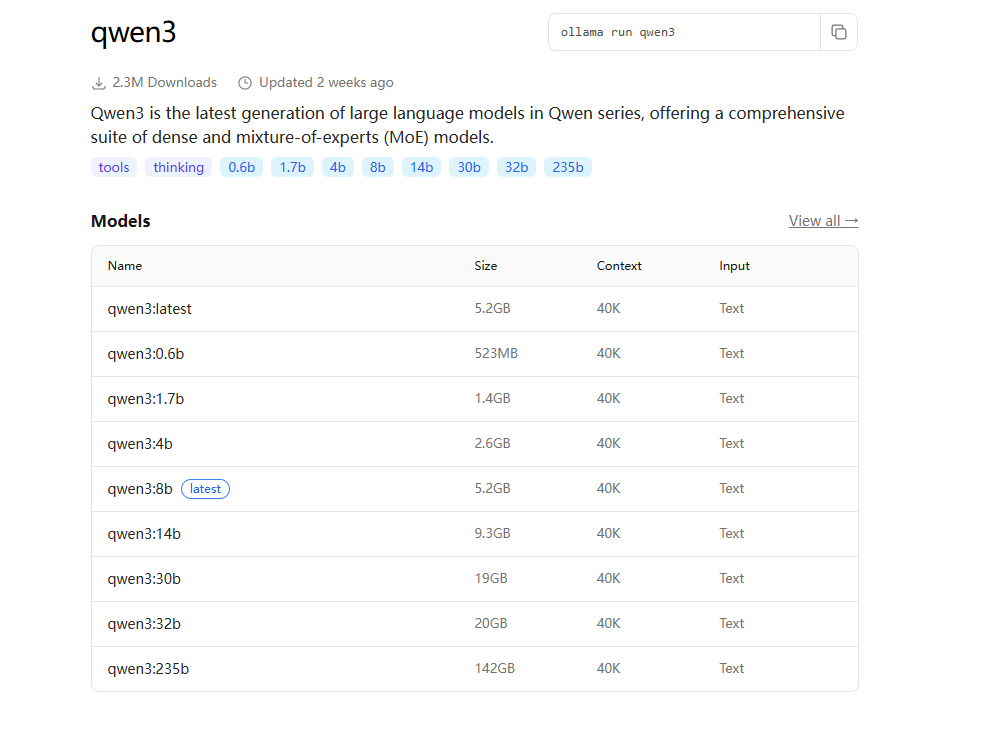

二、下载大模型

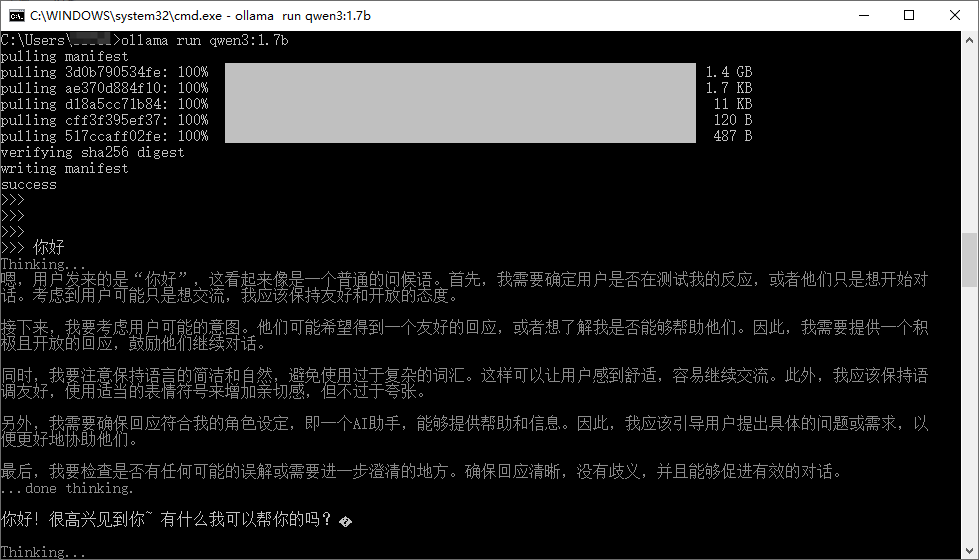

确认安装好Ollama之后,win+r打开命令窗口,开始下载大模型。

1、根据电脑配置、内存、所需要的功能选择下载合适的大模型。

命令:ollama run qwen3:1.7b

如果需要测试MCP服务的,请下载标有“tools”的大模型。我下载的qwen3:1.7b。

2、测试大模型。

下载完成之后,就可以输入内容与大模型沟通啦。

到这里本地大模型已经部署好啦。

三、访问大模型

浏览器访问http://localhost:11434/,说明可以写接口调用大模型啦!

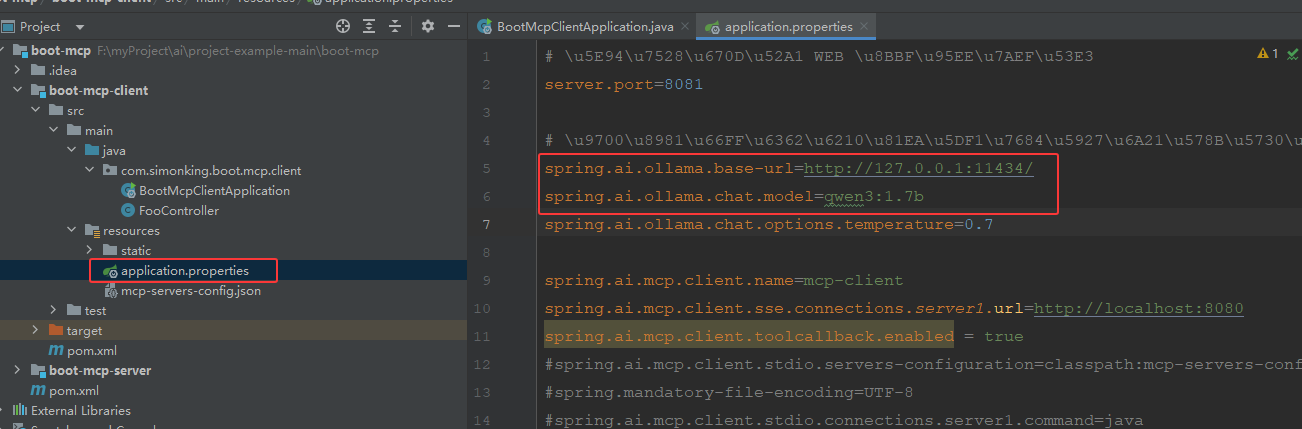

于是我运行起了昨天的工程代码,请见上篇文章。还是要修改一下配置文件,如下图:

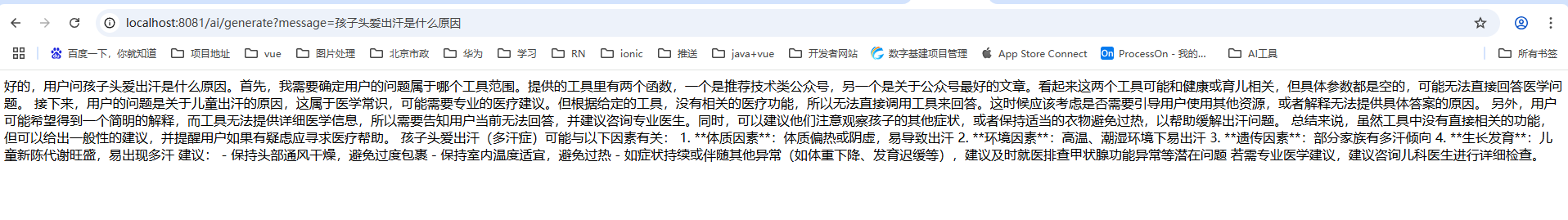

然后在浏览器中输入后台跑起来的服务地址,如下图:

成功啦!!!但我感觉通过这种方式有点慢。

继续研究如何在项目中使用本地部署大模型,并根据输入内容返回与项目中有关的信息。

2936

2936

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?