准备设备: 手机+aidlux2.0个人版

一、下载依赖

pip install langchain langchain-community faiss-cpu pypdf

二、安装ollama并下载模型

curl -fsSL https://ollama.com/install.sh | sh #需要科学上网

ollama serve & #让ollama服务在后台运行

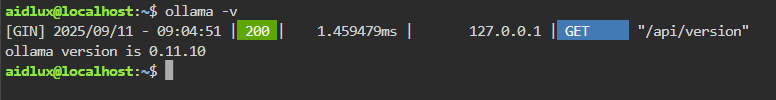

安装完毕可以查看ollama版本进行验证,出现版本号之后就可以使用ollama

ollama -v

考虑性能因素,选择下载较小的模型

ollama pull phi3:mini

ollama pull all-minilm

三、构建rag知识库

- 打开手机上的aidlux应用,打开Cloud_ip查看网络ip,输入ip到浏览器+端口号

:8000访问

输入以下命令:

cd ~

touch build_knowledge_base.py

- 在文件浏览器中/home/aidlux 下找到对应py文件并打开

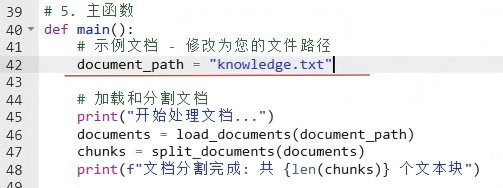

- 自行准备一个知识库文本(txt或pdf),将文本的路径填入脚本中

- 写入以下脚本内容

from langchain_community.document_loaders import PyPDFLoader, TextLoader

from langchain_text_splitters import RecursiveCharacterTextSplitter

from langchain_community.embeddings import OllamaEmbeddings

from langchain_community.vectorstores import FAISS

import os

# 1. 设置环境变量优化 Ollama 性能

os.environ["OLLAMA_NUM_THREADS"] = "8" # 设置线程数

os.environ["OLLAMA_NUM_CTX"] = "2048" # 设置上下文长度

# 2. 配置嵌入模型 - 移除无效参数

embeddings = OllamaEmbeddings(

model="all-minilm" # 仅保留必要参数

)

# 3. 加载文档

def load_documents(file_path):

if file_path.endswith(".pdf"):

loader = PyPDFLoader(file_path)

print(f"加载 PDF 文档: {

file_path}")

elif file_path.endswith(".txt"):

loader = TextLoader(file_path)

print(f"加载文本文档: {

file_path}")

else:

raise 使用Langchain搭建RAG知识库系统

使用Langchain搭建RAG知识库系统

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2899

2899

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?