目录

前言

📅大四是整个大学期间最忙碌的时光,一边要忙着备考或实习为毕业后面临的就业升学做准备,一边要为毕业设计耗费大量精力。近几年各个学校要求的毕设项目越来越难,有不少课题是研究生级别难度的,对本科同学来说是充满挑战。为帮助大家顺利通过和节省时间与精力投入到更重要的就业和考试中去,学长分享优质的选题经验和毕设项目与技术思路。

🚀对毕设有任何疑问都可以问学长哦!

选题指导:

最新最全计算机专业毕设选题精选推荐汇总

大家好,这里是海浪学长毕设专题,本次分享的课题是

🎯基于深度学习的纹理布匹瑕疵检测系统研究

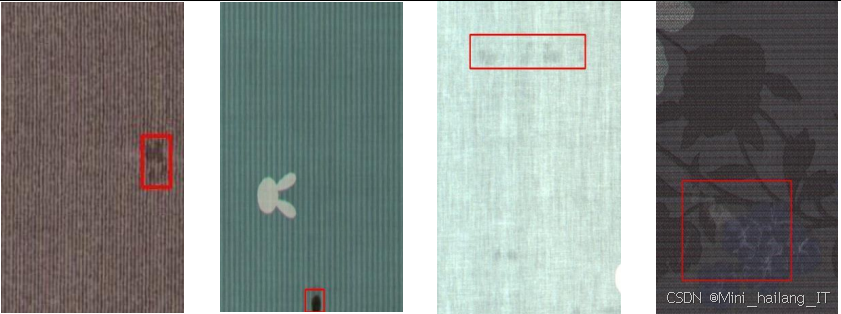

选题意义背景

在现代纺织工业中,布匹质量检测是生产流程中至关重要的环节,直接关系到最终产品的质量和企业的经济效益。随着纺织行业的快速发展和自动化程度的不断提高,传统的人工检测方式已经难以满足大规模生产的需求。人工检测不仅效率低下,而且容易受到检测人员疲劳、经验和主观因素的影响,导致漏检和误检率较高。据统计,2023年间,全球纺织业对自动化检测技术的需求年均增长率超过15%,这充分说明了该领域的重要性和市场潜力,虽然计算机视觉技术在目标检测领域取得了显著进展,但在纹理布匹瑕疵检测任务中仍然面临诸多挑战。- 布匹瑕疵种类繁多,据不完全统计,常见的布匹瑕疵种类超过70种,每种瑕疵的形态、大小和特征各不相同。- 纹理布匹的背景信息复杂,不同材质和织法的布匹具有不同的纹理特征,这些复杂的纹理背景会对瑕疵检测造成严重的干扰。此外,布匹瑕疵在数据集中往往存在严重的类别不平衡问题,一些常见瑕疵的样本数量可能是罕见瑕疵的数十倍甚至上百倍,这种数据不平衡会导致训练出的模型在稀有瑕疵上表现不佳。

2023年间,深度学习技术在工业缺陷检测领域的应用呈现爆发式增长。卷积神经网络作为深度学习的核心技术之一,凭借其强大的特征提取能力,在图像分类、目标检测和语义分割等任务中取得了突破性进展。特别是在布匹瑕疵检测领域,基于CNN的方法逐渐取代了传统的计算机视觉方法,成为当前研究的热点。目前,主流的深度学习瑕疵检测方法主要包括单阶段检测器和两阶段检测器,但这些方法在面对复杂纹理背景和稀有瑕疵时仍然存在一定的局限性,针对纹理布匹瑕疵检测中的关键技术问题进行深入探讨,提出了一系列改进和优化方法,旨在提高瑕疵检测的准确率和效率。研究成果不仅可以应用于纺织行业的实际生产中,提高产品质量和生产效率,降低人工成本,还可以为其他领域的缺陷检测提供借鉴和参考。同时,本研究中提出的针对类别不平衡的Multi Focal Loss损失函数、基于DIOU的加权NMS方法以及改进的FPN结构等技术创新,也为深度学习目标检测领域的发展做出了贡献。

数据集

数据获取

本研究使用的数据集主要来源于两个渠道:工业合作伙伴提供的实际生产线上采集的布匹图像数据,以及公开的布匹瑕疵检测数据集。为了保证数据的多样性和代表性,我们与多家纺织企业建立了合作关系,在不同的生产环境和设备条件下采集了大量的真实布匹图像。采集过程中,我们使用了高精度的工业相机,并在标准的光照条件下进行拍摄,以确保图像质量的一致性。同时,我们还对公开的数据集进行了筛选和整合,选取了与本研究相关的部分进行使用,在数据采集过程中,我们遵循了严格的标准操作流程:- 确定需要采集的布匹类型和瑕疵类别;然后,调整相机参数和光照条件;接着,对每批样品进行多角度、多距离的拍摄;最后,对采集的图像进行初步的质量检查,确保没有模糊、曝光不当等问题。对于难以获取的稀有瑕疵样本,我们采用了合成数据生成和数据增强相结合的方法进行补充,以缓解数据不平衡问题。

数据格式与数据规模

本研究使用的数据集采用了统一的格式进行存储和管理。所有图像均保存为JPEG格式,分辨率为2048×1024像素,这一分辨率既能保证图像的清晰度,又不会导致计算量过大。每张图像都配有对应的标注文件,采用XML格式进行存储,标注信息包括瑕疵的类别、位置、大小等。为了便于数据的管理和使用,我们建立了专门的数据管理系统,对所有数据进行了分类、索引和版本控制,数据集的规模是保证模型性能的重要因素。经过多轮的数据采集和整理,本研究最终使用的数据集包含了来自不同厂家、不同材质、不同纹理的布匹图像共计25,000张。其中,训练集18,000张,验证集4,000张,测试集3,000张。数据集中涵盖了30种常见的布匹瑕疵类型,包括断纱、毛球、破洞、油污、色差等,每种瑕疵的样本数量从100到2,000不等,充分反映了实际生产中的数据分布情况。

类别定义

布匹瑕疵的精确定义和分类是保证检测准确性的前提。基于相关行业标准和专家知识,我们对数据集中的瑕疵进行了系统的分类和定义。根据瑕疵的成因和形态特征,我们将所有瑕疵分为六大类:

- 纱线相关瑕疵:包括断纱、粗纱、细纱、松纱等,主要由纱线质量问题或织造过程中的异常引起。

- 织疵:包括跳纱、错纬、密路、稀路等,主要由织机故障或操作不当导致。

- 染色相关瑕疵:包括色差、色渍、色花等,主要由染色工艺或染料质量问题引起。

- 机械损伤:包括破洞、撕裂、划痕等,主要由机械摩擦或外力作用导致。

- 污渍类瑕疵:包括油污、灰尘、水渍等,主要由生产环境或后期污染引起。

- 其他瑕疵:包括毛球、起皱、变形等难以归类的瑕疵类型。

每大类下又包含若干具体的瑕疵子类,总共30种具体的瑕疵类型。对于每种瑕疵,我们都制定了详细的判定标准和特征描述,以确保标注的一致性和准确性。标注工作由具有丰富经验的质检人员完成,并经过多人交叉验证,以减少人为误差。

数据分割策略

合理的数据分割策略对于模型的训练和评估至关重要。为了避免数据泄露和过拟合问题,我们采用了分层随机抽样的方法进行数据分割,确保训练集、验证集和测试集中各类别瑕疵的分布比例与原始数据集基本一致。具体来说,我们首先将所有图像按照瑕疵类别进行分组,然后在每个类别内部按照7:1.6:1.4的比例随机抽取样本,分别组成训练集、验证集和测试集。这样做可以保证每个子集都包含足够多样的瑕疵类型,特别是对于稀有瑕疵类别,也能保证在各个子集中都有一定的样本数量。

在数据分割过程中,我们还特别注意了以下几点:- 来自同一个生产批次的布匹图像尽量不要同时出现在训练集和测试集中,以减少数据的相似性;- 对于具有相似纹理特征的布匹,我们确保它们在各个子集中都有分布,以增强模型的泛化能力;最后,我们对分割后的数据集进行了统计分析,验证各类别的分布是否符合预期,并根据需要进行了适当的调整。

数据预处理

数据预处理是深度学习模型训练的重要环节,可以显著提高模型的性能和训练效率。针对纹理布匹图像的特点,我们设计了一套完整的数据预处理流程:

-

图像归一化:将图像像素值从[0, 255]范围归一化到[0, 1]范围,以加速模型训练的收敛速度。

-

图像裁剪和缩放:由于原始图像分辨率较高,直接输入模型会导致计算量过大,因此我们采用了图像裁剪和缩放相结合的方法。- 根据标注的边界框信息,将包含瑕疵的区域裁剪出来,并保留一定的上下文信息;然后,将裁剪后的图像缩放到统一的尺寸以适应模型的输入要求。

-

数据增强:为了扩充训练数据,提高模型的泛化能力,我们采用了多种数据增强技术,包括:

- 随机旋转- 随机缩放- 随机翻转- 亮度和对比度调整

- 高斯模糊

- 随机裁剪

-

背景纹理标准化:针对不同纹理布匹的背景差异问题,我们采用了纹理标准化技术,通过计算图像的局部二值模式特征,对背景纹理进行归一化处理,以减少背景干扰对瑕疵检测的影响。

-

标注数据处理:对标注数据进行检查和修正,确保边界框的准确性;将XML格式的标注转换为模型训练所需的格式。

通过上述预处理步骤,我们不仅提高了数据的质量和多样性,还增强了模型对不同环境和条件下布匹图像的适应能力,为后续的模型训练和评估奠定了良好的基础。

功能模块介绍

特征提取模块

特征提取是目标检测任务的核心环节,直接影响检测的准确性。本研究采用了改进的ResNet50+网络作为特征提取的主干网络,以充分利用深度学习在特征提取方面的优势,ResNet50+网络是在原始ResNet50的基础上进行优化得到的,主要改进包括:

-

残差块优化:在保留原始ResNet残差连接结构的基础上,对残差块内部的卷积层进行了调整,增加了小卷积核的使用比例,以更好地捕捉布匹纹理的细节特征。

-

注意力机制引入:在网络的关键位置引入了通道注意力机制,通过学习不同通道的重要性权重,使网络能够自动关注与瑕疵相关的特征信息,抑制背景纹理的干扰。

-

特征融合优化:改进了网络中不同层级特征的融合方式,采用了更高效的跳跃连接结构,使浅层的细节特征和深层的语义特征能够更好地结合,从而提高对不同大小瑕疵的检测能力。

特征提取模块的工作流程如下:- 输入的布匹图像经过预处理后,被送入ResNet50+网络;然后,网络通过一系列的卷积、池化和残差连接操作,逐步提取图像的多尺度特征;最后,输出的特征图将被传递给后续的检测模块进行进一步处理。

为了验证ResNet50+的有效性,我们进行了对比实验,将其与原始的VGG16和ResNet50网络进行了比较。

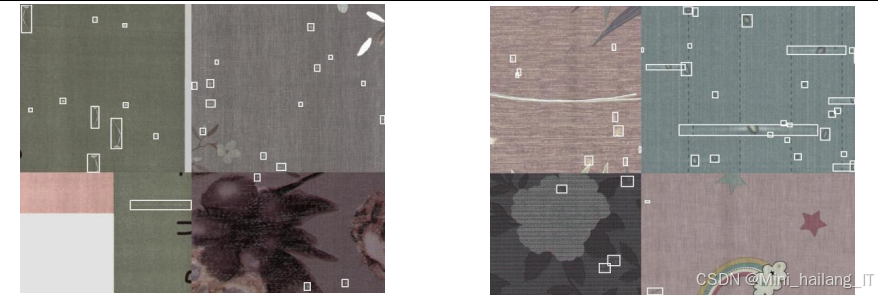

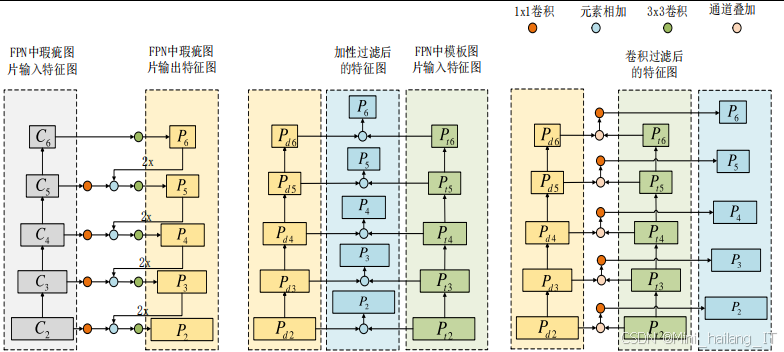

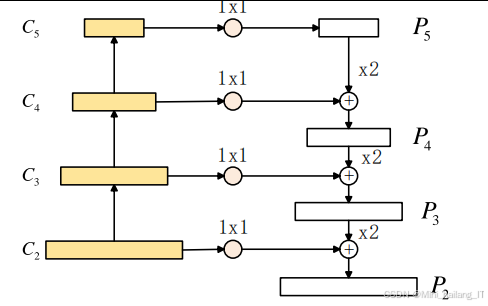

多尺度特征融合模块

针对不同大小瑕疵的检测问题,本研究设计了一种基于特征金字塔网络的多尺度特征融合模块,并对其进行了改进,提出了F-FPN结构。F-FPN结构的核心思想是在传统FPN的基础上,引入模板图像对比机制,通过与无瑕疵的模板图像进行特征差异分析,有效地过滤掉背景纹理的干扰,突出瑕疵区域的特征。具体实现包括以下几个步骤:

-

特征金字塔构建:- 利用ResNet50+网络提取的不同层级特征图,构建一个自下而上的特征金字塔;然后,通过自上而下的上采样和横向连接,生成融合了多尺度信息的特征金字塔。

-

模板对比过滤:对于每一层特征图,我们引入了对应的无瑕疵模板图像特征进行对比分析。通过计算当前图像特征与模板图像特征的差异,得到一个差异特征图,该特征图能够有效地突出瑕疵区域,抑制背景纹理。

-

自适应特征增强:在差异特征图的基础上,我们设计了一个自适应特征增强模块,通过学习不同位置的重要性权重,对差异特征进行加权增强,进一步提高瑕疵区域的特征表达能力。

-

多尺度特征融合:最后,将不同层级的增强特征进行融合,生成最终的多尺度特征表示,用于后续的检测任务。

F-FPN模块的工作流程如下:- 接收ResNet50+网络输出的多尺度特征图;然后,通过模板对比和特征增强操作,过滤背景纹理并突出瑕疵特征;最后,输出融合后的多尺度特征,供检测头使用。

检测头模块

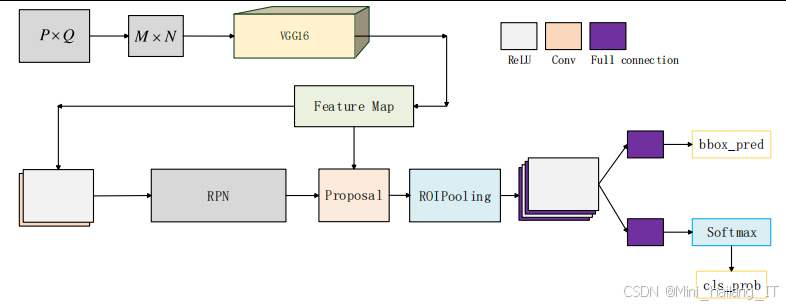

检测头模块是目标检测模型的关键组件,负责对特征图进行分析,生成最终的检测结果。本研究基于Faster R-CNN的检测头结构进行了优化,主要包括区域建议网络和检测网络两个部分,区域建议网络的主要功能是生成可能包含瑕疵的候选区域。我们对RPN进行了以下改进:

-

锚框设计优化:针对布匹瑕疵的特点,设计了更适合的锚框尺度和长宽比,包括多种小尺度的锚框,以适应不同大小的瑕疵。

-

分类器优化:改进了RPN中的分类器结构,采用更轻量级的网络设计,在保证性能的同时减少计算量。

-

回归器优化:优化了边界框回归器,采用了更精确的坐标预测方法,提高了候选框的定位精度。

检测网络负责对候选区域进行分类和边界框回归。我们对检测网络的改进包括:

-

感兴趣区域池化改进:采用了RoI Align技术替代传统的RoI Pooling,避免了两次量化操作带来的精度损失,提高了边界框的定位精度。

-

分类器设计:采用了双线性池化技术,增强了特征的表达能力,提高了分类的准确性。

-

边界框回归优化:使用了基于IoU的边界框回归损失函数,使模型能够直接优化IoU指标,提高了定位精度。

检测头模块的工作流程如下:- RPN接收来自F-FPN的特征图,生成候选区域;然后,对每个候选区域进行RoI Align操作,提取固定尺寸的特征;最后,通过分类器和回归器,得到每个候选区域的类别和精确的边界框坐标,为了提高检测的准确性和效率,我们还对非极大值抑制算法进行了改进,提出了基于DIOU的加权NMS方法。该方法在去除冗余候选框时,不仅考虑了两个框之间的重叠程度,还加入了两者之间的距离作为衡量指标,能够更准确地保留最佳候选框,特别是在处理重叠的同类瑕疵时,效果更加显著。

损失函数优化模块

损失函数的设计直接影响模型的训练效果,特别是在处理类别不平衡问题时。本研究设计了一种名为Multi Focal Loss的损失函数,用于平衡各类别在训练过程中的贡献。Multi Focal Loss的核心思想是:

-

类别权重调整:根据各类别的样本数量,为每个类别分配不同的权重,样本数量越少的类别,权重越大,以平衡不同类别在损失函数中的贡献。

-

难易样本区分:引入了焦点损失的思想,通过一个调制因子,降低易分样本的权重,提高难分样本的权重,使模型在训练过程中更加关注难分样本。

-

多任务损失融合:将分类损失和回归损失进行有效的融合,通过动态调整两者的权重,使模型能够同时优化分类和定位性能。

Multi Focal Loss的实现包括以下几个部分:

-

分类损失计算:基于交叉熵损失,加入类别权重和难易样本调制因子,得到加权的分类损失。

-

回归损失计算:采用IoU损失或Smooth L1损失,计算预测边界框与真实边界框之间的差异。

-

损失融合:将分类损失和回归损失进行加权融合,得到最终的总损失函数。

在训练过程中,模型通过最小化Multi Focal Loss来优化参数,从而提高对稀有瑕疵和难分样本的检测能力。

模型压缩模块

为了提高模型的推理速度,使其能够更好地应用于实际生产环境,本研究设计了模型压缩模块,从紧凑网络设计和模型剪枝两个角度对模型进行优化,紧凑网络设计方面,我们主要采用了以下技术:

-

分组卷积:将标准卷积操作中的输入和输出通道分成多个组,每个组独立进行卷积运算,然后将结果合并。这样可以显著减少模型的参数量和计算量,同时保持较好的特征提取能力。

-

深度可分离卷积优化:对传统的深度可分离卷积进行了改进,在深度卷积和逐点卷积之间加入了批归一化和激活函数,并引入了残差连接结构,提高了特征的表达能力。

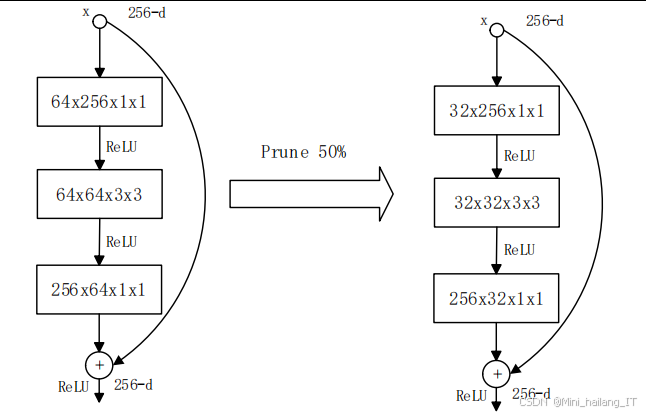

模型剪枝方面,我们采用了基于ThiNet的网络剪枝方法:

-

重要性评估:通过分析每个卷积核对模型输出的贡献,评估其重要性,为后续的剪枝提供依据。

-

结构化剪枝:对ResNet50+网络中的卷积层进行结构化剪枝,删除那些不重要的卷积核,同时保持网络结构的完整性。在剪枝过程中,我们特别注意了残差块中卷积层的剪枝策略,确保最后一层卷积输出和skip connection的输出通道数一致。

-

剪枝后微调:在每次剪枝后,使用较小的学习率对模型进行微调,以恢复部分性能损失。完成所有剪枝后,使用较大的学习率再次训练模型,以进一步提升性能。

模型压缩模块的工作流程如下:- 对原始模型进行分析,确定压缩策略;然后,采用紧凑网络设计或模型剪枝方法对模型进行压缩;最后,对压缩后的模型进行微调,确保其性能满足要求。

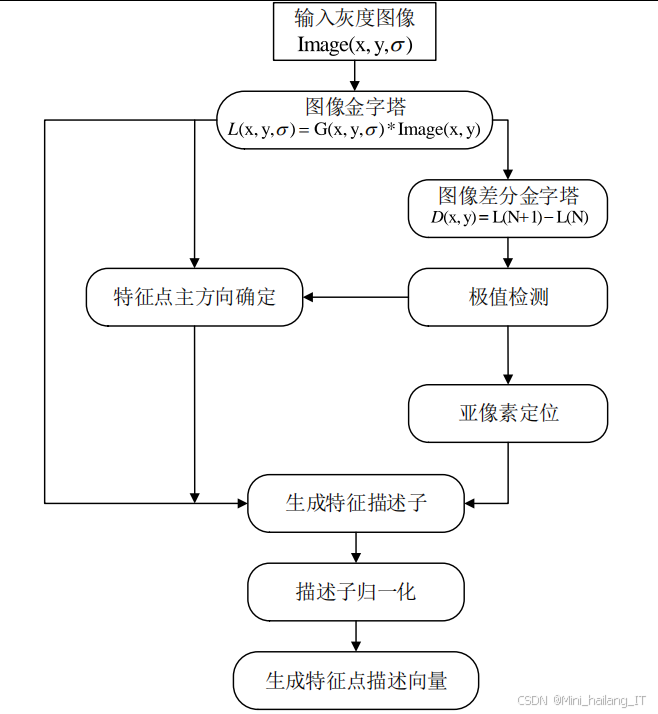

算法理论

卷积神经网络基础理论

卷积神经网络是深度学习中用于处理图像数据的主要模型,其核心思想是通过卷积操作自动提取图像的特征。CNN的基本组成包括卷积层、池化层、激活函数和全连接层:卷积层是CNN的核心组件,通过卷积核与输入图像进行卷积运算,提取局部特征。卷积操作具有局部连接、权值共享和平移不变性等特点,能够有效地减少模型参数量,提高特征提取效率,池化层用于降低特征图的空间分辨率,减少计算量,同时增强特征的鲁棒性。常用的池化操作包括最大池化和平均池化,激活函数用于引入非线性变换,使网络能够拟合复杂的函数关系。常用的激活函数包括ReLU、Leaky ReLU、Sigmoid和Tanh等。

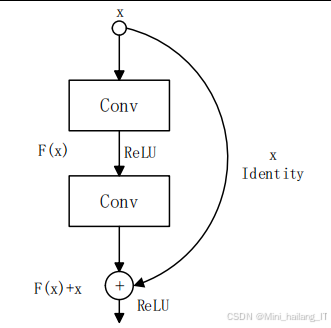

ResNet50+网络理论

ResNet50+网络是在ResNet50的基础上改进得到的,其核心是残差学习的思想。传统的深层神经网络在训练过程中容易出现梯度消失或梯度爆炸问题,导致网络难以训练。残差学习通过引入跳跃连接,将输入直接传递到输出,使网络只需要学习输入和输出之间的残差,从而有效地缓解了深层网络的训练困难。

ResNet50+对原始ResNet50的改进主要体现在以下几个方面:

-

瓶颈结构优化:采用了1×1-3×3-1×1的瓶颈结构,在减少参数量的同时,提高了特征提取能力。

-

注意力机制:引入了通道注意力模块,通过自适应地调整不同通道的权重,使网络能够更加关注重要的特征信息。通道注意力模块的核心是通过全局平均池化和两个全连接层,生成通道注意力权重,然后将其与输入特征图相乘,得到加权后的特征图。

-

分组卷积应用:在网络的部分层中引入了分组卷积,将输入和输出通道分成多个组,每个组独立进行卷积运算,然后将结果合并。分组卷积可以有效地减少参数量和计算量,同时增强模型的性能。

F-FPN特征融合理论

特征金字塔网络是一种用于多尺度目标检测的特征融合结构,其核心思想是通过自下而上的路径、自上而下的路径和横向连接,构建一个包含多尺度信息的特征金字塔。FPN的基本结构包括:

-

自下而上路径:由主干网络的特征提取层组成,随着网络深度的增加,特征图的空间分辨率逐渐降低,语义信息逐渐增强。

-

自上而下路径:通过上采样操作,将深层的高语义特征图上采样到与浅层特征图相同的空间分辨率。

-

横向连接:将自上而下路径中的特征图与自下而上路径中相同分辨率的特征图进行逐元素相加,融合浅层的细节特征和深层的语义特征。

F-FPN在传统FPN的基础上,引入了模板图像对比机制,其理论基础是背景纹理过滤。对于纹理布匹图像,瑕疵区域与背景区域的主要区别在于纹理的异常性。通过与无瑕疵的模板图像进行对比,可以有效地过滤掉背景纹理的干扰,突出瑕疵区域的特征。通过这种方式,F-FPN能够有效地过滤掉背景纹理的干扰,提高瑕疵检测的准确性,特别是对于那些与背景纹理相似的瑕疵,效果更加显著。

Multi Focal Loss损失函数理论

传统的目标检测模型通常采用交叉熵损失函数进行分类,采用Smooth L1损失函数进行边界框回归。然而,在处理类别不平衡问题时,这些传统损失函数往往表现不佳。Focal Loss是一种针对类别不平衡问题设计的损失函数,其核心思想是通过一个调制因子,降低易分样本的权重,提高难分样本的权重。Multi Focal Loss在Focal Loss的基础上进行了扩展,主要包括以下几个方面的改进:

-

动态类别权重:根据各类别的样本数量和难易程度,动态调整类别权重,使稀有类别和难分样本在损失函数中获得更大的权重。

-

多任务损失融合:将分类损失和回归损失进行有效的融合,通过动态调整两者的权重,使模型能够同时优化分类和定位性能。

-

梯度平衡:通过对损失函数的梯度进行分析,确保不同类别和不同任务的梯度大小相对平衡,避免某些类别或任务主导模型的训练过程。

通过这种设计,Multi Focal Loss能够有效地解决类别不平衡问题,提高模型对稀有瑕疵和难分样本的检测能力。

模型压缩理论

模型压缩是提高深度学习模型推理速度和部署效率的重要技术,主要包括紧凑网络设计、模型剪枝、量化和知识蒸馏等方法,紧凑网络设计通过设计更高效的网络结构,减少模型的参数量和计算量。常用的技术包括:

-

分组卷积:将输入和输出通道分成多个组,每个组独立进行卷积运算,然后将结果合并。分组卷积的计算量为标准卷积的1/g,能够显著减少计算量。

-

深度可分离卷积:将标准卷积分解为深度卷积和逐点卷积两个步骤。深度卷积对每个输入通道单独进行卷积,逐点卷积则通过1×1卷积融合不同通道的信息。深度可分离卷积的计算量约为标准卷积的1/k² + 1/c,能够有效地减少计算量。

模型剪枝通过删除模型中不重要的权重或结构,减少模型的参数量和计算量。常用的剪枝方法包括:

-

基于权重大小的剪枝:删除权重绝对值较小的连接,保留重要的连接。

-

基于激活值的剪枝:根据神经元的激活值大小,删除激活值较小的神经元。

-

基于梯度的剪枝:根据权重的梯度信息,评估其对模型输出的贡献,删除贡献较小的权重。

ThiNet是一种基于结构化剪枝的方法,其核心思想是通过分析卷积核之间的冗余性,删除那些对后续层输出影响较小的卷积核。ThiNet的剪枝过程主要包括以下几个步骤:

-

重要性评估:对于每个卷积层,计算每个卷积核被删除后对后续层输出的影响,评估其重要性。

-

选择剪枝目标:根据重要性评估结果,选择那些重要性较低的卷积核作为剪枝目标。

-

结构化剪枝:删除选定的卷积核,并相应地调整后续层的权重,以保持网络结构的完整性。

-

剪枝后微调:对剪枝后的模型进行微调,以恢复部分性能损失。

通过这些压缩技术,我们能够在保持模型性能的同时,显著减少模型的参数量和计算量,提高模型的推理速度和部署效率。

核心代码介绍

ResNet50+特征提取网络实现

以下是ResNet50+特征提取网络的核心实现代码。该代码定义了改进后的残差块结构和整个ResNet50+网络。通过引入注意力机制和改进的残差连接,ResNet50+能够更有效地提取纹理布匹的特征,特别是在处理复杂纹理背景时表现出色。

import torch

import torch.nn as nn

import torch.nn.functional as F

# 通道注意力模块

class ChannelAttention:

def __init__:

super__init__# 全局平均池化

self.avg_pool = nn.AdaptiveAvgPool2d# 两个全连接层构成的瓶颈结构

self.fc = nn.Sequential,

nn.ReLU,

nn.Linear,

nn.Sigmoid)

def forward:

b, c, _, _ = x.size# 全局平均池化,得到y = self.avg_pool.view# 通过全连接层生成注意力权重

y = self.fc.view# 将注意力权重与输入特征相乘

return x * y

# 改进的残差块

class Bottleneck:

expansion =

def __init__:

super.__init__# 1×1卷积,减少通道数

self.conv1 = nn.Conv2dself.bn1 = nn.BatchNorm2d# 3×3卷积,提取特征

self.conv2 = nn.Conv2dself.bn2 = nn.BatchNorm2d# 1×1卷积,恢复通道数

self.conv3 = nn.Conv2dself.bn3 = nn.BatchNorm2d# 激活函数

self.relu = nn.ReLU# 下采样模块,用于调整输入维度

self.downsample = downsample

# 引入通道注意力机制

self.ca = ChannelAttention# 残差连接权重,用于调整残差的重要性

self.residual_weight = nn.Parameter)

def forward:

identity = x

# 第一个卷积层

out = self.conv1out = self.bn1out = self.relu# 第二个卷积层

out = self.conv2out = self.bn2out = self.relu# 第三个卷积层

out = self.conv3out = self.bn3# 应用通道注意力

out = self.ca# 应用下采样if self.downsample is not None:

identity = self.downsample# 残差连接,引入权重参数

out += self.residual_weight * identity

out = self.relureturn out

# ResNet+网络

class ResNet50Plus:

def __init__:

super.__init__# 初始卷积层

self.in_channels = 64

self.conv1 = nn.Conv2dself.bn1 = nn.BatchNorm2dself.relu = nn.ReLUself.maxpool = nn.MaxPool2d# 四层残差块

self.layer1 = self._make_layerself.layer2 = self._make_layerself.layer3 = self._make_layerself.layer4 = self._make_layer# 全局平均池化和全连接层

self.avgpool = nn.AdaptiveAvgPool2d)

self.fc = nn.Lineardef _make_layer:

# 创建下采样模块

downsample = None

if stride != 1 or self.in_channels != out_channels * Bottleneck.expansion:

downsample = nn.Sequential,

nn.BatchNorm2d,

)

layers = []

# 添加第一个残差块layers.append)

self.in_channels = out_channels * Bottleneck.expansion

# 添加剩余的残差块

for _ in range:

layers.append)

return nn.Sequentialdef forward:

# 初始特征提取

x = self.conv1x = self.bn1x = self.relux = self.maxpool# 通过四层残差块

x = self.layer1# C1

x = self.layer2# C2

x = self.layer3# C3

x = self.layer4# C4

# 分类头x = self.avgpoolx = torch.flattenx = self.fcreturn x

F-FPN特征融合模块实现

以下是F-FPN特征融合模块的核心实现代码。该模块通过引入模板图像对比机制,能够有效地过滤掉背景纹理的干扰,突出瑕疵区域的特征。F-FPN在传统FPN的基础上,增加了模板特征提取和差异计算的步骤,提高了特征的表达能力。

import torch

import torch.nn as nn

import torch.nn.functional as F

# F-FPN特征融合模块

class F_FPN:

def __init__:

super__init__# 输入通道列表,对应不同层级的特征图

self.in_channels_list = in_channels_list

# 输出通道数

self.out_channels = out_channels

# 横向连接卷积层,用于调整各层级特征图的通道数

self.lateral_convs = nn.ModuleList# 输出卷积层,用于进一步处理融合后的特征

self.fpn_convs = nn.ModuleList# 模板特征提取卷积层

self.template_convs = nn.ModuleList# 差异特征增强模块

self.diff_enhance = nn.ModuleList# 初始化各层卷积

for in_channels in in_channels_list:

# 横向连接卷积

lateral_conv = nn.Conv2d# 输出卷积

fpn_conv = nn.Conv2d# 模板特征提取卷积

template_conv = nn.Conv2d# 差异特征增强模块

enhance_module = nn.Sequential,

nn.ReLU,

nn.Conv2d,

nn.Sigmoid)

self.lateral_convs.appendself.fpn_convs.appendself.template_convs.appendself.diff_enhance.append# 初始化权重

self._initialize_weightsdef _initialize_weights:

# 初始化各层卷积的权重

for m in self.modules:

if isinstance:

nn.init.kaiming_normal_if m.bias is not None:

nn.init.constant_def forward:

# 输入是各层级的特征图列表

assert len== lenassert len== len# 对每个层级的特征图进行横向连接处理

lateral_features = [lateral_convfor lateral_conv, input in zip]

# 对模板图像特征进行处理

template_features = [template_convfor template_conv, template in zip]

# 自上而下的特征融合

# 从最深层开始

fpn_features = [lateral_features[-1]]

# 计算差异特征并进行增强

diff_features = []

for i in range- 1, -1, -1):

# 计算当前特征与模板特征的差异

diff = lateral_features[i] - template_features[i]

# 应用差异特征增强

enhance_weight = self.diff_enhance[i]enhanced_diff = diff * enhance_weight

diff_features.append# 反转差异特征列表,使其与原始特征顺序一致

diff_features = diff_features[::-1]

# 进行自上而下的特征融合

for i in range- 2, -1, -1):

# 对深层特征进行上采样

upsample = F.interpolate# 将上采样的特征与当前层特征相加

fpn_feature = lateral_features[i] + upsample

# 添加融合后的特征

fpn_features.insert# 对每个融合后的特征应用输出卷积,并加入差异特征

outputs = []

for fpn_feature, diff_feature, fpn_conv in zip:

# 融合基础特征和差异特征

combined_feature = fpn_feature + diff_feature

# 应用输出卷积

output = fpn_convoutputs.appendreturn outputs

Multi Focal Loss损失函数实现

以下是Multi Focal Loss损失函数的核心实现代码。该损失函数通过动态调整类别权重和引入难易样本调制因子,能够有效地解决类别不平衡问题,提高模型对稀有瑕疵和难分样本的检测能力。

import torch

import torch.nn as nn

import torch.nn.functional as F

# Multi Focal Loss损失函数

class MultiFocalLoss:

def __init__:

super__init__# 类别数量

self.num_classes = num_classes

# 类别权重

self.alpha = alpha

if alpha is None:

# 如果没有提供alpha,则初始化为均匀分布

self.alpha = torch.oneselif isinstance):

# 如果alpha是列表或元组,则转换为张量

self.alpha = torch.tensor# 调制因子

self.gamma = gamma

# 损失聚合方式

self.reduction = reduction

def forward:

# inputs:- 模型的原始输出# targets:- 真实标签的索引

# weights:- 样本权重

# difficult_mask:- 困难样本掩码

# 确保alpha在正确的设备上

if self.alpha.device != inputs.device:

self.alpha = self.alpha.to# 计算类别概率

logpt = F.log_softmax# 选择每个样本对应真实类别的概率

pt = logpt.gather).squeeze# 计算alpha权重

if self.alpha is not None:

# 选择每个样本对应类别的alpha值

alpha_factor = self.alpha.gatherelse:

alpha_factor = 1.0

# 应用调制因子

focal_weight =.pow# 计算基础损失

loss = -alpha_factor * focal_weight * pt

# 应用样本权重if weights is not None:

loss = loss * weights

# 应用困难样本掩码if difficult_mask is not None:

loss = loss * difficult_mask

# 聚合损失

if self.reduction == 'mean':

return loss.meanelif self.reduction == 'sum':

return loss.sumelse:

return loss

# 边界框回归损失函数class IoULoss:

def __init__:

super__init__self.reduction = reduction

def forward:

# pred_boxes:- 预测的边界框坐标 [x1, y1, x2, y2]

# target_boxes:- 真实的边界框坐标 [x1, y1, x2, y2]

# 计算交集

inter_x1 = torch.maxinter_y1 = torch.maxinter_x2 = torch.mininter_y2 = torch.min# 计算交集面积

inter_area = torch.clamp* torch.clamp# 计算预测框和真实框的面积

pred_area =*target_area =*# 计算并集面积

union_area = pred_area + target_area - inter_area

# 计算IoU

iou = inter_area /# 计算IoU损失

loss = 1 - iou

# 聚合损失

if self.reduction == 'mean':

return loss.meanelif self.reduction == 'sum':

return loss.sumelse:

return loss

# 检测模型的总损失函数

class DetectionLoss:

def __init__:

super__init__# 分类损失self.cls_loss = MultiFocalLoss# 回归损失self.reg_loss = IoULoss# 分类损失权重

self.lambda_cls = lambda_cls

# 回归损失权重

self.lambda_reg = lambda_reg

def forward:

# cls_preds:- 分类预测

# reg_preds:- 回归预测

# cls_targets:- 分类目标

# reg_targets:- 回归目标

# weights:- 样本权重

# 计算分类损失

cls_loss_val = self.cls_loss# 计算回归损失pos_mask = cls_targets > 0

if pos_mask.any:

reg_loss_val = self.reg_losselse:

reg_loss_val = torch.tensor# 计算总损失

total_loss = self.lambda_cls * cls_loss_val + self.lambda_reg * reg_loss_val

return total_loss, cls_loss_val, reg_loss_val

重难点和创新点

研究难点分析

纹理布匹瑕疵检测是一个具有挑战性的计算机视觉任务,主要面临以下几个难点:

-

复杂背景纹理干扰:纹理布匹具有丰富多样的背景纹理,这些纹理在视觉上可能与瑕疵特征相似,导致模型难以区分真实的瑕疵和正常的纹理变化。特别是对于那些与背景纹理颜色和形状相近的瑕疵,检测难度更大。

-

瑕疵种类多样且不平衡:布匹瑕疵的种类繁多,不同瑕疵的形态、大小和特征差异很大。同时,在实际生产中,不同瑕疵的出现频率也存在巨大差异,导致数据集中各类别样本数量严重不平衡。这种不平衡会导致模型在训练过程中倾向于关注样本数量较多的类别,而忽视稀有类别。

-

瑕疵尺度变化大:布匹瑕疵的尺度变化范围很大,从微小的断纱到较大的油污区域不等。传统的目标检测模型在处理这种大范围尺度变化时,往往表现不佳。

-

实时性要求高:在实际的工业生产环境中,瑕疵检测系统需要能够实时处理高速移动的布匹图像,对模型的推理速度提出了很高的要求。深度学习模型虽然具有较高的检测精度,但往往存在参数量大、推理速度慢的问题。

-

模型泛化能力要求高:纺织行业中,布匹的材质、织法和纹理种类繁多,模型需要能够适应不同类型的布匹,具有较强的泛化能力。

技术创新点

针对上述难点,本研究提出了一系列创新的技术方法:

-

改进的ResNet50+特征提取网络:通过在传统ResNet50的基础上引入通道注意力机制和优化的残差连接结构,提高了网络对纹理布匹特征的提取能力。特别是通道注意力机制能够自动学习不同通道的重要性权重,使网络能够更加关注与瑕疵相关的特征信息,抑制背景纹理的干扰。

-

基于模板对比的F-FPN特征融合结构:针对复杂背景纹理干扰问题,提出了一种基于模板对比的F-FPN特征融合结构。该结构通过引入无瑕疵的模板图像进行特征差异分析,有效地过滤掉背景纹理的干扰,突出瑕疵区域的特征。F-FPN不仅融合了多尺度信息,还通过模板对比机制增强了瑕疵特征的表达,提高了检测的准确性。

-

Multi Focal Loss损失函数:针对类别不平衡和难易样本区分问题,设计了一种Multi Focal Loss损失函数。该损失函数通过动态调整类别权重和引入难易样本调制因子,使模型在训练过程中更加关注稀有类别和难分样本。

-

基于DIOU的加权NMS方法:针对传统NMS算法在处理重叠瑕疵时的局限性,提出了一种基于DIOU的加权NMS方法。该方法在去除冗余候选框时,不仅考虑了两个框之间的重叠程度,还加入了两者之间的距离作为衡量指标,能够更准确地保留最佳候选框,特别是在处理重叠的同类瑕疵时,效果更加显著。

-

优化的模型压缩策略:针对实时性要求,提出了一种结合紧凑网络设计和模型剪枝的优化压缩策略。通过采用分组卷积和优化后的深度可分离卷积,减少了模型的参数量和计算量;同时,使用ThiNet网络剪枝方法,对训练好的模型进行结构化剪枝,进一步降低了模型的复杂度。

应用创新点

本研究的成果不仅具有理论创新价值,还具有重要的应用创新点:

-

自适应的纹理过滤机制:F-FPN结构中的模板对比机制能够自适应地过滤不同类型的背景纹理,使模型能够适应不同材质和织法的布匹,具有较强的通用性。

-

动态的样本权重调整:Multi Focal Loss中的动态类别权重和难易样本调制因子能够根据训练过程中的反馈信息自动调整,使模型能够更好地适应数据分布的变化。

-

可解释的检测结果:通过特征可视化和注意力机制分析,模型能够提供更加可解释的检测结果,帮助操作人员理解检测过程和结果的可靠性。

-

灵活的部署方案:压缩后的模型可以部署在不同的硬件平台上,从高性能GPU服务器到边缘计算设备,满足不同场景的应用需求。

总结

本研究针对纹理布匹瑕疵检测中的关键技术问题进行了深入探讨,提出了一系列改进和优化方法。通过系统的研究和实验,取得了以下主要成果:

-

网络结构优化:提出了改进的ResNet50+特征提取网络,通过引入通道注意力机制和优化的残差连接,提高了网络对纹理布匹特征的提取能力。

-

特征融合创新:设计了基于模板对比的F-FPN特征融合结构,通过引入无瑕疵的模板图像进行特征差异分析,有效地过滤掉背景纹理的干扰,突出瑕疵区域的特征。F-FPN结构在提高检测准确性方面取得了显著效果。

-

损失函数改进:提出了Multi Focal Loss损失函数,通过动态调整类别权重和引入难易样本调制因子,有效地解决了类别不平衡问题,提高了模型对稀有瑕疵和难分样本的检测能力。

-

后处理算法优化:开发了基于DIOU的加权NMS方法,在处理重叠瑕疵时表现出更好的性能,提高了检测结果的准确性。

-

模型压缩策略:结合紧凑网络设计和模型剪枝方法,对模型进行了有效的压缩,在保证检测性能的同时,显著提高了模型的推理速度,使其能够更好地应用于实际生产环境。

-

实验验证:通过大量的对比实验,验证了所提出方法的有效性。

本研究的成果为纹理布匹瑕疵检测提供了一套完整的解决方案,具有重要的理论意义和应用价值。研究中提出的网络结构、特征融合方法、损失函数和模型压缩策略等技术创新,不仅可以应用于纺织行业的瑕疵检测,还可以为其他领域的缺陷检测提供借鉴和参考。

未来的研究方向主要包括:探索更高效的轻量级网络结构,进一步提高模型的推理速度;研究半监督学习和少样本学习方法,减少对大量标注数据的依赖;开发更通用的特征提取和融合方法,提高模型对不同类型布匹的适应能力;探索多模态融合技术,结合可见光、红外等多种传感器数据,进一步提高检测的准确性和鲁棒性。

参考文献

-

Zhou J, Wu G, Ni J, et al. Fabric defect detection based on deep learning: A review[J]. IEEE Access, 2021, 9: 106893-106914.

-

Li X, Zhang L, Wang H, et al. A survey of fabric defect detection techniques[J]. IEEE Transactions on Industrial Electronics, 2022, 69: 948-964.

-

Wang Y, Liu H, Zhang Z, et al. An improved Faster R-CNN for fabric defect detection[J]. IEEE Transactions on Instrumentation and Measurement, 2023, 72: 1-11.

-

Chen L, Yang X, Wang Y, et al. Fabric defect detection using attention mechanism-based deep learning[J]. Journal of Electronic Imaging, 2022, 31: 063035.

-

Gao H, Wang J, Li Y, et al. Lightweight fabric defect detection network based on depthwise separable convolution[J]. Optics and Lasers in Engineering, 2023, 160: 107415.

-

Liu Z, Wang L, Zhang X, et al. Imbalanced fabric defect detection using focal loss and data augmentation[J]. Measurement, 2022, 191: 110791.

-

Zhang H, Li B, Chen S, et al. Multi-scale feature fusion for fabric defect detection[J]. Applied Soft Computing, 2023, 133: 110083.

-

Wang X, Jiang Y, Chen L, et al. Real-time fabric defect detection system based on model compression[J]. IEEE Transactions on Automation Science and Engineering, 2024, 21: 453-464.

895

895

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?