深度解析Deep Research系统结构与路线图

将大语言模型作为一种研究工具,大约经历了三个阶段:

- 早期模型(比如 GPT-3 )主要处理孤立的任务,包括问答、机器翻译。随后,与外部工具的集成使 WebGPT 等模型能够自主浏览网页并合成来自不同来源的信息。

- 最近一年,一种能够自主研究的复杂 AI 代理迅速涌现——

Deep Research,包括海外的Gemini、OpenAI、Grok、Perplexity,以及国内的 Manus、MiniMax、Kimi 等都推出了Deep Research 产品。 - 近期,利物浦大学联合华为诺亚方舟实验室和牛津大学等顶尖学府发布了一份针对 Deep Research Agents 的系统性综述,首次将 Deep Research 的技术路线、架构设计等进行了深度的梳理与对比。

本文针对Deep Research的五大核心组件——搜索引擎集成、工具使用能力、工作流架构、调优方法以及非参数化持续学习进行详细分析。

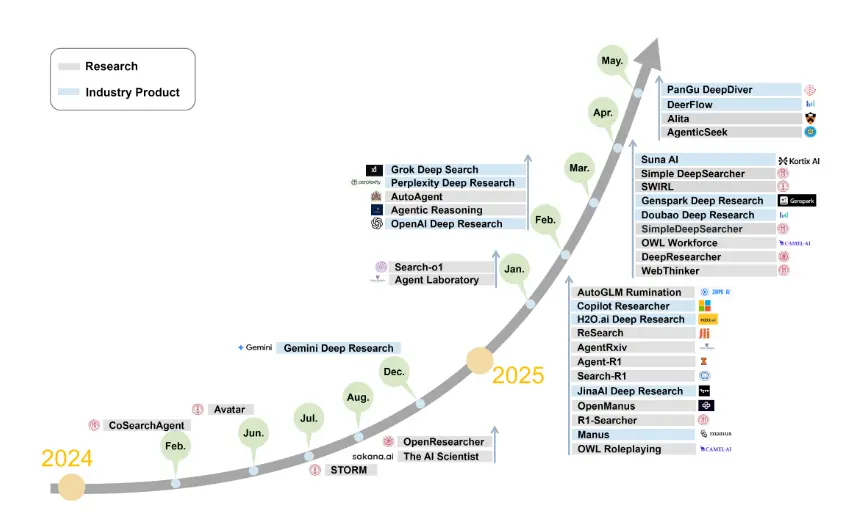

图:多年来DR agent的演变概况

1. 引言

近年来,大语言模型(LLMs)的快速发展推动了功能强大的AI智能体的迅速崛起,这些智能体已具备自主科研的能力。早期的模型,如GPT-3,主要专注于解决单一任务,例如问答和机器翻译。随后,通过与外部工具的整合,像WebGPT这样的模型得以实现自主浏览网络,并从多种来源中高效整合信息。而最近,一类全新的先进自主系统——Deep Research(DR)智能体应运而生,其中以OpenAI DR、Gemini DR、Grok DeepSearch以及Perplexity DR等行业领先解决方案为代表。这些深度研究智能体通过引入先进的推理能力、动态任务规划,以及与网络资源和分析工具的自适应交互,极大地拓展了LLM的功能边界。

我们正式定义“Deep Research Agents”为:

由大模型驱动的AI智能体,集成了动态推理、自适应规划以及迭代式工具使用功能,能够获取、整合并分析外部信息,最终生成全面的输出,以完成开放式的信息研究任务。

具体而言,DR agents以大模型作为其认知核心,通过Web浏览器和结构化API实时检索外部知识,并借助定制化工具包或Model Context Protocol(MCP)等标准化接口,动态调用各类分析工具。这种架构使DR agents能够自主管理复杂、端到端的研究工作流,实现推理过程与多模态资源的无缝整合。

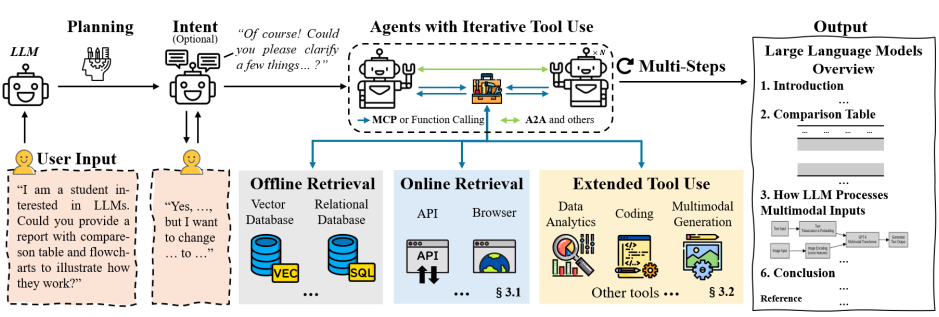

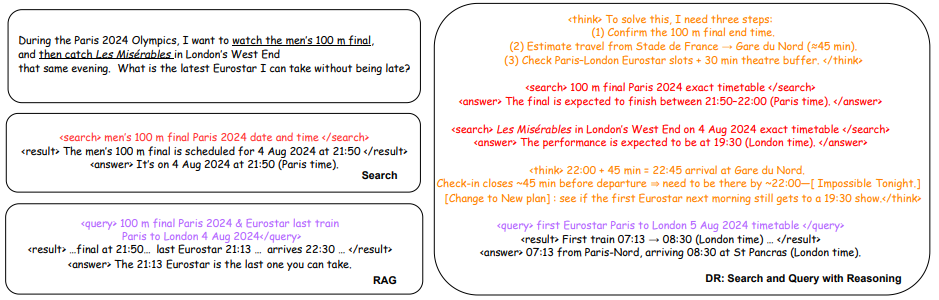

图1:一个DR agent在一个多智能体架构中的案例总览

与主要提升事实准确性但缺乏持续推理能力的传统检索增强生成(RAG)方法,以及高度依赖预定义工作流的传统工具使用(TU)系统相比,DR智能体展现出显著更高的自主性、持续且深入的推理能力、动态任务规划,以及实时自适应交互能力。这些先进功能使DR智能体能够独特地应对复杂、多变且知识密集型的研究场景。图1展示了此类DR智能体架构的典型示例,清晰呈现了从用户输入开始,经由可选的规划与意图澄清,再到迭代式工具应用——包括离线检索(向量数据库和关系数据库)、在线检索(API和浏览器),以及数据分析、代码编写(等)和多模态生成等扩展功能——最终生成全面结构化报告的完整流程。

本文贡献:系统梳理了近年来DR agents领域的最新进展,全面分析了核心技术、方法论、优化流程以及代表性应用案例。具体而言,本调研的贡献包括:

- 对代表性DR系统的深入剖析,详细探讨其系统架构、检索机制、工具调用方式及性能特征,并重点分析了相关的优化与调优范式。

- 提出了一套统一的分类框架(图4),依据工作流特性(静态 vs. 动态)、规划策略以及基于代理的架构类型(单代理 vs. 多代理),对DR系统进行系统化归类,从而连接起多样化的技术方法与当前行业解决方案。

- 对现有用于评估DR系统的各类基准测试进行了系统性回顾与分类,重点阐明这些基准如何衡量关键能力,如检索精度、推理深度以及自适应工具调用的熟练度。

- 针对当前亟需解决的关键挑战与研究方向展开深入分析,特别聚焦于突破传统方法的检索范围限制、实现异步并行执行、构建全面的多模态基准测试,以及优化多代理架构,以提升系统的鲁棒性和效率。

2. 背景和预备知识

2.1 推理与工具集成的最新进展

近年来,大型推理模型(LRMs)的不断进步,极大地提升了语言模型应对复杂与抽象任务的能力。这些模型在算术、常识推理及符号问题求解等任务上均展现出显著性能提升,这主要得益于模型架构和训练技术上的创新。其中一项重要进展便是由Wei等人提出的思维链(CoT)提示方法,该方法能明确引导模型逐步展现中间逻辑步骤,将复杂问题分解为一系列更简单的连续阶段。这一方法不仅显著提高了大语言模型在各类推理基准测试中的可解释性和准确性。在此基础上,后续研究又进一步提出了多种优化LLM推理能力的方法,尤其是在处理长文本上下文方面。例如,位置插值法和稀疏注意力机制被相继引入,以有效扩展模型的实际上下文窗口。此外,针对长文本情境下的推理需求,研究人员还专门开发了LongBench和LongFinanceQA等基准测试集,旨在严格评估并持续提升模型在长文本推理任务中的表现。

为了更好地解决那些需要实时或特定外部知识支持的推理任务,工具增强型框架如Toolformer以及多工具思维链方法MultiTool-CoT应运而生,使大语言模型能够自主调用外部计算资源与API接口,无缝融入推理工作流中。这些方法显著增强了模型在依赖精确数值计算和动态信息检索任务中的表现。与此同时,如何确保推理过程在多轮对话中保持连贯性,也构成了另一大挑战。为此,Dialogue CoT和**结构化思维链(SCoT)**等技术被提出,通过将对话状态与上下文信息显式整合到推理链条中,大幅提升了推理的连贯性、情境感知能力,以及对用户复杂查询的迭代处理与澄清能力。

然而,尽管已有诸多改进,当前的推理框架仍面临一些关键问题,例如幻觉现象、内部知识陈旧或过时,以及对快速变化的信息需求响应不足等。这些问题凸显了整合外部信息源、实时检索机制及自适应推理策略的迫切性,而这也正是推动近期研究朝着更加全面、稳健的推理框架迈进的核心动力,以满足DR Agent应用的需求。

2.2 检索增强生成(RAG)与代理式(Agentic)检索的最新进展

检索增强生成(RAG)技术通过利用外部知识库(如网络、API等),已成为一种有效策略,能够缓解幻觉问题,并显著提升网络信息搜索的准确性。早期的RAG架构通常采用静态流程:检索器从维基百科或搜索引擎等外部来源抓取相关文档,而生成器(如大语言模型LLMs)则仅基于这些检索到的片段生成答案。然而,这种静态方法在处理复杂或多步骤查询时存在局限性,因此近年来研究者们逐步转向迭代式和交互式的检索机制,以生成更丰富、更贴切的响应,代表性的方法包括FLARE、Self-RAG、IAG以及ToC 。此外,一些研究还将检索范围从结构化数据库(如维基百科)扩展至大规模、多样化的网络语料库,例如通过CCNet流水线预处理后的Common Crawl数据集。为进一步提升RAG性能,混合型方法应运而生——它们结合了内部LLM的知识与外部检索结果,从而实现更高的准确性和连贯性。最近,Huang等人提出了RAG-RL框架,引入了reinforcement learning和curriculum learning技术,使推理语言模型(RLMs)能够更高效地识别并利用相关上下文信息。

尽管检索方法和增强推理能力的模型已取得显著进展,RAG技术在有效管理复杂的推理工作流、动态适应多样化任务需求方面仍面临挑战。为应对这些难题,最新研究将RAG进一步拓展至代理化范式,在传统RAG流程的基础上叠加了额外的推理与决策层。Agentic RAG方法通过迭代检索、自适应查询及动态工作流调整,大幅增强了多步推理能力。例如,基于强化学习的查询优化技术(如Hsu等人)可显著改善复杂查询的检索效果;而基于图结构的检索方法(如GeAR)则进一步提升了对多跳查询的处理能力。

然而,即便取得了这些突破,代理化RAG依然面临关键挑战,包括如何平衡动态推理过程带来的计算开销、确保代理行为与用户意图的一致性,以及在自适应工作流中保持模型的可解释性。此外,即使是最先进的代理化RAG方法,仍受限于其对预先构建或定期更新语料库的依赖,这使得它们难以有效应对实时性高、变化迅速或长尾信息需求的场景。要解决这一难题,亟需将外部API接口与网页浏览功能融入RAG架构,从而推动最新DR方法的研发,进一步提升检索的全面性与适应性。

2.3 模型上下文协议(MCP)与代理间策略(A2A)

模型上下文协议(MCP)和代理间协作协议(A2A)已被提出,旨在解决基于大语言模型的智能体系统中的互操作性挑战,从而实现高效的工具访问与有效的多智能体协作。

MCP:传统工具使用(TU)型智能体面临诸多难题,包括API不一致、维护成本高昂以及开发工作重复等,这些都严重制约了系统间的互操作性[87]。为应对这些问题,Anthropic推出了MCP,这是一种统一的通信层,使基于大模型的智能体能够通过标准化接口,安全且一致地与外部服务和数据源进行交互。MCP还通过动态服务发现和统一的访问模式,有效缓解了数据孤岛问题。A2A:谷歌的A2A协议则通过结构化、任务导向的对话,促进去中心化的多智能体协作。来自不同供应商和模型架构的智能体可相互发现伙伴,明确职责分工,并以平等参与者的身份协同管理复杂任务。A2A将智能体发现抽象为“Agent Cards”,并将任务协调细化为“Tasks”和“Artefacts”,从而支持灵活、渐进式、多模态的工作流程,特别适用于复杂的协作场景。

MCP与A2A相辅相成,各自清晰划分了职责:MCP作为访问外部工具的标准化接口,而A2A则负责统筹协调智能体间的协作互动。二者共同构建了一个模块化、可扩展的开放互操作智能体生态系统,显著提升了AI系统应对现实世界复杂挑战的实际能力。

3. Deep Research:搜索引擎、工具使用、工作流程、调优、非参数持续学习

与传统基于RAG的方法对比。DR agents通过整合动态检索、实时工具使用以及自适应推理,将传统RAG方法的功能扩展为一个统一的系统。而传统的RAG方法通常依赖于固定的工作流程,在处理复杂、多步骤的查询或快速变化的情境时,灵活性受到限制。相比之下,DR智能体具备更高的自主性、更强的上下文感知能力以及更高的准确性,能够实时动态地调用外部工具,并高效管理多阶段的研究任务。

在本节中,将深入探讨开发和优化DR agents所不可或缺的五个核心组件:

- 搜索引擎集成,重点比较基于API的接口与基于浏览器的探索方式,以提升动态知识获取的能力;

- 工具使用功能,研究代码执行、数学计算、文件操作及多模态处理模块如何融入智能体的推理流程;

- 工作流架构,分析其基础设计、多智能体与单智能体模式的平衡,以及记忆机制和辅助组件,这些要素共同助力复杂研究工作流的协调与执行;

- 调优方法论,涵盖提示驱动的结构化生成、大模型驱动的提示策略、微调方案,以及旨在提升智能体性能的强化学习方法;

- 非参数式持续学习,使大模型智能体能够通过动态调整外部工具、记忆和工作流,实现自我进化,而无需更新内部模型权重,从而为复杂任务提供可扩展的优化方案。

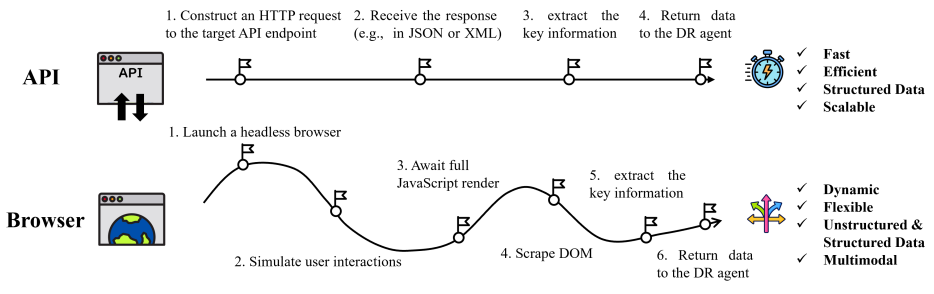

图2:基于API与基于浏览器的检索工作流程对比

3.1 搜索引擎的两种技术路径:API 与浏览器

为了增强处理不断发展的任务的推理深度和准确性,Deep Research 使用搜索引擎来获取最新信息,目前主要有两种技术路径:

**一是基于 API 的搜索引擎,可以与结构化数据源交互,例如搜索引擎 API 或科学数据库 API。**比如,谷歌 Gemini Deep Research 通过 Google Search API 和 arXiv API,对数百至数千个网页进行大规模检索,从而显著扩展其信息覆盖范围;Grok DeepSearch 宣称通过新闻媒体源、维基百科 API 和 X 的原生接口持续索引,以及根据需要激活查询驱动的代理来生成有针对性的子查询并实时获取相关页面,从而确保其知识库的新鲜度和深度。

二是基于浏览器的搜索引擎,通过模拟人类与网页的交互,促进实时提取动态或非结构化内容。 Manus就是其典型代表,其浏览器代理会为每个research session运行一个沙箱环境(Sandbox),程序化地打开新标签页、发出搜索查询、点击结果链接、滚动页面直到达到内容阈值、在必要时填写表单元素、执行页面内 JavaScript 以显示延迟加载部分以及下载文件或 PDF 以供本地分析。

OpenAI Deep Research、Grok DeepSearch 以及 Gemini Deep Research 虽然并没有公开其浏览功能的实现细节,但它们能够处理交互式小部件、动态渲染内容和多步骤导航的能力强烈表明,它们也在后台采用了类似的headless浏览器框架。在开源的 Deep Research 研究中,AutoAgent、DeepResearcher 也采用了基于浏览器的搜索引擎。

两种方式各有优劣。基于 API 调用的搜索引擎往往有更高的效率,但高度依赖内容源的开放性,它更适合谷歌这种本身就做搜索引擎的企业;基于浏览器的搜索引擎会像人类操作一样获取任何浏览器内的信息,但带来了更大的延迟与成本。在实际的应用中,两者可能会深度结合在一起使用。

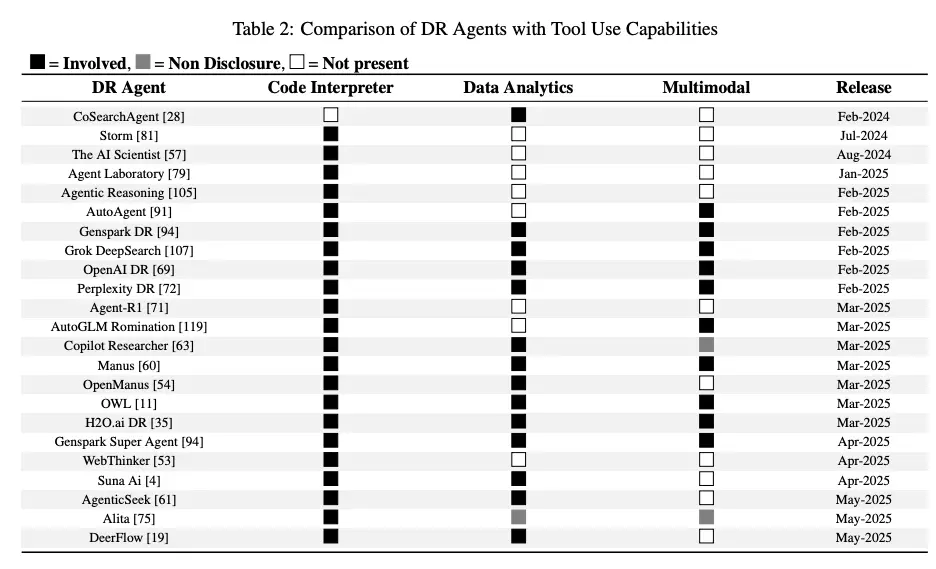

3.2 工具使用:为代理赋能扩展功能

为了扩展在复杂研究任务中与外部环境互动的能力,特别是通过主动调用和处理各种工具和数据源,Deep Research 引入了三个核心工具:代码解释器、数据分析、多模态处理。现在,这些工具通常会通过模型上下文协议(MCP)的形式接入。

- 代码解释器使 Deep Research 能够在推理过程中执行脚本,使它们能够执行数据处理、算法验证和模型模拟。大多数 Deep Research 都嵌入了一个脚本执行环境,它们通常依赖于 Python 工具,来协调动态脚本编写、进行文献驱动的分析以及执行实时计算推理。

- 许多闭源的 Deep Research 都实现了数据分析功能,比如绘图、表格生成和统计分析,但大部分都没有披露技术细节。但开源产品提供了具体的案例,比如CoSearchAgent 在团队通信平台内整合了基于 SQL 的查询,智谱的 AutoGLM 从基于表格的网络界面直接提取和分析结构化数据集。

- 多模态处理和生成工具使 Deep Research 能够在统一的推理管道中整合、分析和生成异构数据(如文本、图像、音频和视频),从而丰富它们的上下文理解并扩大它们的输出范围。只有少数成熟的商业和开源项目,例如 Manus、OWL、AutoAgent、AutoGLM、OpenAI、Gemini、Perplexity 和 Grok DeepSearch,支持这一功能,而大多数学术原型由于计算成本高昂而未实现该功能。

3.3 架构和工作流

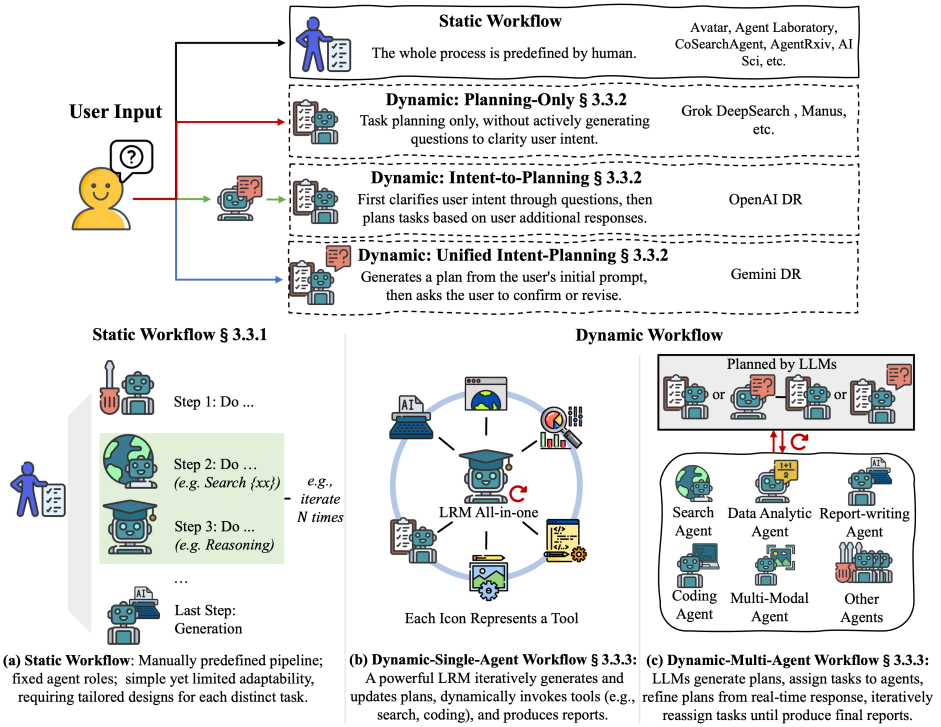

如图4所示,本节系统分析了DR系统的构建,重点聚焦于分为静态与动态两类的工作流。首先介绍静态工作流,随后探讨规划策略——这些策略通过三种独特的用户交互方式来优化任务分配与执行,从而明确用户意图:仅规划型(直接进行规划,无需进一步澄清用户意图)、意图导向规划型(先澄清意图,再根据用户目标调整任务规划),以及统一意图规划型(自动生成计划,并主动征求用户确认)。此外,针对动态工作流,本文还对比分析了单智能体系统与多智能体系统在任务管理上的差异,特别强调了二者的专业化分工优势。同时,我们深入研究了记忆机制,探讨其如何有效管理和整合检索到的信息,以提升DR系统的性能与适应能力。

图3:信息检索方法对比。左上角(Search)表示搜索方法,可使用浏览器或API;左下角(RAG、Query)代表检索增强生成,结合检索与生成模型,输出自然语言答案;右侧(Deep Research)则展示了深度研究过程,通过检索和显式推理,生成复杂的决策或分析结果。

3.3.1 静态vs动态工作流

静态工作流通过手动预定义的任务管道,将研究过程分解为顺序子任务,适合结构化研究场景。例如,AI Scientist 通过构思、实验和报告阶段自动化科学发现;Agent Laboratory 划分文献综述、实验和综合阶段;AgentRxiv 通过代理间协作共享中间结果,实现知识重用。

动态工作流支持自适应任务规划,允许代理根据反馈和上下文动态调整任务结构。它利用自动化规划、迭代细化和互动式任务分配,使任务能实时演变,展现出卓越的泛化能力和适应性,非常适合复杂、知识密集型的 AI 研究任务。

图4:DR工作流对比:(1)静态与动态工作流:静态工作流依赖于预定义的任务序列,而动态工作流则支持基于大模型的任务规划。(2)规划策略:主要分为三种类型:仅规划型(直接进行规划,无需明确用户意图)、意图导向型(先明确意图再展开规划),以及统一意图规划型(自动生成计划,并需用户确认)。(3)单智能体 vs. 多智能体:动态工作流可进一步细分为动态多智能体系统(任务由多个专业化的智能体协同完成)和动态单智能体系统(由一个LRM自主更新并执行任务)。如需查看持续更新的、针对每项研究课题的DR工作流分类,请访问:https://github.com/ai-agents-2030/awesome-deep-research-agent。

3.3.2 动态工作流:规划策略

为了增强 Deep Research 对演变的用户需求和上下文的适应性,现有研究提出了三种基于 LLM 的规划策略,每种策略在是否以及如何与用户互动以澄清意图方面有所不同:

- Planning-Only:直接根据初始用户提示生成任务计划,而不主动进一步澄清意图,这是大多数现有的 Deep Research 代理所采用的方法,包括 Grok、H2O 和 Manus。

- Intent-to-Planning:意图到规划策略,通过有针对性的问题在规划之前主动澄清用户意图,然后根据用户额外的回应生成量身定制的任务序列;这种方法被 OpenAI Deep Research 所采用。

- Unified Intent-Planning,统一意图规划方法综合了这些方法,从初始提示生成初步计划,并与用户互动以确认或修订提出的计划。Gemini Deep Research 是这种策略的代表,有效地利用了用户引导式细化的优势。

3.3.3 动态工作流:单智能体 vs. 多智能体

动态工作流的 Deep Research 代理可以根据代理架构分为单代理和多代理框架。

- 动态单代理系统将规划、工具调用和执行整合到一个统一的 LRM 中,将任务管理简化为一个连贯的认知循环。单代理架构自主地根据演变的上下文细化任务计划并调用适当的工具,通常无需明确的代理间协调。单代理系统允许在整个工作流上直接进行端到端的强化学习(RL)优化,促进推理、规划和工具调用的更顺畅、更连贯的整合。例如,Agent-R1、ReSearch 和 Search-R1 等系统通过明确推理、行动和反思的迭代循环,与 ReAct 框架一致。

- 动态多代理系统利用多个专门代理协作执行由自适应规划策略生成和动态分配的子任务。这些系统通常采用分层或集中式规划机制,其中协调代理根据实时反馈和重新规划持续地分配和重新分配任务。代表性的框架包括 OpenManus 和 Manus,都采用了

分层规划者 - 工具调用者架构。

3.3.4 用于长上下文优化的记忆机制

尽管最近LLM的进展显著扩大了上下文窗口大小,但当前的限制仍然限制了涉及极长上下文的任务。为了解决这些挑战,Deep Research 系统实施了各种优化,用于处理扩展上下文。这些优化可以分为以下三种主要策略:(i)扩展上下文窗口长度;(ii)压缩中间步骤;(iii)利用外部结构化存储用于临时结果。

- 扩展上下文窗口长度是最直观有效的办法,以谷歌的 Gemini 模型为例,它支持长达一百万个标记的上下文窗口,并辅以 RAG 设置。尽管这种方法直观有效,但往往会导致高昂的计算成本,并且在实际部署中可能会导致资源利用效率低下。

- 另一种策略是压缩或总结中间推理步骤,显著减少模型处理的标记数量,从而提高效率和输出质量。例如,AI Scientist 和 CycleResearcher 等代表性框架在工作流阶段之间传递总结的中间结果。然而,这种方法的潜在缺点是可能会丢失详细信息,从而影响后续推理的准确性。

- 利用外部结构化存储来保存和检索历史信息,使 Deep Research 代理能够在上下文窗口的限制之外持续且高效地存储大量过去上下文,提高记忆容量、检索速度和语义相关性。流行的开源框架,如 Manus、OWL、Open Manus 和 Avatar,利用外部文件系统存储中间结果和历史数据以便后续检索。WebThinker 和 AutoAgent 等框架开发了自我管理模块,利用向量数据库支持可扩展的记忆存储和基于相似性的快速查找。

3.4 参数调优:从SFT微调到强化学习

参数化方法。基于提示的方法直接利用预训练大模型的能力,无需昂贵的微调或额外训练,即可实现复杂的功能。然而,系统性地优化提示结构和工作流程仍面临挑战。此外,由于智能体的性能本质上受限于其基础大模型,随着决策过程复杂度的提升,很快就会触及模型性能的上限。为突破这些局限,必须引入先进的优化技术,如微调、强化学习(RL)或混合训练范式,以进一步拓展模型的固有能力。下面,我们将探讨两种主要的调优范式——监督微调(SFT)和强化学习,并重点说明它们如何分别将智能体的能力扩展至仅靠提示方法之外的领域。

3.4.1 基于SFT的优化

基于提示的方法虽然能够快速适应,但其根本上受限于基础大模型的内在泛化能力,在复杂任务场景中往往表现出较弱的鲁棒性。为此,研究人员日益探索微调方法,旨在系统性地优化大模型,以提升深度研究智能体的关键组件性能。这些组件包括搜索查询的构建、结构化报告的生成,以及外部工具的高效利用。通过这些努力,研究团队希望进一步提高检索质量,减少幻觉现象,并实现更可靠、基于证据的长文本生成。

Open-RAG 是SFT微调的早期里程碑,通过引入多样化的监督信号(如检索标记、相关性标记等)来增强数据构建,并利用对抗性训练提升模型过滤不相关信息的能力,进而提高检索准确性和下游任务质量。

在此基础上,AUTO-RAG 进一步增强了 LLM 的自主迭代检索能力,构建基于推理的指令数据集,使模型能够自主规划检索查询并进行多轮互动,动态细化检索策略以收集足够证据后再合成最终答案。

DeepRAG 则提出了二叉树搜索机制,递归生成子查询并构建多轮检索轨迹,平衡内部知识与外部检索展开,提高搜索效率并减少冗余查询。

为减少对人工构建的 SFT 数据集的依赖,近期研究开发了基于拒绝采样的微调策略,如 CoRAG 从标准问答数据集中提取中间检索链,实现逐步检索增强和动态子查询重新制定,而不仅限于监督最终输出。

尽管这些SFT方法通过支持动态检索规划、结构化信息合成以及集成工具使用,有效提升了深度研究智能体的泛化能力,但它们仍局限于检索增强系统典型的离线、静态检索流程。相比之下,强化学习为在线查询生成和工具调用提供了一种更为灵活的解决方案。通过从实时奖励信号中学习,强化学习智能体能够掌握如何构建高效的搜索查询,并精准判断何时调用工具。这一方法克服了合成演示数据的局限性及分布偏移问题,从而在开放式研究环境中展现出更强的鲁棒性和适应性。

3.4.2 基于强化学习的优化

强化学习代理通过实时奖励信号学习,能够制定有效的搜索查询并确定工具调用的最佳时机,解决了合成演示数据和分布偏移的限制,使代理在开放性研究环境中具有更强的稳健性和适应性。

在 Deep Research 系统中,RL 实现有三种关键模式:

1)工业系统(如 Gemini Deep Research 和 Grok DeepSearch)采用专有的 RL 实现,细节未公开;

2)学术方法倾向于使用 GRPO 和 Reinforce++ 进行模块化 RL 优化,奖励设计透明;

3)新兴混合系统(如 SimpleDeepSearcher)结合了基于过程的奖励与跨多个问答数据集的多任务训练。Qwen2.5 和 LLaMA3 模型家族是 RL 优化的首选基础架构。

在策略优化算法方面,GRPO 在更广泛的奖励分布覆盖、增强探索能力和更快的 KL 散度稳定化方面优于传统的 PPO。

3.5 非参数持续学习

基于SFT与强化学习的 Deep Research 面临的一个根本挑战是,如何在不重新训练模型的前提下持续改进能力。对此,非参数化持续学习方法提供了一种可扩展的替代方案,通过优化外部记忆、工作流和工具配置来完善能力,而非更新内部权重,以最小的数据和计算开销实现有效的在线适应,非常适合复杂架构的 Deep Research。

基于案例推理(CBR)的方法是主流。**CBR 使代理能从外部案例库动态检索、适应和重用结构化问题解决轨迹,促进在线上下文适应和任务级泛化。**例如,DS-Agent 引入 CBR 到自动化数据科学工作流,采用近似在线检索;LAM 将 CBR 应用于功能测试生成,结合轨迹级检索和模块化系统设计;Agent K 通过奖励策略引导动态案例检索和重用,实现自我进化;AgentRxiv 扩展这一范式,使代理能协作共享和访问集中化的研究输出库,类似于在线更新的 arXiv 平台。这些方法使代理在不修改模型参数的情况下增强能力和知识。

与基于提示的方法相比,非参数化方法能动态检索和适应结构化轨迹,促进持续任务泛化。CBR 在轨迹级别运行,强调推理中心的记忆组织,如 Kaggle Grandmaster Agent 展示了通过 LLM 实现专家级结构化问题解决的能力。此外,自我进化也可通过动态基础设施适应实现,如 Alita 根据任务需求和环境信号动态配置 MCP 服务器。

这些自我进化范式为 LLM 驱动的深度研究代理系统提供了巨大潜力,解决了参数化方法的高数据和计算需求,是未来研究和实际部署的有吸引力的方向。

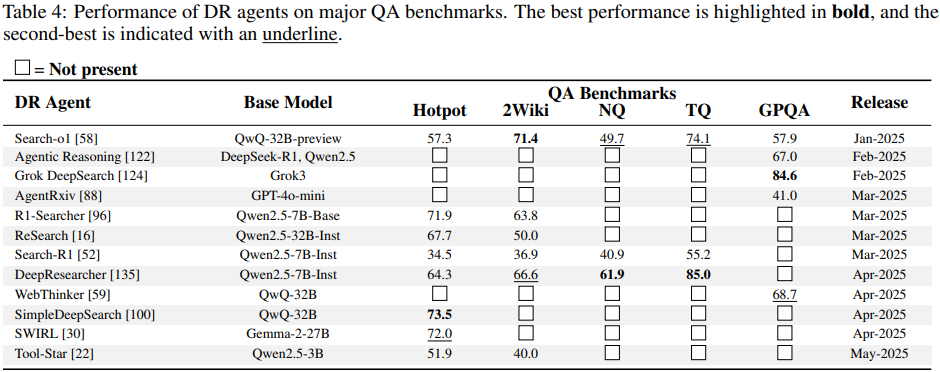

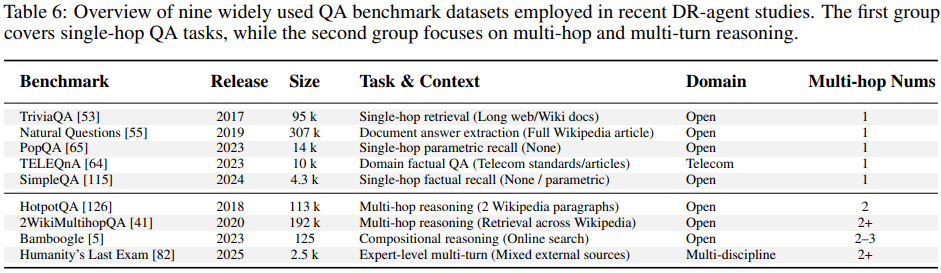

4. DR Agent Benchmarks

评估 DR 智能体需要具备能够全面捕捉其研究工作流程的基准测试,包括多步骤的信息检索、跨源信息整合、动态工具调用,以及基于结构化证据的报告生成。目前现有的评估方法主要分为两大类:

- Question-Answering (QA)基准测试涵盖从单轮事实性问题到复杂研究型难题的多种场景,用于衡量智能体的事实性知识、领域特定推理能力,以及定位和整合相关信息的能力;

- **任务执行基准测试(Task Execution benchmarks)**则侧重于评估更广泛的综合能力,如长周期规划、多模态理解、工具使用及环境交互等,以检验智能体完成端到端研究任务的整体表现。

尽管像Qasper和ELI5这样的长文本生成数据集提供了对扩展输出连贯性的测试,但其自由形式的特性与DR智能体所应具备的、基于结构化证据的规范性报告要求并不匹配。因此,当前亟需开发专门的基准测试,以真实反映DR工作流中多阶段、多模态的特点,并确保对智能体在自主研究各环节中的表现进行严格且具相关性的评估。

QA Benckmarks:(QA)基准测试涵盖了从简单事实回忆到多跳推理及研究型问答等多种复杂程度。在较低层次上,像SimpleQA[115]、TriviaQA[53]和PopQA[65]等数据集主要关注参数化或单跳式事实回忆,评估模型能否从记忆或极简上下文中快速提取出简短的事实性答案。而Natural Questions (NQ)[55]和TELEQnA[64]则通过要求从长文档或特定领域资料中抽取答案,进一步提升了任务的复杂性。HotpotQA[126]、2WikiMultihopQA[41]和Bamboogle[5]等基准测试则更侧重于跨文档的多跳推理能力,以及相关证据的精准选择。至于最高难度的测试,则属“人类最后的考试”(HLE)[82],它专为各领域顶尖教授精心设计的专家级、开放域科学问题而设,通常需要多轮检索、复杂推断,甚至跨模态的理解能力。此外,OpenAI还提出了BrowseComp[79]这一极具挑战性的新基准,旨在衡量AI智能体查找难以获取信息的能力。该基准保留了Simple QA基准中答案可验证的特点,同时剔除了那些仅靠大模型结合网络搜索即可轻松解决的问题,从而全面检验智能体的信息检索与整合能力。尽管近年来相关技术取得了显著进展,但目前领先的文档检索(DR)智能体在HLE和BrowseComp基准上的表现,仍不及人类专家水平,这凸显了这两个基准作为评估DR智能体时最具挑战性且尚未完全攻克的关键难题。

Task Execution Benchmarks:任务执行基准评估代理在工具使用、环境感知和信息过滤方面的综合能力。这些可以分为两个子类。第一类包括通用助手任务,例如GAIA [68]、AssistantBench [128]和Magentic-One[26]。这些任务要求代理在开放式环境中计划和执行基于工具的工作流程(例如搜索、浏览或表单填写)。其中,GAIA已经成为最重要的基准之一,提供多样化、真实世界的任务,易于人类解决,但对于当前的代理来说仍然具有高度挑战性。第二类专注于研究和面向代码的任务,包括SWE-bench [51]、HumanEvalFix [71]、MLGym [74]、MLE-bench [14]、MLBench [102]、MLAgentBench [45]和ScienceAgentBench [19],它们测试代理完成机器学习管道、修复现实世界代码或复制科学实验的能力。这些任务需要长期规划、精确的工具调用,通常还需要代码生成和验证。此外,RE-Bench [118]和RESEARCHTOWN [129]等基准模拟了多代理研究环境,评估代理在多角色科学研究工作流程中的协作和迭代能力。

随着DR智能体不断整合更多交互式工具,未来的评估可能会扩展至基于图形用户界面的操控环境。诸如OSWorld [125]、WebArena [139]和SpaBench [15]等基准测试平台,使智能体能够直接控制应用程序或网页界面,为在真实、面向用户的场景中测试具身化研究能力开辟了全新途径。

5. 挑战和未来方向

尽管DR智能体发展迅速,并且已展现出在自动化多步骤信息发现与合成方面的显著成效,但两大核心挑战依然存在,它们为未来创新指明了方向。首先,当前可获取信息的广度与深度仍受到限制,主要受限于对静态知识库或传统搜索界面的依赖。其次,执行工作流和系统架构的效率与稳健性,也因线性规划范式及单体化智能体设计而受到制约。要解决这些挑战,关键在于推动DR智能体真正实现自主、灵活的研究助手功能,使其能够自如应对复杂、异构的数据环境,并高效协调高通量、并行化的推理流程。

拓宽信息来源。为满足复杂任务的信息需求,当前的DR智能体通常采用静态知识库(如RAG方法),或完全依赖搜索引擎和浏览器;然而,前者功能不足,后者则受限于公开的网络内容,极大地制约了其信息获取能力。这种固有的局限性,使得它们无法从应用程序、专有界面或专业数据库背后挖掘隐藏的信息。例如,传统的浏览与搜索技术无法深入企业软件、移动应用,也无法访问诸如彭博终端等需订阅才能使用的服务,从而阻碍了对关键实时市场情报的获取。为了突破这一瓶颈,当务之急是通过MCPs整合更加精细且广泛的模块化工具。这种方式使智能体能够动态调用标准浏览器或搜索引擎无法覆盖的专用工具与资源——这些资源可能包括专有应用、数据库或API接口,进而帮助智能体轻松获取以往难以触及的数据。因此,DR智能体具备了提供更精准、更具适应性及情境感知能力的交互体验的能力,从而高效满足用户多样化且复杂的实际需求。

在集成专有API和数据库后,工作流程中的速率限制因素将从数据获取阶段转移到网页交互效率上。而传统以人类为中心的浏览器,反而进一步成为智能体的瓶颈:由于这些浏览器主要优化视觉渲染效果,而非程序化控制,因此常面临页面加载缓慢、元素定位器极易因布局变化而失效,以及强大的反机器人防护机制频繁中断自动化会话等问题。这些问题直接导致高延迟、抓取不稳定,且在大规模数据采集时难以实现高效的并行处理。为解决这一瓶颈,研究人员已开始研发原生AI驱动的浏览器,例如Browserbase [2]、Browser Use [72]、Dia、Fellou [105],以及Perplexity推出的Comet [108]。这些新型浏览器均能为智能体提供稳定、结构化的DOM视图,使其可按编程方式灵活遍历页面内容[2, 72, 108]。其中,[2, 105]还特别提供了明确的API接口,支持智能体直接点击元素、填写表单,彻底摆脱了对脆弱的坐标式操作的依赖。此外,[2]还能在无头容器中异步执行页面加载,显著降低加载时间的波动性,并避免了可见界面带来的额外开销。而[2]更内置了视觉-语言模型,能够实时追踪页面动态变化,自动应对登录验证及各类反机器人挑战。与此同时,[72, 108]则支持同时管理数十个标签页,使DR智能体能够大规模地与私有仪表板、单页应用及互动式可视化内容无缝对接。综合来看,这些创新技术有效消除了传统以人为中心的浏览器在智能体与全新解锁的专有数据源之间所引发的延迟与不稳定性问题,大幅提升了数据采集的效率与可靠性。

事实核查:为进一步提升事实准确性,最新方法在多步检索的基础上,新增了结构化验证循环和自我反思能力。具体而言,当智能体初步拟出答案后,并不会急于给出最终结论,而是主动展开交叉核查:它会寻找独立的权威来源以确认同一事实,并仔细搜寻是否存在相互矛盾的证据。例如,Grok DeepSearch便采用了这一策略——它不仅对每种信息源的可信度进行评分,还会通过多达七层深度的层层检验,确保信息的一致性;同时,针对每个关键论断,该模型还会从多个不同渠道反复核实,从而有效降低单一信息源可能带来的误差,大幅提高答案的可靠性。与此同时,智能体也开始对自己的推理过程进行反思:在推导过程中,它们会像人类研究者一样,主动审视并检验中间结果。以智谱的“沉思”模型为例,该模型在得出结论后会暂时停顿,继续深入搜索,以验证这一结论是否成立;只有在确认无误后,才会最终定稿。这种内省式思考通常通过强化学习中引入以正确性为导向的奖励机制来鼓励。如果模型检测到冲突或不确定性,便会重新规划检索策略,必要时甚至回溯至早期推断步骤,及时修正错误[78]。正是凭借这种结构化验证与自我反思的有机结合,如今的研究型智能体在事实核查领域达到了前所未有的严谨水准:它们不仅能提供准确的答案,还能清晰解释为何该答案值得信赖,从而显著减少事实性错误与幻觉现象的发生。简而言之,现代智能体已具备制定完整搜索计划的能力,能够根据逐步获取的中间证据灵活调整查询方式;而在遇到疑难时,更可适时回溯先前步骤,以补全缺失的信息[78]。

异步并行执行。为解决现有大多数DR代理完全依赖线性任务规划——即子任务的顺序执行——这一局限性,我们提出了两种可行的方法。这些方法突破了纯线性策略固有的效率与鲁棒性瓶颈,既能充分发挥并行性优势,又能在任务执行过程中实现动态调整。首先,一种基于先进任务建模结构(如有向无环图,DAG)的异步并行架构,展现出极具前景的发展方向,有望支持子任务的并行执行与动态优先级分配,从而有效管理任务间的复杂依赖关系,并推动实现诸如重新规划等更为复杂的规划能力。其次,我们还可提出一种通过强化学习训练而成的智能调度代理,它可根据运行时性能信号(如执行延迟)来分配子任务并调整执行顺序。通过将调度决策视为强化学习环境中的动作,该代理将逐步探索出兼顾并行度、资源利用率及任务关键性的最优策略,最终打造出更加稳健高效的研究全流程工作流。

工具集成推理。在开发有效的深度研究代理方面,面临的一个基本挑战是实现工具集成推理(TIR),这是一种超越简单工具使用的范例,涵盖复杂的多步骤推理,具有动态工具集成。TIR需要代理不仅按逻辑顺序调用适当的工具,还应根据中间结果自适应地调整其推理路径。传统的监督微调方法在基于工具的推理任务中显示出有限的一般化能力,通常导致过度推理或不适当的选择工具。最近的研究表明,带有精心设计奖励结构的强化学习框架可以显著增强模型的工具推理能力。通过纳入对工具选择适当性、参数规格准确性、推理效率等进行细粒度评价的奖励,TIR优化的代理在多个基准测试中表现出15-17%的性能提升。此外,这些代理对于未见过的工具和任务具有更好的泛化能力,更合理的调用模式,并且更好地平衡了工具利用和自我知识之间的关系。在深度研究代理中有效地实现TIR代表了一种朝着能够最小化人类干预并在复杂信息景观中导航的真正自主研究助手迈进的关键步骤。

基准不一致。基准不一致是指在评估DR系统时,大多数公共评估仍然基于传统的QA(问答)套件,其问题主要来自静态语料库,如维基百科。由于相当一部分内容现在嵌入到背骨模型参数中,当前竞争性代理通常可以直接从内存中回答问题,跳过任何研究程序,从而夸大了它们的表现。为了探测真正的检索、推理和工具使用能力,DR领域急需开放网络、时间敏感的基准测试。因此,BrowseComp[79]是一个有意义的进步,它过滤掉可以通过参数知识解决的问题,并迫使代理在线查找难以找到的信息。此外,一个互补的方向是不断更新的排行榜,它会更新最新的Web环境和事件中的问题,通过参数记忆防止基准攻击。

除了参数知识对QA基准测试的攻击外,大多数现有DR研究的指标仍将开放式研究工作流程缩小为狭窄范围内的QA提示或基本GUI控制任务,忽略了该范式定义的结果——结构化的多模态研究报告,将文本叙述、表格、图表和引证编织在一起。由于这些基准测试的指标几乎只关注信息检索和提取以及工具调用,它们低估了跨异质源证据聚合、跨模态合成和话语级组织等更高层次的能力。因此,开发综合基准测试以评估DR代理端到端报告生成能力的关键研究优先事项,包括长篇叙述、集成表格和图表以及多模态连贯性,从而评估事实准确性、话语结构和跨模态一致性在一个任务中的表现。

多智能体架构的参数优化。多智能体架构参数优化是指通过使用多个专门化的代理来分配工作负载以提高系统性能的方法。这种方法已经被证明可以显著增强针对数据恢复(DR)任务的骨干模型的推理能力,并且已经成功地被几个开源项目复制。然而,当前的实现主要使用单个代理架构,这要求骨干模型同时管理规划、工具调用和报告生成。这种多任务处理给骨干模型带来了过大的计算和认知负担,从而降低了其效率和鲁棒性。

为优化面向DR任务的多智能体架构,我们提出了两个极具前景的未来方向:(i) 采用层次强化学习(HRL),通过引入分层的内部奖励机制,促进高效反馈传播,并推动各智能体之间的协作式学习;或实施一种后训练优化流程,该流程包含多个针对DR任务量身定制的细化阶段,可逐步提升智能体间的交互效果,进而增强系统的整体稳定性和适应性;(ii) 运用基于强化学习的专用调度智能体,根据实时性能指标动态分配子任务并调整执行顺序。通过将调度决策建模为强化学习框架中的动作,这一方法能够逐步习得自适应策略,从而实现并行执行、资源利用与任务优先级的最优平衡,显著提升端到端科研工作流的鲁棒性和效率。

自进化语言模型智能体。尽管已经出现了针对DR代理的自我进化方法的初步尝试,例如模拟协作平台AgentRxiv[88],它促进了在线共享和重用结构化研究经验,但该范式仍然不成熟且只关注基于案例推理的方法。同样地,CycleResearcher[117]通过迭代偏好学习和强大的验证器(verifier)实现了整个研究过程的仿真(research-evaluation-refine),这代表了向完全自动化的科学探究迈出的重要一步,并与AlphaEvolve[76]分享了类似的自我进化概念。简而言之,虽然已经有了一些尝试来实现DR代理的自我进化,如模拟协作平台AgentRxiv等,但是这些方法仍处于初级阶段,主要集中在基于案例推理的方法上。类似地,CycleResearcher通过迭代学习和强化验证器实现了整个研究过程的仿真,这代表着向全自动科学探索迈进的重要一步,并与AlphaEvolve分享了相似的自我进化概念。

为了充分实现DR代理的自我进化潜力,未来的研究所应沿着两个互补方向扩展自我进化方法。(i) 综合基于案例推理框架。基于案例推理方法利用层次化的经验轨迹,包括计划轨迹和结构化的工具调用日志,并采用先进的检索和选择机制,以实现精细的、上下文特定的自适应。(ii) 自主工作流程演化增强效率和灵活性。通过将代理工作流程表示为可变结构,如树或图,研究人员可以应用进化算法或自适应图形优化来动态探索、修改和优化执行计划。在两个方向上同时追求将加强框架的鲁棒性,并减少对数据和计算资源的依赖。

6. 结论

深度学习驱动的深入研究代理是一种新兴的研究支持范式,它整合了迭代信息检索、长篇内容生成、自主规划和复杂工具利用等先进技术。本文系统地回顾了深度研究代理的最新进展,并从信息检索和报告生成的角度将现有方法分类为基于提示、微调和强化学习的方法。

非参数化方法使用大型语言模型(LLM)和精心设计的提示来实现高效和成本效益的部署,使其适合快速原型制作。相比之下,微调和强化学习方法明确优化模型参数,显著增强了代理的推理和决策能力。

尽管在自然语言处理领域取得了一些显著进展,但仍然存在一些关键挑战。其中,有限的泛化能力是一个重要问题,这意味着现有的模型可能无法很好地适应新的任务或场景。此外,任务流程的灵活性也是一个难点,现有的工具难以灵活地组合使用。同时,集成粒度外部工具也面临着困难。另外,高级规划和优化所需的计算复杂性也是目前面临的挑战之一。

为了解决这些挑战,未来的研究方向将更加注重更广泛和更灵活的工具集成,例如基于操作符架构的模块化能力提供者、异步和并行规划框架(如有向无环图方法)以及多代理体系结构的端到端优化方法,如分层强化学习或多阶段微调管道等。随着大规模预训练模型技术的不断发展,DR agents有望改变复杂的科研工作流程,提高人类生产力,并推动学术和工业领域的创新。

补充资料

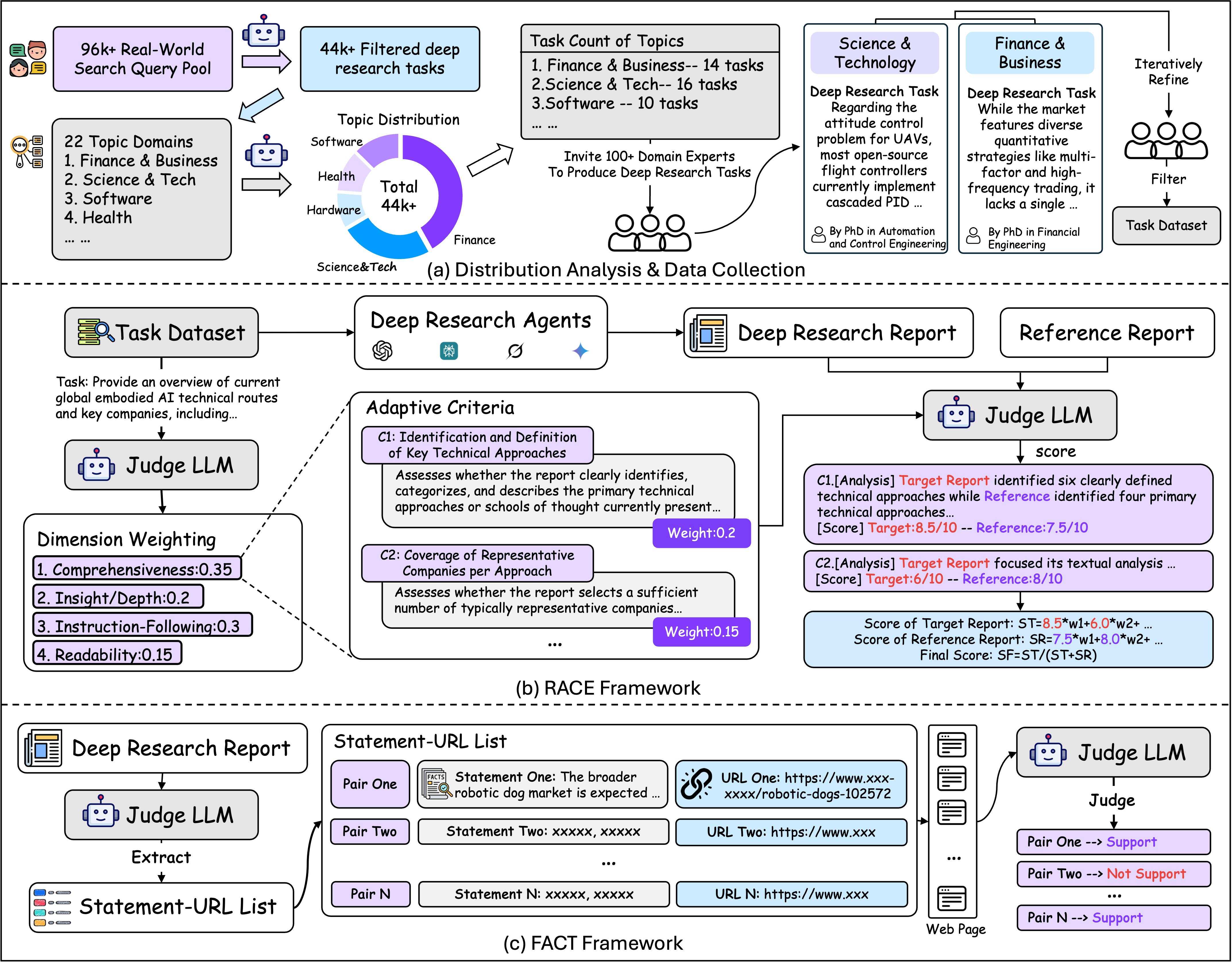

DeepResearch Bench:一个Deep Research Agents 的全面Benchmark

Deep Research Agents是基于大模型的智能体中一个引人注目的类别。它们通过自主协调多步骤的网络探索、精准检索以及higher-order的综合分析,能够将海量在线信息转化为具备分析师水准、富含引用文献的高质量报告——将原本需要数小时的手动案头研究工作,压缩至短短几分钟内完成。然而,目前仍缺乏一套全面的基准测试,用以系统性地评估此类智能体的能力。为此,我们推出了DeepResearch Bench基准测试集,它由100个博士级研究任务组成,每个任务均由来自22个不同领域的权威专家精心设计。由于对DRAs的评估本身复杂且耗时费力,创新性地提出了两种全新方法,能够有效贴近人类的判断标准。其一,是一种reference-based的评估方法,配备自适应评判标准,用于衡量生成研究报告的质量;另一套框架则专门针对DRA的信息检索与收集能力,通过评估其实际引用次数及整体引用准确性来加以评价。我们已将DeepResearch Bench基准测试集,以及这些评估框架的核心组件,以开源形式发布在https网址上,旨在加速基于大模型的实际智能体开发进程。

- DeepResearch Bench基准测试集:由100个博士级别的研究任务组成——其中50个为中文任务,50个为英文任务,涵盖22个不同领域。

- 设计了两个相辅相成的评估框架,分别从不同维度衡量DRA的能力,这两个框架协同工作,为DRAs的表现提供了全方位的综合评估。:

- RACE(基于参考的自适应标准驱动评估框架,具备动态权重功能),用于评价生成的研究报告质量;

- FACT(事实丰富度与引用可信度评估框架),则专注于评估信息检索效果及引用准确性。

AgentOrchestra: Orchestrating Hierarchical Multi-Agent Intelligence with the Tool-Environment-Agent(TEA) Protocol

近年来,基于大语言模型的智能体系统取得了显著进展,展现出解决复杂任务的卓越能力。然而,当前的协议(如A2A和MCP)在上下文管理、对多样化环境的适应性以及动态智能体架构的构建方面仍显不足。为突破这些局限,我们提出了**Tool-Environment-Agent (TEA)**协议,为将环境、智能体与工具无缝整合到统一系统中奠定了扎实的理论基础。该协议将环境和智能体视为一类核心资源,从而实现全面的上下文管理和灵活的环境集成。在此基础上,我们创新性地推出了AgentOrchestra——一个分层式多智能体框架,其中包含一个中央规划智能体,负责分解复杂目标并协调各专业化的子智能体。每个子智能体均专注于特定功能,具备数据处理、文件操作、网页导航及交互式推理等强大能力。尤为值得一提的是,**AgentOrchestra还引入了工具管理智能体,支持通过动态的工具创建、检索与复用机制,推动系统的智能化演进。**在三大常用基准测试中的实验表明,AgentOrchestra的表现始终优于现有基线,在GAIA测试集上更是以83.39%的优异成绩跻身顶级通用型大模型驱动智能体行列。这些成果充分彰显了TEA协议及其分层化组织架构在构建通用型多智能体系统方面的强大效能。

参考资料

- Du M, Xu B, Zhu C, et al. DeepResearch Bench: A Comprehensive Benchmark for Deep Research Agents[J]. arXiv preprint arXiv:2506.11763, 2025.

- Huang Y, Chen Y, Zhang H, et al. Deep research agents: A systematic examination and roadmap[J]. arXiv preprint arXiv:2506.18096, 2025.

- Zhang W, Zeng L, Xiao Y, et al. Agentorchestra: A hierarchical multi-agent framework for general-purpose task solving[J]. arXiv preprint arXiv:2506.12508, 2025.

1239

1239

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?