这是2015年NIPS的一篇经典的剪枝文章,由韩松大神所作,由于年代比较久远,所以就大概说一下它的重点内容,以便给模型剪枝有个初始印象。

Introduction

文章首先讲了LeNet、AlexNet和VGG这些当时经典的网络的参数量的非常大,同时需要的存储空间也越来越大;然后以能量消耗的角度谈了这些模型运行具体能消耗多少能量。这就引出了本文的目标,就是对较大的网络模型进行剪枝以降低能量消耗从而能在移动端实时运行。

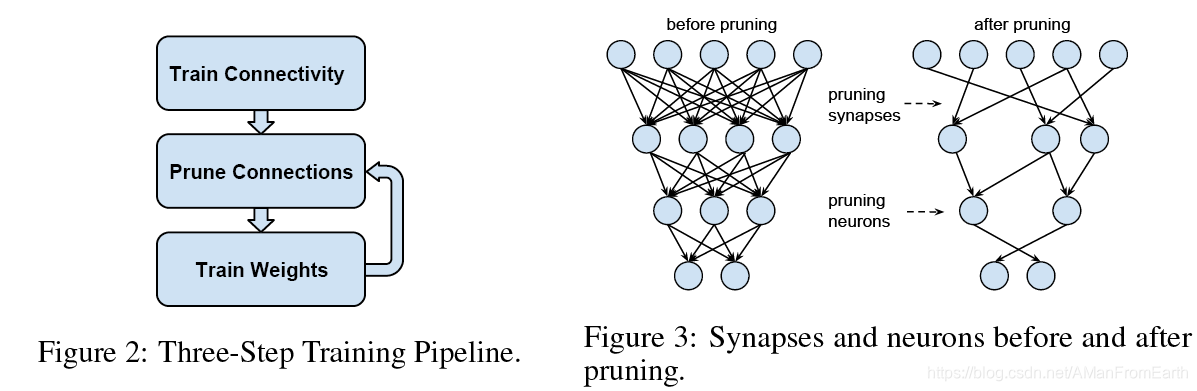

文章提出的剪枝策略是:①在初始模型训练完成后,②移除权重低于特定阈值的所有连接,即从稠密连接的网络剪枝得到一个稀疏连接的网络,③然后重新训练得到的网络用来减小精度损失。其中,②③两步可以多次迭代进行以得到最优模型。如图所示:

该策略能在剪枝后还能保持原有的精度几乎不损失。

Learning Connections in Addition to Weights

这里文章分析了一些(重)训练中使用的方法对重训练的影响。

正则化(Regularization)

我们知道,L1正则化使得网络模型变得稀疏,作者通过实验证明,如果不进行重训练的话,L1正则化比L2正则化使得网络精度损失少(如下图中随着剪枝比例增加,蓝色比紫色精度损失更少),但是经过重训练后L2正则化比L1正则化更好(如下图绿色对黄色)。而经过多

本文介绍了2015年NIPS上韩松大神关于网络模型剪枝的研究,探讨了如何通过移除权重低于特定阈值的连接来压缩和加速深度学习模型,同时保持精度。文章强调了在剪枝后进行重训练的重要性,分析了正则化方法(L1与L2)、dropout比例调整以及神经元剪枝对模型的影响。实验表明,该方法能够在几乎无精度损失的情况下,对VGG等模型实现13倍的压缩。

本文介绍了2015年NIPS上韩松大神关于网络模型剪枝的研究,探讨了如何通过移除权重低于特定阈值的连接来压缩和加速深度学习模型,同时保持精度。文章强调了在剪枝后进行重训练的重要性,分析了正则化方法(L1与L2)、dropout比例调整以及神经元剪枝对模型的影响。实验表明,该方法能够在几乎无精度损失的情况下,对VGG等模型实现13倍的压缩。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1104

1104

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?