1. 初识LSTM

我对LSTM的理解:

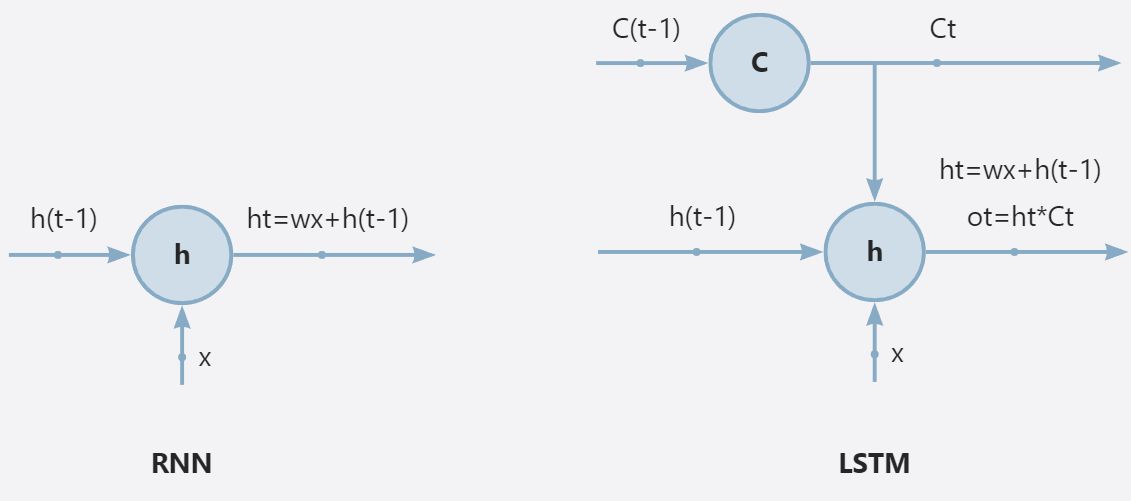

总结:一个短时记忆单元(RNN的隐藏层记忆单元)和一个长时记忆单元共同处理同一个数据得出输出结果

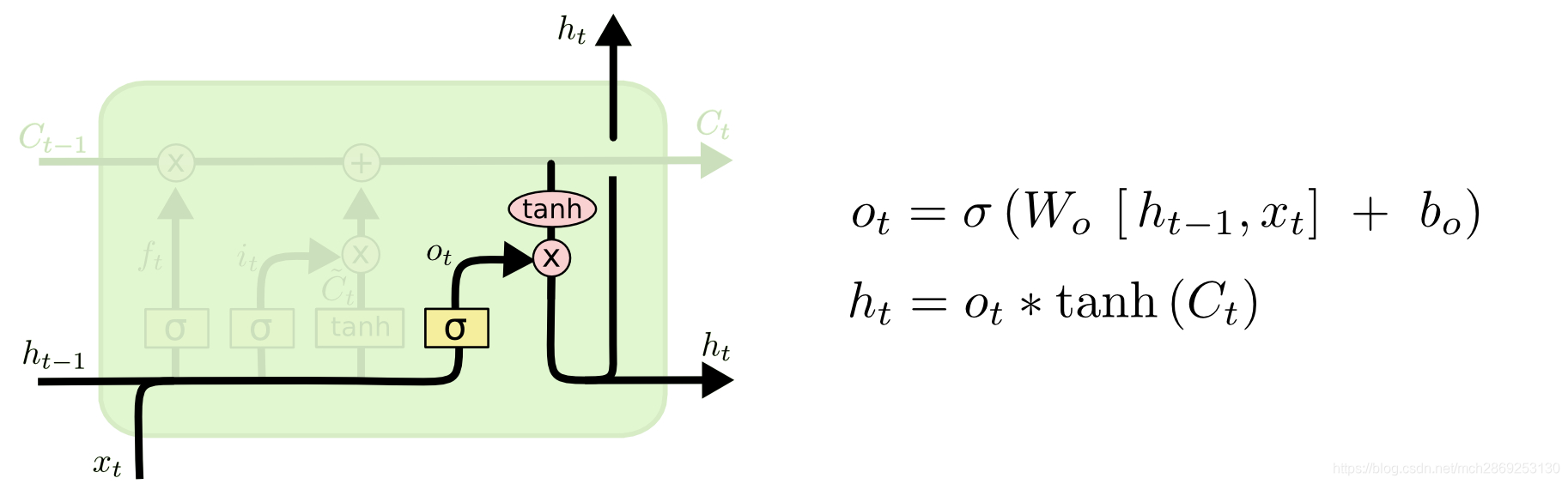

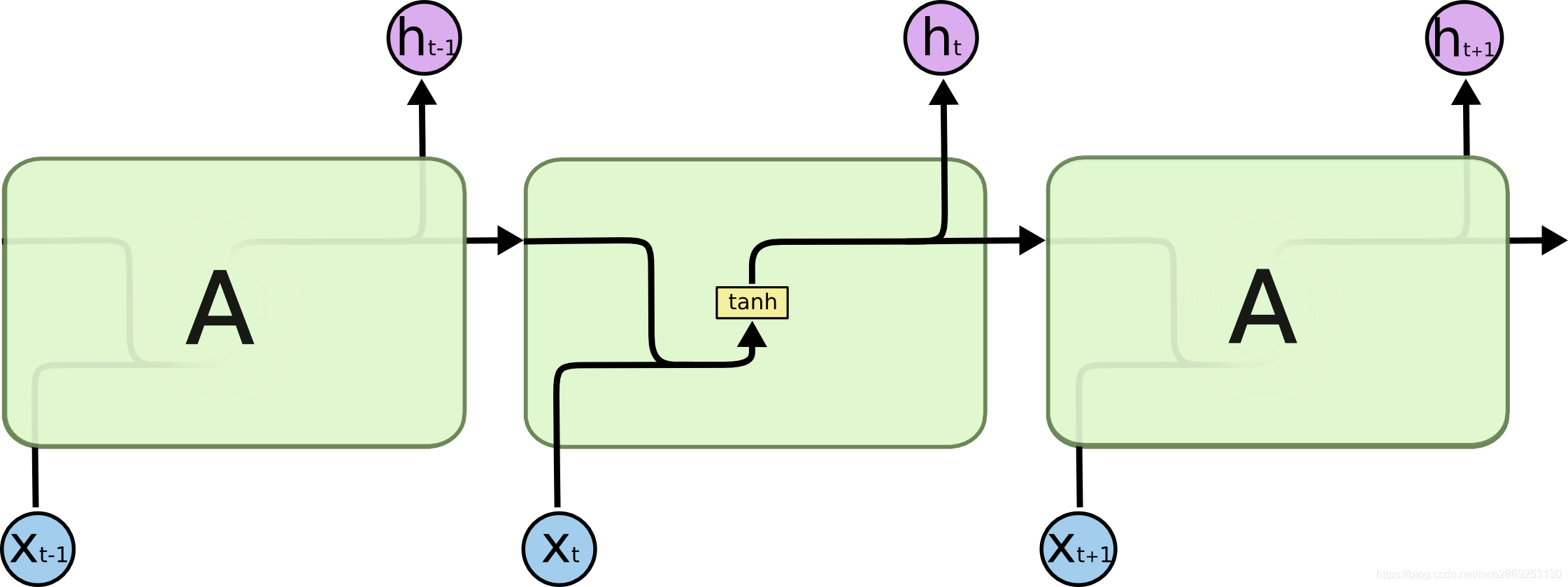

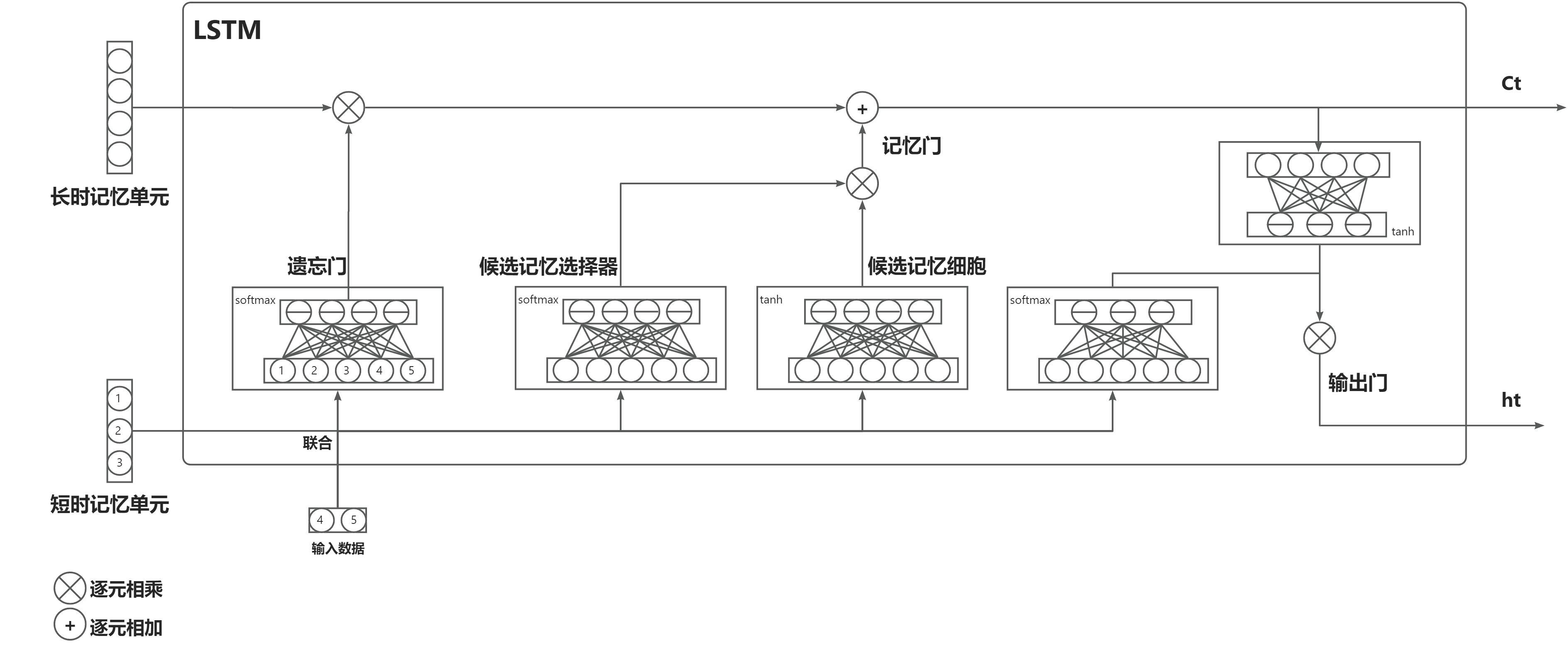

较详细解释:单看LSTM的输出层门,将输出ht改为输出ot将,sigmoid函数改成tanh函数便成了RNN网络单元。所以LSTM网络便是在RNN的基础上引入了记忆单元C,记忆单元在每个时间步进行一次遗忘门处理,一次记忆门处理,然后对RNN的输出再处理一遍,也就是说记忆单元C会对之前所有的信息都进行了记录然后对当下的RNN输出结果再共同处理一遍得到最终输出。简单说就是,一个短时记忆单元(RNN的隐藏层记忆单元)和一个长时记忆单元共同处理同一个数据得出输出结果。

2. 超详细拆解模型

LSTM一个时间步

对比一下RNN一个时间步

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?