想吃瓜的同学,直接往后看

训练

经过几次博文,Informer的模型已经完全复现了。接下来就是通过训练验证复现的模型是否可行。

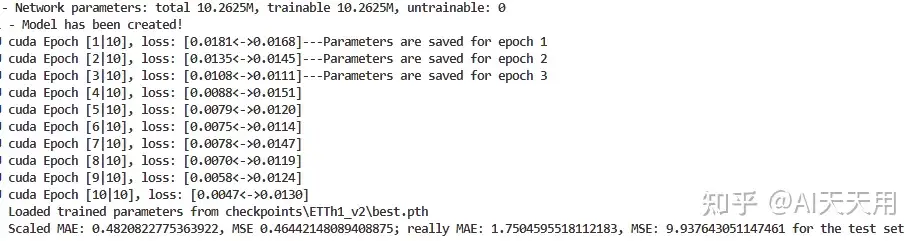

优化器optimizer用Adam,评价标准criterion用MSELoss(),学习率设置为1e-3,学习率衰减采用CosineLRScheduler (timm.scheduler.cosine_lr),预热5个epoch。batch_size和源代码保持一致,设置为32。pred_len设置为24。

经过10个epoch的训练,最终得到结果为

相较于源代码中公布的结果(MSE 0.577 和MAE 0.549)而言,复现的结果要比源代码的好。

同时,复现的代码也提供了真实的MAE和MSE(数据刚开始归一化进行训练,测试结果要反归一化)。

需要完整训练代码的同学,可关注公众号 (AI天天用),留言获取。

吃瓜

正当不同研究者疯狂研究Informer的时候,一朵(或许很多?)质疑的乌云悄悄地飘到了Informer的上空。

有的质疑在自己数据集上效果一般(以下截图来自知乎):

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

3312

3312

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?