为什么需要 Agentic Reasoning?

大语言模型(LLM)的推理能力一直存在"思维天花板"。LLM就像一个只会闭卷考试的学生,只能依赖预训练时记住的知识进行内部推演。当遇到需要实时数据验证、复杂计算或跨领域知识整合的问题时,这种单一推理模式就会暴露出三大致命缺陷:

-

1. 信息孤岛困境:模型无法主动获取最新信息,面对时效性强的提问(如"2024 年诺贝尔化学奖得主的研究突破")时,只能给出过时答案

-

2. 逻辑断层危机:在处理多步骤推理时,模型常常丢失中间结论的关联性。就像解数学题时忘记前面步骤的推导结果,导致最终结论偏差

-

3. 工具使用障碍:人类专家在解决问题时会自然调用计算器、搜索引擎、思维导图等工具,但传统 LLM 缺乏这种动态调用外部工具的能力

牛津大学团队在测试 DeepSeek-R1 等先进模型时发现,即便在数学解题正确率达到 90%的模型,面对开放性社会科学问题时,解释逻辑链条的完整性骤降至 40%。这种"理科尖子,文科差生"的偏科现象,暴露出现有推理范式的结构性缺陷。

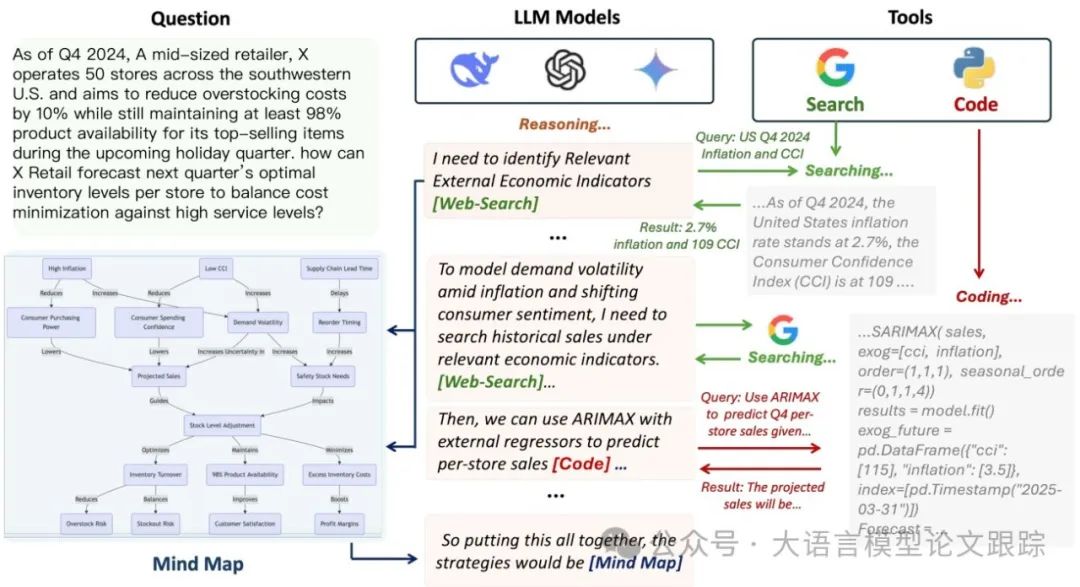

什么是 Agentic Reasoning?

Agentic Reasoning 框架创造性地将三个功能型 AI 智能体(Agent)整合进推理过程,构建起类人的工具使用思维链:

核心三剑客

-

1. Mind Map 智能体:相当于模型的"思维白板",实时构建知识图谱。当模型分析"全球气候变化对咖啡产业的影响"时,这个智能体会

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1604

1604

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?