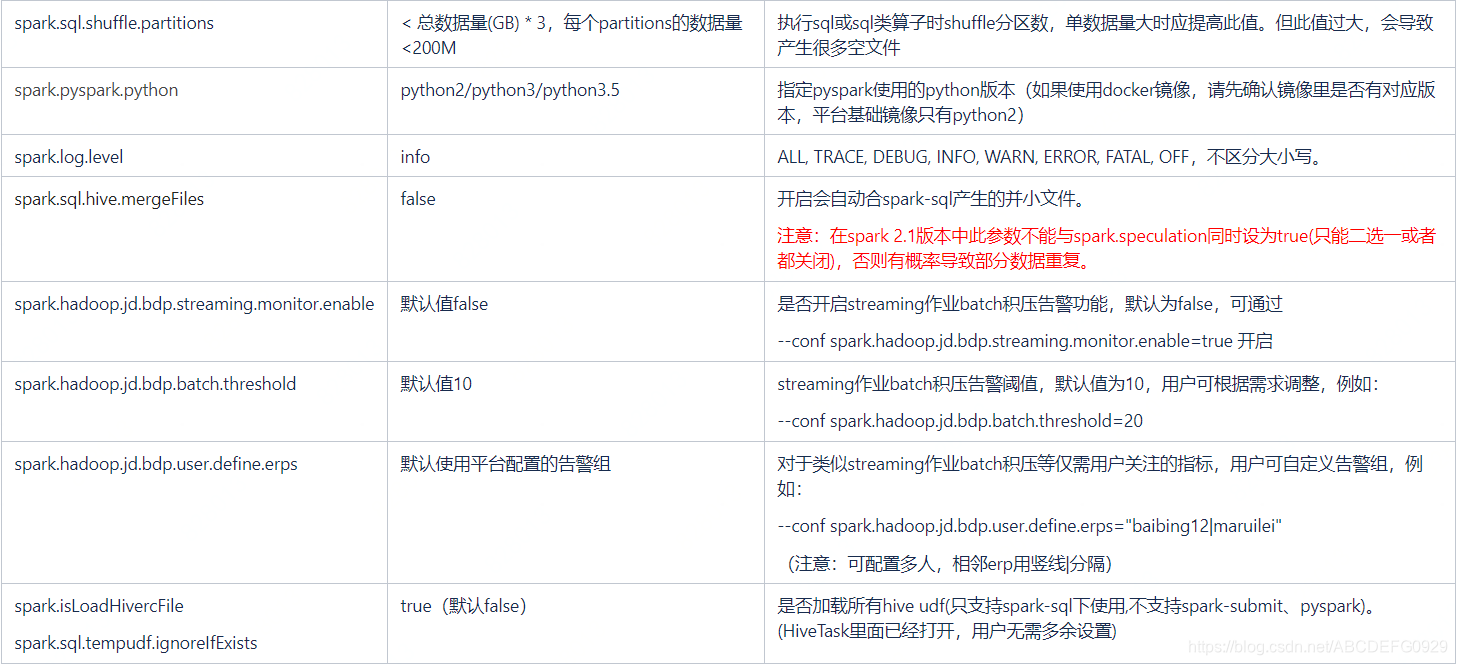

Spark常用参数解释及建议值

spark的默认配置文件位于堡垒机上的这个位置: $SPARK_CONF_DIR/spark-defaults.conf,用户可以自行查看和理解。

需要注意的是,默认值优先级最低,用户如果提交任务时或者代码里明确指定配置,则以用户配置为先。 用户再理解参数含义的基础上,可根据具体任务情况调整参数。

以下常用参数配置均可以通过 --conf XXX=Y 方式使用,其他参数以及介绍请参考 https://spark.apache.org/docs/latest/configuration.html

Spark默认使用jdk7,使用jdk8的话添加如下配置:

若只设置客户端jdk版本:

export JAVA_HOME=/software/servers/jdk1.8.0_121

若设置整个应用程序的jdk版本:

–conf spark.yarn.appMasterEnv.JAVA_HOME=/software/servers/jdk1.8.0_121

–conf spark.executorEnv.JAVA_HOME=/software/servers/jdk1.8.0_121

Spark使用各种python库请使用docker

DockerLinuxContainer的使用例子

./bin/spark-submit --class org.apache.spark

本文介绍了Spark的常用参数及其建议值,强调了默认配置的优先级最低,用户可以根据任务需求进行调整。例如,若要使用JDK8,需设置JAVA_HOME环境变量,并通过--conf指定。此外,建议在使用Python库时配合Docker容器。

本文介绍了Spark的常用参数及其建议值,强调了默认配置的优先级最低,用户可以根据任务需求进行调整。例如,若要使用JDK8,需设置JAVA_HOME环境变量,并通过--conf指定。此外,建议在使用Python库时配合Docker容器。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2903

2903

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?