LeNet架构

手写的数字识别

图片展示了两张包含手写文字信息的图片,一张是信封,另一张是支票,这表明LeNet架构可用于识别类似场景中的手写数字。

数据复杂度

数据处理:提到对数据进行居中和缩放处理。

数据量:有50000个训练数据和10000个测试数据。

图像规格:图像大小为28*28,共10类(对应0 - 9这十个数字)

LeNet架构组成

卷积编码器:由两个卷积层组成。

全连接层密集块:由三个全连接层组成,分别是全连接层(120)、全连接层(84)、全连接层(10)。

每个卷积层使用5×5卷积核和一个sigmoid激活函数。

LeNet简化版

学习表征

浅层学习:不涉及特征学习,其特征主要依靠人工经验或特征转换方法来抽取。

表示学习:如果有一种算法可以自动地学习出有效的特征,并提高最终机器学习模型的性能,那么这种学习就叫作表示学习 。

学习表征的实现方式

通常需要从底层特征开始,经过多步非线性转换才能得到。通过构建具有一定“深度”的模型,可以让模型自动学习好的特征表示,从底层特征,到中层特征,再到高层特征,从而最终提升预测或识别的准确性。

视觉分层理论

该理论认为视觉处理是从底层到高层不断抽象的过程。人类视觉中,V1层处理边缘、线条等简单特征,V2层处理形状等更复杂特征;在卷积神经网络(CNNs)可视化中,第一层卷积层(1st CL)类似处理边缘等简单特征,第二层卷积层(2nd CL)处理更复杂特征,最终实现分类(CLs)等任务。

ImageNet数据集(2010)

AlexNet架构

AlexNet的背景与改进

背景:AlexNet在2012年赢得了ImageNet竞赛,它可以看作是更深更大的LeNet。

主要修改:采用丢弃法防止过拟合;使用ReLU激活函数进行训练。

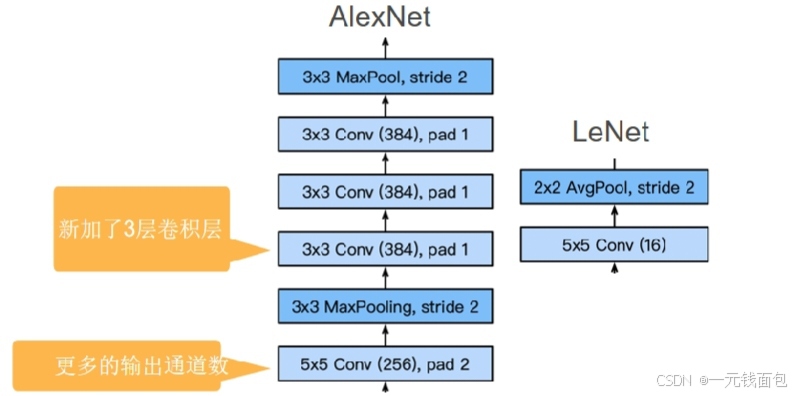

架构对比

池化层:AlexNet的池化窗口更大,且为最大池化(3x3 MaxPool, stride 2),而LeNet是平均池化(2x2 AvgPool, stride 2) 。

卷积层:

AlexNet使用更大的卷积核(11x11 Conv (96), stride 4 等)、更大的步长,由于处理的图像尺寸增大(3x224x224),输出通道更多。相比之下,LeNet卷积核较小(5x5 Conv (6)等),处理图像尺寸为32x32 。

AlexNet新增了3层卷积层,且每层输出通道数更多,如3x3 Conv (384)等,而LeNet相应卷积层输出通道数较少,如5x5 Conv (16) 。

全连接层:

AlexNet有1000类输出,隐含层大小从120增加到4096,结构为Dense (4096) - Dense (4096) - Dense (1000) 。

LeNet输出为10类,隐含层结构为Dense (120) Dense (84) - Dense (10) 。

1.AlexNet比相对较小的LeNet5要深得多。A lexNet由八层组成:五个卷积层、两个全连接隐藏层和一个全连接输出层。

2.AlexNet使用ReLU而不是sigmoid作为其激活函数。

总结

·AlexNet的架构与LeNet相似,但使用了更多的卷积层和更多的参数来拟合大规模的ImageNet数据集。

·今天,AlexNet已经被更有效的架构所超越,但它是从浅层网络到深层网络的关键一步。

·新加入了Dropout、ReLU、最大池化层和数据增强

VGG网络

VGG网络结构

VGG19是VGG网络的一种典型架构,它共有16个卷积层和3个全连接层,此外还有5个最大池化层分布在不同的卷积层之下。

输入图像尺寸为224×224×3,随着网络的推进,特征图尺寸逐渐减小(如56×56×256、28×28×512等 ),通道数逐渐增加,最后通过全连接层和Softmax进行分类,输出1000类结果。

设计思路

对比AlexNet:AlexNet比LeNet更深入更大从而获得更强性能,在此基础上思考能否进一步增大网络深度。

选择方向:增加更多稠密层开销太大,因此选择增加更多卷积层,并将卷积层组合成块

VGG块

构成:由3×3卷积(填充=1,n层,m个通道 )和2×2最大池化层(步幅=2)构成。

探讨:在网络设计上探讨是更深还是更宽更好,对比了5×5卷积和3×3卷积,得出更深和更窄的网络结构更好的结论。通过堆叠多个小卷积核(3×3)的卷积层,VGG网络在保证感受野的同时,减少了参数数量,并且能够学习到更复杂的特征表示,在图像分类等任务中表现出色。

发展

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?