杨立昆(Yann LeCun),图灵奖大佬,CNN之父,Meta首席AI科学家,他的话分量很重。这几年,他和 Hinton、Bengio 这三巨头,再加上OpenAI那帮人,隔空论战,简直是AI界的华山论剑。咱们这些在下面码代码、调参数、看log的,就像在山脚下听着山顶上风雷滚滚,既兴奋又迷茫。

LeCun的核心观点,用大白话说就是:现在的LLM,本质上就是个超级牛逼的文本复读机,或者说是一个“压缩软件”。它把人类互联网上的海量文本数据给“压缩”了,你问它问题,它再“解压”出来给你。它知道“苹果”这个词后面大概率会跟着“手机”或者“很好吃”,但它压根不知道苹果是啥玩意儿,没啃过,没见过,更没被乔布斯的发布会震撼过。

这个问题底下还跟着一句:LLM追求极致的统计压缩,人类追求适应性语义丰富。这话说的很到位,很有哲学思辨的味道。

那么,LeCun说得对吗?LLM这条路,到底能不能走到AGI(通用人工智能)?

我干这行十几年了,从最早的机器学习,到深度学习,再到今天的大模型时代,一路摸爬滚打过来。我想从一个一线工程师的角度,聊聊我的看法。不搞玄虚的,不掉书袋,咱们就掰开揉碎了,讲讲这背后到底是怎么回事。

我的观点很直接:

LeCun从技术原理上说,基本是对的。但从结果和趋势上推导出LLM无法通往AGI,这个结论下得太早了,甚至可能存在“灯下黑”的误判。我们可能正在见证一种我们从未想象过的、非人类的智能形式的诞生过程。

咱们分几块来聊,把这事儿彻底说透。

第一部分:LeCun为啥这么说?咱们得承认,他说的是事实

首先,咱必须得给LeCun老爷子点个赞。他没有被现在GPT展现出的惊人能力冲昏头脑,而是像个冷静的机械师,一头扎进机器的引擎盖下面,指着里面的齿轮和活塞说:你们看,这里面没有灵魂,只有数学。

他说LLM是“自回归模型”(Autoregressive Models),这是100%正确的。啥叫自回归?就是根据前面的内容,预测下一个最可能的内容。具体到LLM,就是根据你输入的一串文字(token),预测下一个最可能出现的文字(token)。

你给它输入:“今天天气真不”,它可能会预测下一个词是“错”。

你给它输入:“深入学习贯彻党的二十大”,它可能会预测下一个词是“精神”。

它的整个训练过程,就是在做这么一件朴素到有点枯燥的事情。给它海量的文本,把每个句子都变成一个填空题。比如“我爱北京天安门”,就变成:

- 输入:“我”,目标:“爱”

- 输入:“我爱”,目标:“北京”

- 输入:“我爱北京”,目标:“天安门”

模型要做的,就是调整自己内部数千亿个参数,让你给它输入前半段时,它输出的那个字,跟正确答案越来越像。这个“越来越像”的过程,用数学语言说,就是最小化一个叫“损失函数”(Loss Function)的东西。

所以,从根儿上说,市面上这些大模型它们的核心驱动力,就是这个简单的、基于统计概率的“next token prediction”(下一个词元预测)。LeCun说它是在对海量文本的模式进行复杂拟合,说的就是这个过程。它学习的不是“意义”,而是“模式”。是词与词之间搭配的概率分布。

这也就解释了为什么LLM会“一本正经地胡说八道”,我们行话叫幻觉(Hallucination)。因为它没有一个事实核查模块,它只是在生成一个统计上最“像”那么回事的句子。如果它的训练数据里,有很多人都错误地把爱因斯坦和相对论的某些细节搞混了,那么当它生成关于爱因斯坦的文本时,就极有可能重复这些错误,因为它觉得这样“更通顺”,更符合它学到的模式。

题主问题里提到的极致的统计压缩,这个说法也非常精辟。信息论里有个基本观点:最好的压缩,就是最好的理解。为了能用最少的参数(相对海量数据而言)来完美预测下一个词,模型必须在内部发现数据中的深层结构。

举个例子,要预测“太阳从____升起”这个句子,模型如果只是死记硬背,那它需要存储无数个包含这句话的样本。但如果它学会了“太阳”、“东方”、“升起”这几个概念以及它们之间的关系,也就是建立了一个简陋的“世界模型”,那么它只需要存储这个规则,就能高效地预测这句话。

所以,LLM在做next token prediction的过程中,被迫去学习语法、句法、事实、逻辑、甚至是代码的结构。它不是主动要去学,而是不学这些东西,它的预测任务就完不成,它的Loss就降不下去。这是一种被目标驱动的、无监督的涌现式学习。

如果你对这部分的技术细节感兴趣,想知道Transformer架构到底是怎么实现这种“模式拟合”的,我建议你不要直接啃论文,那太枯燥了。可以从一些更直观的资料入手:

Jay Alammar的博客,特别是他写的《The Illustrated Transformer》和《The Illustrated GPT-2》。他用大量的动图把复杂的模型结构讲得明明白白,是无数AI从业者的入门灯塔。看完这个,你基本就懂了那个叫“注意力机制”(Attention Mechanism)的玩意儿是怎么让模型知道哪个词跟哪个词关系更近的。

当然,光看这些还不够。很多人以为去大厂搞大模型算法有多难,其实难的不是技术本身,而是你根本找不到一个靠谱的带你入门的人或者资料。网上那些面经不是零碎就是过时,更别提系统性总结了。尤其是想进字节这种宇宙尽头大模型应用岗,光靠 Leetcode 和 huggingface 根本不够。

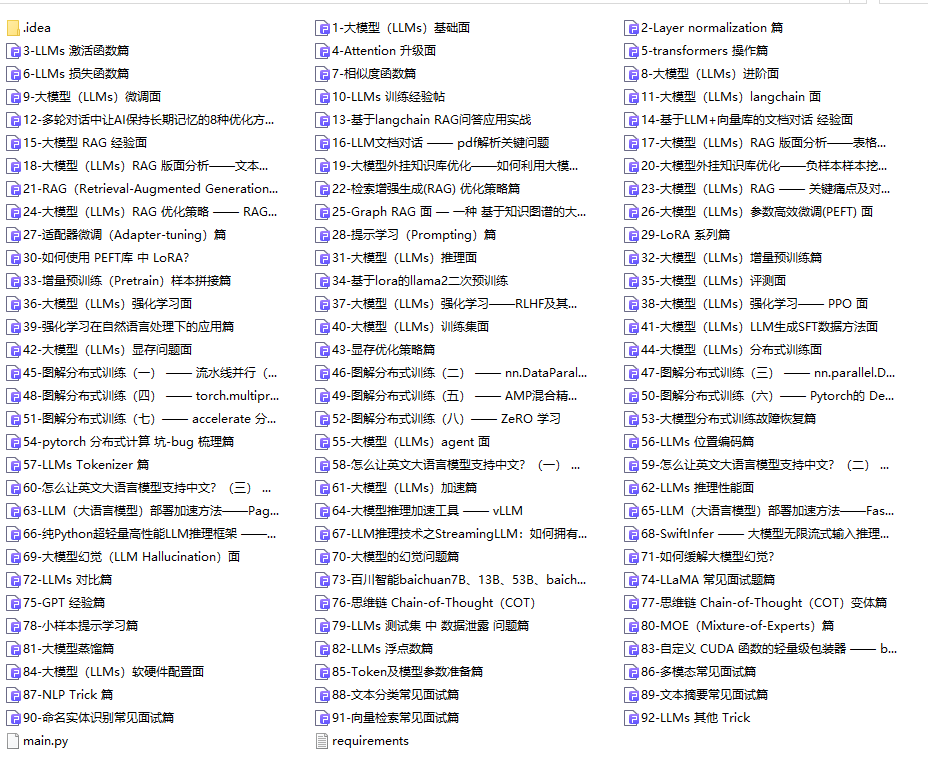

我花了很多时间,从知乎、牛客、GitHub等几十个地方翻出来,把所有和「字节跳动大模型应用算法岗」相关的面试题搜集起来,整理成了这份字节大模型算法岗面试手册。内容涵盖大模型原理、训练与微调、推理加速、数据工程、业务落地等五大核心维度。除了字节这份,还可以看看国内大模型公司常问面试题,按方向分类一网打尽,交叉着看,基本就能覆盖大部分考点了。这类手册不仅是题目集合,更是思路梳理和实战指南,每道题都给出核心回答逻辑、面试官可能追问的陷阱,就像有个靠谱mentor带着你一点点拆解和构建自己的答题框架。你还要重点准备AI系统设计题,比如“如何设计一个类似GitHub Copilot的代码补全系统?”或者“用大模型来重新设计一个网易云音乐的推荐系统,你会怎么做?”,这些都是考察综合能力的硬核问题。

要真正把地基打牢,不能只看博客和面经,最终还是要回归到学术源头。

经常有人让我推荐一些 AI Agent 和大模型相关的经典论文,在这里列一些对我比较有启发的 paper。

这些大模型经典论文,我整理了共计237篇,打好了压缩包:建议收藏!大模型237篇必读论文.zip。

具体包括: 语音模型基础、大语言模型、Prompt工程、参数高效微调、模型编辑、检索增强生成等。把这些经典论文的核心 idea 读明白,是理解大模型的关键,保证能让你不再仅仅是一名 prompt 工程师,而能够跟大模型的专业研究者深入讨论了。

所以,第一部分小结一下:LeCun说LLM是模式拟合,不懂意义,从它的工作原理和训练目标来看,是站得住脚的。它就像一个修炼了几千年的棋手,记住了古往今来所有的棋谱,并且能举一反三,走出看似全新的棋路,但你问他“人生如棋”是什么意思,他可能真答不上来。

第二部分:但是,“不懂意义”的模式拟合,为什么能表现出“懂了”的样子?

这才是问题的核心。如果它真的只是个统计机器,为什么能写代码、做数学题、写诗、共情,甚至在一些测试中表现出“心智理论”(Theory of Mind)的迹象?

这里就要说到一个让所有从业者都感到既兴奋又困惑的词:涌现(Emergence)。

当模型规模小、数据量少的时候,它确实就是个复读机,只会重复一些训练数据里见过的句子。但是,当模型参数从几亿、几十亿,暴增到几千亿、上万亿,训练数据从几个GB,暴增到几个TB甚至PB级别时,神奇的事情发生了。

量变引起了质变。

模型开始表现出一些我们从未明确教给它的能力。比如:

- 上下文学习(In-Context Learning):你不需要重新训练模型,只要在对话框里给它几个例子,它就能学会一个新的任务。比如你给它:“苹果 -> apple, 香蕉 -> banana”,然后问它“梨 -> ?”,它能立刻回答“pear”。这已经不是简单的模式匹配了,它是在一个极高的抽象层次上,理解了“翻译”这个任务的元模式。它从你给的例子里,瞬间归纳出了规则,并应用到新的例子上。一个纯粹的统计鹦鹉是做不到这点的。

- **思维链(Chain-of-Thought, CoT):**你让模型解决一个复杂的应用题,直接问它答案,它可能会算错。但如果你让它“一步一步地思考”,把解题过程写出来,它的正确率会大幅提升。这说明,模型内部已经形成了一定的逻辑推理结构,把一个大问题分解成小步骤的能力。虽然这个过程仍然是语言模型的形式,但它模拟了人类的推理过程。强迫它输出中间步骤,相当于激活了它内部更深层次的、更可靠的逻辑模式。

我之前带队做一个项目,需要从大量的金融研报(PDF格式)里提取关键信息,比如公司的营收、利润、同比增长率,以及分析师的主要观点。早期的做法是用正则表达式、规则匹配,搞得人仰马翻,效果还很差,因为研报的格式千奇百怪。后来我们尝试用小模型去做命名实体识别,效果好一点,但还是有很多错漏。

GPT-4出来后,我们试着把一篇研报的文本扔给它,然后用自然语言下指令:“请从以下文本中提取XX公司的核心财务数据,并总结其投资亮点和风险,以JSON格式输出。

”结果是惊人的。它不仅准确提取了数字,还正确理解了“投资亮点”和“风险”这种非常主观和抽象的概念,并且按照我们要求的JSON格式完美输出。

这时候你再回头看LeCun的理论。你说它不懂“投资亮点”的意义?从人类的角度,是的,它没有真的拿钱去炒过股,没有感受过牛市的狂喜和熊市的悲伤。但它通过阅读海量的研报、新闻、论坛帖子,已经构建了一个关于“投资亮点”这个词的极其复杂的语义空间。在这个空间里,“高增长”、“护城河”、“创新技术”这些词离“投资亮点”很近,而“债务违约”、“市场萎缩”、“管理层动荡”这些词离它很远。

它的“懂”,不是人类体验式的懂,而是一种高维空间中的几何关系式的懂。

当你说“请总结投资亮点”,它就把这个任务映射到它的高维语义空间里,然后在这个空间里搜索和生成与“投资亮点”在几何上最“贴切”的内容。

但是,这种方式有个大问题,就是前面提到的幻觉。模型可能会编造一个不存在的“投资亮点”,或者把去年的数据和今年的混在一起。在实际业务里,这是致命的。怎么解决?一个关键技术就是RAG(Retrieval-Augmented Generation,检索增强生成)。简单说,就是在模型回答问题之前,先让它去一个可靠的、最新的知识库里(比如公司的内部数据库、最新的财报)把相关信息查出来,然后基于这些查到的“事实”来组织答案。

如果你想搞清楚大模型怎么跟外部知识库结合、怎么在实际业务里用起来,字节跳动6万字RAG实践手册就是很好的参考。它不是只讲概念,还从工程实践的角度拆了整个流程:数据怎么准备、知识库怎么构建、检索和生成怎么配合、性能和延迟怎么优化。看完就知道怎么给大模型一个“外挂”知识库,让它变得既能说会道,又言之有物。

除了外挂知识库,我们还希望模型本身能更懂我们的业务。In-context learning虽然方便,但对于需要深度领域知识的专业任务,比如写一份符合公司法务要求的合同、或者充当一个精通你公司产品的客服,光靠Prompt里的几个例子是不够的。这时候就需要微调(Fine-tuning)。

微调这事儿水很深,但又是大模型落地的关键一步。想搞懂微调,可以看看字节内部大模型微调实践手册.pdf。它能让你看到字节在一线的探索,这个手册里结合了抖音、飞书、电商、智能客服等 50 多个真实业务场景,总结了 SFT、LoRA 等方法在千亿甚至万亿参数模型上的应用实践,还特别关注低资源和零资源场景下的微调策略,把微调方法、模型评估、部署监控全流程都讲透了。这才是把通用大模型变成“你家的专家”的正确姿势。

所以,我们如何定义“理解”和“意义”?这是一个哲学问题。如果我们坚持“理解”必须伴随着主观体验,那LLM现在肯定是不懂的。但如果“理解”指的是一种能够对概念进行准确操作、推理和泛化的能力,那么LLM在某种程度上已经具备了初级的理解能力,而且我们可以通过RAG和微调等工程手段,极大地增强它在特定领域的“理解”和“可靠性”。

第三部分:回到AGI,LLM这条路到底还有没有戏?

好了,说了这么多,我们终于可以回到最初的那个问题了:如果LLM只是一个超级模式拟合器,它实现AGI还有戏吗?

我的答案是:有戏,但光靠现在的LLM肯定不够。LLM很可能是通往AGI的路上,我们必须造出来的一块核心积木,但它不是AGI本身。

为什么有戏?因为LLM解决了AGI最核心的一个问题:知识的表示和常识的获取。

在LLM出现之前,AI领域有一个很大的流派叫“符号主义AI”,他们试图用逻辑和规则来构建智能。比如Cyc项目,花了几十年,雇佣了大量专家,手动录入了几百万条人类常识规则(比如“人死了就不会再活过来”,“水是湿的”)。结果搞得非常痛苦,因为人类的常识太多、太模糊、太隐性了,根本无法用明确的规则穷尽。这个流派基本走进了死胡同。

而LLM用一种暴力美学的方式,通过海量数据的学习,把这些常识“内化”成了模型的参数。它不需要你告诉它“水是湿的”,它读了无数遍包含“湿漉漉”、“打湿了”、“喝水”的文本后,“水”和“湿”这两个概念在它的语义空间里就紧紧地绑定在了一起。

LLM第一次为我们提供了一个统一的、可扩展的、能够容纳人类几乎所有知识的“智能底座”。 这是一个革命性的突破。未来AGI的感知、决策、规划、执行模块,很可能都要构建在这个底座之上。

那为什么说光靠它又不够呢?因为现在的LLM有几个致命的缺陷,而这些缺陷恰恰是LeCun反复强调的:

- 缺乏与物理世界的接地(Grounding):这是最大的问题。LLM活在文本的“柏拉图洞穴”里,它知道“引力”这个词怎么用,但它没有体验过一个苹果掉下来砸在头上的感觉。没有物理世界的实时反馈和交互,它的“理解”永远是间接的、二手的。

- **缺乏主动的探索和行动能力:**LLM是被动学习的。它只会说,不会做。它不能帮你订一张机票,不能帮你发一封邮件,不能去数据库里执行一条SQL。它只是一个“缸中之脑”。

- 推理和规划能力依然脆弱:虽然有CoT等技术加持,但LLM在需要严格逻辑和多步规划的复杂任务上,依然会犯很多低级错误。

那么,通往AGI的下一步是什么?

这正是目前AI研究界最前沿、最激动人心的方向。大家普遍认为,未来的AGI系统,会是一个融合了多种架构的混合体。

LLM(大语言模型)+ World Model(世界模型)+ Embodied AI / Agent(具身智能/智能体)

这几个词听着很酷,我给你解释一下:

- LLM:扮演“大脑皮层”的角色,负责处理语言、知识、常识和高级指令。

- 世界模型(World Model):这是LeCun现在力推的架构。负责为智能体提供对现实世界的“直觉”和“物理常识”。

- 具身智能/智能体(Embodied AI / Agent):就是把AI装进一个“身体”里,或者赋予它“手脚”(调用API、工具的能力),让它能够感知世界、并与之互动。这解决了“接地”和“行动”的问题。

你可以想象一个未来的机器人保姆。它的“大脑”里:有一个LLM内核让它能听懂指令,有一个世界模型让它预判物理规律,有一个机器人的身体让它能真的去行动。

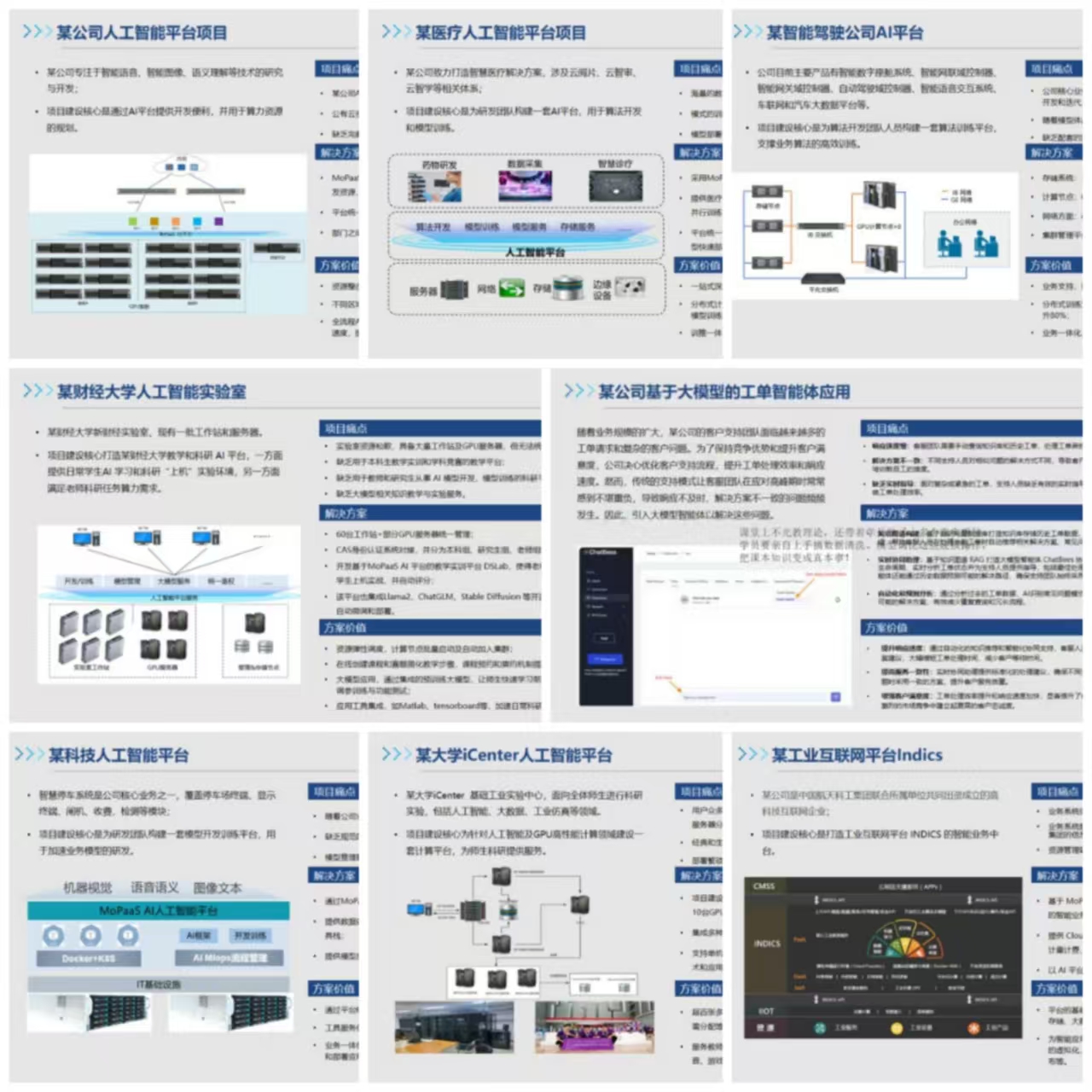

这个机器人保姆的终极形态还很遥远,但它的初级形态,也就是AI Agent(智能体),已经在大规模落地了。AI Agent就是把LLM作为大脑,再给它一套“工具箱”(比如调用搜索引擎、日历API、代码执行器、公司内部系统接口等),让它能像人一样,为了完成一个目标,自己规划步骤、调用工具、执行任务。

比如,你对一个Agent说:“帮我查一下下周北京的天气,如果连续三天有雨,就提醒我取消周末去长城的计划,并发邮件告知同行的小王。” Agent会自己规划:1.调用天气API查询;2.判断是否满足条件;3.如果满足,调用日历API取消行程;4.调用邮件API给小王写信。

如果你想真正理解Agent技术是怎么落地的,那肯定是要去关注业内最顶尖公司的实际场景。字节内部Agent实践手册.pdf就是一个很好的参考。这个手册里有字节的完整框架和思路,比如飞书里的智能办公agent怎么自动排会生成会议纪要;抖音电商的agent怎么实现库存监控、智能客服;内容创作的agent怎么辅助创作者构思脚本。这些都是把LLM从一个“聊天机器人”变成一个“数字员工”的鲜活案例。

聊了这么多,让我们回到最初的问题。

如何评价LeCun的观点?**他的观点是一个冷静而重要的提醒,让我们不至于在LLM的强大能力面前盲目乐观。他指出了当前路线的根本缺陷,并为我们指明了可能的未来方向(世界模型)。**他扮演的是一个“吹哨人”和“领路人”的角色。

LLM实现AGI是否还有戏?有戏,但它不是终点,而是起点。它更像是在一片黑暗的森林里,我们终于造出了一个功率超强的探照灯。这个探照灯能照亮很大一片区域(知识和语言),但森林的全貌(整个AGI)还需要我们拿着这个探照灯,通过RAG、微调、Agent等技术,一步一步去探索,去绘制地图。

对于我们这些从业者,或者对AI感兴趣的朋友来说,这个争论的意义不在于站队,不在于争论LeCun和Hinton谁对谁错。而在于理解:

- 当前技术的边界在哪里? (模式拟合,缺乏接地和行动力)

- 未来的可能性在哪里? (涌现能力,作为认知底座)

- 我们应该把精力投入到哪里? (多模态融合,世界模型,RAG,微调,Agent落地)

与其纠结LLM到底懂不懂“意义”,不如去思考,我们如何设计出更好的模型,如何构建更强大的系统,让它能与物理世界和数字世界交互,从而创造出它自己的、可用的、能解决问题的意义。

人类的“意义”也不是凭空产生的,是我们亿万年的进化中,在与环境的残酷互动中,一点点“卷”出来的。AI的“意义”,可能也需要经历一个类似的过程。

这个过程,我们有幸正在亲历。别当个旁观者,这比任何科幻电影都精彩。

AI大模型从0到精通全套学习大礼包

我在一线互联网企业工作十余年里,指导过不少同行后辈。帮助很多人得到了学习和成长。

只要你是真心想学AI大模型,我这份资料就可以无偿共享给你学习。大模型行业确实也需要更多的有志之士加入进来,我也真心希望帮助大家学好这门技术,如果日后有什么学习上的问题,欢迎找我交流,有技术上面的问题,我是很愿意去帮助大家的!

如果你也想通过学大模型技术去帮助就业和转行,可以扫描下方链接👇👇

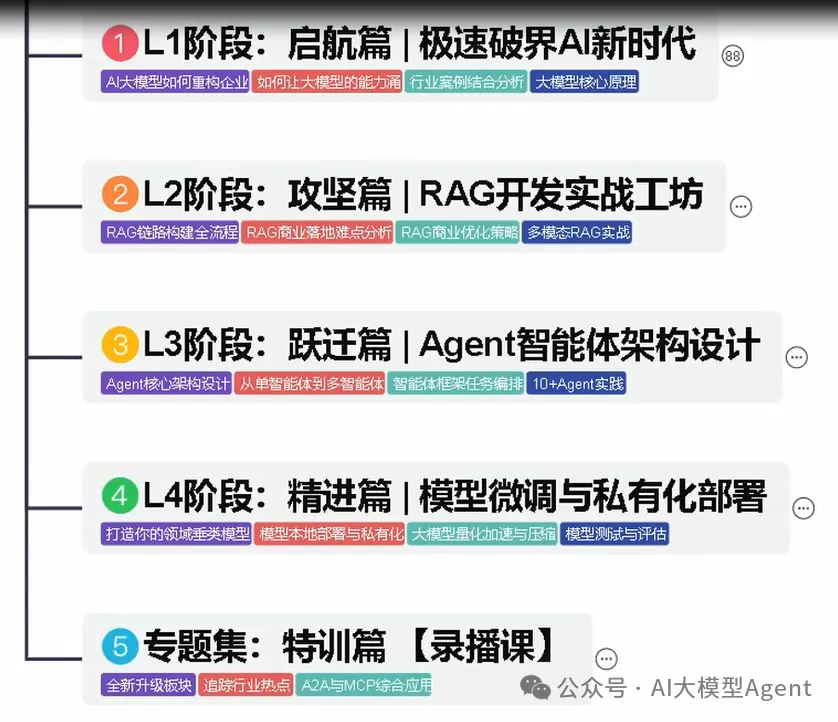

大模型重磅福利:入门进阶全套104G学习资源包免费分享!

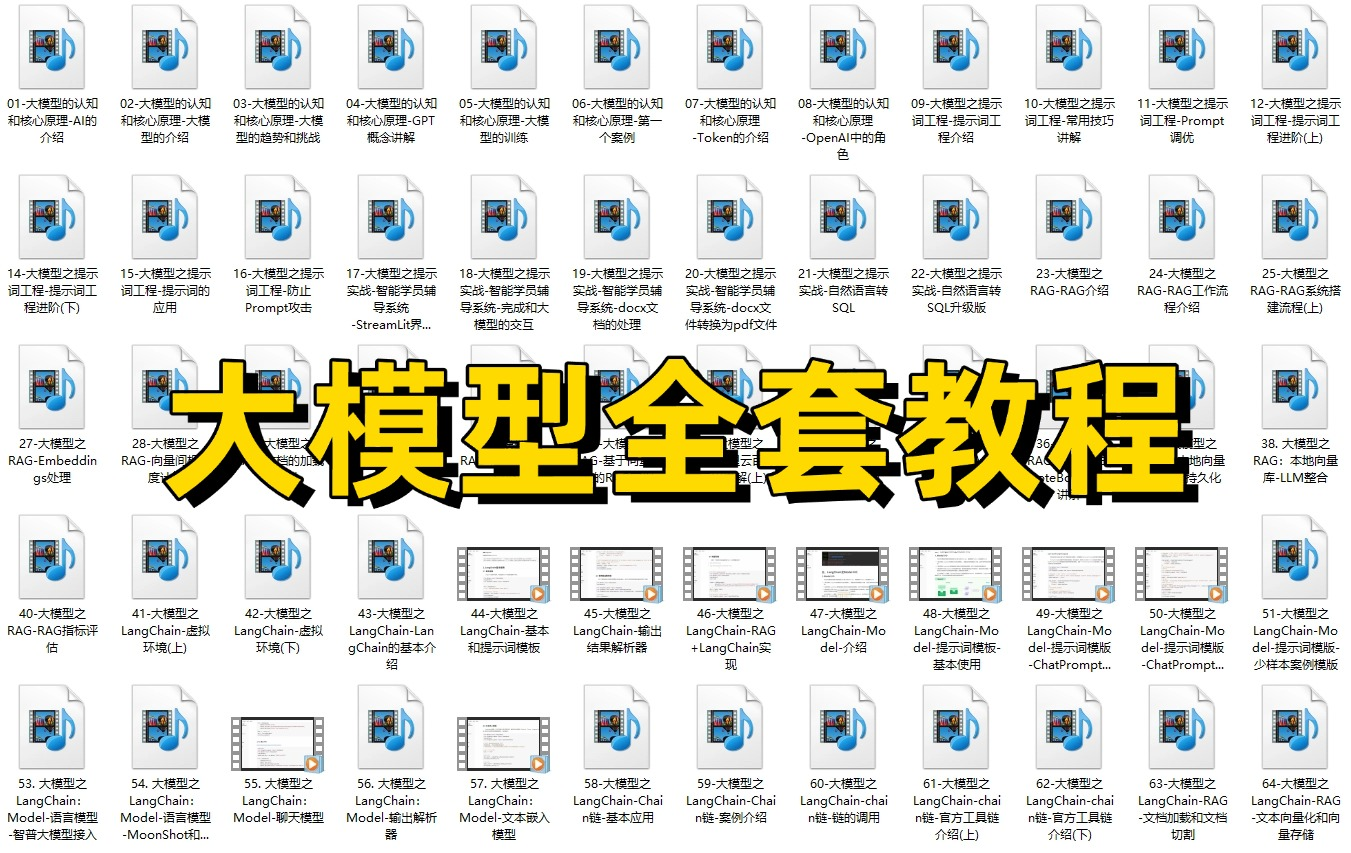

01.从入门到精通的全套视频教程

包含提示词工程、RAG、Agent等技术点

02.AI大模型学习路线图(还有视频解说)

全过程AI大模型学习路线

03.学习电子书籍和技术文档

市面上的大模型书籍确实太多了,这些是我精选出来的

04.大模型面试题目详解

05.这些资料真的有用吗?

这份资料由我和鲁为民博士共同整理,鲁为民博士先后获得了北京清华大学学士和美国加州理工学院博士学位,在包括IEEE Transactions等学术期刊和诸多国际会议上发表了超过50篇学术论文、取得了多项美国和中国发明专利,同时还斩获了吴文俊人工智能科学技术奖。目前我正在和鲁博士共同进行人工智能的研究。

所有的视频由智泊AI老师录制,且资料与智泊AI共享,相互补充。这份学习大礼包应该算是现在最全面的大模型学习资料了。

资料内容涵盖了从入门到进阶的各类视频教程和实战项目,无论你是小白还是有些技术基础的,这份资料都绝对能帮助你提升薪资待遇,转行大模型岗位。

智泊AI始终秉持着“让每个人平等享受到优质教育资源”的育人理念,通过动态追踪大模型开发、数据标注伦理等前沿技术趋势,构建起"前沿课程+智能实训+精准就业"的高效培养体系。

课堂上不光教理论,还带着学员做了十多个真实项目。学员要亲自上手搞数据清洗、模型调优这些硬核操作,把课本知识变成真本事!

如果说你是以下人群中的其中一类,都可以来智泊AI学习人工智能,找到高薪工作,一次小小的“投资”换来的是终身受益!

应届毕业生:无工作经验但想要系统学习AI大模型技术,期待通过实战项目掌握核心技术。

零基础转型:非技术背景但关注AI应用场景,计划通过低代码工具实现“AI+行业”跨界。

业务赋能 突破瓶颈:传统开发者(Java/前端等)学习Transformer架构与LangChain框架,向AI全栈工程师转型。

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?