-

每次添加元素到链表中的时候都是从头部添加

-

每次删除元素的时候都是从尾部删除

-

删除的时候同时从哈希表里面删除对应的key

-

再次访问的元素,需要把元素移动到链表的头部

Leetcode

========

Leetcode有LRU Cache经典算法题,这道题并不难,也是我当面试官经常考的一道题。

这道题算是LRU实现的简单版本,可以当作入门练习。

146. LRU 缓存机制

运用你所掌握的数据结构,设计和实现一个 LRU (最近最少使用) 缓存机制 。 实现 LRUCache 类:

- LRUCache(int capacity) 以正整数作为容量 capacity 初始化 LRU 缓存

- int get(int key) 如果关键字 key 存在于缓存中,则返回关键字的值,否则返回 -1 。

- void put(int key, int value) 如果关键字已经存在,则变更其数据值;如果关键字不存在,则插入该组「关键字-值」。当缓存容量达到上限时,它应该在写入新数据之前删除最久未使用的数据值,从而为新的数据值留出空间。

进阶:你是否可以在 O(1) 时间复杂度内完成这两种操作?

C++解答:

#include

#include<unordered_map>

using namespace std;

class LRUCache {

public:

struct Node {

Node(int key, int val) {

key_ = key;

val_ = val;

left_ = right_ = nullptr;

}

int key_, val_;

Node* left_, *right_;

};

LRUCache(int capacity) {

capacity_ = capacity;

head_ = new Node(-1, -1);

tail_ = new Node(-1, -1);

head_->right_ = tail_;

tail_->left_ = head_;

}

~LRUCache() {

Node *node = head_;

while (node != nullptr) {

Node *next = node->right_;

delete node;

node = next;

}

}

int get(int key) {

if(hash_.count(key) == 0) return -1;

Node *node = hash_[key];

if (node->left_ != head_) {

unlink(node);

insertToHead(node);

}

return node->val_;

}

void put(int key, int value) {

if (hash_.count(key) == 0) {

if (hash_.size() >= capacity_) {

Node *node = tail_->left_;

unlink(node);

hash_.erase(node->key_);

delete node;

}

Node *node = new Node(key, value);

hash_[key] = node;

insertToHead(node);

} else {

Node *node = hash_[key];

node->val_ = value;

if (node->left_ != head_) {

unlink(node);

insertToHead(node);

}

}

}

void insertToHead(Node *node) {

node->right_ = head_->right_;

head_->right_ = node;

node->left_ = head_;

node->right_->left_ = node;

}

void unlink(Node *node) {

node->left_->right_ = node->right_;

node->right_->left_ = node->left_;

}

private:

int capacity_;

unordered_map<int, Node*> hash_;

Node *head_, *tail_;

};

复制代码

开源项目应用

======

这里我会介绍LRU在各个常用的开源项目中的使用。

我会用尽量简短的语言概述,但是又能尽量包含关键信息。

Redis中使用LRU淘汰策略

Redis 作为缓存使用时,一些场景下需要考虑内存的空间消耗问题。

Redis 有很多淘汰策略,其中和LRU相关的有其中的两种:

allkeys-lru: 对所有的键都采取LRU淘汰

volatile-lru: 仅对设置了过期时间的键采取LRU淘汰

我们知道,LRU算法需要一个双向链表来记录数据的最近被访问顺序,但是出于节省内存的考虑,Redis的LRU算法并非完整的实现。

Redis并不会选择最久未被访问的键进行回收,相反它会尝试运行一个近似LRU的算法,通过对少量键进行取样,然后回收其中的最久未被访问的键。通过调整每次回收时的采样数量maxmemory-samples,可以实现调整算法的精度。

在Redis3.0中,还新增加了一个淘汰池,本质上它是一个大根堆,新随机出来的key会添加到淘汰池,然后淘汰最旧的key。

关于Redis的淘汰策略或者LRU源码分析,也可以单独出一遍博客分析,这里篇幅所限不做详细分析了。

MySQL中InnoDB引擎中缓存池LRU算法

InnoDB的缓存池:简单来说就是一块内存区域,该区域内缓存着InnoDB访问存储在磁盘的数据和索引信息。缓冲池有两个作用,一是提高了大容量读取操作的效率,二是提高了缓存管理的效率。

MySQL的InnoDB引擎从磁盘加载数据页到缓存池时,往往连带着目标数据页相邻的数据页一起加载到缓存池中–MySQL预读机制。

为什么MySQL会存在预读机制呢?

其实就是提升性能。

但是另一方面可能会发生,预读进去的数据页几乎不被访问,但是由于LRU的特性,这部分数据页在预读进去后会处于链表的头节点附近,还可能淘汰一部分本身访问比较频繁的数据页。

所以MySQL采用了基于冷热隔离的LRU策略

LRU链被拆为两部分:一部分存储热数据,一部分存储冷数据。

当数据初次加载到缓存池中时,会首先放在冷链的头部,经过 innodb_old_blocks_time (默认1s)后如果再被访问,则将缓存页移动至热链头部。

实际业务使用

======

实际业务中主要针对热点数据使用内存LRU缓存来降低后端数据库或者Redis缓存的压力。

电商大促

大促期间秒杀促销或者人气店铺

我们在实际业务中使用了LRU缓存,主要是为了解决热点数据的访问问题。

我们的一些数据存在MySQL中,然后使用Redis的集群作为缓存。平时由于命中率比较高,MySQL的读取的QPS相对比较低,一切都很顺利。

写在最后

很多人感叹“学习无用”,实际上之所以产生无用论,是因为自己想要的与自己所学的匹配不上,这也就意味着自己学得远远不够。无论是学习还是工作,都应该有主动性,所以如果拥有大厂梦,那么就要自己努力去实现它。

最后祝愿各位身体健康,顺利拿到心仪的offer!

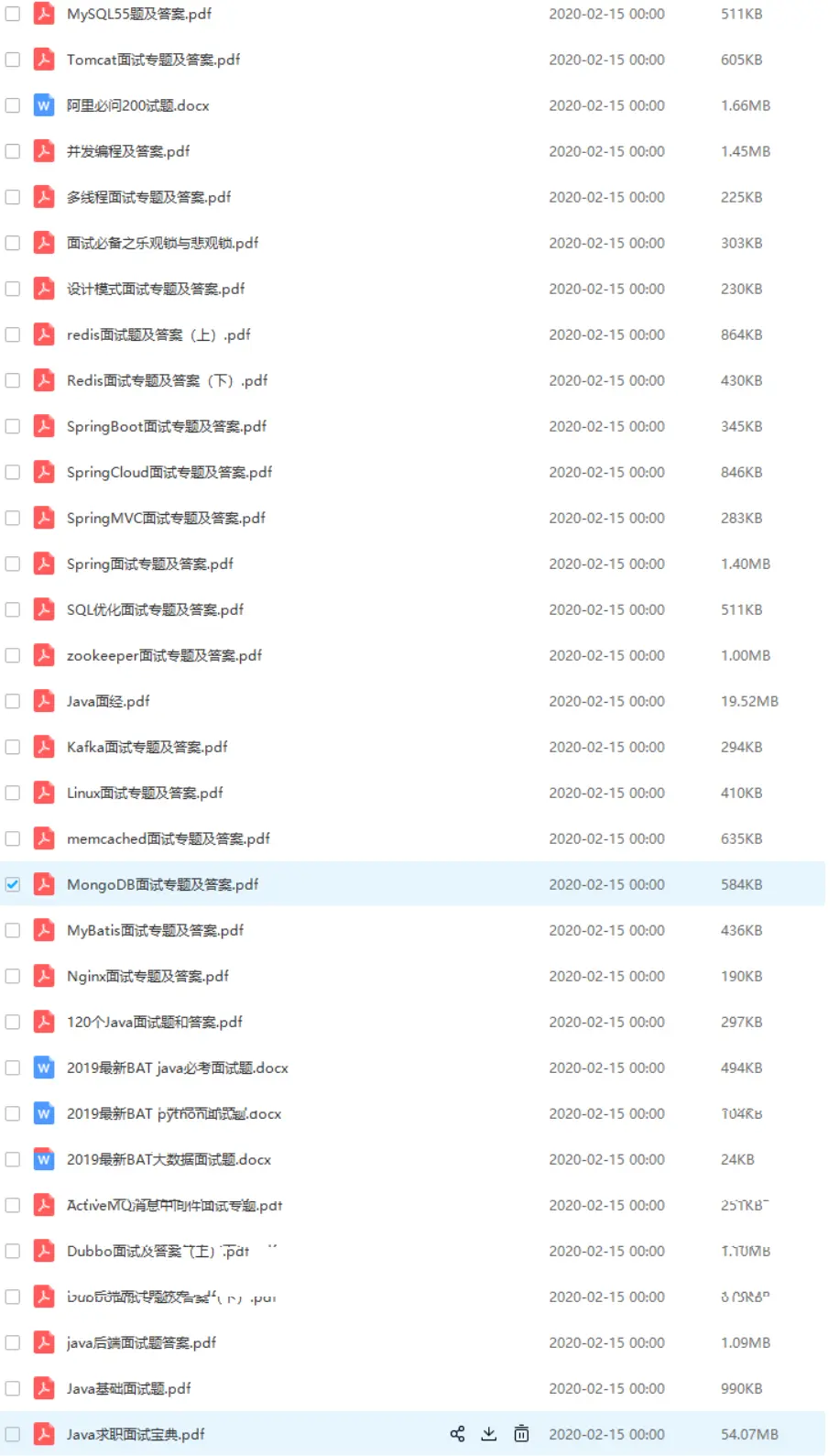

由于文章的篇幅有限,所以这次的蚂蚁金服和京东面试题答案整理在了PDF文档里

一切都很顺利。

写在最后

很多人感叹“学习无用”,实际上之所以产生无用论,是因为自己想要的与自己所学的匹配不上,这也就意味着自己学得远远不够。无论是学习还是工作,都应该有主动性,所以如果拥有大厂梦,那么就要自己努力去实现它。

最后祝愿各位身体健康,顺利拿到心仪的offer!

由于文章的篇幅有限,所以这次的蚂蚁金服和京东面试题答案整理在了PDF文档里

[外链图片转存中…(img-Vuwaxuwx-1718857526256)]

[外链图片转存中…(img-Roptlizv-1718857526257)]

[外链图片转存中…(img-XDwaFle4-1718857526260)]

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?