网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

下面是一个使用协程和通道的案例,展示了如何并发下载多个文件:

package main

import (

"fmt"

"io/ioutil"

"net/http"

"time"

)

func downloadFile(url string, c chan<- string) {

resp, err := http.Get(url)

if err != nil {

c <- fmt.Sprintf("Error: %v", err)

return

}

defer resp.Body.Close()

data, err := ioutil.ReadAll(resp.Body)

if err != nil {

c <- fmt.Sprintf("Error: %v", err)

return

}

filename := fmt.Sprintf("%d.txt", time.Now().UnixNano())

err = ioutil.WriteFile(filename, data, 0644)

if err != nil {

c <- fmt.Sprintf("Error: %v", err)

return

}

c <- fmt.Sprintf("Success: %s", filename)

}

func main() {

urls := []string{

"https://example.com/file1.txt",

"https://example.com/file2.txt",

"https://example.com/file3.txt",

}

results := make(chan string)

for \_, url := range urls {

go downloadFile(url, results)

}

for \_ = range urls {

fmt.Println(<-results)

}

}

在上面的案例中,我们创建了一个协程来下载每个文件,并将下载结果发送到结果通道中。主线程等待所有协程完成下载,并将结果从结果通道中接收并打印出来。

通过使用协程,我们可以并发地下载多个文件,提高下载的效率。

当然,下面我将为你介绍3个使用Golang协程的案例,并提供相应的代码和讲解。

案例1: 并发计算斐波那契数列

斐波那契数列是一个经典的计算问题,下面的示例展示了如何使用协程并发地计算斐波那契数列中的第n个数字。

package main

import (

"fmt"

"time"

)

func fibonacci(n int, c chan<- int) {

x, y := 0, 1

for i := 0; i < n; i++ {

c <- x

time.Sleep(time.Millisecond \* 100) // 模拟计算耗时

x, y = y, x+y

}

close(c)

}

func main() {

c := make(chan int)

go fibonacci(10, c)

for num := range c {

fmt.Println(num)

}

}

在上面的代码中,我们定义了一个fibonacci函数,它使用协程并发地计算斐波那契数列中的前n个数字,并将结果发送到通道c中。在main函数中,我们通过range语句从通道中读取结果并打印出来。

案例2: 并发爬取网页内容

在网络爬虫的场景中,我们通常需要并发地爬取多个网页的内容。下面的示例展示了如何使用协程并发地爬取多个网页的内容,并将结果发送到通道。

package main

import (

"fmt"

"io/ioutil"

"net/http"

)

func crawl(url string, c chan<- string) {

resp, err := http.Get(url)

if err != nil {

c <- fmt.Sprintf("Error: %v", err)

return

}

defer resp.Body.Close()

body, err := ioutil.ReadAll(resp.Body)

if err != nil {

c <- fmt.Sprintf("Error: %v", err)

return

}

c <- string(body)

}

func main() {

urls := []string{

"https://example.com",

"https://google.com",

"https://github.com",

}

results := make(chan string)

for \_, url := range urls {

go crawl(url, results)

}

for i := 0; i < len(urls); i++ {

fmt.Println(<-results)

}

}

在上面的代码中,我们定义了一个crawl函数,它使用协程并发地爬取每个给定的URL的内容,并将结果发送到通道results中。在main函数中,我们遍历URL列表,并使用协程同时爬取多个网页的内容。然后,通过读取通道中的结果,我们将每个网页的内容打印出来。

案例3: 并发处理图片处理任务

在图像处理的场景中,我们通常需要并发地处理大量的图片。下面的示例展示了如何使用协程并发地处理多个图片,并将结果发送到通道。

package main

import (

"fmt"

"image"

"image/jpeg"

"io/ioutil"

"os"

"path/filepath"

)

func processImage(filename string, c chan<- string) {

file, err := os.Open(filename)

if err != nil {

c <- fmt.Sprintf("Error: %v", err)

return

}

defer file.Close()

img, err := jpeg.Decode(file)

if err != nil {

c <- fmt.Sprintf("Error: %v", err)

return

}

// 图像处理逻辑...

// 这里只是简单地将图片大小调整为50x50像素

resized := resize(img, 50, 50)

// 保存处理后的图片

outputFilename := filepath.Join("output", filepath.Base(filename))

outputFile, err := os.Create(outputFilename)

if err != nil {

c <- fmt.Sprintf("Error: %v", err)

return

}

defer outputFile.Close()

err = jpeg.Encode(outputFile, resized, nil)

if err != nil {

c <- fmt.Sprintf("Error: %v", err)

return

}

c <- fmt.Sprintf("Success: %s", outputFilename)

}

func resize(img image.Image, width, height int) image.Image {

**既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上Go语言开发知识点,真正体系化!**

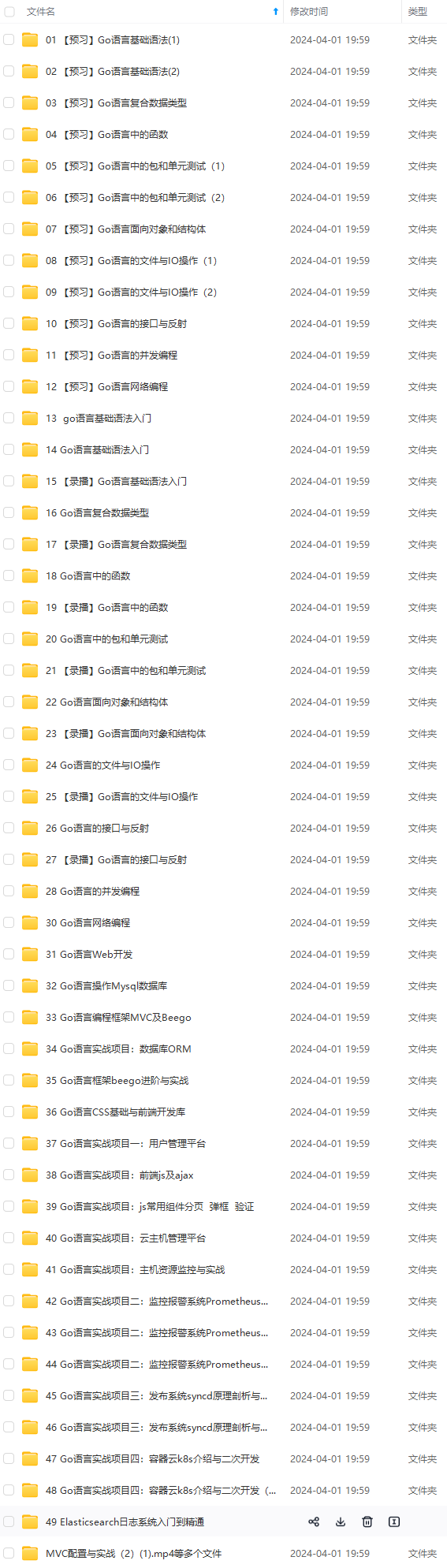

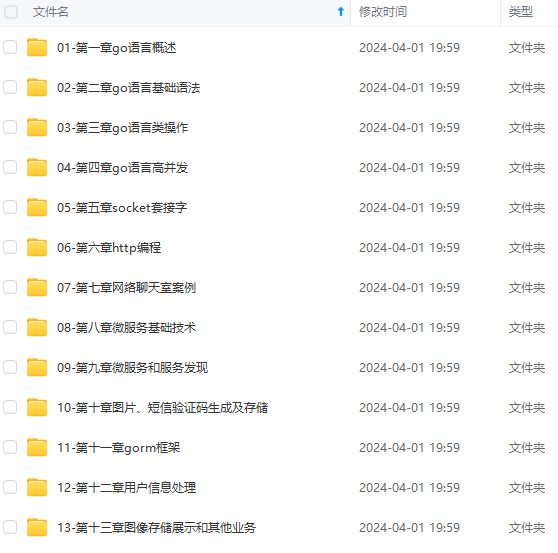

**由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新**

**[如果你需要这些资料,可以戳这里获取](https://bbs.youkuaiyun.com/topics/618658159)**

-iq6mFN3O-1715380026790)]

**既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上Go语言开发知识点,真正体系化!**

**由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新**

**[如果你需要这些资料,可以戳这里获取](https://bbs.youkuaiyun.com/topics/618658159)**

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?