前言

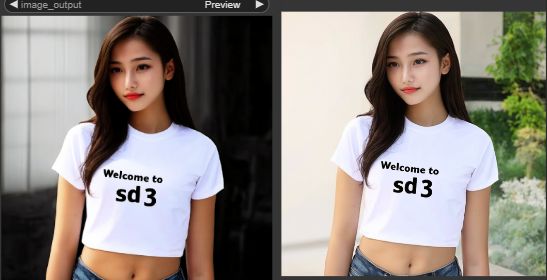

最近学习comfyui的工作流搭建及应用,发现搭建工作流有点像是炒菜,今天这个工作流我之前拆解过,但是没有给光指定方向和形状,第一次拆解的时候对某些节点的参数还不是很了解,所以今天再重新搭建一次!

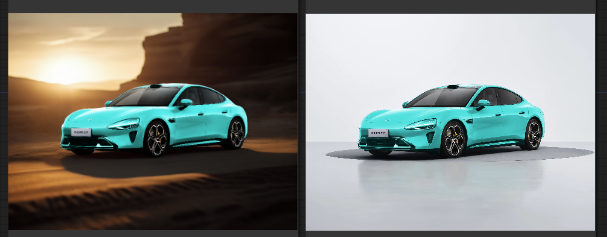

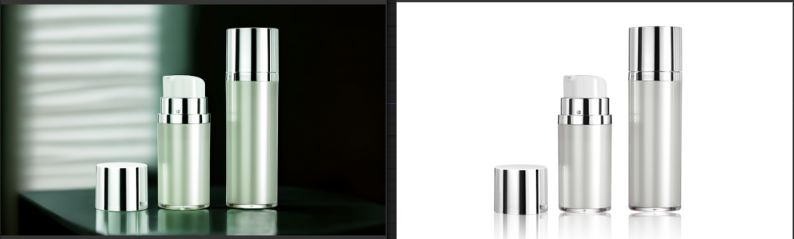

老规矩一句话描述工作流原理:文生图搭载光效节点对产品重新打光,并去除背景保留前景对背景进行重绘,制作光源控制光效!接下来开始准备材料,一步步拆解这个工作流!

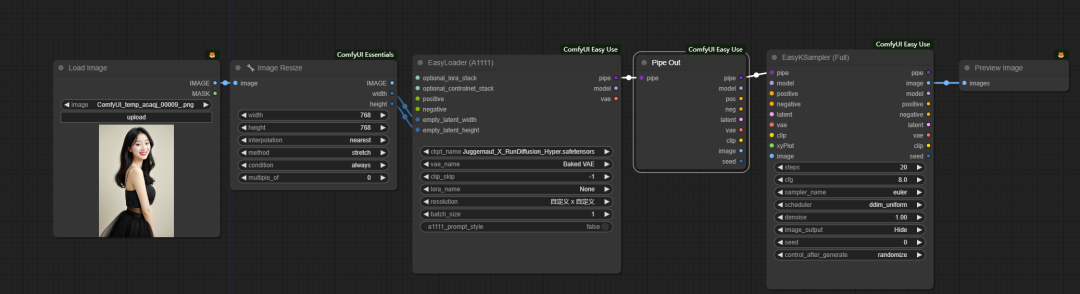

第一步、搭建easyuse 文生图工作流

这里顺便把将要处理的主体,改变尺寸后输给了emptylatent,尺寸这里限定了不超过768并且是按比例缩放,为什么是768呢?因为cilight目前只支持sd1.5的模型!

整理和输出教程属实不易,觉得这篇教程对你有所帮助的话,可以点击👇二维码领取资料😘

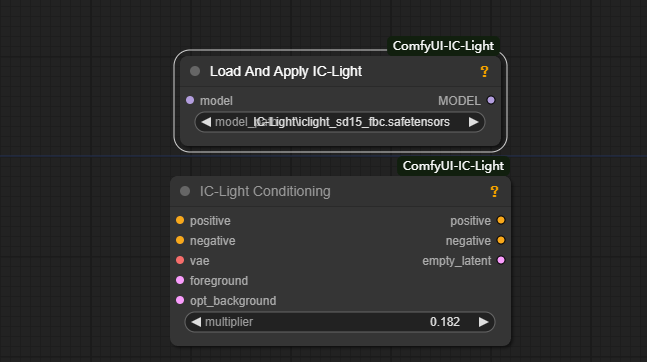

第二步、搭建IC Light 工作流

apply iclight和conditioning不用连接,这点好像和其他的模型组合步太一样啊,其余的按提示连接即可,至于foreground前景则是连接的需要应用光照条件的图像或图像部分,这个图像传送需要编码之后在连接foreground!

至于multiplier(乘数)它的数值越大,光照的效果越大,这个需要在应用的过程中具体调整!

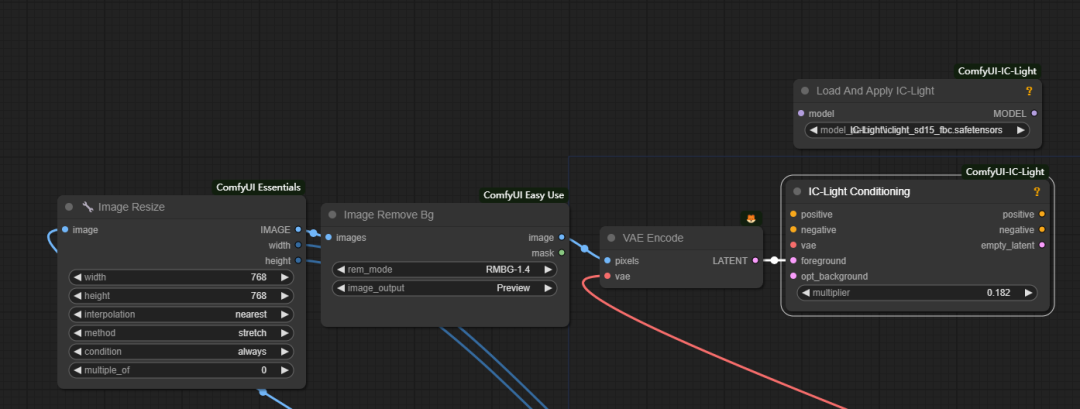

第三步、将图像进行编码连接到foreground

这里上传到是经过缩放并取出背景的图片,因为我们要给取出背景的人物或者图像应用光照!

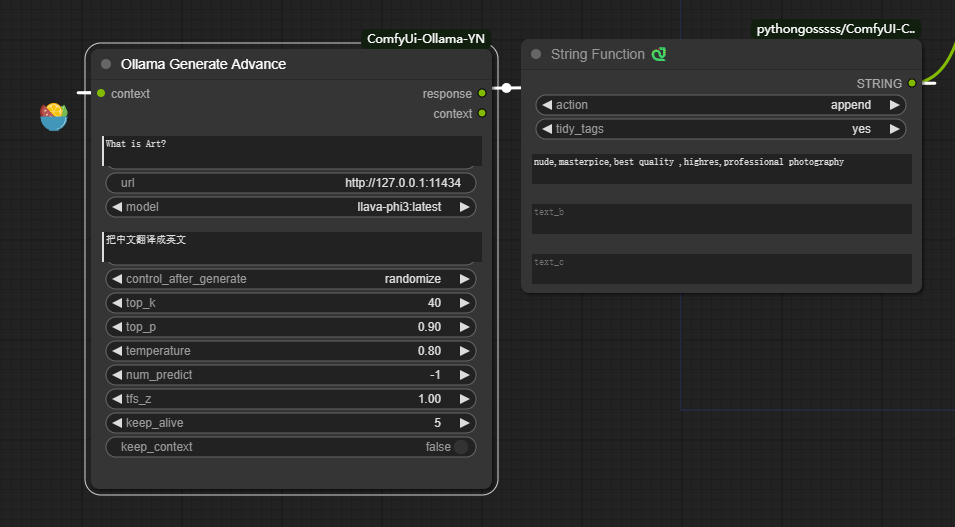

第四步:设置中文提示词工具

这里用到两个节点一个是ollama generate advance和stringfunction选择action的方式为append(增加),这样可以把ollama翻译成的提示词和质量提示词连接,方便我们不会英文的同学任意换背景!

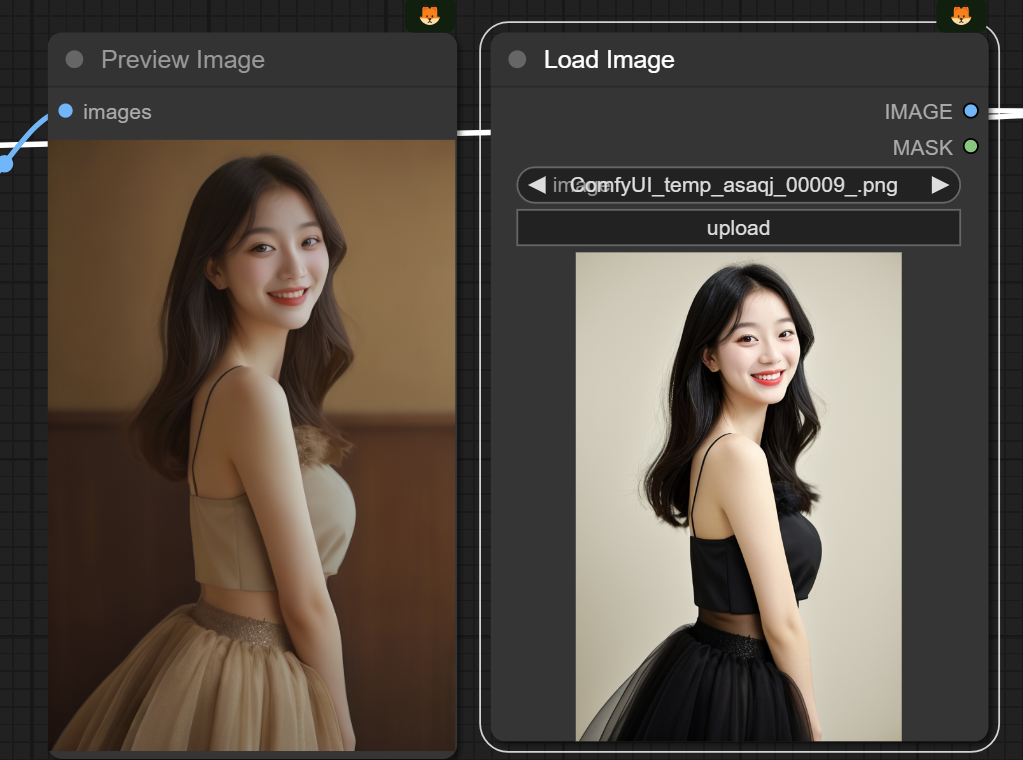

然后连接到这里工作流大家完成了,但是你会发现生成的图片是这样的背景和人物的色彩都变色了,如图!

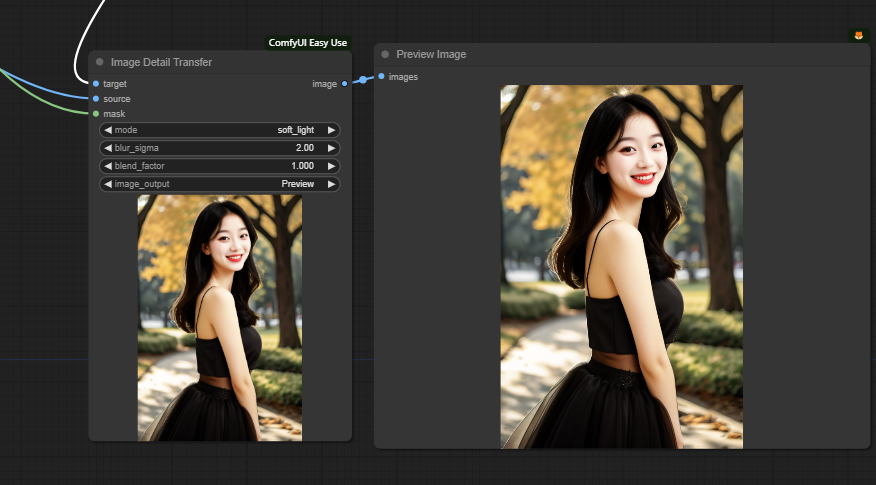

第五步、搭载image detail transfer 恢复主体细节

其中target为刚才文生图生成的图像,source是经过image resize处理过的图像,mask是去removebg处理过的遮罩,其中遮罩给定了限制区域,source给定了限制区域的所有信息!这样是不是把原图像传过来了!

看着这个节点的参数:

blury sigma:模糊程度决定了源图像的细节在传输到目标图像时的清晰度和柔和度。这个参数的作用类似于在图像处理软件中应用高斯模糊滤镜。

-

较低的模糊值 (如 0.5) :

-

如果设置较低的模糊值,源图像的细节会非常清晰地传输到目标图像上。这意味着每一个细小的纹理和边缘都会被清晰地保留下来,细节非常锐利。例如,如果源图像有很多皮肤的细小纹理,低模糊值会使这些细节非常明显地出现在目标图像上。

-

较高的模糊值 (如 3.0) :

-

**较高的模糊值会使得源图像的细节在传输过程中变得更加平滑和柔和。这种情况下,细小的纹理和边缘会变得模糊,整体效果更柔和。**例如,如果源图像是一个风景图片,较高的模糊值会使得树叶和草地的细节变得不那么锐利,看起来更加梦幻和柔和。

也就是说模糊值越低,人物越清晰但和背景的融合就会差点意思!反之越高则在细节传送过程中会变得更加平滑柔和,融合度越好!具体还需手动测试了!

blend_factor (混合因子) :

- 混合因子控制了源图像细节与目标图像的混合程度。数值为1.000表示完全混合,0.000表示不混合。你可以根据需要调整这个参数,以获得不同的混合效果。

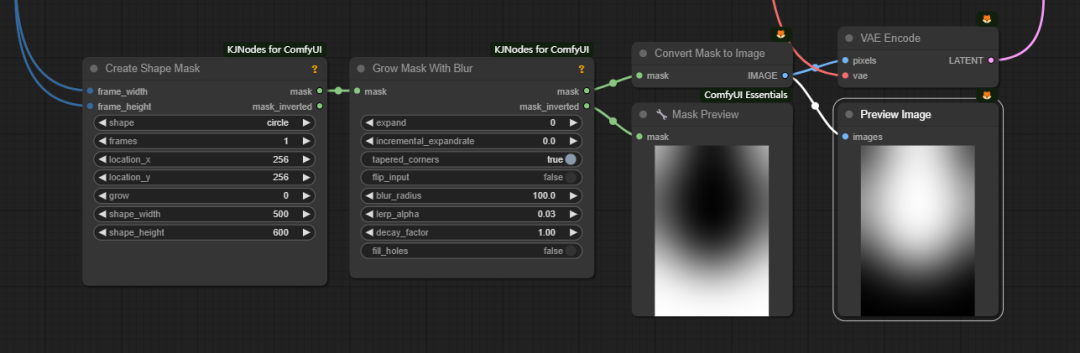

第五步:增加光源效果

先看这个光源的整体框架大小应该和我们之前处理过的自定义图大小一致,也就是这里我已经 转化为输入的frame width和frame

height!然后借助grow mask blur节点让光源不要那么生硬!

1.expand (扩展) :

这是掩码扩展的像素数。数值越大,掩码的区域就越大。例如,设置为50表示掩码将扩展50个像素。

2.incremental_expandrate (递增扩展率) :

这个参数控制掩码扩展的速度。如果设置为0,扩展是一次性完成的;如果设置为一个正值,掩码会逐步扩展。我认为这是一种过渡效果!

3.tapered_corners (渐变角落) :

启用此选项会使扩展的掩码在边缘处渐变,使其边缘更加平滑和自然。

4.flip_input (翻转输入) :

当启用这个选项时,输入的掩码图像将会翻转,通常用于特殊效果或需要对图像进行反转处理的情况。

5.blur_radius (模糊半径) :

控制掩码模糊的程度。数值越大,模糊效果越强。100表示模糊半径为100个像素,会使掩码边缘变得非常柔和。

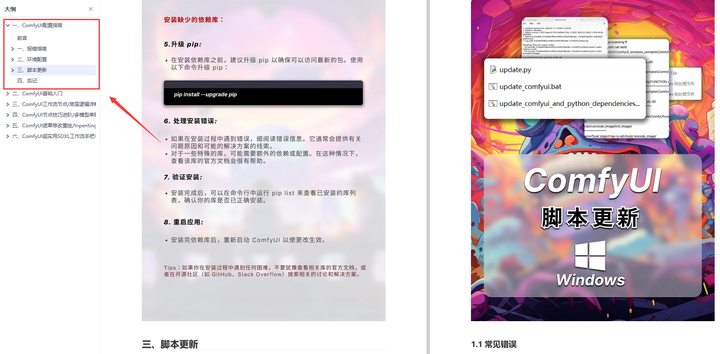

为了帮助大家更好地掌握ComfyUI,我在去年花了几个月的时间,撰写并录制了一套ComfyUI的基础教程,共六篇。这套教程详细介绍了选择ComfyUI的理由、其优缺点、下载安装方法、模型与插件的安装、工作流节点和底层逻辑详解、遮罩修改重绘/Inpenting模块以及SDXL工作流手把手搭建。

由于篇幅原因,本文精选几个章节,详细版点击下方卡片免费领取

一、ComfyUI配置指南

- 报错指南

- 环境配置

- 脚本更新

- 后记

- …

二、ComfyUI基础入门

- 软件安装篇

- 插件安装篇

- …

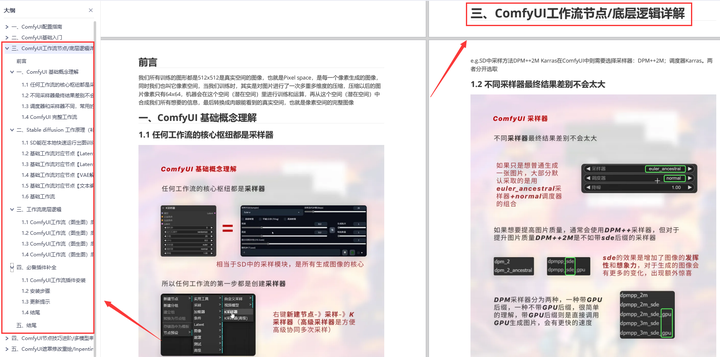

三、 ComfyUI工作流节点/底层逻辑详解

- ComfyUI 基础概念理解

- Stable diffusion 工作原理

- 工作流底层逻辑

- 必备插件补全

- …

四、ComfyUI节点技巧进阶/多模型串联

- 节点进阶详解

- 提词技巧精通

- 多模型节点串联

- …

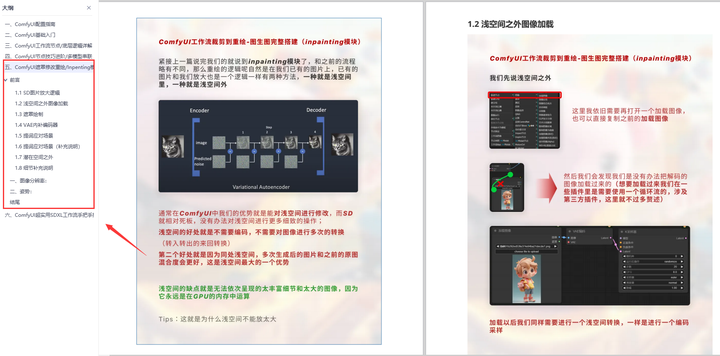

五、ComfyUI遮罩修改重绘/Inpenting模块详解

- 图像分辨率

- 姿势

- …

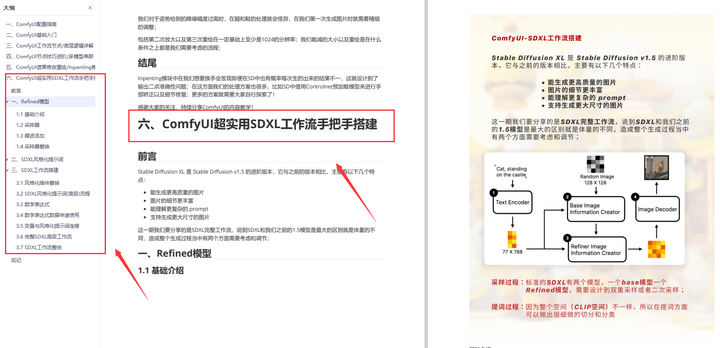

六、ComfyUI超实用SDXL工作流手把手搭建

- Refined模型

- SDXL风格化提示词

- SDXL工作流搭建

- …

由于篇幅原因,本文精选几个章节,详细版点击下方卡片免费领取

/i-blog.csdnimg.cn/direct/d95597db7d9d44ac98bb7a18dcfeacc5.png#pic_center)

这里直接将该软件分享出来给大家吧~

1.stable diffusion安装包

随着技术的迭代,目前 Stable Diffusion 已经能够生成非常艺术化的图片了,完全有赶超人类的架势,已经有不少工作被这类服务替代,比如制作一个 logo 图片,画一张虚拟老婆照片,画质堪比相机。

最新 Stable Diffusion 除了有win多个版本,就算说底端的显卡也能玩了哦!此外还带来了Mac版本,仅支持macOS 12.3或更高版本。

2.stable diffusion视频合集

我们在学习的时候,往往书籍源码难以理解,阅读困难,这时候视频教程教程是就很适合了,生动形象加上案例实战,一步步带你入坑stable diffusion,科学有趣才能更方便的学习下去。

3.stable diffusion模型下载

stable diffusion往往一开始使用时图片等无法达到理想的生成效果,这时则需要通过使用大量训练数据,调整模型的超参数(如学习率、训练轮数、模型大小等),可以使得模型更好地适应数据集,并生成更加真实、准确、高质量的图像。

4.stable diffusion提示词

提示词是构建由文本到图像模型解释和理解的单词的过程。可以把它理解为你告诉 AI 模型要画什么而需要说的语言,整个SD学习过程中都离不开这本提示词手册。

5.SD从0到落地实战演练

如果你能在15天内完成所有的任务,那你堪称天才。然而,如果你能完成 60-70% 的内容,你就已经开始具备成为一名SD大神的正确特征了。

这份完整版的stable diffusion资料我已经打包好,需要的点击下方插件,即可前往免费领取!

1042

1042

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?