目录

前言

📅大四是整个大学期间最忙碌的时光,一边要忙着备考或实习为毕业后面临的就业升学做准备,一边要为毕业设计耗费大量精力。近几年各个学校要求的毕设项目越来越难,有不少课题是研究生级别难度的,对本科同学来说是充满挑战。为帮助大家顺利通过和节省时间与精力投入到更重要的就业和考试中去,学长分享优质的选题经验和毕设项目与技术思路。

🚀对毕设有任何疑问都可以问学长哦!

选题指导:

大家好,这里是海浪学长毕设专题,本次分享的课题是

🎯基于计算机视觉技术进行野生动物监测与识别

设计思路

一、课题背景与意义

随着生态保护意识的增强,野生动物的监测与保护显得尤为重要。传统的野生动物观察方法往往依赖于人工记录,效率低且难以获取全面的数据。近年来,计算机视觉和深度学习技术的快速发展,为野生动物的自动识别提供了新的可能。通过对动物种类的准确识别,研究人员能够更好地了解野生动物的种群动态、分布情况以及栖息环境。这为制定有效的保护措施提供了科学依据,有助于维护生态平衡和生物多样性。例如,识别濒危物种的栖息地,能够为其提供保护,减少人类活动对其生存环境的影响。在野生动物园中,准确的动物种类识别有助于管理人员进行科学的饲养和繁殖管理。通过实时监测动物种群状态,管理者能够及时发现健康问题和行为异常,确保动物的福利和园区的安全。

二、算法理论原理

2.1 卷积神经网络

CNN 是深度学习应用广泛的经典算法之一,具有较强的表征学习能力,可以对输入信息进行平移不变分类。自上世纪八十至九十年代开始,CNN 逐步发展,最早出现的 CNN 包括时间延迟网络和 LeNet。目前,随着人工智能理论的不断深化以及高性能设备的出现,CNN 得到了快速发展,并广泛应用于机器视觉、人体行为识别、医学领域。CNN 的基础结构主要包括输入层、卷积层、池化层、全连接层和输出层。

卷积层的主要功能是提取输入图像的特征,包括卷积核、步长等参数。卷积核的大小决定可提取特征的复杂度,卷积核越大,提取的特征越复杂。激活函数常常存在于卷积层中,以协助表达复杂特征,常见的激活函数有 Sigmoid、ReLU 和 Tanh 函数。经过卷积层和池化层的特征提取后,全连接层通过非线性的方式对这些特征组合,最终输出至输出层。在部分卷积神经网络中,全局平均池化可能取代全连接层,通过对特征图中所有通道求和取平均以获得最终的平均值。

随着卷积神经网络的不断发展,相关模型得到了更新和优化。AlexNet 网络的结构与最初的 LeNet 网络相似,都是先通过卷积再进行全连接层的输出,但在某些细节上有明显不同。在 LeNet 的基础上,AlexNet 加深了网络结构,能够学习更高维及更丰富的图像特征,具有以下特点:引入 ReLU 激活函数代替 Sigmoid 激活函数;使用 Dropout 层来抑制过拟合现象;使用数据扩增方法,在一定程度上抑制过拟合,并提高模型的泛化能力。

ResNet 在网络中引入了残差模块,得到了广泛应用。残差学习单元的引入使得网络可以只学习输入与输出之间的残差部分,使模型的收敛速度更快,同时能够进一步提高模型的精度。残差模块并没有采用传统的前向和后向传递信息的方式,从而使网络得到了较好的优化。通过恒等函数将输入直接给到输出,使梯度的传导变得更快。通过减小模块中的参数值,可以增强反向传导的损失值响应能力。尽管这种方法不能百分之百缓解回传过程中遇到的小损失现象,但参数的减小在一定程度上加强了回传损失的效果,导致正则化现象的发生。

2.2 YOLOv5算法

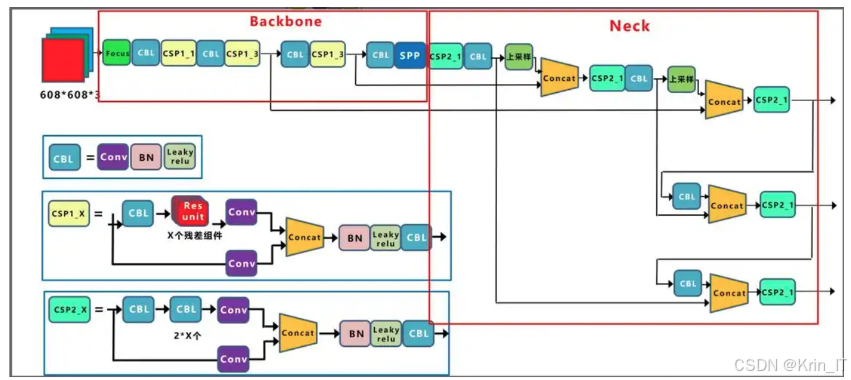

YOLOv5是一种高效的目标检测算法,具有显著的实时检测能力和准确性。结构主要包括输入层、特征提取层、检测头和输出层。其特征提取层采用了一种深度卷积神经网络(CNN)设计,通常使用CSPNet结构,以提高特征的表达能力和计算效率。通过多尺度特征融合,YOLOv5在不同层次上提取丰富的特征信息,从而增强对小目标的检测能力。检测头部分负责生成边界框和类别概率,采用了锚框机制来提升模型的检测精度。最终,输出层通过非极大值抑制(NMS)来筛选出最终的检测结果,确保检测结果的准确性。

YOLOv5算法在速度和精度之间实现了良好的平衡,适合实时应用,能够快速处理视频流和图像数据,确保监测人员及时捕捉到野生动物的动态。模型经过轻量化设计,能够在较低的计算资源下运行,适合移动设备和边缘计算,这使得野生动物监测设备能够在偏远地区或资源有限的环境中高效工作。YOLOv5支持多种输入尺寸和自定义锚框,使得模型能够灵活适配不同的任务需求,用户可以根据具体的监测对象和环境条件调整模型参数,以达到最佳的检测效果。提供了丰富的训练和推理工具,用户可以通过简单的命令行操作进行模型训练和部署,大大降低了使用门槛。

三、检测的实现

3.1 数据集

图像采集选择了两种主要的采集方式以确保数据的丰富性和多样性。首先,自主拍摄是在野生动物栖息地进行的实地拍摄,使用高质量的相机在不同时间和天气条件下拍摄各种动物,以捕捉它们的自然行为和不同的姿态。这种方式能够确保获得真实的样本,并涵盖不同的光照、角度和背景。其次,通过互联网采集,我们从开放的数据库和相关网站获取已标注的野生动物图像,补充数据集的多样性。通过这两种方式,最终构建了一个包含多种野生动物的丰富数据集。采用LabelImg等标注工具对采集到的图像进行标注,将每张图像中的野生动物用边界框标识出来,并为每个物种分配相应的类别标签。数据标注的准确性直接影响到后续模型训练的效果。

将数据集划分为训练集、验证集和测试集,通常按70%-20%-10%的比例进行划分,以确保模型在训练和评估时能够获得充分的样本。此外,为了增强模型的泛化能力,我们采用了数据扩展技术,包括随机旋转、平移、缩放、翻转和颜色变换等操作。这些数据扩展方法有效增加了样本的多样性,使得模型在面对实际应用时具有更强的适应性。

3.2 实验环境搭建

3.3 实验及结果分析

数据集通常由自主拍摄和互联网采集的图像组成,这些图像经过标注工具进行标记,确保每张图像中的动物被准确标识。数据集需要按照一定比例划分为训练集、验证集和测试集,以确保模型的泛化能力和评估的准确性。此外,为了提升模型的鲁棒性,我们还会对图像进行数据扩展处理,例如随机旋转、缩放和颜色变换等,以增加样本的多样性。

import os

from torchvision import transforms

from torchvision.datasets import ImageFolder

from torch.utils.data import DataLoader

# 数据增强和预处理

data_transforms = transforms.Compose([

transforms.RandomHorizontalFlip(),

transforms.RandomRotation(10),

transforms.ColorJitter(brightness=0.2, contrast=0.2),

transforms.Resize((640, 640)),

transforms.ToTensor(),

])

# 加载数据集

train_dataset = ImageFolder(root='path/to/train_data', transform=data_transforms)

val_dataset = ImageFolder(root='path/to/val_data', transform=data_transforms)

train_loader = DataLoader(train_dataset, batch_size=16, shuffle=True)

val_loader = DataLoader(val_dataset, batch_size=16, shuffle=False)选择YOLOv5作为基础模型,因为其在速度与精度之间的平衡表现出色。使用YOLOv5的预训练模型,可以通过迁移学习的方式来加速训练过程。根据数据集的特征,可以对模型进行微调,例如调整输出层以适应不同的动物类别。构建模型时,我们应确保模型的结构能够有效提取图像特征,并能够处理多种输入尺寸,以适应不同的图像需求。使用合适的优化器(如Adam或SGD)和损失函数(如交叉熵损失或Focal Loss),并监控训练过程中的损失值和准确率,以确保模型的有效收敛。通常设置多个epoch,以便模型能够充分学习数据中的特征。训练过程中,实时监控训练损失和验证集的表现,以便及时调整训练策略。

import torch.optim as optim

# 定义优化器

optimizer = optim.Adam(model.parameters(), lr=0.001)

# 训练过程

num_epochs = 50

for epoch in range(num_epochs):

model.train() # 设置为训练模式

running_loss = 0.0

correct = 0

for images, targets in train_loader:

images, targets = images.to(device), targets.to(device)

outputs = model(images) # 前向传播

loss = criterion(outputs, targets) # 计算损失

optimizer.zero_grad()

loss.backward() # 反向传播

optimizer.step() # 更新权重

running_loss += loss.item()

_, preds = torch.max(outputs, 1)

correct += (preds == targets).sum().item()

epoch_loss = running_loss / len(train_loader)

accuracy = correct / len(train_loader.dataset)

print(f'Epoch [{epoch+1}/{num_epochs}], Loss: {epoch_loss:.4f}, Accuracy: {accuracy:.4f}')模型进行评估,以验证其在验证集和测试集上的性能。通过计算精度、召回率和F1-score等指标,以评估模型的准确性和鲁棒性。混淆矩阵可以用于可视化模型在不同类别上的表现,帮助识别模型的不足之处。将模型集成到动物园的监控系统中,实时分析来自监控摄像头的图像,自动识别和定位动物种类。

from sklearn.metrics import precision_score, recall_score, f1_score

model.eval() # 设置为评估模式

all_preds = []

all_targets = []

with torch.no_grad():

for images, targets in val_loader:

images, targets = images.to(device), targets.to(device)

outputs = model(images)

_, preds = torch.max(outputs, 1)

all_preds.extend(preds.cpu().numpy())

all_targets.extend(targets.cpu().numpy())

# 计算评估指标

precision = precision_score(all_targets, all_preds, average='weighted')

recall = recall_score(all_targets, all_preds, average='weighted')

f1 = f1_score(all_targets, all_preds, average='weighted')

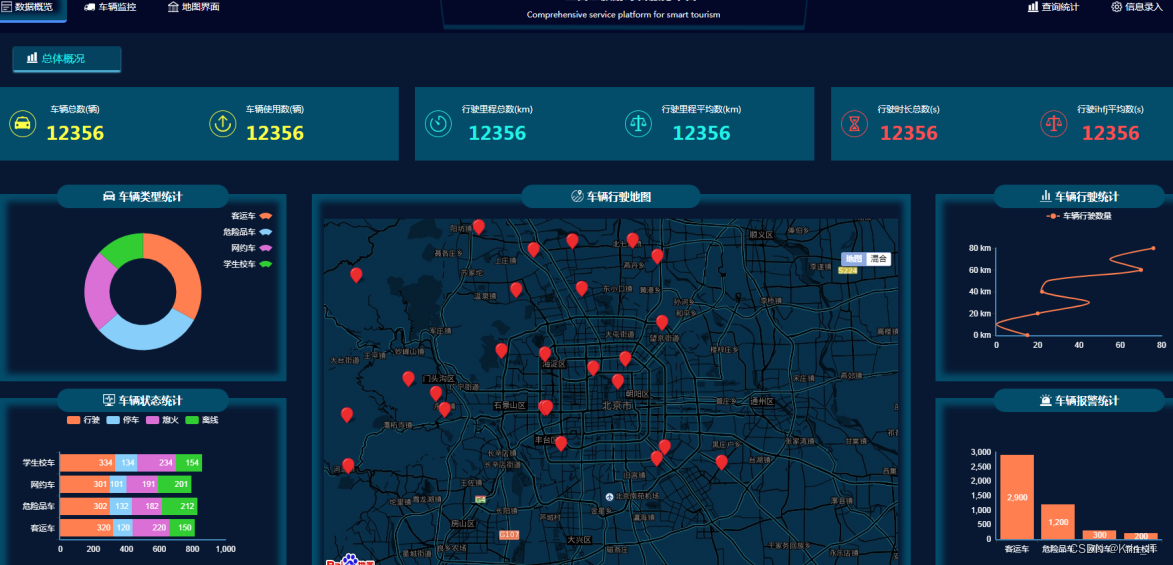

print(f'Precision: {precision:.4f}, Recall: {recall:.4f}, F1-Score: {f1:.4f}')实现效果图样例:

创作不易,欢迎点赞、关注、收藏。

毕设帮助,疑难解答,欢迎打扰!

2423

2423

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?