以下是对不同注意力模式(sdpa、flash att_2、flash attn_3、sageattn、spargeattn、spargeattn_tune)的详细分析和区别:

-

SDPA(Scaled Dot Product Attention)

- SDPA是Transformer中经典的注意力机制,通过缩放点积计算注意力权重。它是许多现代Transformer模型的基础实现,如GPT-3和BERT等。

- SDPA在PyTorch中被优化为支持多种硬件(CPU、GPU、CUDA、AMD等),并可以通过BetterTransformer API提前受益。

- SDPA的实现相对简单,但其计算量随着序列长度的平方增长,可能导致内存和计算资源的消耗较大。

-

Flash Attention 2(Flash Attention-2)

- Flash Attention 2是一种改进的注意力机制,通过减少内存访问次数和优化计算顺序来提高效率。

- 它在PyTorch 2.2版本中被支持,并且可以通过

torch.nn.functional.scaled_dot_product_attention直接调用。 - Flash Attention 2在某些情况下比SDPA更快,尤其是在处理长序列时。然而,它可能需要特定的硬件支持(如H100或A100 GPU)。

-

Flash Attention 3(Flash Attention-3)

- Flash Attention 3是Flash Attention 2的进一步优化版本,速度比Flash Attention 2快约2倍。

- 它目前仍处于测试阶段,仅支持部分头部维度,并且尚未广泛应用于生产环境。

-

Sage Attention(SageAttn)

- Sage Attention是一种量化注意力机制,通过8位量化和稀疏化技术显著减少VRAM占用,同时保持端到端性能。

- 它适用于需要高效推理的场景,特别是在资源受限的设备上。

-

Sparge Attention(SpargeAttn)

- Sparge Attention是一种稀疏化注意力机制,通过减少不必要的计算和存储来优化性能。

- 它特别适合处理长序列数据,能够显著降低内存消耗。

-

Sparge Attention Tune(SpargeAttn_Tune)

- Sparge Attention Tune是Sparge Attention的优化版本,通过调整稀疏化参数进一步提高效率。

- 它可能需要额外的调优步骤以达到最佳性能。

总结

- SDPA 是经典实现,适用于大多数场景,但在长序列处理上可能效率较低。

- Flash Attention 2 和 Flash Attention 3 是高效的注意力机制,适合需要加速的场景,尤其是长序列处理。

- Sage Attention 和 Sparge Attention 专注于内存优化,适合资源受限的设备。

- Sparge Attention Tune 是Sparge Attention的优化版本,适合需要进一步调优的场景。

选择哪种注意力模式应根据具体需求(如序列长度、硬件支持、内存限制等)来决定。

--------------------------------------------------------

显卡架构

| 架构 | 代表显卡 | 核心改进 | 性能差距(vs 2080 Ti) |

|---|---|---|---|

| Pascal | GTX 1080 Ti | 无 RT/Tensor Core,纯 CUDA 计算 | 落后 30-40%(光追场景差距更大) |

| Turing | RTX 2080 Ti | 引入 RT Core + Tensor Core | 基准 |

| Ampere | RTX 3080 Ti | 第二代 RT Core + 第三代 Tensor Core | 领先 40-50% |

| Ada Lovelace | RTX 4080 | DLSS 3.0 + 光流加速器 | 领先 80-100% |

RTX 2080 Ti只支持sdpa,其他全部不支持,因为其他都用到bf16,而RTX 2080 Ti不支持bf16.

但在某个工作流运行到节点:SamplerCustomAdvanced 时,因为安装的 sageattention=1.0.6,出现错误:cannot import name 'sageattn_qk_int8_pv_fp16_triton' from 'sageattention' and auto aslo error,升级 sageattention = 2.1.1 后,问题消失,这是不是说,RTX 2080 Ti 也能用 sageattention?

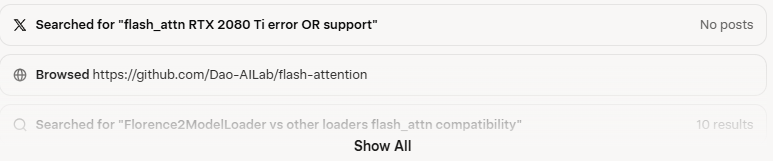

针对 flash_attn_2 问了https://grok.com/,得到的答案还是很不错的,下面是提问及答案:

-------------------------------------------------------------------------------------------------------------

显卡RTX 2080ti,安装了flash_attn 2.7.4.post1,Florence2ModelLoader 节点使用正常,但WanVideo Model Loader节点则报错,为何会这样?flash_attn_2究竟是支持RTX 2080ti显卡还是不支持呢?

问题分析与原因解释

根据您的描述,您在 ComfyUI 中使用 RTX 2080 Ti 显卡(Turing 架构,Compute Capability 7.5)安装了 flash_attn 2.7.4.post1 版本。Florence2ModelLoader 节点(来自 ComfyUI-Florence2 扩展)运行正常,但 WanVideo Model Loader 节点(来自 ComfyUI-WanVideoWrapper 扩展)报错。这是一个典型的兼容性问题,主要源于 flash_attn 2.x 系列对 GPU 架构的支持限制,以及不同节点在模型加载和注意力机制实现上的差异。下面我一步步解释原因,并回答您的具体疑问。

1. flash_attn 2.x 系列对 RTX 2080 Ti 的支持情况

- 不支持:flash_attn 2.x(包括 2.7.4.post1)不官方支持 RTX 2080 Ti。官方文档(GitHub Dao-AILab/flash-attention)明确指出:

- FlashAttention-2(2.x 系列)仅支持 Ampere(RTX 30 系列,如 RTX 3090)、Ada(RTX 40 系列,如 RTX 4090)或 Hopper(H100 等专业卡)架构的 GPU。这些架构的 Compute Capability ≥ 8.0。

- 对于 Turing 架构的 GPU(如 RTX 20 系列,包括 RTX 2080 Ti),官方推荐使用 FlashAttention 1.x(例如 1.0.4),因为 2.x 的优化(如更好的并行性和内存效率)依赖于更新的 CUDA 内核和硬件特性(如 bf16 支持),这些在 Turing 上不可用或不稳定。

- 即使您成功安装了 2.7.4.post1(可能是通过预构建 wheel 或编译),运行时仍会触发运行时错误(如 "RuntimeError: FlashAttention only supports Ampere GPUs or newer"),因为内核检查会检测到 GPU 架构不兼容。这在 Hugging Face Transformers 和 PyTorch 集成中很常见。

- 为什么能安装但运行报错?

- 安装 flash_attn 2.x 在 Turing GPU 上可能成功(尤其是 Windows 用户使用预构建 wheel),但这是因为编译阶段不严格检查运行时硬件。运行时,PyTorch 会尝试加载 CUDA 内核,如果内核不支持 Turing 的 SM_75(Compute Capability 7.5),就会失败。

- 社区讨论(GitHub issues #1514、#787 等)确认:RTX 2080 Ti 用户经常遇到此错误,尤其在加载 Transformer-based 模型时。官方表示 "Support for Turing GPUs is coming soon",但截至 2025 年 9 月,仍未完全实现(可能需等待 FlashAttention-3 或后续更新)。

- 性能与替代:

- Turing GPU(如 RTX 2080 Ti)在 1.x 版本上表现良好,能加速注意力计算,但 2.x 的额外优化(如 head dim > 192 的 backward pass)不可用。

- 备选:使用 PyTorch 的内置 Scaled Dot-Product Attention (SDPA) 或 xformers(这些支持 Turing,无需 flash_attn)。安装 xformers:pip install xformers。

2. 为什么 Florence2ModelLoader 正常,但 WanVideo Model Loader 报错?

- 节点差异与实现机制:

- Florence2ModelLoader(ComfyUI-Florence2 扩展):

- 这个节点基于 Hugging Face Transformers 加载 Microsoft Florence-2 模型(视觉-语言模型)。它提供 "precision" 参数选项,包括 "flash_attention_2"、"sdpa" 等。

- 即使 flash_attn 2.x 已安装,如果检测到不兼容(Turing GPU),Transformers 会 自动回退(fallback) 到 SDPA(PyTorch 内置注意力机制)。这是因为 Florence-2 的 modeling_florence2.py 脚本有容错机制:如果 flash_attn 导入失败或不支持,它会切换到标准注意力,而不强制要求 flash_attn。

- 社区报告(GitHub issues #31793、Hugging Face discussions)显示,许多用户在 Turing GPU 上通过设置 "precision" 为 "sdpa" 就能正常运行。即使默认尝试 flash_attn,也会优雅降级。这解释了为什么您的 Florence2ModelLoader "使用正常"——它没有严格依赖 flash_attn 2.x 的完整功能。

- 示例:如果您在节点中将 "precision" 设为 "sdpa" 或 "default",它会绕过 flash_attn 检查。

- WanVideo Model Loader(ComfyUI-WanVideoWrapper 扩展):

- 这个节点用于加载 Wan 2.1 等视频生成模型(基于 Transformer 的 U-Net 或 DiT 架构),对注意力机制更敏感,尤其在视频 latents 处理中需要高效的 KV cache 和长序列注意力。

- 它可能 强制或默认启用 flash_attn 2.x(或 SageAttention/Trition 后端),没有像 Florence-2 那样的自动回退。GitHub issues(如 #10、#360、#725)显示,用户在加载时常报错:

- "RuntimeError: FlashAttention only supports Ampere GPUs or newer"(直接与您的场景匹配)。

- "Can't import SageAttention: No module named 'sageattention'"(WanVideo 扩展可能依赖 SageAttention 作为 flash_attn 的备选,但 Turing 不支持)。

- "Cannot find a working triton installation"(Trition 是 flash_attn 的后端,如果 flash_attn 2.x 失败,会尝试 Trition,但 Turing 兼容性差)。

- Wan 模型(如 Wan2.1)是高资源视频模型,需要更激进的优化(如 flash_attn 的内存节省),因此节点实现更严格。一旦检测到 flash_attn 不可用,就直接报错,而非回退。这在 Reddit r/comfyui 和 GitHub 上有多个报告:RTX 20/30 系列用户需降级到 SDPA 或使用 1.x 版本。

- 额外因素:WanVideo 可能使用自定义的 attn_implementation="flash_attention_2"(在代码中硬编码),导致在 Turing 上崩溃。相比之下,Florence-2 的加载更灵活。

- 报错的具体触发:

- 您的 flash_attn 2.7.4.post1 在运行时被检测为 "installed but unusable"(因为 Turing 不支持)。Florence-2 忽略此问题并继续(使用 SDPA),但 WanVideo 节点在模型初始化时尝试调用 flash_attn 内核,导致崩溃。

- 常见错误日志(基于社区):类似于 "FlashAttention2 has been toggled on, but it cannot be used" 或 "Torch was not compiled with flash attention"(尽管您已安装)。

3. 解决方案建议

- 立即修复 WanVideo Model Loader:

- 切换注意力模式:在 WanVideo Model Loader 节点中(如果有选项),将 attn_implementation 或 precision 设为 "sdpa" 或 "eager"(避免 flash_attn)。如果节点无此选项,编辑扩展代码(nodes.py)中添加 attn_implementation="sdpa" 到模型加载调用。

- 降级 flash_attn:卸载 2.x 并安装 1.x 版本:

text

这在 Turing 上稳定支持,且许多节点(如 WanVideo)能兼容 1.x。重启 ComfyUI 后测试。pip uninstall flash-attn pip install flash-attn==1.0.4 --no-build-isolation- 安装备选后端:

- xformers:pip install xformers(支持 Turing,提供类似加速)。

- SageAttention(如果扩展支持):但注意,它也可能有 Turing 兼容问题(GitHub issue #10)。

- Triton-based flash_attn:安装 pip install flash-attn-triton(专为不支持的 GPU 如 Turing 提供 wrapper),但测试兼容性。

- 检查环境:

- 确保 PyTorch ≥ 2.0、CUDA 11.8+(RTX 2080 Ti 支持 CUDA 12.x,但需匹配)。

- 运行 python -c "import flash_attn; print(flash_attn.__version__); import torch; print(torch.cuda.get_device_capability())" 验证:应输出 1.x 版本和 (7, 5)。

- 更新 ComfyUI-WanVideoWrapper 到最新版(通过 ComfyUI Manager),可能有修复。

- 通用优化:

- 对于 RTX 2080 Ti(11GB VRAM),视频模型如 Wan 2.1 可能需降低分辨率或使用量化版本(e.g., bf16 或 4-bit)。

- 测试工作流:用简单提示运行短视频生成,监控 VRAM 使用(nvidia-smi)。

- 如果仍报错,提供完整错误日志(ComfyUI 控制台),可进一步诊断。

- 长期建议:

- 升级 GPU 到 RTX 30/40 系列以充分利用 flash_attn 2.x(速度提升 2-3x,VRAM 节省 20-50%)。

- 参考资源:

- GitHub flash-attention:https://github.com/Dao-AILab/flash-attention(安装指南和 issues)。

- ComfyUI-WanVideoWrapper issues:搜索 "flash_attn" 或 "Turing"。

- Reddit r/comfyui:帖子如 "Wan 2.1 on RTX 2080 Ti" 讨论类似问题,用户报告用 SDPA 成功运行(生成时间 ~10-20 分钟/短视频)。

如果您提供报错的完整日志或节点配置细节,我可以给出更精确的修复步骤!

原来因为DeepSeek的说法是flash_attn 2.5.8支持RTX 2080 Ti,耗时几个小时编译了从2.5.8到2.74多个版本(2.80之后的版本编译失败),得到上面这个解析,死心了,还是先卸载无用的 flash_attn ,等官方牛年马月能有支持的版本推出才再考虑了。

不得不赞下https://grok.com/ 在技术的准确性及解析上,有时候还是比chatgpt 及DeepSeek 要好。

-------------------

在《万相2.1太慢?试试这个节点,两倍提速》里,网友“东岳整人” 说:把comfyui官方工作流里面的模型加载节点替换成kjnodes里面的diffusion load(大概是这个),替换后的节点里面的sage选项选auto,2080ti 就可以使用 Sage Attention ,但我试了,报错:sageattn() got an unexpected keyword argument 'tensor_layout' ,而且这个错误发生后,即使换回官方流、关闭comfyui重启,依然报这个错误,需要关电脑再开这个错误才消失。

950

950

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?